Trouble Shooting

1.[Airflow] Log file does not exist

파일의 위치가 이상하다.그리고 스케줄러에 의한 run과 수동으로 실행한 run 두 개가 오랫동안 running 중이었다.airflow.cfg 설정에서 remote_logging = True로 변경 후 Airflow 재가동원격 로깅을 활성화하여 container가 원격

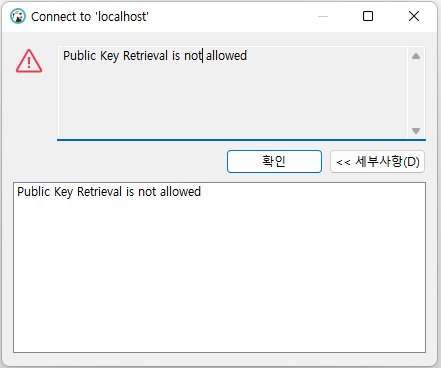

2.[MySQL] Public Key Retrieval is not allowed

DBeaver로 접속했을 때 아래와 같은 에러 발생Public Key Retrieval is not allowedMySQL 공식사이트에서 보안 상의 이유로 allowPublicKeyRetrieval 옵션의 default 값은 False라고 한다. 따라서 이 값을 Tru

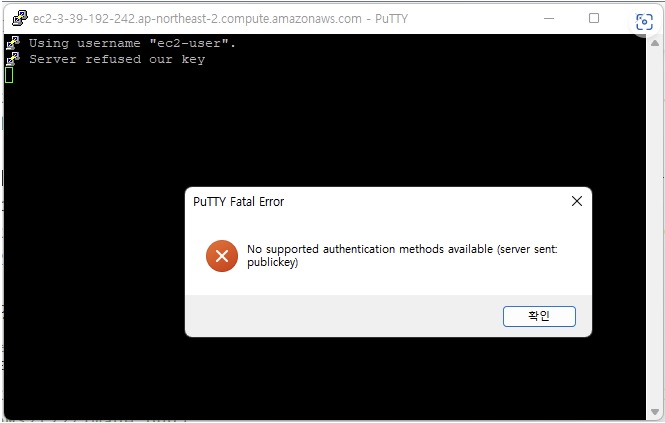

3.[AWS EC2] No supported authentication methods available (server sent: publickey)

No supported authentication methods available (server sent: publickey)이 에러는 아래와 같이 이 컴퓨터를 사용하는 사용자명을 내가 임의로 정해 연결하는 경우에도 뜰 수 있다. EC2에서 컴퓨터를 빌릴 때 이미 기본

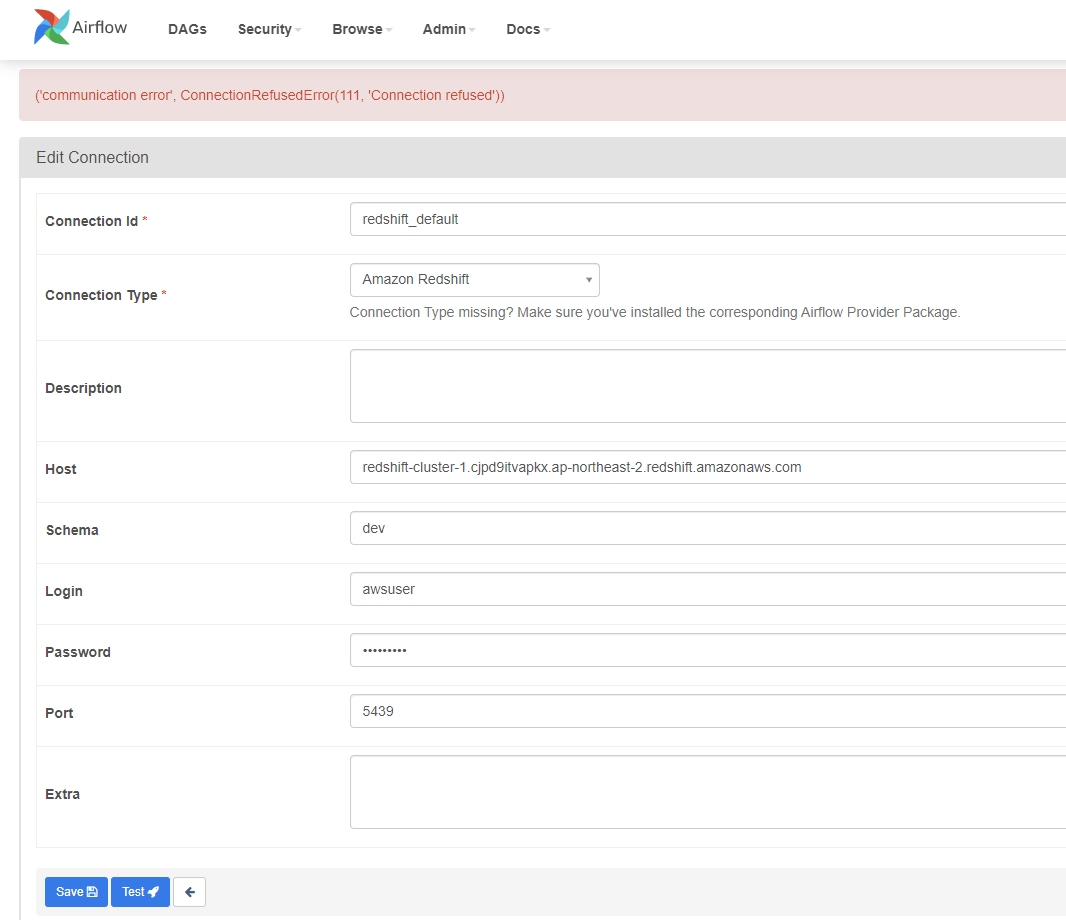

4.[Airflow][Redshift] ('communication error', ConnectionRefusedError(111, 'Connection refused'))

AWS Redshift 연결 시 발생우선적으로 두 가지를 의심해볼 수 있을 것 같다.Cluster의 퍼블릭 액세스 가능 옵션 비활성화퍼블릭 액세스 가능 옵션은 VPC 외부에서의 Access를 허용할지를 물어보는 옵션이다.Cluster의 속성 탭으로 이동하여 네트워크 및

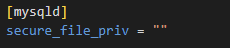

5.[MySQL] SQL Error [1290] [HY000]: The MySQL server is running with the --secure-file-priv option so it cannot execute this statement

Problem LOAD DATA, INTO OUTFILE와 같은 키워드를 사용할 경우 발생 문제원인 --secure-file-priv 옵션은 데이터 export/import 기능을 제한하는 옵션이다. 이 옵션 설정이 필요하다. show variables를 통해

6.WSL2 환경에서 Zeppelin Website가 안 뜰 때

해당 내용은 WSL2를 사용에 따른 네트워크 문제입니다. Zeppelin을 설치 후 Zeppelin을 정상적으로 실행했다.

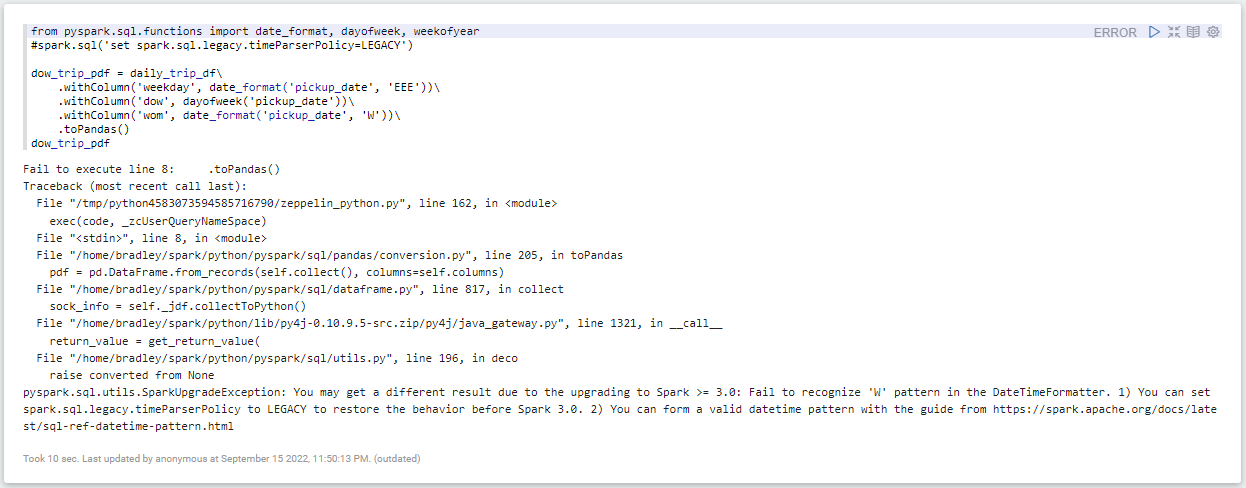

7.[pyspark] You can set spark.sql.legacy.timeParserPolicy to LEGACY to restore the behavior befor Spark 3.0.

아래 옵션과 같이 설정해준다.spark.sql("set spark.sql.legacy.timeParserPolicy=LEGACY")

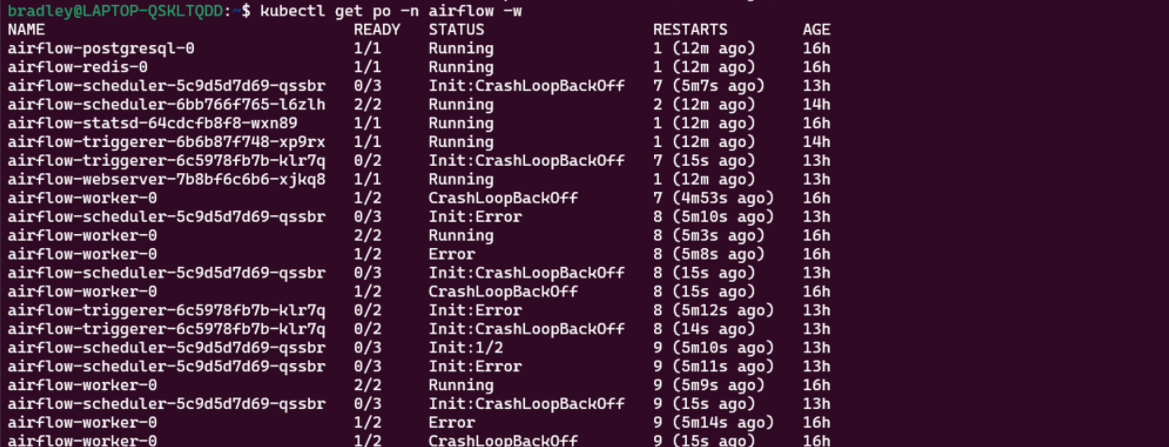

8.[K8S] Pod 장애 진단 방법

아래와 같이 Init:~ 현상이 반복적으로 계속되거나, Error를 나타내는 문구를 나타내면 Init Container 기동에 문제가 발생한 것이다.Kubernetes는 Pod라는 배포 최소단위를 쓰고, 이 Pod 안에는 1개 또는 그 이상의 Container가 포함된

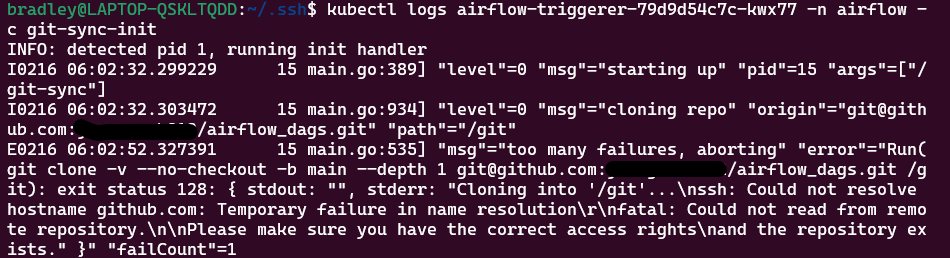

9.[Github][k8s] ssh: Could not resolve hostname github.com: Temporary failure in name resolution

Git sync로 GitHub의 DAGs들을 Sync하고 있었는데 다음과 같은 에러 발생에러 메세지ssh: Could not resolve hostname github.com: Temporary failure in name resolution 요런 문구가 보인다면 DN

10.[Airflow] FileExistsError, AlreadyLocked

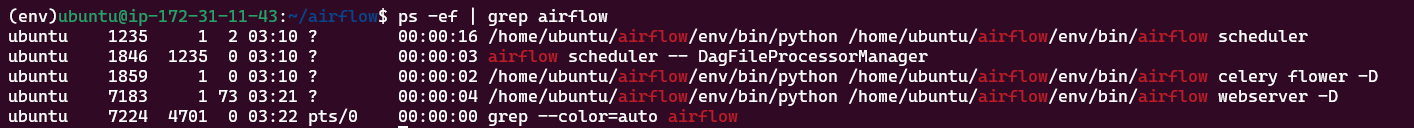

Airflow Webserver가 먹통이 됐다.프로세스를 확인해보니 Airflow Webserver 프로세스가 떠 있긴 한데, Airflow Web Interface를 담당하는 gunicorn이 안 떠있다.airflow-webserver.err를 확인해보니, FileE

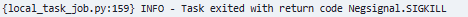

11.[Airflow] Negsignal.SIGKILL

Task를 실행할 때 Negsinal.SIGKILL이란 Log를 발생시키며 Task fail이 난다.이 경우 Memory 문제라고 한다.Task가 Airflow Worker에 할당된 Memory보다 더 많이 사용하기 때문에 발생한다고 한다.따라서 해결 방법은 단순하다.

12.[Airflow] Worker 서비스 부팅 시 자동 실행 안 됨

Worker Node를 부팅했을 때 systemctl로 등록해놓은 서비스가 잘 동작하다가 언젠가부터 자동 실행되지 않는다.systemctl로 airflow-worker.service 서비스를 시작해보면 문제없이 실행도 된다.Unit 파일 자체는 문제 없는 것 같다.ai