[논문리뷰] Resolving Interference When Merging Models

- 최근 model merging은 단일 multitask model로 추가적인 학습 없이 여러 태스크 특화된 모델을 결합한다.

- 기존의 방식은 머지된 모델에서의 파라미터 magnitude를 줄일 수 있고 값들 사이에 미묘한 구분을 없앨 수 있어 여러 모델을 머징할 때 큰 성능 하락을 야기시킨다

(a) 중복 매개변수 값으로 인한 간섭

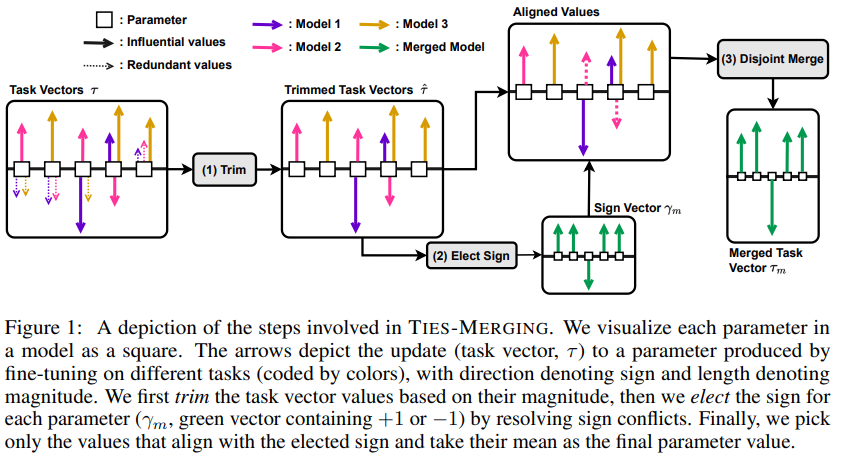

(b) 파라미터 부호 불일치로 인한 간섭 - 3가지 스텝으로 task vector를 결합함으로서 모델을 머징하는 TRIM, ELECT SIGN & MERGE (TIES-MERGING) 제안

(1) 파인튜닝동안 변화된 적은양의 파라미터만 다시세팅

(2) 부호 혼동문제 해결

(3) 부호가 모델간 가장 큰 총 movement의 부호와 일치하는 매개변수만 머징

1.Introduction

-

최근 model merging은 단일 multitask model로 추가적인 학습 없이 여러 태스크 특화된 모델을 결합한다.

-

기존의 방식은 머지된 모델에서의 파라미터 magnitude를 줄일 수 있고 값들 사이에 미묘한 구분을 없앨 수 있어 여러 모델을 머징할 때 큰 성능 하락을 야기시킨다

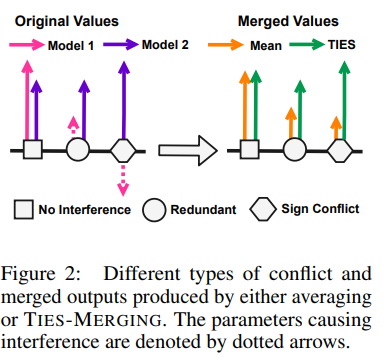

(a) 중복 매개변수 값으로 인한 간섭 -

pruning 연구에 따르면, 파인튜닝 과정 동안 많은 모델 파라미터들이 변할 수 있고 성능에 작은 영향을 줄 수 있다고 밝혔다.

-

그러나 어떤 모델에서는 영향력이 있지만 다른 모델에서는 영향력이 없는(중복) 파라미터를 머징할 때, 영향력 있는 값은 중복 값에 가려져 모델 성능을 하락시킬 수 있습니다.

(b) 파라미터 부호 불일치로 인한 간섭 -

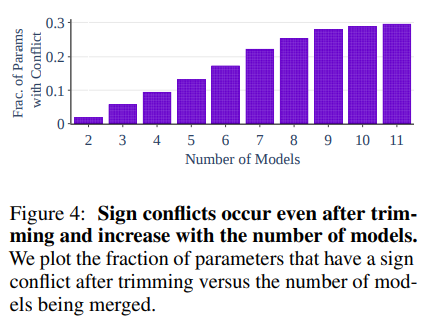

주어진 파라미터는 어떤 모델에는 + 이지만 어떤 모델에는 - 값일 수 있습니다. 그래서 단순 평균을 취하면 안되며, 영향력이 있는 매개변수간의 간섭은 모델의 수가 증가할 수록 머지된 모델과 멀티태스크로 훈련된 모델간의 성능 차이가 증가하는 이유를 설명해 줄 수 있습니다.

-

3가지 스텝으로 task vector를 결합함으로서 모델을 머징하는 TRIM, ELECT SIGN & MERGE (TIES-MERGING) 제안

(1) 파인튜닝동안 변화된 적은양의 파라미터만 다시세팅

: 각각의 task vector에서 중복되는(남는) 값들을 0으로 (혹은 미세 조정된 매개변수 값을 사전학습된 모델에서 나온 값으로) 세팅해서 영향력이 있는 매개변수 값들만 보유하도록 각각의 task vector를 다듬는다. 부호 충돌은 영향력이 있는 매개변수 사이에 여전히 있을 수 있다.

(2) 부호 혼동문제 해결

(3) 부호가 모델간 가장 큰 총 movement의 부호와 일치하는 매개변수만 머징 -

Task Arithmetic, RegMean, Fisher Merging, weight averaging 능가

2.Related work

2.1 Loss Landscape and Weight Interpolation

-While the loss function of a neural network is generally non-convex, recent work has demonstrated that the parameter values from different training runs can sometimes be interpolated without increasing the loss (i.e. they are mode-connected)

Model Merging and Different Use Cases.