✏️학습 정리

9. Closed-book QA with T5

-

Closed-book Question Answering

- 이미 pre-train으로 대량의 지식을 학습했다면, pre-trained model 자체가 하나의 knowledge storage라고 해석가능

- 사전학습 시 전혀 본 적없는 Natural Question 데이터셋에 어느 정도 대답 가능

- Text-to-Text Format

- Generation-based MRC와 유사 (input에 질문만 들어감)

- Task-specific prefix 추가 → 특정 task에 알맞은 output text 생성

- Machine Translation (prefix = translate A to B)

- Text classification (prefix = mnli hypothesis A premise B)

-

T5

- Text-to-Text Format

- 거의 모든 자연어처리 문제를 해결하도록 학습된 seq-to-seq 형태의 Transformer 모델

- pre-training

-

다양한 모델 구조, 사전학습 목표, 사전학습용 데이터, Fine-tuning 방법

-

가장 성능이 좋은 방식들을 선택하여 방대한 규모의 모델 학습

-

- fine-tuning for Closed-book QA

- MRC 데이터셋의 QA pair 활용

- 데이터셋의 supporting document 무시

- prefix = trivia question: A

-

실험 setting

- 데이터셋: ODQA 데이터셋 or MRC 데이터셋 (지문 제거)

- 의미를 갖는 단위에 속하는 토큰 범위 마스킹 후 학습 (Salient Span Masking)

- pre-trained 체크포인트에서 추가로 pre-training 진행

- fine-tuning: pre-trained T5로 ODQA 학습 데이터셋으로 추가 학습

-

실험 결과

- 대부분의 Open-book 스타일 모델보다 뛰어난 성능을 보임

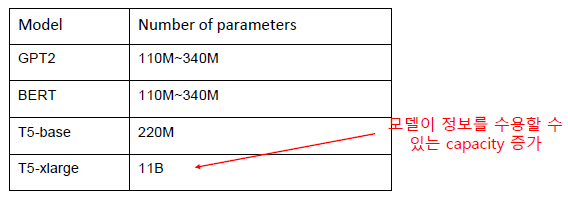

- 모델 크기가 커질수록 성능 증가

- Salient Span Masking이 성능을 크게 끌어올림

-

Closed-book QA의 한계 및 개선 방향

- 모델의 크기가 커서 계산량이 많고 속도가 느림 → 더 효율적인 모델 필요

- 모델이 어떤 데이터로 답을 내는지 알 수 없음 → 결과의 해석 가능성 높이는 연구 필요

- 모델이 참조하는 지식을 추가하거나 제거하기 어려움