증권 데이터 가져오기

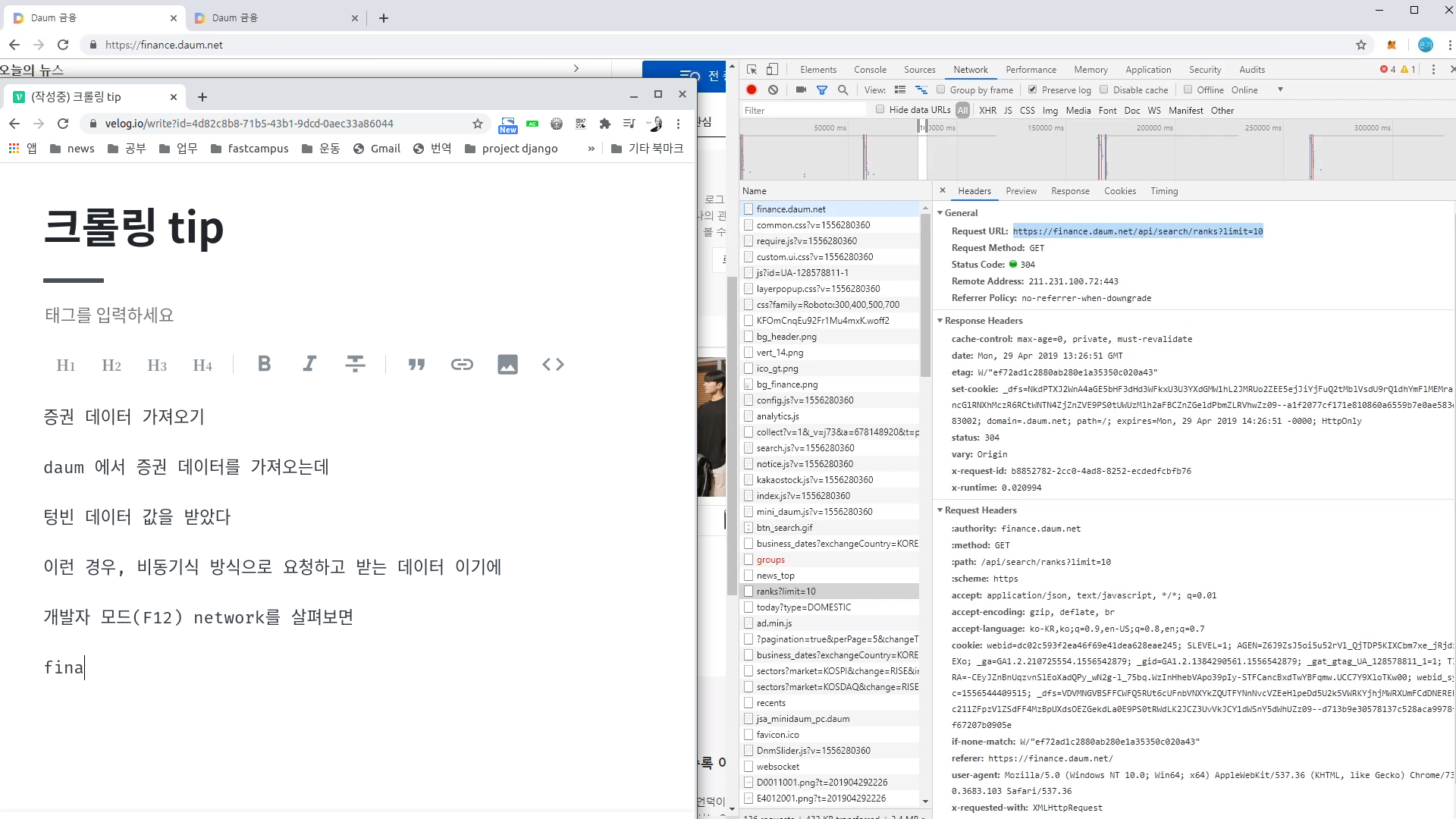

daum 에서 증권 데이터를 가져오는데

텅빈 데이터 값을 받았다

이런 경우, 비동기식 방식으로 요청하고 받는 데이터 이기에

개발자 모드(F12) network를 살펴보면

fina

그림에

- finance.daum.net

- ranks?limit=10

....을 클릭하여

Headers 값을 분석해야한다

분석한 결과 refer 는 이전 요청 페이지가 어디인지

(즉, 어디서 넘어왔는지)

user-agen: 브라우저인지 혹은 python engine 구별하여 403 페이지를 보여주기에 잘 분석해서 크롤링을 해야한다.

pip install fake-useragent

import json

import urllib.request as req

from fake_useragent import UserAgent

ua = UserAgent()

print(ua.ie)

headers = {

'User-agent':ua.ie,

'referer': 'https://finance.daum.net/'

}

# 다음 주식 요청 URL

url = "https://finance.daum.net/api/search/ranks?limit=10"

# 요청

res = req.urlopen(req.Request(url, headers=headers)).read().decode('UTF-8')

print('res', res)

rank_json = json.loads(res)['data']