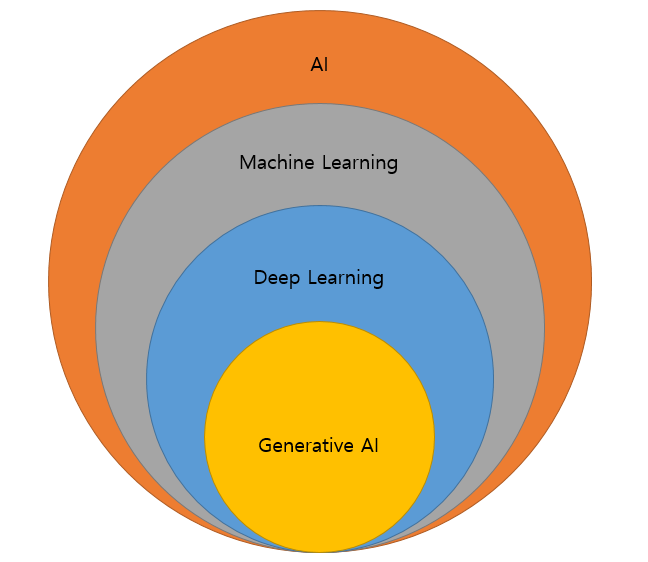

인공지능(Artificial Intelligence)

AI는 인간처럼 생각하고 학습하도록 프로그래밍된 기계에서 인간 지능을 시뮬레이션하는 것을 말합니다. AI의 목표는 시각적 인식, 음성 인식, 의사결정, 언어 번역 등 일반적으로 인간의 지능이 필요한 작업을 수행할 수 있는 시스템을 개발하는 것임.

AI 시스템은 기계 학습, 자연어 처리, 컴퓨터 비전 등 다양한 기술을 사용하여 데이터를 분석 및 해석하고 의사 결정을 내리며 시간이 지남에 따라 성능을 향상시킨다.

머신러닝(Machine Learning)

AI의 하위 집합인 머신 러닝(ML)에는 프로그래밍하지 않고도 예측이나 결정을 내릴 수 있도록 대규모 데이터에 대한 알고리즘을 훈련하는 것이다.

ML 알고리즘은 지도 학습(supervised learning), 비지도 학습(unsupervised learning), 강화 학습(reinforcement learning)으로 분류할 수 있고, 이것들은 패턴을 인식하고 예측이나 결정을 내리기 위해 데이터에 대한 학습훈련을 받음

지도 학습(supervised learning) 예시

- 이미지 분류: 사진 속 물체 인식, 의료 영상 진단 등

- 텍스트 분류: 스팸 메일 탐지, 문서 주제 분류 등

- 예측 모델링: 주식 가격 예측, 고객 이탈 예측 등

비지도 학습(unsupervised learning) 예시

- 고객 세분화: 고객 데이터를 활용하여 유사한 고객 그룹을 찾아내 마케팅 전략을 수립가능

- 이상 탐지: 정상적인 데이터와 이상치를 구분하여 사기 거래 탐지, 결함 감지 등에 활용가능

- 추천 시스템: 사용자의 선호도와 행동 패턴을 분석하여 개인화된 추천 서비스를 제공가능

강화 학습(reinforcement learning) 예시

- 자율 주행 자동차: 환경과 상호작용하며 최적의 주행 전략을 학습

- 로봇 제어: 로봇이 복잡한 환경에서 최적의 행동을 학습

- 게임 AI: 게임 환경에서 최적의 전략을 학습하여 인간 플레이어를 능가

딥러닝(Deep Learning)

딥러닝(DL)은 여러 layer로 구성된 신경망(neural networks)과 Deep neural networks를 지니고있는 ML 내의 전문 분야이다. multiple processing layers을 사용하여 데이터의 높은 수준의 추상화를 모델링하는 것을 목표로 한다.

DL은 특히 이미지 및 음성 인식, 자연어 처리, 게임 플레이와 같은 작업에서 많이 쓰이고, 대표적인 네트워크로 이미지 인식에 사용되는 CNN(합성곱 신경망, Convolutional Neural Network) 또는 자연어 처리에 사용되는 RNN(순환신경망, Recurrent Neural Network)이 있음.

생성형 AI(Generative AI)

생성형 AI(Generative AI)는 인간의 지능과 유사하게 지식을 다양한 업무에 걸쳐 이해하고, 학습하고, 적용할 수 있는 능력을 갖춘 인공지능의 한 형태.

생성형 AI는 광범위한 인지 능력을 보유하여 인간과 같은 지적 작업을 수행할 수 있고, Gen AI 모델은 주어진 데이터 세트의 패턴을 학습하고 해당 지식을 사용하여 새로운 데이터를 생성하는 기능을 갖추고 있으며 생성형 AI의 모델은 시각적 콘텐츠와 텍스트 콘텐츠를 모두 생성할 수 있습니다.

생성형 AI에 사용되는 모델

GAN(Generative Adversarial Network)

GAN은 머신러닝의 생성 모델의 일종으로 두 개의 신경망인 생성 모델(Generator)과 판별 모델(Discriminator)이 적대적 훈련을 통해 동시에 훈련된다. 생성모델는 새로운 데이터 인스턴스를 생성하고, 판별모델은 이를 평가하며 훈련된다. 목표는 생성기가 실제 데이터와 구별할 수 없는 데이터를 생성하는 것임.

GAN은 이미지 및 비디오 생성, 스타일 전송 및 현실적인 데이터 생성이 필요한 기타 작업에 널리 사용됨.

LLM(Large Language Model)

LLM은 일반적으로 모델의 매개변수 수 측면에서 규모가 큰 언어 모델을 나타낸다. 이러한 모델은 방대한 양의 텍스트 데이터를 학습하고 인간과 유사한 텍스트를 생성하고, 맥락을 이해하고, 다양한 자연어 처리 작업을 수행할 수 있다.

OpenAI의 GPT(Generative Pre-trained Transformer) 시리즈와 같은 대규모 언어 모델은 언어 번역, 텍스트 완성, 질문 답변 등과 같은 작업에 사용됨.

Transformer

Transformer는 일종의 신경망 아키텍처. Transformer는 self-attention이라는 메커니즘을 사용하여 입력 데이터를 병렬로 처리하므로 순차 또는 병렬 처리가 포함된 작업에 매우 효과적임.

Transformer는 자연어 처리의 기본 아키텍처가 되었으며 언어 이해를 위한 BERT(BiDirectional Encoder Representations from Transformers), 언어 생성을 위한 GPT 등 다양한 모델에 사용됨.