Neural Graph Collaborative Filtering 제5부 method

2.2 Embedding Propagation Layers

-

Next we build upon the mesage-apssing architecture of GNNs in order to capture CF signal along the graph structure are refine the embeddings of users and items.

다음으로 그래프 구조를 따라 CF 신호를 캡처하고 사용자와 항목의 임베딩을 구체화하기 위해 GNN [8, 38]의 메시지 전달 아키텍처를 기반으로합니다. -

We first illustrate the design of one-layer propagation, and then generalize it to multiple successive layers.

우리는 먼저 한 층 전파의 설계를 설명한 다음 여러 개의 연속적인 레이어로 일반화합니다

2.2.1 First-order Propagation.

-

Intuitively, the interacted items provide direct evidence on a user's perference' analogously, the users that consume an item can be terated as the item's features and used to measure the collaborative simlarity of two items.

직관적으로, 상호작용된 아이템들은 사용자의 선호도에 대한 직접적인 증거를 제공한다[16, 39]; 유사하게, 아이템을 소비하는 사용자는 아이템의 특징으로서 취급될 수 있고 두 아이템의 협업적 유사성을 측정하는 데 사용될 수 있다. -

We build upon this basis to perform embedding propagation between the connected users and items, formulating the process with two major operation: message consturction and message aggregation.

우리는 이러한 기반을 바탕으로 연결된 사용자와 항목 간에 임베딩 전파를 수행하여 메시지 구성 및 메시지 집계라는 두 가지 주요 작업으로 프로세스를 공식화한다.

Message Construction

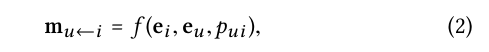

- For a connected user-item pair (u, i), we define the message form i to u as:

연결된 사용자 항목 쌍 (u, i)의 경우 메시지 양식 i를 다음과 같이 정의합니다.

-

where m u←i is the message embedding (i.e., the information to be propagated). f (·) is the message encoding function, which takes embeddings ei and eu as input, and uses the coefficient pui to control the decay factor on each propagation on edge (u, i).

여기서 mu←i는 메시지 임베딩(즉, 전파될 정보)이다. f (·)는 메시지 인코딩 함수로, ei 및 eu를 입력으로 임베딩하고 계수 pui를 사용하여 가장자리 (u, i)의 각 전파에 대한 감쇠 계수를 제어합니다. -

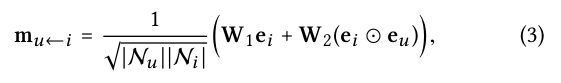

In this work, we implement f (·) as:

- where W1 , W2 ∈ Rd ′ ×d are the trainable weight matrices to distill useful information for propagation, and d′ is the transformation size.

여기서 W1, W2 rd Rd × × d는 전파에 유용한 정보를 증류하기 위한 훈련 가능한 무게 행렬이고, d′는 변환 크기이다.

-

Distinct from conventional graph convolution networks [4, 18, 29, 42] that consider the contribution of ei only, here we additionally encode the interaction between ei and eu into the message being passed via ei ⊙ eu , where ⊙ denotes the element-wise product.

ei의 기여만을 고려하는 종래의 그래프 컨볼루션 네트워크들[4, 18, 29, 42]과는 구별되며, 여기서 우리는 ei와 eu 사이의 상호작용을 ei ⊙ eu를 통해 전달되는 메시지로 추가로 인코딩하며, 여기서 ⊙는 element-wise product을 나타낸다 -

This makes the message dependent on the affinity between ei and eu , e.g., passing more messages from the similar items.

이것은 메시지를 ei와 eu 사이의 친화도에 의존하게 만든다, 예를 들어, 유사한 아이템들로부터 더 많은 메시지들을 전달한다. -

This is not only increases the model representation ability, but also boosts the performance for recommendataion(evidences in our experiments section 4.4.2)

이는 모델 표현 능력을 향상시킬 뿐만 아니라 권장 성능을 향상시킨다(우리 실험의 증거 4.4.2).

-

Following the graph convolutional network, we set as the graph Laplacian norm , where and denote the first-hop neighbors of user u and item i.

그래프 convolutional network에 따라, 우리는 를 라플라시안 norm에따라 설정한다. 여기서 와 는 사용자 u와 항목 i의 첫번째 first-hop neighbors로 나타낸다. -

From the viewpointof representation learning, reflects how much the historicla item contributes the user preference.

표현 학습의 관점에서, 는 과거 항목이 사용자 선호도에 얼마나 기여하는지 반영한다 -

From the viewpoint of message passing, can be interpreted as a discount factor, considering the messages being propagated should decay with the path length.

메시지 전달의 관점에서 는 전판되는 메시지가 경로 길이에 따라 decay 되어야 한다는 점을 고려하면 discount factor 요인으로 해석될 수 있다.

Message Aggregation.

-

In this stage, we aggregate the messages propagated from u's representation.

이 단계에서는 u의 표현을 다듬기 위해 u의 이웃에서 전파된 메시지를 집계한다. -

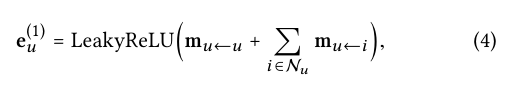

Specifically, we define the aggregation function as:

특히, 우리는 집계 함수를 다음과 같이 정의한다