구글 코랩을 이용해서 '웹' 브라우저에서 무료로 파이썬 프로그램을 테스트하고 저장할수 있다

실습 1. k-최근접 이웃 알고리즘을 사용하여 2개의 종류를 분류하는 머신러싱 모델 구현하기

(생선이름 자동으로 알려주는 머신러닝 만들기)

- 단순하게 생선 길이가 30cm 이상이면 도미야!

if fish_length >=30;

print("도미")그러나 30cm보다 큰 생선이 모두 도미는 아니다..고래도있고 상어도있고 등등

따라서 머신러닝이 스스로 도미의 기준을 정해서 분류한다

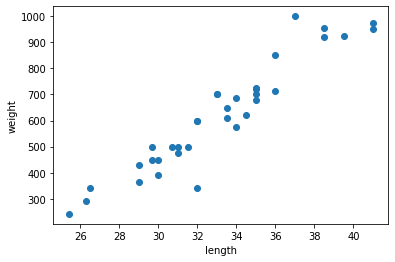

맷플롯립(matplotlib)패키지를 임포트(import)하여 scatter()함수사용

- 도미 값 입력

bream_length = [25.4, 26.3, 26.5, 29.0, 29.0, 29.7, 29.7, 30.0, 30.0, 30.7, 31.0, 31.0,

31.5, 32.0, 32.0, 32.0, 33.0, 33.0, 33.5, 33.5, 34.0, 34.0, 34.5, 35.0,

35.0, 35.0, 35.0, 36.0, 36.0, 37.0, 38.5, 38.5, 39.5, 41.0, 41.0]

bream_weight = [242.0, 290.0, 340.0, 363.0, 430.0, 450.0, 500.0, 390.0, 450.0, 500.0, 475.0, 500.0,

500.0, 340.0, 600.0, 600.0, 700.0, 700.0, 610.0, 650.0, 575.0, 685.0, 620.0, 680.0,

700.0, 725.0, 720.0, 714.0, 850.0, 1000.0, 920.0, 955.0, 925.0, 975.0, 950.0]

import matplotlib.pyplot as plt #matplotlib의 pyplot함수를 줄여서 plt로 사용

plt.scatter(bream_length, bream_weight)

plt.xlabel('length')

plt.ylabel('weight')

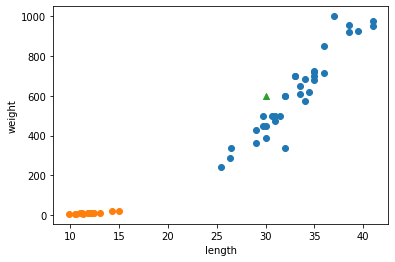

plt.show()- 도미값과 빙어값 모두 입력

smelt_length = [9.8, 10.5, 10.6, 11.0, 11.2, 11.3, 11.8, 11.8, 12.0, 12.2, 12.4, 13.0, 14.3, 15.0]

smelt_weight = [6.7, 7.5, 7.0, 9.7, 9.8, 8.7, 10.0, 9.9, 9.8, 12.2, 13.4, 12.2, 19.7, 19.9]

plt.scatter(bream_length, bream_weight)

plt.scatter(smelt_length, smelt_weight)

plt.xlabel('length')

plt.ylabel('weight')

plt.show()두개의 리스트 더해서 하나로 만들어주기

length = bream_length + smelt_length

weight = bream_weight + smelt_weight

print("length:", length)

print("weight:", weight)length: [25.4, 26.3, 26.5, 29.0, 29.0, 29.7, 29.7, 30.0, 30.0, 30.7, 31.0, 31.0, 31.5, 32.0, 32.0, 32.0, 33.0, 33.0, 33.5, 33.5, 34.0, 34.0, 34.5, 35.0, 35.0, 35.0, 35.0, 36.0, 36.0, 37.0, 38.5, 38.5, 39.5, 41.0, 41.0, 9.8, 10.5, 10.6, 11.0, 11.2, 11.3, 11.8, 11.8, 12.0, 12.2, 12.4, 13.0, 14.3, 15.0]

weight: [242.0, 290.0, 340.0, 363.0, 430.0, 450.0, 500.0, 390.0, 450.0, 500.0, 475.0, 500.0, 500.0, 340.0, 600.0, 600.0, 700.0, 700.0, 610.0, 650.0, 575.0, 685.0, 620.0, 680.0, 700.0, 725.0, 720.0, 714.0, 850.0, 1000.0, 920.0, 955.0, 925.0, 975.0, 950.0, 6.7, 7.5, 7.0, 9.7, 9.8, 8.7, 10.0, 9.9, 9.8, 12.2, 13.4, 12.2, 19.7, 19.9]

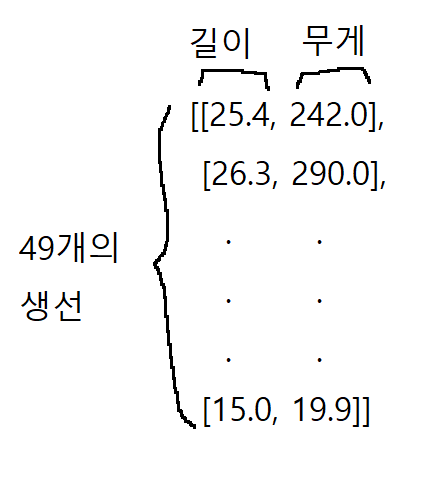

사이킷런(scikit-lean)사용하여각 특성의 리스트를 아래 세로로 만들기(2차원리스트)

HOW?

zip()함수와 리스트 내포 구문을 사용.

zip : 나열된 리스트 각각에서 하나씩 원소를 꺼내 반환

for : zip함수로 length와 weight 리스트에서 원소를 하나씩 꺼내어 l과 w에 할당

그러면 [l,w]가 하나의 원소로 구성된 리스트가 만들어짐

fish_data = [[l, w] for l, w in zip(length, weight)]

print(fish_data)[[25.4, 242.0], [26.3, 290.0], [26.5, 340.0], [29.0, 363.0], [29.0, 430.0], [29.7, 450.0], [29.7, 500.0], [30.0, 390.0], [30.0, 450.0], [30.7, 500.0], [31.0, 475.0], [31.0, 500.0], [31.5, 500.0], [32.0, 340.0], [32.0, 600.0], [32.0, 600.0], [33.0, 700.0], [33.0, 700.0], [33.5, 610.0], [33.5, 650.0], [34.0, 575.0], [34.0, 685.0], [34.5, 620.0], [35.0, 680.0], [35.0, 700.0], [35.0, 725.0], [35.0, 720.0], [36.0, 714.0], [36.0, 850.0], [37.0, 1000.0], [38.5, 920.0], [38.5, 955.0], [39.5, 925.0], [41.0, 975.0], [41.0, 950.0], [9.8, 6.7], [10.5, 7.5], [10.6, 7.0], [11.0, 9.7], [11.2, 9.8], [11.3, 8.7], [11.8, 10.0], [11.8, 9.9], [12.0, 9.8], [12.2, 12.2], [12.4, 13.4], [13.0, 12.2], [14.3, 19.7], [15.0, 19.9]]

정답 데이터 만들기(도미 = 1, 빙어 = 0)

WHY?

최소한 어떤 생선이 도미이고 생선인지 알려주기위한 작업 보통 2개일 겨우 1,0으로 구분함

fish_target = [1]*35 + [0]*14

print(fish_target)[1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0]

K-최근접 이웃 알고리즘 사용하기

KNeighborsClassfifer 임포트

from sklearn.neighbors import KNeighborsClassifier

임포트한 KNeighborsClassifier클래스를 객체로 만들기

kn = KNeighborsClassifier()

기준데이터와 정답데이터를 학습

fit() 메서드 사용하여 학습

kn.fit(fish_data, fish_target)

score() 메서드 사용하여 학습이 잘 되었는지 확인

1 : 모든 데이터를 정확하게 맞혔다

0.5 : 반만 맞췄다

0 : 애라 모르겠다kn.score(fish_data, fish_target) 1.01.0임으로 정확도 100%

실제로 예측 해보기

predict()메서드는 새로운 데이터의 정답을 예측함

kn.predict([[30,600]] 결과값 : array([1])1을 도미로 정의했으니, 녹색삼각형은 도미이다! 소오름

K-최근접 이웃 알고리즘은 새로운 데이터를 예측할때 가장 가까운 직선거리에 어떤 데이터가 있는지를 살피기만 하면 됨

단점 : 데이터 그기가 크면 메모리, 시간이 많이 필요해서 대량의 데이터에는 적합 X

- _fit_X , _y 속성에 데이터가 다있음

print(kn._fit_X) print(kn._y)결과값 : [[ 25.4 242. ] [ 26.3 290. ] [ 26.5 340. ] [ 29. 363. ] [ 29. 430. ] [ 29.7 450. ] [ 29.7 500. ] [ 30. 390. ] [ 30. 450. ] [ 30.7 500. ] [ 31. 475. ] [ 31. 500. ] [ 31.5 500. ] [ 32. 340. ] [ 32. 600. ] [ 32. 600. ] [ 33. 700. ] [ 33. 700. ] [ 33.5 610. ] [ 33.5 650. ] [ 34. 575. ] [ 34. 685. ] [ 34.5 620. ] [ 35. 680. ] [ 35. 700. ] [ 35. 725. ] [ 35. 720. ] [ 36. 714. ] [ 36. 850. ] [ 37. 1000. ] [ 38.5 920. ] [ 38.5 955. ] [ 39.5 925. ] [ 41. 975. ] [ 41. 950. ] [ 9.8 6.7] [ 10.5 7.5] [ 10.6 7. ] [ 11. 9.7] [ 11.2 9.8] [ 11.3 8.7] [ 11.8 10. ] [ 11.8 9.9] [ 12. 9.8] [ 12.2 12.2] [ 12.4 13.4] [ 13. 12.2] [ 14.3 19.7] [ 15. 19.9]] [1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 0 0 0 0 0 0 0 0 0 0 0 0 0 0]

즉,

-

실제로 KNN은 훈련되는게 없다.

-

fit() 메서드에서 전달한 데이터를 모두 저장하고 있다가 새로운 데이터가 등장하면 가장 가까운 데이터를 참고하여 도미인지 빙어인지 구분합니다.

그럼 가까운 몇 개의 데이터를 참고할까요?기본값은 5

-

만약에 49개(전체)를 참고한다면? ->정확도가 떨어짐

kn49 = KNeighborsClassifier(n_neighbors=49)kn49.fit(fish_data, fish_target)

kn49.score(fish_data, fish_target)

결과값 : 0.7142857142857143 << 35/49확률임그렇다면 기본값이 얼마일때 1이하로 내려갈까?

코딩 ㄱㄱ

kn = KNeighborsClassifier()

kn.fit(fish_data, fish_target)

for n in range(5,50):

kn.n_neighbors = n

score = kn.score(fish_data, fish_target)

if score < 1:

print(n,score)

break

결과 : 18 0.9795918367346939즉, 18부터 1 이하로 떨어짐으로 17까지는 정확도가 1이닷!