명령어 모음

useadd : 사용자 생성

userdel : 사용자 계정 삭제

usermod : 사용자 계정 정보 변경

passwd : 패스워드 부여

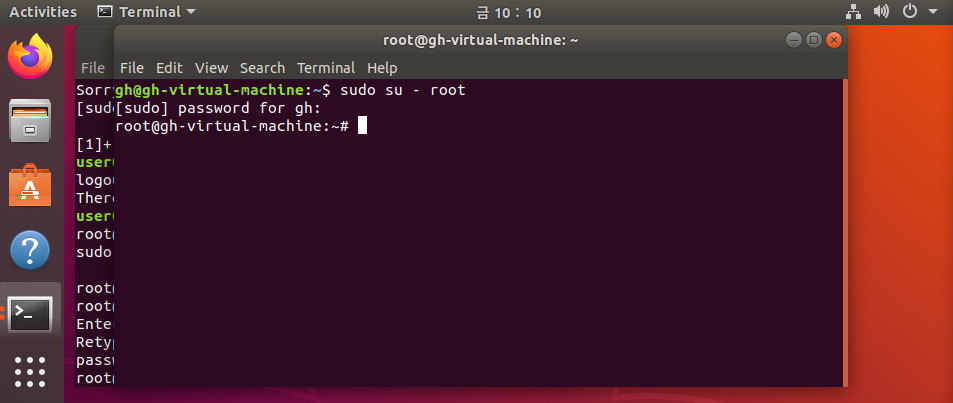

su : 다른 사용자로 로그인 할때 사용

sudo : 현재 계정에서 root의 권한을 이용할때 사용

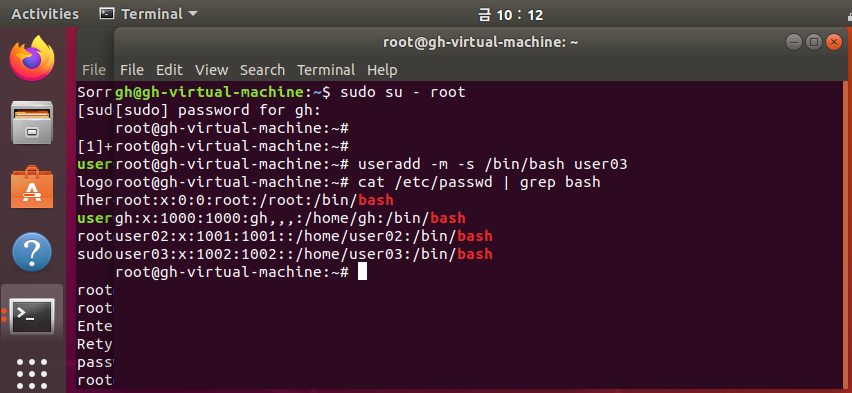

사용자 관리

useadd : 사용자 생성

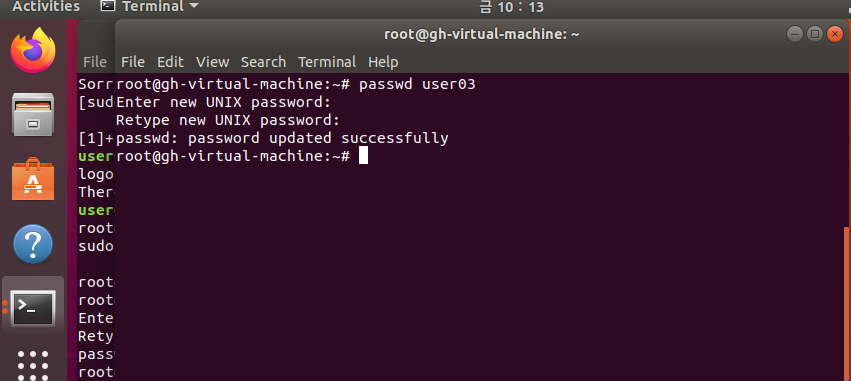

passwd 사용자명

관리자권한이기 때문에 유저 비번 맘대로 바꾸기 가능

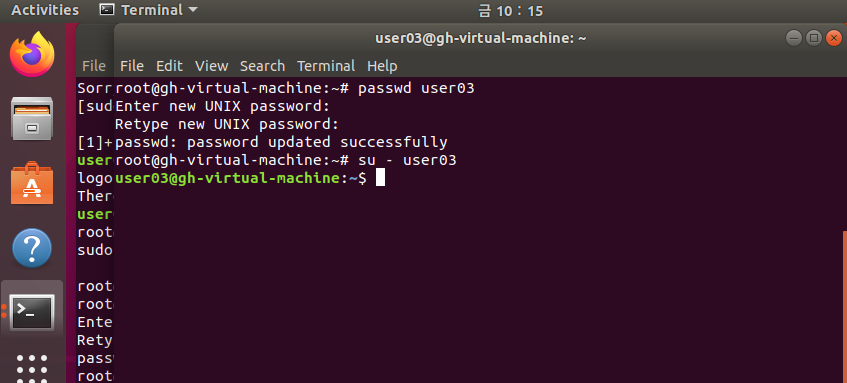

su - 사용자명

sudo su - root

추가적인거

-s /bin/bash

로그인 쉘을 배쉬로 한다

useradd -m -s /bin/bash user02

cat /etc/passwd | grep bash로 사용자들 확인 가능

su - user02

부팅 과정

런 레벨

1번이 안전모드 정도라고 생각하면됨

2 : 아직 네트는 불가능

init 해당 런레벨로 변경

init 0 = 종료

system

커널 이미지 파일

systemd 유닛

systemd는 전체 시스템을 시작하고 관리하는데 유닛이라고 부르는 구성요소를 사용

유닛의 종류

service : 데몬의 시작, 종료, 재시작 담당 atd.service

socket : 소켓을 관리하는 유닛 dbus.socket

device : 리눅스의 여러 장치들을 관리 dev-sda.device

mount : 마운트 포인트 관리 boot.mount

automount : 자동마운트포인트 관리 proc-sys-fs-binfmt_misc.automount

systemctl 옵션 명령 유닛이름

옵션

-a : 상태와 관계없이 유닛 전체를 출력한다

-t [유닛의 종류] : 지정한 종류의 유닛만 출려한다.

명령

start : 유닛을 시작

stop : 유닛을 정지

reload : 유닛의 설정 파일을 다시 읽어온다

restart : 유닛을 재시작

status : 유닛이 현재 상태를 확인한다.

enable : 부팅 시 유닛이 자동으로 시작되도록 설정한다.

diablse : 부팅 시 유닛이 자동으로 시작되지 않도록 한다.

systemctl restart mysqld

systemctl satus atd(예약작업 언제 실행하래)

systemctl list-units --type servic

디스크 추가

m은 도움말

파티션을 4개 이상 만들고 싶으면 주 파티션 3개 후 나머지들은 확장파티션으로 만들어야함

원래 마운트는 재부팅하면 풀리지만

ppt에 적힌 파일에서 등록시켜놓으면 안풀림

/etc/fstab 에서 vi해서 수정하면됨

파티션 만들기

ex)

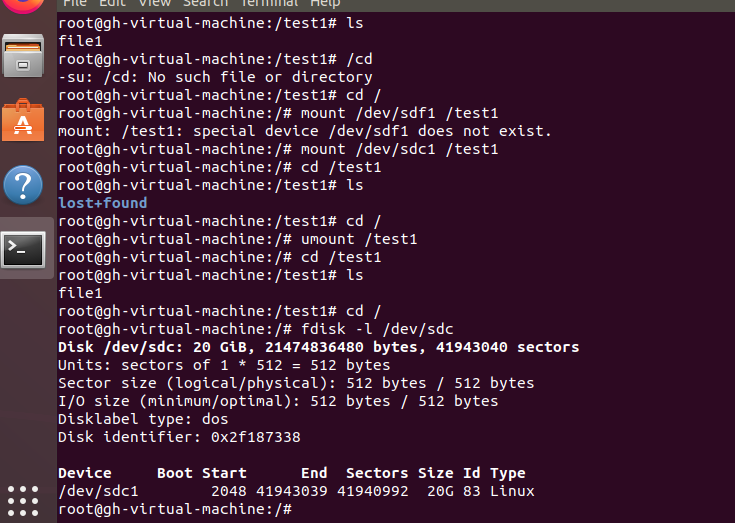

fdisk /dev/sdc

로 들어가서

n(파티션 추가) -> p or g(주 or 확장)

-> 1(파티션 번호) -> 시작 섹터 번호 -> 파티션 크기 -> p 확인 -> w 저장

저장까지 해야지만 파티션이 잘 나눠짐

그후 fdisk -l /dev/sdc로 확인하면

sdc1로 잘 나눠짐

그후 파일시스템을 만들어야 하는데

mkfs /dev/sdc1을 통해 생성

마운트 연결하기

루트에서 만든 디렉토리와 내가 파티션한 디스크를 연결하기위해서는 마운트를 사용해야함

mkdir /test1

을 통해 디렉토리를 만들고

cd /test1을 통해 이동

touch file1을 통해 만들면

현재 file1은 /dev/sda에 담겨있다

mount는 하기 전에 해당 디렉토리에 있으면 안되니 다시 루트 디렉토리로 이동

mount /dev/sdc1 /test1

을 하면 연결이 되고

cd /test1 하고 ls를 해보면 우리는 현재 sdc1과 연결이 되어있기 때문에

기존에 만든 file1은 없다

umount /test1 또는 umount /dev/sdc1로 연결 끊기 가능

mount 후

df -h를 입력해서 바로 확인도 가능

LVM 설정 전체적인 과정

1) 파티션 생성

파티션 생성할때 그냥 파티션이 아니라 LVM용 파티션으로 만들어줘야함

fdisk에서 t를 누르면 타입 변경가능 8e 입력하면 리눅스 LVM용으로 바뀜

2) pv생성 및 확인

pvcreate /dev/sdd1

pvscan : pv볼륨확인가능

pvdisplay /dev/sdd1 하면 더 자세히 확인 가능

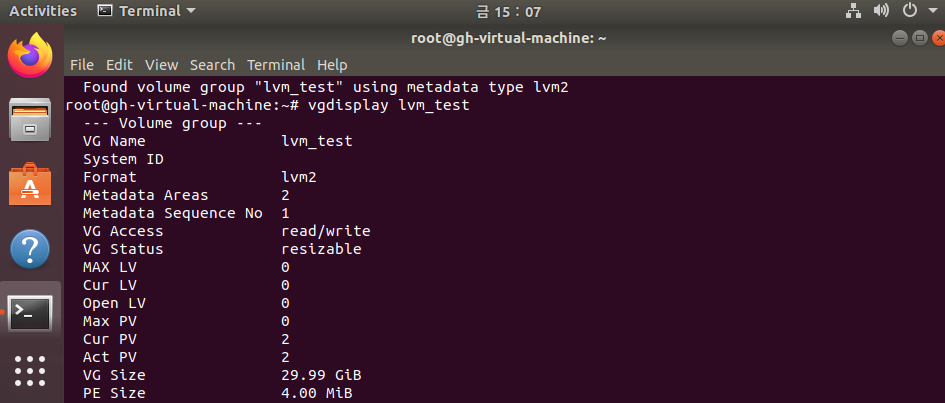

3) vg생성 및 확인

vgcreate lvm_test /dev/sdd1 한번에 여러개의 파티션 합치기 가능

vgscan

vgdisplay lvm_test로 볼륨확인 가능

10G인 sdd1과 20G인 sdc1을 합쳐서 30G로 만듬

물리적인 하드디스크를 합친게 VG

LV는 꼭 PV에 맞추지 않고 원하는 만큼 용량을 분할하는것을 의미

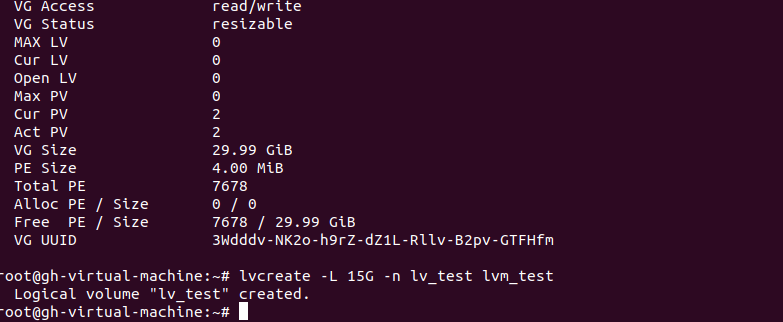

lv만들기

lvcreate -L 15G -n lv_test lvm_test

용량이15인 lv_test를 만드는데 lvm_test에서 분할해서 만든다.

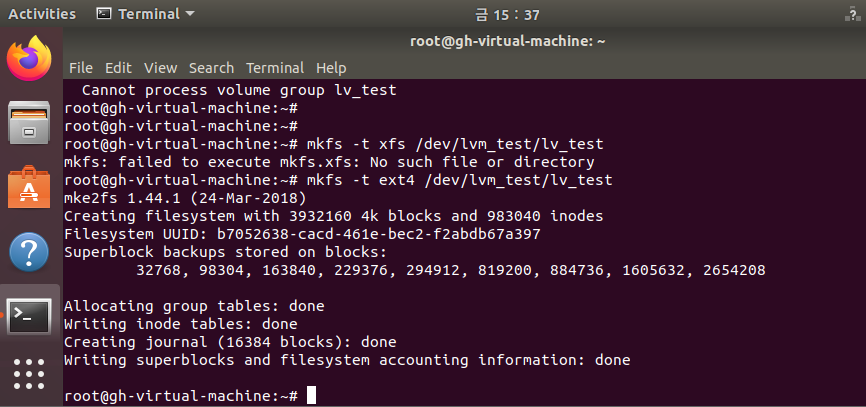

lv에 파일시스템 만들기

mkfs -t ext4 /dev/lvm_test/lv_test

파일시스템을 ext4타입(그나마 최신)으로 /dev/lvm_test/lv_test에 만든다.

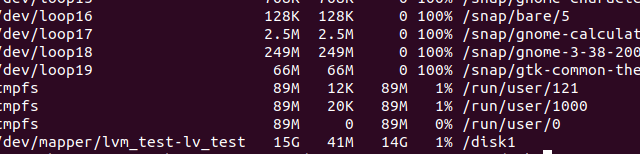

그후 마운트 하고 df -h

내 파티션들은 20G 10G였지만 lv로 15G로 만들어서 disk1에 마운트할 수 있었다.

미리 LVM을 해두면 나중에 급하게 용량을 추가할때 편하게 용량추가가 가능

ex)

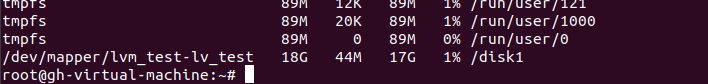

lvextend -L +3G /dev/lvm_test/lv_test

파일시스템도 다시 인식시켜줘야함

resize2fs /dev/lvm_test/lv_test

RAID

Raid0

lvcreate --type raid0 -L 2G lvm_test 해도 되고

lvcreate --type raid0 -L 2G lvm_test /dev/sdd1 /dev/sdc1 처럼 파티션을 여러개지정해도됨

--type 하면 레이드 타입을 뭘로할지 지정할 수 있음

Raid1

lvcreate --type raid1 --mirrors 1 -L 1G lvm_test

mirrors 1 은 복사본을 하나 더 만들어라 (하드디스크가 하나니까)

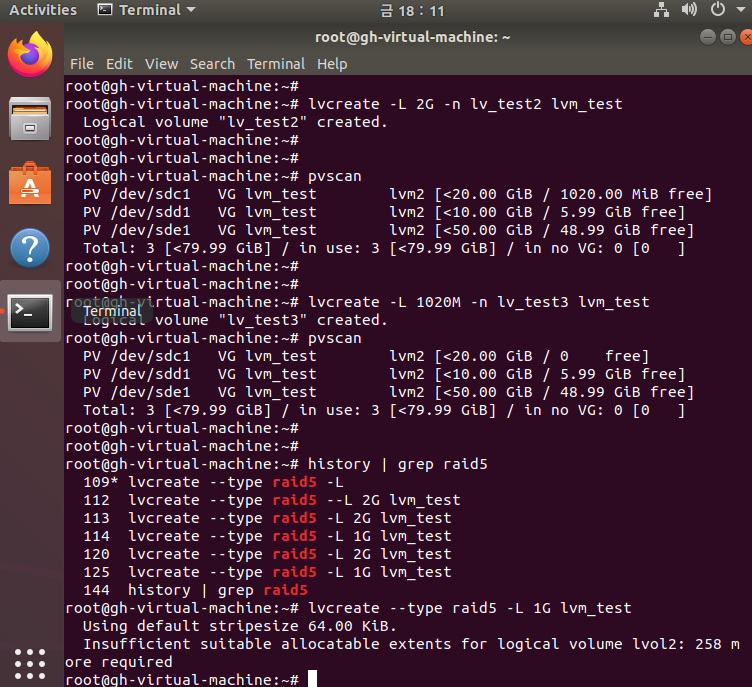

Raid5

lvcreate --type raid5 -L 2G lvm_test

추가적인 내용

vg에 새로우 파티션 추가하는법

vgextend lvm_test /dev/sde1

insufficient suitable allocatable extents for logical volume가 뜨는 이유

pe가 남아있는 하드디스크가 없어서 에러가 떴던것

10G와 20G로 Lv를 만들었는데 18G의 할당을 줘서

10G짜리의 pe는 남아있지 않다

이런상황에서

raid1 은 디스크를 2개를 필요로 하니까 오류가 떴던것

그래서 VG에 새로운 것을 추가하니 12G만큼 남아있는 20G와 50G만큼 남아있는 디스크 2개가 있으니 raid이 가능해진것

Raid 5 는 디스크가 최소 3개 필요

용량은 지정값 의 3/2만큼의 용량이 필요