Pytorch Distributed Study

1.Pytorch Distributed Overview

PyTorch 1.6.0 버전 이후 torch.distributed 는 3가지 메인 concept으로 분류가 가능Distributed Data-Parallel Training(DDP)sigle-program multiple-data training에서 주로 사용.모든

2023년 5월 26일

2.What is Distributed Data Parallel(DDP)

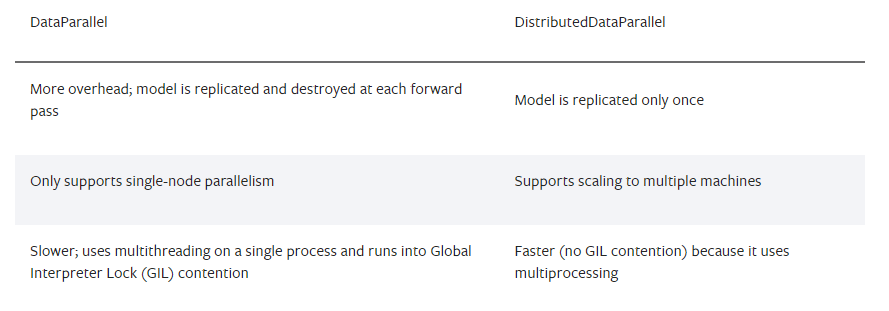

이전 글에서 살펴본 대로 DistributedDataParallel(DDP)는 data parallel training을 가능하게 해준다. Data parallel training은 multi-GPU에서 겹치지 않는 data batch를 받아 학습이 진행되는 방식이다.

2023년 5월 28일

3.Single-Node Multi-GPU Training

이번 튜토리얼에서는 single gpu training code로 부터 multi gpu training을 위해 어떤 부분이 바뀌고 추가되는지에 대한 내용을 다룬다. >* Note 만약 모델이 BatchNorm layer를 가지고 있다면, 모델의 모든 BatchNorm

2023년 5월 30일

4.Fault Tolerance

Fault-tolerant Distributed Training with torchrun distributed training에서 하나의 process failure는 전체 process failure로 이어진다. 높아진 failure 위험으로 인해 robust한 tr

2023년 6월 8일