KoGPT는 2021년 카카오브레인에서 발표한 GPT-3 한국어 버젼이다.

언어모델을 써야하는 일이 있어 써보기로 했다.

... 근데 어떻게 쓰는거지?

코드를 일단 돌려보고 고민해보자.

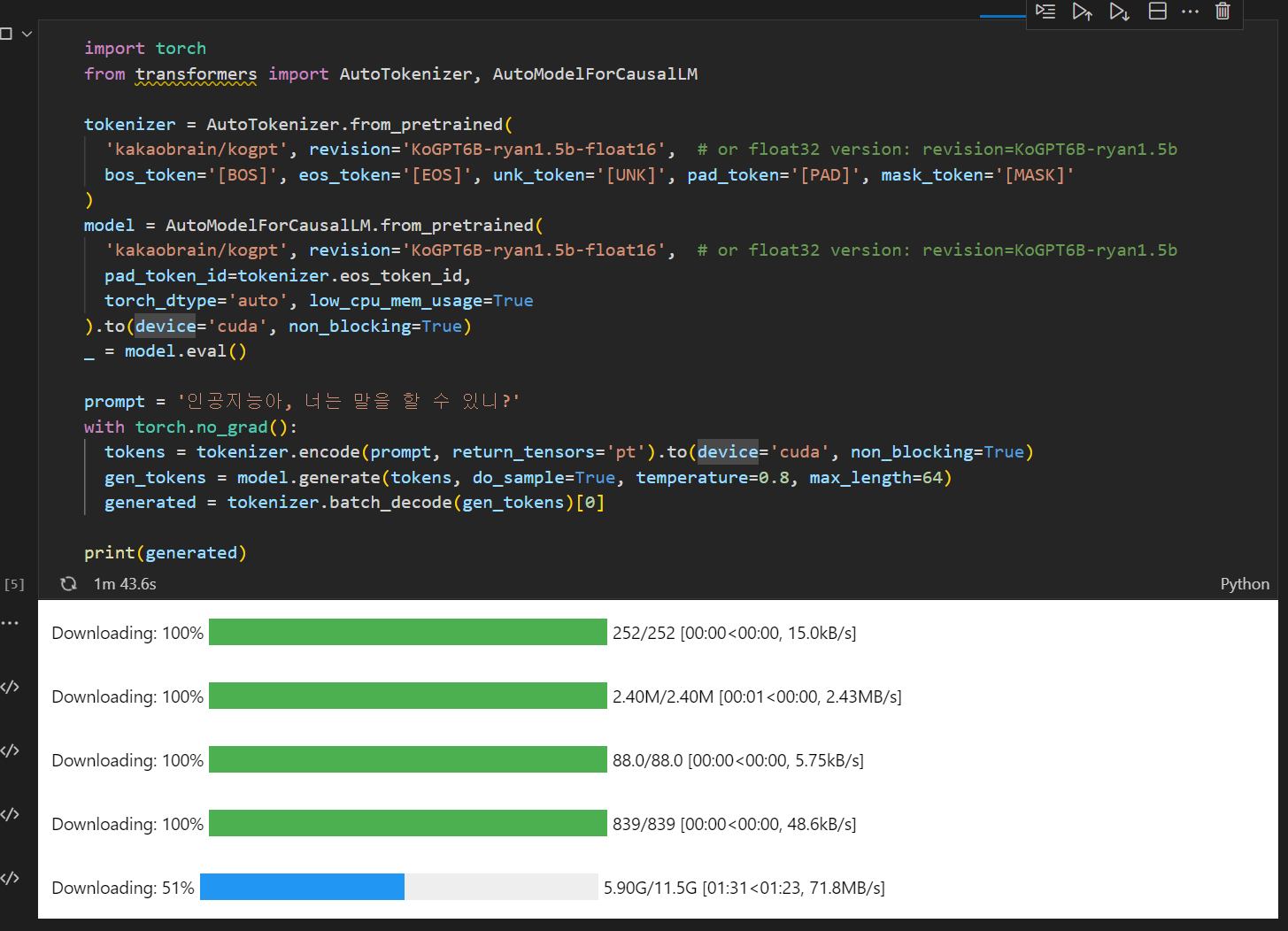

코드는 카카오브레인 Github, Huggingface에서 가져왔다.

https://huggingface.co/kakaobrain/kogpt

import torch

from transformers import AutoTokenizer, AutoModelForCausalLM

tokenizer = AutoTokenizer.from_pretrained(

'kakaobrain/kogpt', revision='KoGPT6B-ryan1.5b-float16', # or float32 version: revision=KoGPT6B-ryan1.5b

bos_token='[BOS]', eos_token='[EOS]', unk_token='[UNK]', pad_token='[PAD]', mask_token='[MASK]'

)

model = AutoModelForCausalLM.from_pretrained(

'kakaobrain/kogpt', revision='KoGPT6B-ryan1.5b-float16', # or float32 version: revision=KoGPT6B-ryan1.5b

pad_token_id=tokenizer.eos_token_id,

torch_dtype='auto', low_cpu_mem_usage=True

).to(device='cuda', non_blocking=True)

_ = model.eval()

prompt = '인공지능아, 너는 말을 할 수 있니?'

with torch.no_grad():

tokens = tokenizer.encode(prompt, return_tensors='pt').to(device='cuda', non_blocking=True)

gen_tokens = model.generate(tokens, do_sample=True, temperature=0.8, max_length=64)

generated = tokenizer.batch_decode(gen_tokens)[0]

print(generated)첫번째 오류.

위 코드를 돌리니 가장 처음 뜨는 오류는,

ModuleNotFoundError: No module named 'torch'torch 가 없대,,,ㅎㅎ

가상환경에서 pytorch를 설치하는 블로그를 보고 해결! 감사합니다

두번째 오류.

ModuleNotFoundError: No module named 'transformers'첫 번째 오류가 해결되니, 기다렸다는듯이 다른 오류!

-> 두 번째 오류는 anaconda prompt 에서

conda install transformers로 해결~

몇 분의 다운로딩 과정을 기다리면 된다.

어김없이 에러인데, Runtime Error

개인 pc에서는 안될것 같다.

연구실 pc에서 해보자!