데이터 분석 거버넌스

- 데이터 분석 → 하나의 기업 문화로 정착

: 기획/관리 조직 + 과제 기획/운영 프로세스 + 지원 인프라 + Data Goverance + 분석 교육 및 HR

1. 데이터 분석 과제 기획 / 운영 프로세스

: 과제 발굴 단계 ▶ 과제 수행 및 모니터링 단계

-

과제 발굴 단계

: 분석 Idea 발굴 → 분석 과제 후보 제안 → 과제 확정 -

과제 수행 및 모니터링 단계

: 팀 구성 → 분석 과제 실행 → 진행 관리 → 결과 공유 및 개선

2. 데이터 분석 지원 인프라

- 분석 플랫폼 구축

: 장기적, 지속적, 안정적 활용 및 확장성 고려

: 분석에 필요한 프로그래밍, 실행, 서비스 가능한 환경 제공

-

협의의 분석 플랫폼

: 데이터처리 Framework + 분석 엔진 + 분석 라이브러리 -

광의의 분석 플랫폼

: 협의의 플랫폼 + 분석 서비스 제공 엔진 + 분석 애플리케이션 + 분석 서비스 제공 API + OS + Hardware

3. Data Governance

: 개별 데이터 관리 시스템 → 중복 데이터 및 정합성 오류를 야기함

▶ Data Governance가 없는 빅데이터 적용 = 단발성 효과에 불가

Data Governance?

: 전사 차원의 모든 데이터에 대한 표준화 관리 체계를 수립/운영하기 위한 Framework, 저장소 구축

-

주요 관리 대상

- Master Data : 마스터 파일 형성, 데이터 처리 및 조작

- Meta Data : 구조화된 데이터, 다른 데이터 설명

- Data Dictionary : 효과적인 데이터 자원 관리

-

특징

: 데이터 가용성, 유용성, 통합성, 보안성, 안정성 확보 -

구성요소 (원칙 + 조직 + 프로세스)

- 원칙 : 보안, 품질기준, 버전관리

- 조직

- 프로세스 : 작업절차, 모니터링, 측정 방안 등

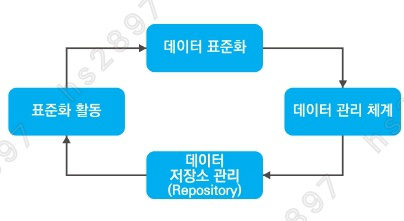

데이터 거버넌스 체계

-

데이터 표준화

: 표준 용어 설정, Meta Data & Data Dictionary 구축 -

데이터 관리 체계

: 데이터 생명 주기 관리 방안 수립 -

데이터 저장소 관리

: 전사 차원 저장소 구성, WF 관리 지원 -

표준화 활동

: 데이터 표준화 개선 → 실용성 증대

데이터 분석 수준 진단

: 현 상태에 대한 명확한 점검을 통해 데이터 분석의 유형과 방안 결정

: 현재 분석 수준을 이해하고 미래 목표 수준을 정의하는 과정

분석 수준진단 프레임워크

: 분석 준비도(Readiness) + 분석 성숙도(Maturity)

-

분석 준비도

: 6가지 영역에 대해 현 수준을 파악 → 일정 수준 충족 = 데이터 분석 업무 도입.

충족 X = 데이터 분석 환경 조성- 분석 업무 파악

- 인력 및 조직

- 분석 기법

- 분석 데이터

- 분석 문화

- IT 인프라

-

분석 성숙도 모델

: 비즈니스 / 조직 및 역량 / IT

→ 3개 부문을 대상으로 데이터 분석 능력, 결과 활용에 대한 성숙도 평가

: 성숙도 수준 = [도입 / 활용 / 확산 / 최적화]- 도입 단계

: 분석을 시작해 환경 및 시스템 구축 - 활용 단계

: 분석 결과를 실제 업무에 적용 - 확산 단계

: 전사 차원에서 분석 관리 및 공유 - 최적화 단계

: 분석을 진화, 혁신 및 성과 향상에 기여

- 도입 단계

-

분석 수준 진단 결과

: 현재 조직 수준 객관적으로 파악 → 향후 목표 및 방향 정의 / 개선방안 수립

Section 02. 데이터 분석 작업 계획

- 데이터 분석 작업 계획 = 데이터 처리 영역 + 데이터 분석 영역

데이터 분석 작업 계획

<데이터 처리 영역>

1. 데이터 소스

2. 데이터 수집

3. 데이터 저장

4. 데이터 처리<데이터 분석 영역>

5. 데이터 분석

6. 데이터 표현

1. 데이터 처리 영역

-

데이터 분석을 위한 기초 데이터 정의

-

수집, 저장, 분석을 위한 물리적 환경 제공

1. 데이터 소스

- 조직 내/외부 데이터, 미디어 정보(SNS)

2. 데이터 수집

- 직접 입력, log 수집, 크롤링 등

3. 데이터 저장

- 유형별 데이터 분리(정형/비정형), Data Storage

4. 데이터 처리

- 실시간 처리, 배치 처리, 분산 차리

2. 데이터 분석 영역

- 데이터 추출 ▶ 가공 ▶ 분석 수행 ▶ 결과 표현

분석 수행 절차

1. 도메인 이슈 도출

2. 분석 목표 수립

3. 프로젝트 계획 수립

4. 보유 데이터 자산 확인

데이터 확보 계획

1. 데이터 확보 사전 검토 사항

-

필요 데이터 정의

: 분석 목적에 맞는 데이터 정의

: 확보 가능 데이터 목록 및 기대효과 작성 -

보유 데이터 현황 파악

-

분석 데이터 유형 고려

: 정형, 반정형, 비정형 -

편향되지 않은 충분한 양의 데이터 규모

: 훈련 / 검증 / 테스트 데이터 셋 구분 -

내부 데이터 사용

: 법률 및 보안적 요소 고려

: 개인정보 데이터의 경우, 비식별 조치사항 수행 -

외부 데이터 사용

: Open API 등, 법률 및 제도 검토 -

데이터 수집 방법

: 크롤링, 스크래퍼, FGI(집단적 토론을 통한 의견 수집) 등

2. 분석 변수 정의

- 적합한 데이터 유형, 분석 변수 정의

: 빅데이터 특징(5V)고려, 측정 구간별 순수도를 가장 높이는 변수 도출

3. 분석 변수 생성 프로세스 정의

- 논리적 인과관계 분석 + 데이터 간 상관관계 분석 프로세스

-

객관적 사실 기반 문제 접근

: 분석적 가정(WHY)에 의한 접근법 + 무엇(WHAT)이 문제인지 파악 -

데이터 상관분석

-

프로토타입을 통한 분석 변수 접근

: 반복적 개선을 통해 비정형 데이터의 문제점 해소

- 문제 인식 수준을 확인하고, 필요 데이터 존재 유무를 확인함.

- 사용 목적에 따른 가변성 검증

4. 분석 변수 정제를 위한 점검 항목 정의

- 도출된 데이터에 대해 가용성 평가, 점검 항목 정의

- 논리적 지표에 따라 분석 변수 점검

분석 변수 점검의 논리적 지표

- 데이터 수집

- 데이터 적정성

- 데이터 가용성

- 대체 분석 데이터 유무

- 데이터 적합성

- 데이터 중복

- 분석 변수별 범위 (MIN, MAX)

- 분석 변수별 연관성

- 데이터 내구성 (Noise, 왜곡 발생 시 예측 성능을 보장하는지)

- 특징 변수

- 특징 변수 사용

- 변수 간 결합 가능 여부 파악 (교차 검증 가능 여부)

- 타당성

- 편익 및 비용 검증

- 기술적 타당성

5. 분석 변수 전처리 방법

- 논리적 모형 설계를 위한 Preprocessing 방법

- 정형/반정형/비정형 데이터를 분석에 적합한 데이터 형태로 변환

정제/통합/축소/변환의 반복적 수행- 정제

: 모순점 포착, MetaData 확인 - 통합 / 축소

: 데이터, 스키마 통합, 중복처리, 통계 생성 - 변환

: 노이즈 제거, 새로운 속성 추가, 정규화, 요약 및 집계

- 정제

6. 생성 변수 검증 방안 수립

- 데이터 양이 충분한 지(충분성) > 정확성

분석 절차와 작업 계획

1. 분석 절차

-

[문제 인식 ▶ 데이터 확보 및 분석 ▶ 결과 도출] 일련의 과정

정형화된 분석 절차

- 문제 인식 (문제 인식 및 분석 목적 정의)

- 연구 조사 (각종 문헌 조사, 해결 방안 정의)

- 모형화 (문제를 변수들 간의 관계로 정의)

- 데이터 수집

- 데이터 분석

- 분석 결과 제시

-

고려사항

-

문제에 대한 구체적 정의가 있고, 데이터와 분석 역량을 보유함

: 통계 기반 전통적 데이터 분석 수행 -

문제에 대한 구체적 정의가 없음

: Data Mining 기반 인사이트 발굴, 반복적으로 개선 결과 도출

-

2. 작업 계획

- 프로젝트 소요비용 배분 ▶ 작업 분할 구조 수립 ▶ 업무분장 계획 및 배분

작업 분할 구조 (WBS 작성)

- 데이터 분석 과제 정의

- 데이터 준비 및 탐색

- 분석 모델링 및 검증

- 산출물 정리

3. 분석 목표 정의서

-

분석 목표 수립 → 필요 데이터 정보, 분석 타당성 검토, 성과 측정 방법 등 정의

-

구성요소

-

원천 데이터 조사

: 데이터 정보 + 데이터 수집 난이도 -

분석 방안 및 적용 가능성 판단

: 분석 목표와 우선순위 조정 -

성과 평가 기준

3-1. 정성적

3-2. 정량적

-

분석 프로젝트 관리

- 도출된 분석기회 → 프로젝트화

분석 프로젝트 특징

- 도출된 결과 → 재해석 → 지속적 반복 및 정교화

추가적 중점관리 영역

- Data Size

- Data Complexity

- Speed (분석 모형의 성능, 속도)

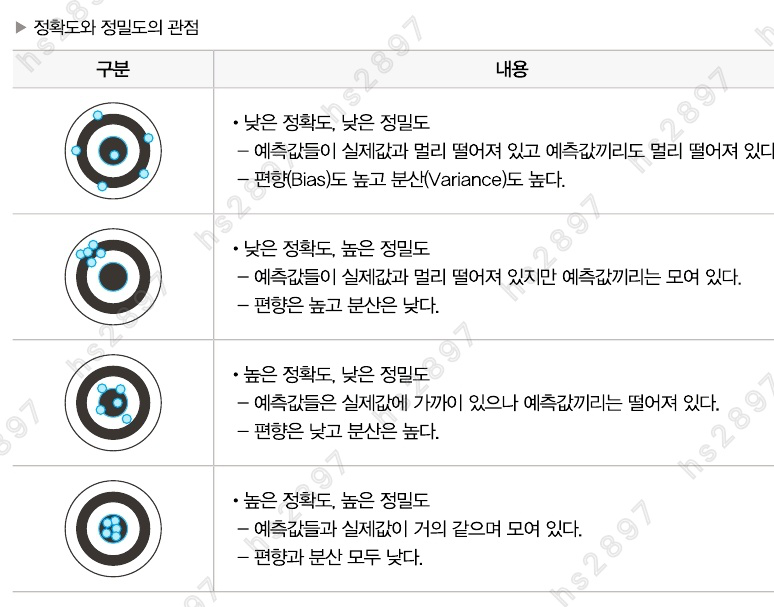

- 분석 모형의 복잡도 (정확도와 정밀도는 Trade Off 관계)

- 정확도와 정밀도

- 결과 활용 측면 : 정확도(Accuracy) 중요

- 안정성 측면 : 정밀도(Precision) 중요