신경망

신경망

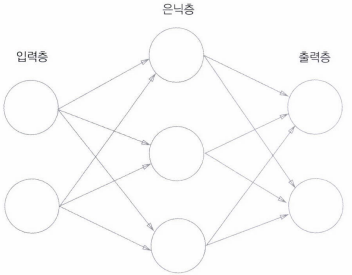

- 입력층, 은닉층(눈에 보이지 않음), 출력층으로 구성

- 비선형 함수 사용 : 선형 함수를 사용하면 1층 구조 → 은닉층이 없으며, 신경망의 층을 깊게 하는 의미가 없음

예시 신경망

- 입력층 → 0층, 은닉층 → 1층, 출력층 → 층

- 2층 신경망 구조

활성화 함수(Activation Function, h(x))

1. 활성화 함수

- 입력 신호의 총합을 출력 신호로 변환하는 함수

- a = b + w1x1 + w2x2

- y = h(a)

2. 계단 함수(Step Function)

- 임계값을 경계로 출력이 바뀌는 활성화 함수

- 입력값 > 0 → 1 출력

- 그 외 → 0 출력

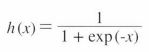

3. 시그모이드 함수(Sigmoid Function)

- 신경망에서 자주 이용하는 활성화 함수

- exp(-x) = e^-x

4. 계단 함수와 시그모이드 함수

- 차이점

계단 함수 시그모이드 함수 입력에 따라 출력이 연속적으로 변화 0을 경계로 출력이 갑자기 바뀜 출력 값이 실수 출력 값이 0 or 1 - 공통점

- 입력이 아무리 작거나 커도 출력은 0에서 1 사이

- 비선형 함수 (직선 1개로 그릴 수 없는 함수)

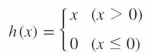

5. ReLU 함수(Rectified Linear Unit, 렐루)

- 입력값 > 0 → 입력값 그대로 출력

- 입력값 ≤ 0 → 0 출력

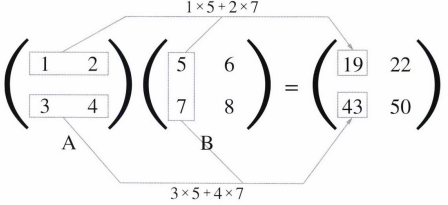

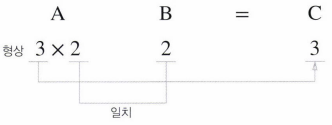

행렬의 곱

- 2X2 행렬

- x, y의 행렬과 y, x의 행렬은 다른 값이 될 수 있음

- x의 열과 y의 행의 수가 같아야 함

N층 신경망

- 입력층 + N-1개의 은닉층 + 출력층

출력층

1. 항등 함수 (Identity Function)

- 일반적으로 회귀에 사용

- 입력을 그대로 출력하는 함수 ⇒ 입력 == 출력

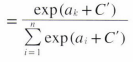

2. 소프트맥스 함수 (Softmax Function)

- 일반적으로 분류에 사용

- exp(x) = e^x - n : 출력층의 뉴런 수 - k : k번째 출력 - 문제점 : e의 지수값은 아주 큰 값이 되므로 오버플로우 문제를 일으켜 수식 개선 필요

- 개선된 수식

- C는 임의의 상수. 일반적으로 입력 신호 중 최댓값 이용 - C’ = logC - 출력값 : 0과 1 사이의 실수

- 출력의 총합 : 1 ⇒ 소프트맥스의 출력을 ‘확률’로 해석할 수 있음

- y = exp(x)는 단조 증가 함수로, a가 n번째 크다면 y도 n번째 큰 원소. 즉, 출력이 가장 큰 뉴런의 위치가 달라지지 않으므로, 신경망으로 분류할 때 자원 낭비를 줄이기 위해 소프트맥스 함수 생략 가능

- 분류 시 출력 뉴런 수 : 분류하고 싶은 클래스 수

데이터 처리

- 정규화 : 데이터를 특정 범위로 변환하는 처리

- 전처리 : 신경망의 입력 데이터에 특정 변환을 가하는 것

- 배치 : 하나로 묶은 입력 데이터

- 배치 처리를 하게 되면 데이터를 더 효율적이고 빠르게 처리할 수 있음