Spark

1.Spark, SBT / HelloWorld

단독 실행 가능한 기본 적인 애플리케이션을 구축하고 스파크 플랫폼으로 옮겨 실행하는 과정을 보여준다.목표 애플리케이션 구축하기프로젝트 관리 도구 설치신규 프로젝트 생성애플리케이션 구축단위 테스트스파크 서버 실행스파크에서 애플리케이션 실행 📗스파크 애플리케이션 구축은

2.Scala, PySpark 비교

Spark에서 Python, Java, Scala 중 어떤 언어를 선택할지 고민해야 하는 이유는 각 언어마다 성능, 사용성, 기능 지원이 다르기 때문이다. Spark의 핵심은 Scala로 작성되었지만, Python과 Java도 지원되므로 상황에 맞게 선택해야 한다.목표

3.스파크를 왜 사용해야 하나

비동기 처리 등을 이용한 프로그래밍을 통해 아주 빠른 병렬처리가 가능한 시대이다. 그럼에도 불과하고 스파크를 이용해야 하는 이유가 뭘까스파크 사용 이유 찾기비동기 처리는 단일 머신이나 작은 규모의 데이터 처리에는 매우 유용하지만, Spark는 대규모 분산 데이터 처리,

4.Spark, 스파크는 왜 생겨났나

스파크 탄생 배경 이해하기하둡 탄생 배경빅데이터 정의스파크 탄생 배경📗스파크는 왜 생겨났나(- 🔗\[목차](- 하둡의 탄생 배경(- 하둡 아키텍처( - 하둡의 구성요소(- 하둡의 한계(- Spark 탄생 배경( - Spark 아키텍처(- 스파크는 언제 사용할까(

5.하둡에서 쿠버네티스 플랫폼으로 이관을 고려해야 할까

하둡에서 Kubernetes로 이관을 고려하는 이유는 주로 운영 효율성과 확장성을 개선하기 위함이다.목표 아키텍처 정의하기스토리지: Object Storage (S3, MinIO) + Iceberg데이터 처리: Spark on Kubernetes, Flink on Ku

6.대용량 CSV 데이터를 스파크로 읽어보자

Kaggle, Google Dataset Search, Data.gov 등에서 대용량 CSV 파일을 다운로드할 수 있다.Kaggle: https://www.kaggle.com/datasetsGoogle Dataset Search: https://dat

7.RDBMS(MariaDB)에 대용량 데이터(사천팔백만건)를 스파크로 넣어보자

파일 크기가 5GB에 달하는 사천팔백만건에 달하는 데이터를 마리아디비에 적재하는데 걸리는 시간은 9분 남짓 걸렸다. 시스템의 환경 (CPU 성능, 개수, 메모리, 노드 수)에 따라 많은 차이가 날 것이다.대용량 데이터 처리에 대한 경험소스와 싱크 연결대용량 데이터 적재

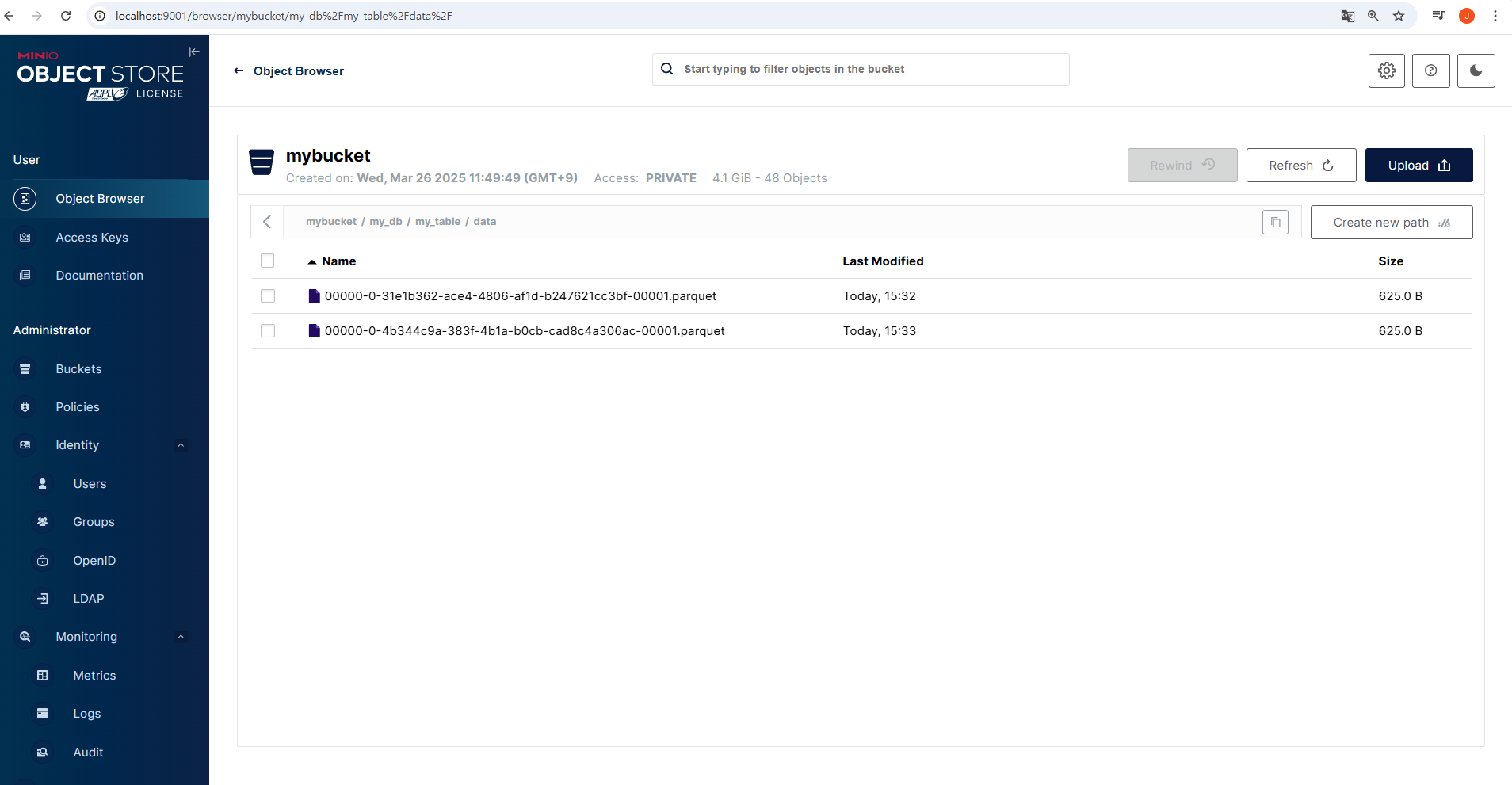

8.Spark, Iceberg

Apache Iceberg는 데이터 레이크를 위한 현대적인 테이블 포맷으로, 기존 Hive 기반의 데이터 관리 문제를 해결하고, ACID 트랜잭션, 스키마 진화, 타임 트래블, 최적화된 데이터 스캔 등의 기능을 제공한다.Spark, Trino, Flink 등 다양한 엔

9.Spark, 데이터 표현계층

🏳️🌈 궁금한점데이터 표현 계층 종류스키마, 데이터프레임,데이터세트,스파크SQL 개념📗스파크의 데이터 표현 계층(- 🔗\[목차](- 데이터 표현 모델( - 스키마( - 데이터프레임( - RDD( - RDD의 주요 특징( - RDD의 주요 연산(

10.Spark, Spark-On-Kubernetes

Spark on Kubernetes는 Apache Spark 애플리케이션을 Kubernetes 클러스터 위에서 직접 실행하는 방법을 말한다. Spark Driver와 Spark Executor가 Kubernetes의 Pod로 실행된다. Kubernetes가 자원 할당,

11.Spark, IntellJ SBT SDK

'/mnt/c/' 뒤에 윈도우 경로 줄경우 WSL에서 윈도우 파일 시스템 접근 가능예를 들어 c:/workspace/kafka-stream 가 sbt project 라면, wsl 내에서 아래로 이동해서 sbt 컴파일이 가능하다.가령 Ubuntu-20.04이라는 이름의

12.Spark, Spark Operator 활용방향

Spark Streaming을 Spark Operator로 장기 실행시키고, 배치는 spark-submit로 On-Demand 실행한다.단발성 작업에 적합예: 하루치 로그를 모아서 Parquet로 변환, 대규모 집계, ML 모델 학습주기 실행이 필요하면 Airflow,