이 장은 면접에서 자주 나오는 "대규모 트래픽"을 어떻게 처리할 것인가에 대해서 다룬다.

한 명의 사용자부터 몇백만의 사용자를 처리하는 데에 있어 어떻게 시스템을 설계해야할까?

단일 서버

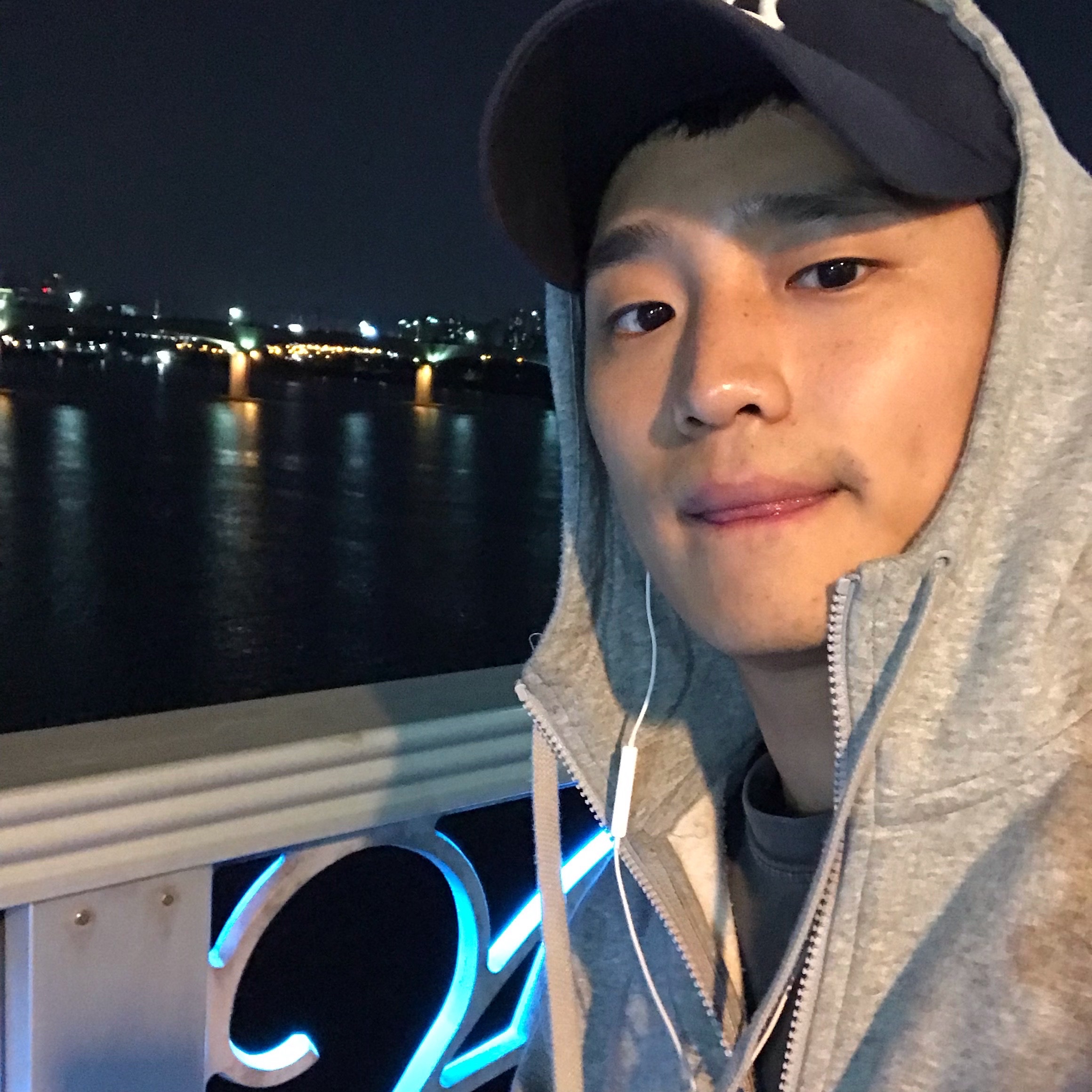

웹 앱, 데이터베이스, 캐시 등 모든 컴포넌트가 한 대의 서버에서 실행되는 간단한 시스템을 보면 다음과 같다.

위 그림을 이해하기 위해서는 사용자의 요청이 처리되는 과정과 요청을 만드는 단말에 대해서 이해할 필요가 있다.

-

사용자의 단말(웹 브라우저 혹은 모바일 앱)에서 도메인 이름을 이용하여 웹사이트에 접속한다. 이 접속을 위해서는 도메인 이름을 도메인 이름 서비스(DNS)에 질의하여 IP 주소로 변환하는 과정이 필요하다.

- DNS는 보통 제3 사업자가 제공하는 유료 서비스를 이용하게 된다.

-

DNS 조회 결과로 IP 주소가 반환된다.

-

해당 IP 주소로 HTTP 요청이 전달된다.

-

요청을 받은 웹 서버는 HTML 페이지나 JSON 형태의 응답을 반환한다.

이제 실제 요청이 어디로부터 오는지 살펴보자. 이 요청들은 다음 두 가지 종류의 단말로부터 온다.

- 웹 애플리케이션

- 비즈니스 로직, 데이터 저장 등을 처리하기 위해서는 서버 구현용 언어를 사용하고, 프레젠테이션 용으로는 클라이언트 구현용 언어를 사용한다.

- 모바일 앱

- 모바일 앱과 웹 서버 간 통신을 위해서는 HTTP 프로토콜을 이용한다. HTTP 프로토콜을 통해서 반환될 응답 데이터의 포맷으로는 보통 다음과 같은 JSON(JavaScript Object Notation)이 널리 쓰인다.

{

"id": 12,

"firstName": "John",

"lastName": "Smith",

“address": {

"streetAddress": "21 2nd Street",

"city": "New Tork",

"state": "NY",

"postalCode": 10021

},

"phoneNumbers": [

"212 555-1234”,

"646 555-4567"

]

}데이터베이스

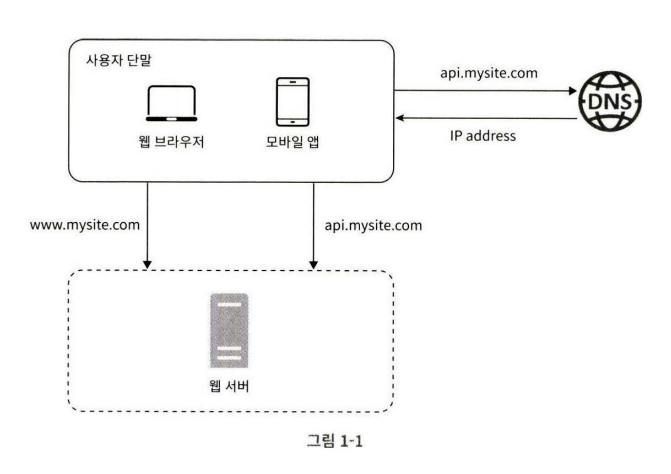

사용자가 늘면 서버 하나로는 충분하지 않아서 여러 서버를 두어야 한다.

하나는 웹/모바일 트래픽 처리 용도이고, 다른 하나는 데이터베이스용이다.

트래픽 처리 서버(웹 계층)와 데이터베이스 서버(데이터 계층)을 분리하면 각각을 독립적으로 확장해 나갈 수 있게 된다.

어떤 데이터베이스를 사용할 것인가?

데이터베이스는 크게 관계형 데이터베이스와 비관계형 데이터베이스로 나눌 수 있다.

관계형 데이터베이스

관계형 데이터베이스는(RelationalDatabase)는 관계형 데이터베이스 관리 시스템(RDBMS, Relational Database Management System)이라고도 부른다.

RDBMS 중 가장 유명한 것은 MySQL, Oracle DB, PostgreSQL 등이 있다.

관계형 데이터베이스는 자료를 테이블과 row, column으로 표현한다. SQL을 사용하면 여러 테이블에 있는 데이터를 그 관계에 따라 조인하여 합칠 수 있다.

비관계형 데이터베이스

NoSQl이라고도 불리는 비관계형 데이터베이스는 CouchDB, MongoDB, Amazon DynamoDB, Cassandra 등이 있다.

NoSQL은 다시 네 부류로 나눌 수 있다.

- 키-값 저장소(key-value store)

- 그래프 저장소(graph store)

- 칼럼 저장소(column store)

- 문서 저장소(document store)

이러한 비관계형 데이터베이스는 일반적으로 조인 연산은 지원하지 않는다.

현업에서는 관계형 데이터베이스가 약 40년 이상 시장에서 살아남았기에 커뮤니티와 규모, 수요도 큰 편이다.

하지만 적재적소의 사용도가 있듯이, 아래와 같은 경우에는 비관계형 데이터베이스의 사용을 고려해볼 법 하다.

- 아주 낮은 응답 Latency가 요구됨

- 다루는 데이터가 비정형(unstructured). 즉. 관계형 데이터가 아님

- 데이터(JSON, YAML, XML 등)를 직렬화하거나 역직렬화 할 수 있기만 하면 됨(serialize, deserialize)

- 아주 많은 양의 데이터를 저장할 필요가 있음

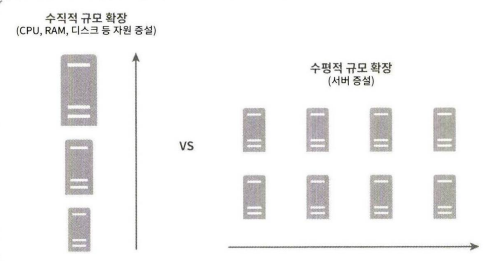

수직적 규모 확장 vs 수평적 규모 확장

소위 scale up이라고도 하는 수직적 규모 확장(veriacal scaling) 프로세스는 서버에 고사양 자원(더 좋은 CPU, 더 많은 RAM 등)을 추가하는 것이다. scale out이라고 하는 수평적 규모 확장 프로세스는 더 많은 서버를 추가하여 성능을 개선하는 행위를 말한다.

서버로 유입되는 트래픽의 양이 적을 때는 수직적 확장이 단순하며 좋은 선택이지만, 몇 가지의 단점이 존재하는데 다음과 같다.

- 수직적 규모 확장에는 한 대의 서버에 CPU나 메모리를 무한대로 증설할 방법이 없으므로 한계가 있다.

- 수직적 규모 확장법은 장애에 대한 자동복구(failover) 방안이나 다중화(redundancy) 방안을 제시하지 않는다. 서버에 장애가 발생하면 웹사이트/앱은 완전히 중단된다.

이러한 문제점들로 인해, 대규모 어플리케이션을 지원하는 데는 수평적 규모 확장법이 보다 적절하다.

너무 많은 사용자의 트래픽을 처리하게 되면 웹 서버가 한계 상황에 도달하게 되어 응답 속도가 느려지거나 서버 접속이 불가능해질 수도 있다.

이런 문제를 해결하는 데는 부하 분산기 혹은 로드밸런서를 도입하는 것이 최선이다.

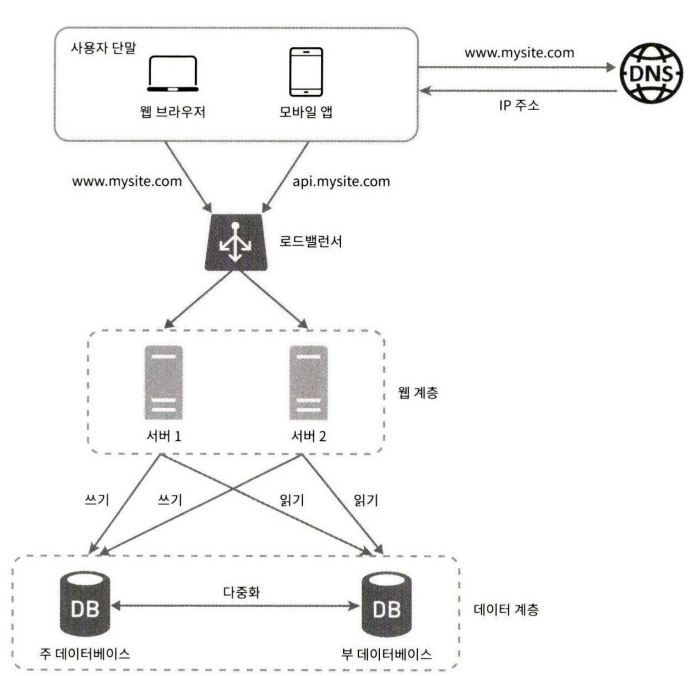

로드밸런서

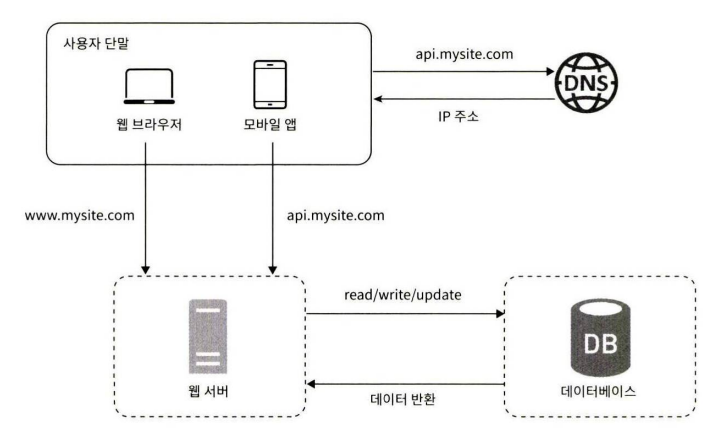

로드밸런서(Load Balancer)는 부하 분산 집합(load balancing set)에 속한 웹 서버들에게 트래픽 부하를 고르게 분산하는 역할을 한다.

위의 그림을 보면, 사용자는 로드밸런서의 공개 IP주소로 접속한다. 즉, 웹 서버는 클라이언트의 접속을 직접 처리하지 않는다.

더 나은 보안을 위해, 서버 간 통신에는 사설 IP 주소가 이용된다.

사설 IP 주소는 같은 네트워크에 속한 서버 사이의 통신에만 쓰일 수 있는 IP 주소로, 인터넷을 통해서는 접속할 수 없다. 로드밸런서는 웹 서버와 통신하기 위해 바로 이 사설 주소를 이용한다.

부하 분산 집합에 또 하나의 웹 서버를 추가하고 나면 장애를 자동복구하지 못하는 문제(no failover)는 해소되며, 웹 계층의 가용성(availability)은 향상된다.

그림에 설명을 덧붙이자면 다음과 같다.

- 서버 1이 다운되면(offline) 모든 트래픽은 서버 2로 전송된다. 따라서 웹 사이트 전체가 다운되는 일이 방지된다.

- 웹 사이트로 유입되는 트래픽이 가파르게 증가하면 두 대의 서버로 트래픽을 감당할 수 없는 시점이 오는데, 웹 서버 계층에 더 많은 서버를 추가하기만 하면 된다. 그러면 로드밸런서가 자동적으로 트래픽을 분산하기 시작할 것이다.

웹 계층은 이러한 방식으로 트래픽을 처리할 수 있다. 그렇다면, 데이터베이스(데이터 계층)은 어떻게 처리해야 할까?

지금까지의 설계는 하나의 데이터베이스 서버일 뿐이고, 장애의 자동복구나 다중화를 지원하는 구성은 아니다.

데이터베이스 다중화는 이러한 문제를 해결하는 보편적인 기술이다.

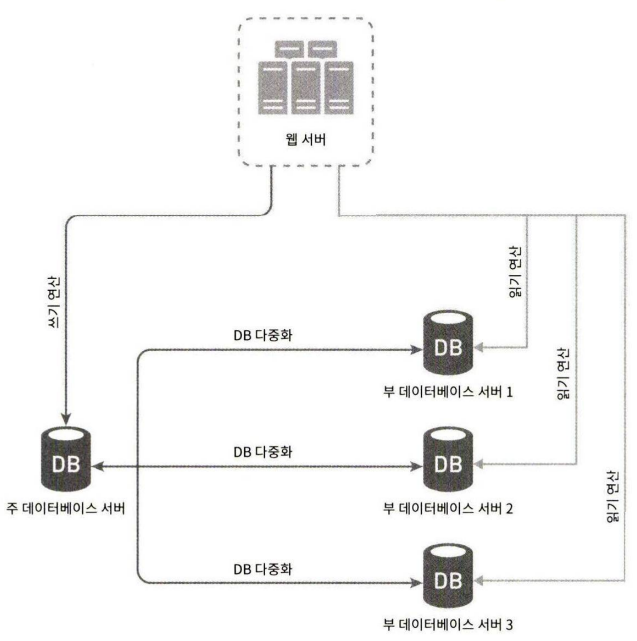

데이터베이스 다중화

데이터베이스 다중화는 서버 사이에 주(master)-부(slave) 관계를 설정하고 데이터 원본은 주 서버에, 사본은 부 서버에 저장하는 방식이다. 현대의 많은 DBMS가 다중화를 지원한다.

쓰기 연산(write operation)은 마스터에서만 지원한다. 부 데이터베이스는 주 데이터베이스로부터 그 사본을 전달받으며, 읽기 연산(read operation)만을 지원한다. 데이터베이스를 변경하는 명령어들(ex. insert, delete, update) 등은 주 데이터베이스로만 전달되어야 한다.

대부분의 application은 읽기 연산의 비중이 쓰기 연산보다 훨씬 높다.

따라서, 통상 부 데이터베이스의 수가 주 데이터베이스의 수보다 많다.

데이터베이스 다중화는 다음과 같은 장점이 있다.

- 더 나은 성능

- 주-부 다중화 모델에서 모든 데이터 변경 연산은 주 데이터베이스 서버로만 전달되는 반면, 읽기 연산은 부 데이터베이스 서버들로 분산된다. 병렬로 처리될 수 있는 질의의 수가 늘어나므로 성능이 좋아진다.

- 안정성

- 자연 재해 등의 이유로 DB 서버 가운데 일부가 파괴되어도 데이터는 보존될 것이다. 데이터를 지역적으로 떨어진 여러 장소에 다중화시켜 놓을 수 있기 때문이다.

- 가용성

- 데이터를 여러 지역에 복제해 둠으로써, 하나의 데이터베이스 서버에 장애가 발생하더라도 다른 서버에 있는 데이터를 가져와 계속 서비스할 수 있게 된다.

만약, 데이터베이스 서버 가운데 하나가 다운되면 어떻게 될까?

-

부 서버가 한 대 뿐인데 다운된 경우라면?

- 읽기 연산은 한시적으로 모두 주 데이터베이스로 전달될 것이다. 또한 즉시 새로운 부 데이터베이스 서버가 장애 서버를 대체할 것이다. 부 서버가 여러 대인 경우에 읽기 연산은 나머지 부 데이터베이스 서버들로 분산될 것이며, 새로운 부 데이터베이스 서버가 장애 서버를 대체할 것이다. -

주 데이터베이스 서버가 다운되면?

- 한 대의 부 데이터베이스만 있는 경우 해당 부 데이터베이스 서버가 새로운 주 서버가 될 것이며, 모든 데이터베이스 연산은 일시적으로 새로운 주 서버상에서 수행될 것이다. 그리고, 새로운 부 서버가 추가될 것이다.프로덕션 환경에서 벌어지는 일은 이것보다는 사실 더 복잡하다.

부 서버에 보관된 데이터가 최신 상태가 아닐 수 있기 때문이다. 없는 데이터는 복구 스크립트(recovery script)를 돌려서 추가해야 한다.

다중 마스터(multi-master)나 원형 다중화(circular replication) 방식을 도입하면 이런 상황에 대처하는 데 도움이 될 수는 있지만 구성이 훨씬 복잡해진다.

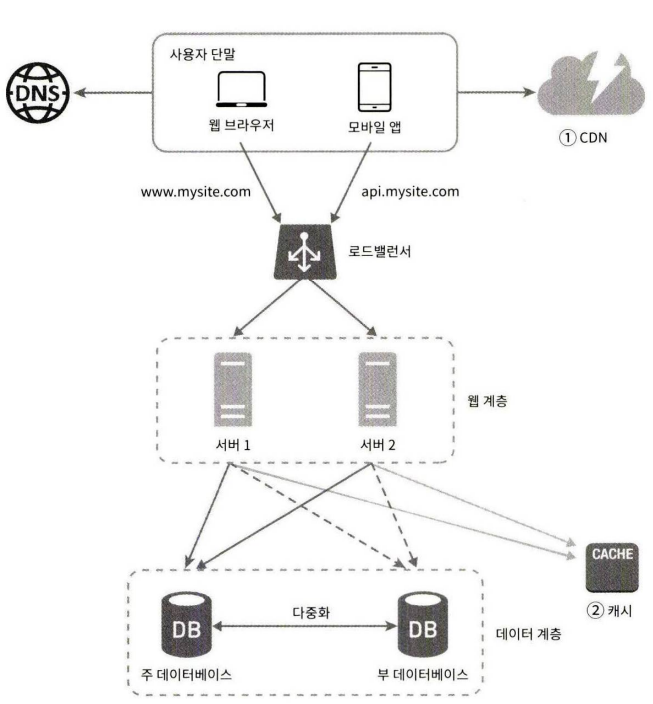

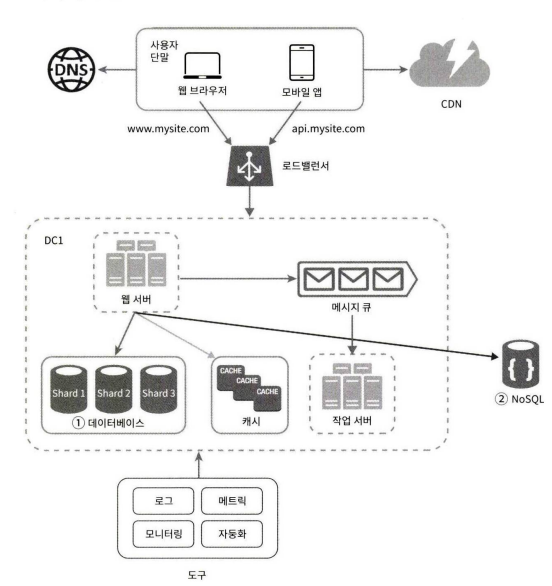

다음 그림은, 로드밸런서와 데이터베이스 다중화를 고려한 설계안이다.

위 그림은 다음과 같이 동작한다.

- 사용자는 DNS로부터 로드밸런서의 공개 IP 주소를 받는다.

- 사용자는 해당 IP 주소를 사용해 로드밸런서에 접속한다.

- HTTP 요청은 서버 1이나 서버 2로 전달된다.

- 웹 서버는 사용자의 데이터를 부 데이터베이스 서버에서 읽는다.

- 웹 서버는 데이터 변경 연산은 주 데이터베이스로 전달한다. 데이터 추가, 삭제, 갱신 연산 등이 이에 해당한다.

이제 웹 계층과 데이터 계층에 대해 충분히 이해하게 되었으니, 응답시간(Latency)을 개선해야한다.

응답 시간은 캐시(Cache)를 붙이고 정적 콘텐츠를 콘텐츠 전송 네트워크(Content Delivery Network, CDN)로 옮기면 개선할 수 있다.

캐시

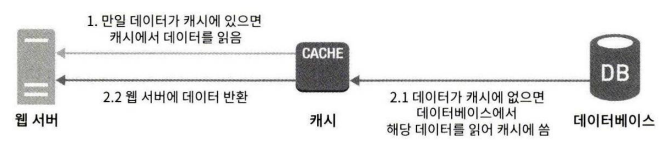

캐시는 값비싼 연산 결과 또는 자주 참조되는 데이터를 메모리 안에 두고, 뒤이은 요청이 보다 빨리 처리될 수 있도록 하는 저장소다.

웹 페이지를 새로고침 할 때마다 표시할 데이터를 가져오기 위해 한 번 이상의 데이터베이스 호출이 발생한다. 애플리케이션의 성능은 데이터베이스를 얼마나 자주 호출하느냐에 크게 좌우되는데, 캐시는 그런 문제를 완화할 수 있다.

캐시 계층

캐시 계층(Cache Tier)은 데이터가 잠시 보관되는 곳으로 데이터베이스보다 훨씬 빠르다. 별도의 캐시 계층을 두면 성능이 개선될 뿐 아니라 데이터베이스의 부하를 줄일 수 있고, 캐시 계층의 규모를 독립적으로 확장시키는 것도 가능해진다. 아래 그림은 캐시 서버를 두는 방법 중 하나이다.

요청을 받은 엡 서버는 캐시에 응답이 저장되어 있는지를 본다. 만일 저장되어 있다면 해당 데이터를 클라이언트에 반환한다. 없는 경우에는 데이터베이스 질의를 통해 데이터를 찾아 캐시에 저장한 뒤 클라이언트에 반환한다.

이러한 캐시 전략을 주도형 캐시 전략(read-through caching stratey)이라고 부른다. 이것 외에 다양한 캐시 전략이 있는데, 캐시할 데이터의 종류, 크기, 액세스 패턴에 맞는 캐시 전략을 선택하면 된다.

캐시 서버를 이용하는 방법은 간단한데 대부분의 캐시 서버들이 일반적으로 널리 쓰이는 프로그래밍 언어로 API를 제공하기 때문이다. 다음 코드는 mamcached API의 전형적 사용 예시이다.

SECONDS = 1

cache.set('myKey', 'hi there', 3600 * SECONDS)

cache.get('myKey')캐시 사용 시 유의할 점

캐시를 사용할 때는 아래 사항들을 고려해야 한다.

-

갱신은 자주 일어나지 않지만 참조는 빈번하게 일어난다면 고려해볼만 하다.

-

캐시는 데이터를 휘발성 메모리에 두므로, 영속적으로 보관할 데이터를 캐시에 두는 것은 바람직하지 않다. 예를 들어, 캐시 서버가 재시작되면 캐시 내의 모든 데이터는 사라진다. 중요 데이터는 여전히 지속적 저장소(persistent data store)에 두어야 한다.

-

캐시에 보관된 데이터는 어떻게 만료되는가? 만료된 데이터는 캐시에서 삭제되어야 한다. 만료 정책이 없으면 데이터는 캐시에 계속 남게 된다. 만료 기한은 너무 짧으면 데이터베이스를 너무 자주 읽게 될 것이고, 너무 길면 원본과 차이가 날 가능성이 높아진다.

-

일관성은 데이터 저장소의 원본과 캐시 내의 사본이 같은지 여부다. 저장소의 원본을 갱신하는 연산과 캐시를 갱신하는 연산이 단일 트랜잭션으로 처리되지 않는 경우 이 일관성은 깨질 수 있다. 여러 지역에 걸쳐 시스템을 확장해 나가는 경우 캐시와 저장소 사이의 일관성을 유지하는 것은 어려운 문제가 된다.

-

캐시 서버를 한 대만 두는 경우 해당 서버는 단일 장애 지점(SPOF, Single Point of Failure)이 될 가능성이 있다.

단일 장애 지점?

어떤 특정 지점에서의 장애가 전체 시스템의 동작을 중단시켜버릴 수 있는 지점을 단일 장애지점이라고 부른다.

결과적으로, SPOF를 피하려면 여러 지역에 걸쳐 캐시 서버를 분산시켜야 한다. -

캐시 메모리가 너무 작으면 액세스 패턴에 따라서는 데이터가 너무 자주 캐시에서 밀려나버려(eviction) 캐시의 성능이 떨어지게 된다. 이를 막을 한 가지 방법은 캐시 메모리를 과할당(overposition)하는 것이다. 이렇게 하면 캐시에 보관될 데이터가 갑자기 늘어났을 때 생길 문제도 방지할 수 있게 된다.

-

데이터 방출(eviction) 정책은 무엇인가? 캐시가 꽉 차버리면 추가로 캐시에 데이터를 넣어야 할 경우 기존 데이터를 내보내야 한다. 이것을 캐시 데이터 방출 정책이라 하는데, 그 가운데 가장 널리 쓰이는 것은 LRU(Least Recently Used - 마지막으로 사용된 시점이 가장 오래된 데이터를 내보내는 정책)이다. 다른 정책으로는 LFU(Least Frequently Used)나 FIFO(First in First Out) 등이 있다.

콘텐츠 전송 네트워크(CDN)

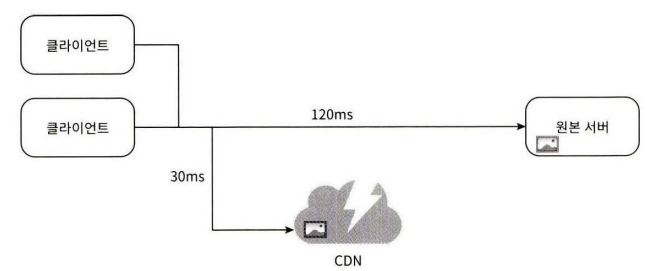

CDN(Content Delivery Network)은 정적 콘텐츠를 전송하는 데 쓰이는, 지리적으로 분산된 서버의 네트워크이다. 이미지, 비디오, CSS, JsvaScript 파일 등을 캐시할 수 있다.

그렇다면, 동적 컨텐츠 캐싱은 뭘까?

요청 경로(request path), 질의 문자열(query string), 쿠키, 요청 헤더 등의 정보에 기반하여 HTML 페이지를 캐시하는 것이다.

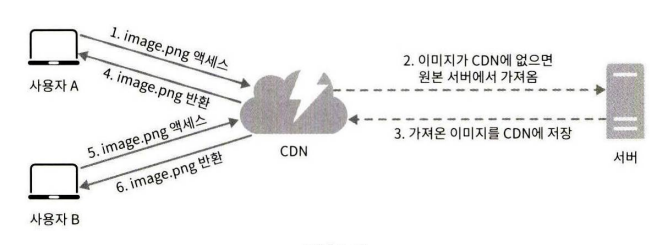

CDN이 어떻게 동작하는지를 개략적으로 살펴보면 다음과 같다.

어떤 사용자가 웹사이트를 방문하면, 그 사용자에게 가장 가까운 CDN 서버가 정적 콘텐츠를 전달하게 된다. 사용자가 CDN 서버로부터 멀면 멀수록 웹사이트는 천천히 로드될 것이다. 예를 들어 CDN 서버가 부산에 있다면 울산에 있는 사용자는 서울에 있는 사용자보다 빠른 웹 사이트를 보게 될 것이다. 다음 그림은 CDN이 사이트 로딩 시간을 어떻게 개선하는지를 보여분다.

다음 그림은 CDN의 동작 원리를 설명한다.

- 사용자 A가 이미지 URL을 이용해 image.png에 접근한다. URL의 도메인은 CDN 서비스 사업자가 제공한 것이다.

- CDN 서버의 캐시에 해당 이미지가 없는 경우, 서버는 원본 서버에 요청하여 파일을 가져온다.

- 원본 서버가 파일을 CDN 서버에 반환한다. 응답의 HTTP 헤더에는 해당 파일이 얼마나 오래 캐시될 수 있는지를 설명하는 TTL(Time-To-Live) 값이 들어 있다.

- CDN 서버는 파일을 캐시하고 사용자 A에게 반환한다. 이미지는 TTL에 명시된 시간이 끝날 때까지 캐시된다.

- 사용자 B가 같은 이미지에 대한 요청을 CDN 서버에 전송한다.

- 만료되지 않은 이미지에 대한 요청은 캐시를 통해 처리된다.

CDN 사용 시 고려해야 할 사항

- 비용

- CDN은 보통 제3 사업자에 의해 운영되며, CDN으로 들어가고 나가는 데이터 전송 양에 따라 요금을 내게 된다. 자주 사용되지 않는 콘텐츠를 캐싱하는 것은 이득이 크지 않으므로, CDN에서 빼는 것을 고려해야 한다.

- 적절한 만료 시한 설정

- 시의성이 중요한(time-sensitive) 콘텐츠의 경우 만료 시점을 잘 정해야 한다. 너무 길지도 않고 짧지도 않아야 하는데, 너무 길면 콘텐츠의 신선도가 떨어질 것이고, 너무 짧으면 원본 서버에 빈번히 접속하게된다.

- CDN 장애에 대한 대처 방안

- CDN 자체가 죽었을 경우 웹사이트/애플리케이션이 어떻게 동작해야 하는지 고려해야 한다. 가령 일시적으로 CDN이 응답하지 않을 경우, 해당 문제를 감지하여 원본 서버로부터 직접 콘텐츠를 가져오도록 클라이언트를 구성하는 것이 필요할 수도 있다.

- 콘텐츠 무효화(invalication)

- 아직 만료되지 않은 콘텐츠라 하더라도 아래 방법 가운데 하나를 쓰면 CDN에서 제거할 수 있다.

1. CDN 서비스 사업자가 제공하는 API를 이용하여 콘텐츠 무효화

2. 콘텐츠의 다른 버전을 서비스하도록 오브젝트 버저닝(object versioning) 이용. 콘텐츠의 새로운 버전을 저장하기 위해 URL 마지막에 버전 번호를 인자로 주면 된다. 예를 들어,image.png?v=2와 같다.

- 아직 만료되지 않은 콘텐츠라 하더라도 아래 방법 가운데 하나를 쓰면 CDN에서 제거할 수 있다.

위 그림을 이전 그림과 비교하자면, 정적 콘텐츠(JS, CSS, 이미지 등)는 더 이상 웹 서버를 통해 서비스하지 않으며, CDN을 통해 제공하여 더 나은 성능을 보장하며, 캐시가 데이터베이스 부하를 줄여준다.

무상태(stateless) 웹 계층

이제 웹 계층을 수평적으로 확장하는 방법을 고민해 볼 차례이다. 이를 위해서는 상태 정보(사용자 세션 데이터와 같은)를 웹 계층에서 제거해야 한다. 바람직한 전략은 상태 정보를 관계형 데이터베이스나 NoSQL같은 저속성 저장소에 보관하고, 필요할 때 가져오도록 하는 것이다. 이렇게 구성된 웹 계층을 무상태 웹 계층이라 부른다.

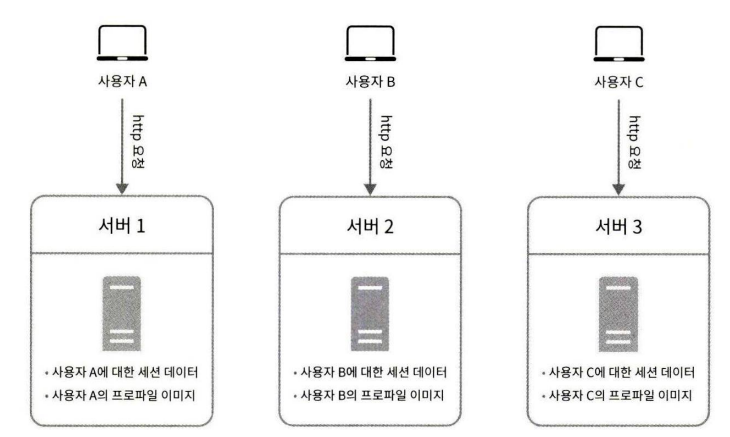

상태 정보 의존적인 아키텍쳐

상태 정보를 보관하는 서버와 그렇지 않은 서버 사이에는 몇 가지 중요한 차이가 있다.

상태 정보를 보관하는 서버는 클라이언트 정보, 즉 상태를 유지하여 요청들 사이에 공유되도록 한다. 무상태 서버에는 이런 장치가 없다.

상태 정보 의존적인 아키텍쳐는 다음과 같다.

사용자 A의 세션 정보나 Profile 이미지 같은 상태 정보는 서버 1에 저장된다. 사용자 A를 인증하기 위해 HTTP 요청은 반드시 서버 1로 전송되어야 한다. 요청이 서버 2로 전송되면 서버 2에는 사용자 A에 대한 데이터가 없기에 인증을 실패한다. 마찬가지로 사용자 B는 서버 2에게 사용자 C는 서버 3에게 요청되어야 하며, 문제는 같은 클라이언트로부터의 요청은 항상 같은 서버로 전송되어야 한다는 것이다.

대부분의 로드밸런서가 이를 지원하기 위해 고정 세션이라는 기능을 제공하고 있지만, 이는 로드밸런서에 부담을 주며 로드밸런서 뒷단에 서버를 추가하거나 제거하기도 까다로워지고 서버 간 장애를 처리하기도 복잡해진다.

무상태 아키텍쳐

무상태 아키텍쳐의 구조로서, 사용자로부터의 HTTP 요청은 어떤 웹 서버로도 전달될 수 있다. 웹 서버는 상태 정보가 필요한 경우 공유 저장소로부터 데이터를 가져온다. 따라서 상태 정보는 웹 서버로부터 물리적으로 분리되어 있다.

이런 구조는 단순하고, 안정적이며, 규모 확장이 쉽다.

공유 저장소는 관계형 데이터베이스일 수도 있고, Memcached/Redis 같은 캐시 시스템일 수도 있으며, NoSQL일 수도 있다.

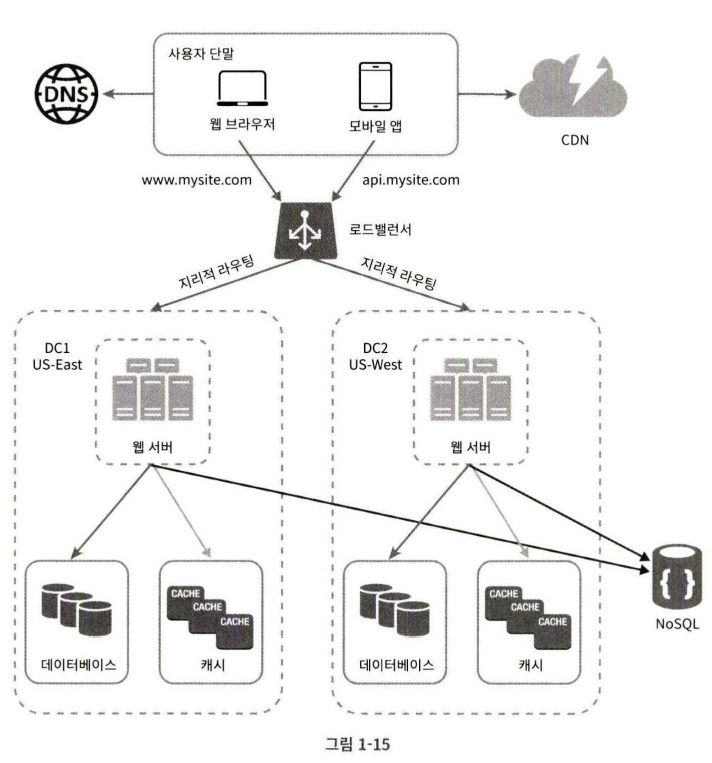

데이터 센터

웹사이트가 매우 빨리 성장하여 전 세계 사용자의 이목을 받는 시점이 왔다고 생각해보자. 가용성을 높이고 전 세계 어디서도 쾌적하게 사용할 수 있도록 하기 위해서는 여러 데이터 센터를 지원하는 것이 필수다.

위 그림은 두 개의 데이터 센터를 이용하는 사례이다.

장애가 없는 상황에서 사용자는 가장 가까운 데이터 센터로 안내되는데, 통상 이 절차를 지리적 라우팅(geoDNS-routing 또는 geo-routing)이라고 부른다. 지리적 라우팅에서의 geoDNS는 사용자의 위치에 따라 도메인 이름을 어떤 IP 주소로 변환할지 결정할 수 있도록 해 주는 DNS 서비스이다. 이 예제의 경우, 그 결과로 x% 사용자는 US-East 센터로, (100-x)%의 사용자는 US-West 센터로 안내된다.

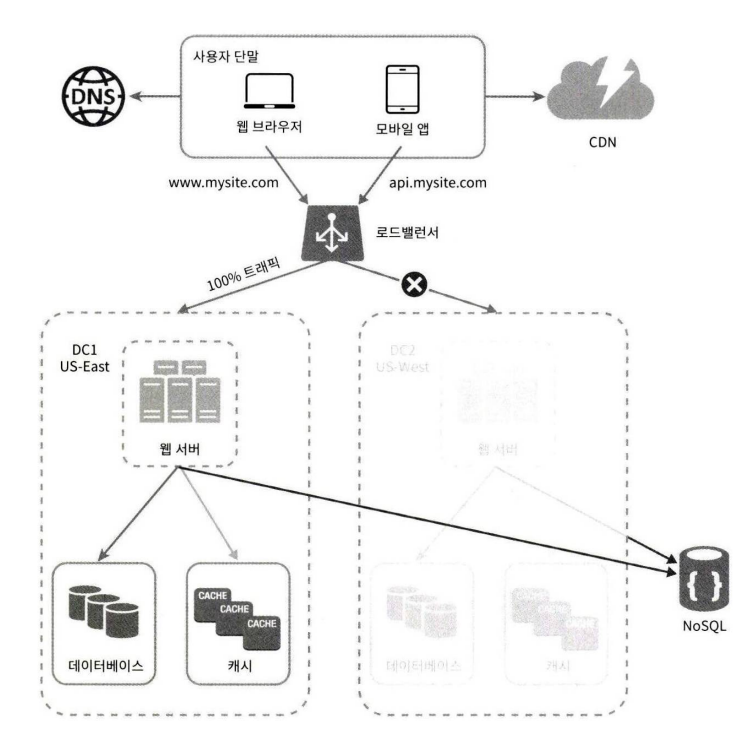

이들 데이터 센터 중 하나에 심각한 장애가 발생하면 모든 트래픽은 아래 그림처럼, 장애가 없는 데이터 센터로 전송된다.

이 사례와 같은 다중 데이터센터 아키텍처를 만들려면 몇 가지 기술적 난제를 해결해야 한다.

- 트래픽 우회

- 올바른 데이터 센터로 트래픽을 보내는 효과적인 방법을 찾아야 한다. GeoDNS는 사용자에게서 가장 가까운 데이터센터로 트래픽을 보낼 수 있도록 해 준다.

- 데이터 동기화(synchronization)

- 데이터 센터마다 별도의 데이터베이스를 사용하고 있는 상황이라면, 장애가 자동으로 복구되어(failover) 트래픽이 다른 데이터베이스로 우회된다 해도, 해당 데이터센터에는 찾는 데이터가 없을 수 있다.

이런 상황을 막는 보편적 전략은 데이터를 여러 데이터센터에 걸쳐 다중화하는 것이다.

- 데이터 센터마다 별도의 데이터베이스를 사용하고 있는 상황이라면, 장애가 자동으로 복구되어(failover) 트래픽이 다른 데이터베이스로 우회된다 해도, 해당 데이터센터에는 찾는 데이터가 없을 수 있다.

- 테스트와 배포

- 여러 데이터 센터를 사용하도록 시스템이 구성된 상황이라면 웹 사이트 또는 애플리케이션을 여러 위치에서 테스트해보는 것이 중요하다.

한편, 자동화된 배포 도구는 모든 데이터 센터에 동일한 서비스가 설치되도록 하는 데 중요한 역할을 한다.

- 여러 데이터 센터를 사용하도록 시스템이 구성된 상황이라면 웹 사이트 또는 애플리케이션을 여러 위치에서 테스트해보는 것이 중요하다.

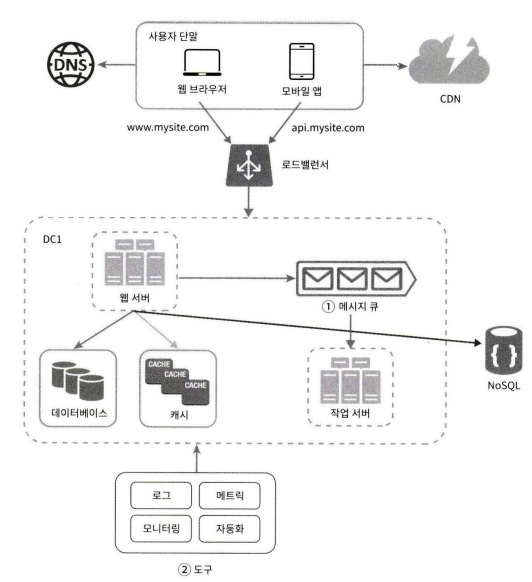

시스템을 더 큰 규무로 확장하기 위해서는 시스템의 컴포넌트를 분리하여, 각기 독립적으로 확장될 수 있도록 하여야 한다. 메시지 큐(Message Queue)는 많은 실제 분산 시스템이 이 문제를 풀기 위해 채용하고 있는 핵심전 적략 가운데 하나이다.

메시지 큐

메시지 큐는 메시지의 무손실(durability : 메시지 큐에 일단 보관된 메시지는 소비자가 꺼낼 때까지 안전히 보관된다는 특성)을 보장하는, 비동기 통신(asynchronous communication)을 지원하는 컴포넌트이다. 메시지의 버퍼 역할을 하며, 비동기적으로 전송한다.

메시지 큐의 기본 아키텍처는 간단하다. 생산자 또는 발행자(producer/publisher)라고 불리는 입력 서비스가 메시지를 만들어 메시지 큐에 발행(publish)한다. 큐에는 보통 소비자 혹은 구독자(consumer/subscriber)라 불리는 서비스 혹은 서버가 연결되어 있는데, 메시지를 받아 그에 맞는 동작을 수행하는 역할을 한다.

메시지 큐를 이용하면 서비스 또는 서버 간 결합이 느슨해져서, 규모 확장성이 보장되어야 하는 안정적 어플리케이션을 구성하기 좋다. 생산자는 소비자 프로세스가 다운되어 있어도 메시지를 발행할 수 있고, 소비자는 생산자 서비스가 가용 상태가 아니더라도 메시지를 수신할 수 있다.

이미지의 Cropping, Sharpening, Blurring 등을 지원하는 사진 보정 애플리케이션을 만든다고 가정해보자

이러한 보정은 시간이 오래 걸리는 프로세스이므로 비동기적으로 처리하면 편하다.

- 웹 서버는 사진 보정 작업(job)을 메시지 큐에 넣는다.

- 사진 보정 작업 프로세스들은 이 작업을 메시지 큐에서 꺼내어 비동기적으로 완료한다.

이렇게 하면 생산자와 소비자 서비스의 규모는 각기 독립적으로 확장될 수 있다. 큐의 크기가 커지면 더 많은 작업 프로세스를 추가해야 처리 시간을 줄일 수 있다. 하지만 큐가 거의 항상 비어 있는 상태라면, 작업 프로세스의 수는 줄일 수 있을 것이다.

로그, 메트릭 그리고 자동화

몇 개 서버에서 실행되는 소규모 웹 사이트를 만들 때는 로그나 메트릭, 자동화 같은 것은 하면 좋지만 꼭 할 필요는 없었다. 하지만, 웹 사이트와 함께 사업 규모가 커진다면 이러한 도구에 필수적으로 투자해야 한다.

-

로그 : 에러 로그를 모니터링하는 것은 중요하다. 시스템의 오류와 문제들을 보다 쉽게 찾아낼 수 있도록 하기 때문이다. 에러 로그는 서버 단위로 모니터링 할 수도 있지만, 로그를 단일 서비스로 모아주는 도구를 활용하면 더 편리하게 검색하고 조회할 수 있다.

-

메트릭 : 메트릭을 잘 수집하면 사업 현황에 관한 유용한 정보를 얻을 수도 있고, 시스템의 현재 상태를 손쉽게 파악할 수도 있다. 메트릭 가운데 특히 유용한 것을 몇 가지 살펴보면 다음과 같다.

- 호스트 단위 메트릭: CPU, 메모리, 디스크 I/O에 관한 메트릭이 여기에 해당한다.

- 종합(aggregated) 메트릭: 데이터베이스 계층의 성능, 캐시 계층의 성능 같은 것이 여기 해당한다.

- 핵심 비즈니스 메트릭: 일별 능동 사용자(daily active user), 수익(revenue), 재방문(retention) 같은 것이 여기 해당한다. -

자동화: 시스템이 크고 복잡해지면 생산성을 높이기 위해 자동화 도구를 활용해야 한다. 가령 지속적 통합(continuous integration, CI)을 도와주는 도구를 활용하면 개발자가 만드는 코드가 어떤 검증 절차를 자동으로 거치도록 할 수 있어서 문제를 쉽게 감지할 수 있다. 이 외에도 빌드, 테스트, 배포 등의 절차를 자동화할 수 있어서 개발 생산성을 크게 향상시킬 수 있다.

메시지 큐, 로그, 메트릭, 자동화 등을 반영하여 수정한 설계안

이러한 도구들과 메시지 큐를 적용하여 수정한 설계이다. 특징으로는 다음과 같다.

- 메시지 큐는 각 컴포넌트가 보다 느슨히 결합(loosely coupled)될 수 있도록 하고, 결함에 대한 내성을 높인다.

- 로그, 모니터링, 메트릭, 자동화 등을 지원하기 위한 장치를 추가하였다.

데이터베이스의 규모 확장

저장할 데이터가 많아지면 데이터베이스에 대한 부하도 증가한다. 그때가 오면 데이터베이스를 증설할 방법을 찾아야 한다.

데이터베이스의 규모를 확장하는 데는 두 가지 접근법이 있다. 하나는 수직적 규모 확장법이고 다른 하나는 수평적 규모 확장법이다.

수직적 확장

스케일 업이라고도 부르는 수직적 규모 확장법은 기존 서버에 더 많은, 또는 고성능의 자원(CPU, RAM, 디스크 등)을 증설하는 방법(ex. AWS Relational Database Service)이다. 고성능 데이터베이스 서버는 많은 양의 데이터를 보관하고 처리할 수 있다. 예를 들어 stackoverflow.com는 2013년 한 해 동안 방문한 천만 명의 사용자 전부를 단 한 대의 마스터 데이터 베이스로 처리하였다. 하지만 이러한 수직적 확장법에는 다음과 같은 심각한 약점이 있다.

- 데이터베이스 서버 하드웨어에는 한계가 있으므로 CPU, RAM 등을 무한 증설할 수는 없다. 사용자가 계속 늘어나면 한 대 서버로는 결국 감당하기 어렵게 될 것이다.

- SPOF(Single Point of Failure)로 인한 위험성이 크다.

- 고성능 서버로 갈수록 비용이 많이 든다.

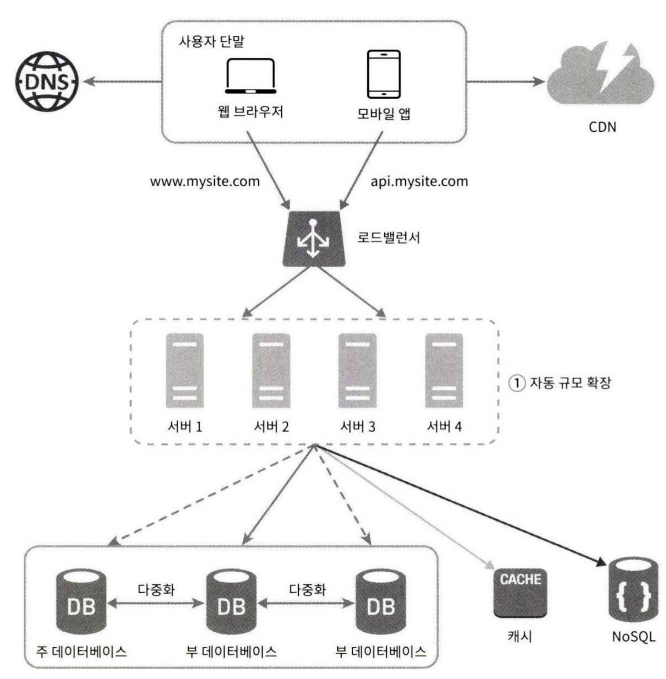

수평적 확장

데이터베이스의 수평적 확장은 샤딩(sharding)이라고도 부르는데, 더 많은 서버를 추가함으로써 성능을 향상시킬 수 있도록 한다.

샤딩은 대규모 데이터베이스를 샤드(shard)라고 부르는 작은 단위로 분할하는 기술을 일컫는다. 모든 샤드는 같은 스키마를 쓰지만 샤드에 보관되는 데이터 사이에는 중복이 없다.

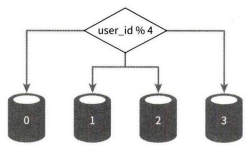

다음은 샤드로 분할된 데이터베이스의 예시다. 사용자 데이터를 어느 샤드에 넣을지는 사용자 ID에 따라 정한다. 이 사례에서는 user_id % 4를 해시 함수로 사용하여 데이터가 보관되는 샤드를 정한다. 결과가 0이면 반드시 0번 샤드에, 1이면 1번 샤드에 보관하는 방식이다.

위 그림은 각 샤드 노드에 사용자 데이터가 어떻게 보관되는지를 보여준다.

샤딩 전략

샤딩 전략을 구현할 때 고려해야 할 가장 중요한 것은 샤딩 키(sharding key)를 어떻게 정하는가에 있다. 샤딩 키는 파티션 키(partition key)라고도 부르는데, 데이터가 어떻게 분산될지 정하는 하나 이상의 칼럼으로 구성된다. 바로 위의 그림에서 샤딩 키는 user_id이다. 샤딩 키를 통해 올바른 데이터베이스에 질의를 보내어 데이터조회나 변경을 처리하므로 효율을 높일 수 있다. 샤딩 키를 정할 때는 데이터를 고르게 분할 할 수 있도록 하는 게 가장 중요하다.

샤딩은 데이터베이스 규모 확장을 실현하는 훌륭한 기술이지만 완벽하진 않다. 샤딩을 도입하면 시스템이 복잡해지고 풀어야 할 다음과 같은 새로운 문제도 생긴다.

데이터의 재 샤딩(resharding)

resharding은 다음과 같은 경우에 필요하다.

- 데이터가 너무 많아져서 하나의 샤드로는 더 이상 감당하기 어려울 때

- 샤드 간 데이터 분포가 균등하지 못하여 특정 샤드에 할당된 공간 소모가 다르샤드에 비해 빨리 진행될 때

샤드 소진(shard exhaustion)이라고도 부르는 이런 현상이 발생하면 샤드 키를 계산하는 함수를 변경하고 데이터를 재배치하여야 한다.

안정 해시 기법을 활용하면 이 문제를 해결할 수 있다.

유명인사 문제 (celebrity)

핫스팟 키(hotspot key)라고도 부르는데, 특정 샤드에 질의가 집중되어 서버에 과부하가 걸리는 문제이다. 가령 아이유, BTS와 같은 유명인사가 전부 같은 샤드에 저장되는 데이터베이스가 있다고 가정 해 보자. 이 데이터로 사회 관계망 애플리케이션을 구축하게 되면 결국 해당 샤드에는 read 연산 때문에 과부하가 걸리게 될 것이다. 이 문제를 풀려면 위에 나열한 유명인사 각각에 샤드 하나씩을 할당해야 할 수도 있고, 심지어는 더 잘게 쪼개야 할 수도 있다.

조인과 비정규화(join and de-normalization)

일단 하나의 데이터베이스를 여러 샤드 서버로 쪼개고 나면, 여러 샤드에 걸친 데이터를 조인하기가 힘들어진다. 이를 해결하는 한 가지 방법은 데이터베이스를 비정규화하여 하나의 테이블에서 질의가 수행될 수 있도록 하는 것이다.

다음 그림은 데이터베이스 샤딩을 적용하고, 데이터베이스에 대한 부하를 줄이기 위해 굳이 관계형 데이터베이스가 요구되지 않는 기능들은 NoSQL로 이전하였다.

백만 사용자, 그리고 그 이상

시스템의 규모를 확장하는 것은 지속적이고 반복적(iterative)인 과정이다. 시스템 규모 확장을 위해 살펴본 기법들을 정리해보면 다음과 같다.

- 웹 계층은 무상태 계층으로

- 모든 계층에 다중화 도입

- 가능한 한 많은 데이터를 캐시할 것

- 여러 데이터 센터를 지원할 것

- 정적 컨텐츠는 CDN을 통해 서비스할 것

- 데이터 계층은 샤딩을 통해 그 규모를 확장할 것

- 각 계층은 독립적으로 서비스로 분할할 것

- 시스템을 지속적으로 모니터링하고, 자동화 도구들을 활용할 것