beeline 접속시

기본 명령어

$ beeline

beeline> !connect jdbc:hive2://localhost:10000

0: jdbc:hive2://localhost:10000>이다.

내가 접속할 cwhdp01의 주소는 cwhdp01.co.kr이므로

localhost -> cwhdp01.co.kr로 변경.

또한 port 번호는 내 로컬 환경으로 띄운다면 10000으로 띄우는데,

cwhdp01 의 ip주소를 vi /etc/hosts를 이용하여 hosts에 등록해주어야 한다.

그래야 내 로컬 환경에서 접속할수 있다.

DB생성, 접근, table 생성 시에 권한

ranger 에서 권한을 설정 해줘야한다.

권한은 hive 뿐만 아니라 hdfs 도 같이 부여

hive - 내가 사용할 db에 권한 부여

hdfs - 내가 사용할 db의 external directory, hive metastore directory 두가지에 부여

hdfs dfs -ls /user 를 확인하면 /user에 내 아이디 생성 그리고 권한 주기

기본적으로 warehouse의 권한은 hive가 가지고있다. 따라서 유저는 접근할 수 없기 때문에 권한을 꼭 줘야함 write 권한 xxx

cwdev01에 구성된 repolist

#yum repolist

현재 활성화된 Yum Repository 목록을 확인합니다.

yum repository rpm 설치와 yum 설치

yum 패키지 찾기 - yum search

#yum search hadoop

hadoop과 관련된 것들을 다 검색해서 보여준다.

hdfs /user 파일

hdfs /user 파일에 사용할 id폴더 만들어주기

sudo -u hdfs hdfs dfs -mkdir /user/id

디렉토리 권한 바꾸기

sudo -u hdfs hdfs dfs - chown id:hdfs /user/modsiw

hiveserver2 log 확인

그리고 hive 실행하다가 error가 난다면, hiveserver2 의 log를 확인한다

hive tail -f hiveserver2.log

vi hiveserver2.log

log가 있는곳cd /var/log

scp를 이용해 로컬과 원격에 파일 전송

scp 목적파일명(경로) 유저명@IP주소:목적디렉토리

scp -r cwadmin@cwhdp01:/etc/hive/conf/* .

옵션 -r : 재귀적으로 모든 폴더들을 복사합니다.

폴더를 복사할때 사용하는 옵션으로 이때 전송하고자 하는 대상은 폴더로 지정하면 됩니다.

ssh 명령어

publickey 생성 -> generation 내 로컬에 인증키 박기

ssh-keygen -t rsa -P '' -f ~/.ssh/id_rsa

cat ~/.ssh/id_rsa.pub>> ~/.ssh/authorized_keys

chmod 0600 ~/.ssh/authorized_keys

vim을 실행하다가 강제 종료했을 시, 생성된 파일은 삭제

숨김 파일까지 같이 보기 ls -a

cwhdp01의 환경과 같게 만들기.

beeline과 hadoop을 가져오기.

PATH 설정은 xx 참고로 pass설정은 vi .bash_profile

ssh 명령어로 접속하기

cwhdp01 -> cwhdp03

ssh cwhdp03 port번호는 2181 => ambari에서 포트번호 확인 가능

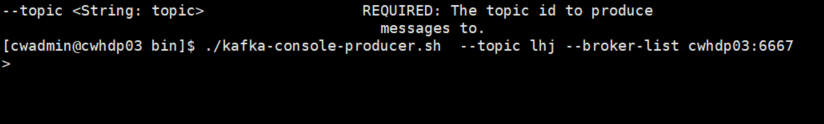

Kafka 설정하기

내가 실습할 환경은 kafka가 Datanode인 cwhdp01 ,cwhdp02, cwhdp03 이렇게 세대에 kafka가 설치가 되어있다.

kafka broker는 hdp03,04,05 번에 있음. 03,04,05번의 port번호를 몰라도 kafka-broker port를 알면 된다

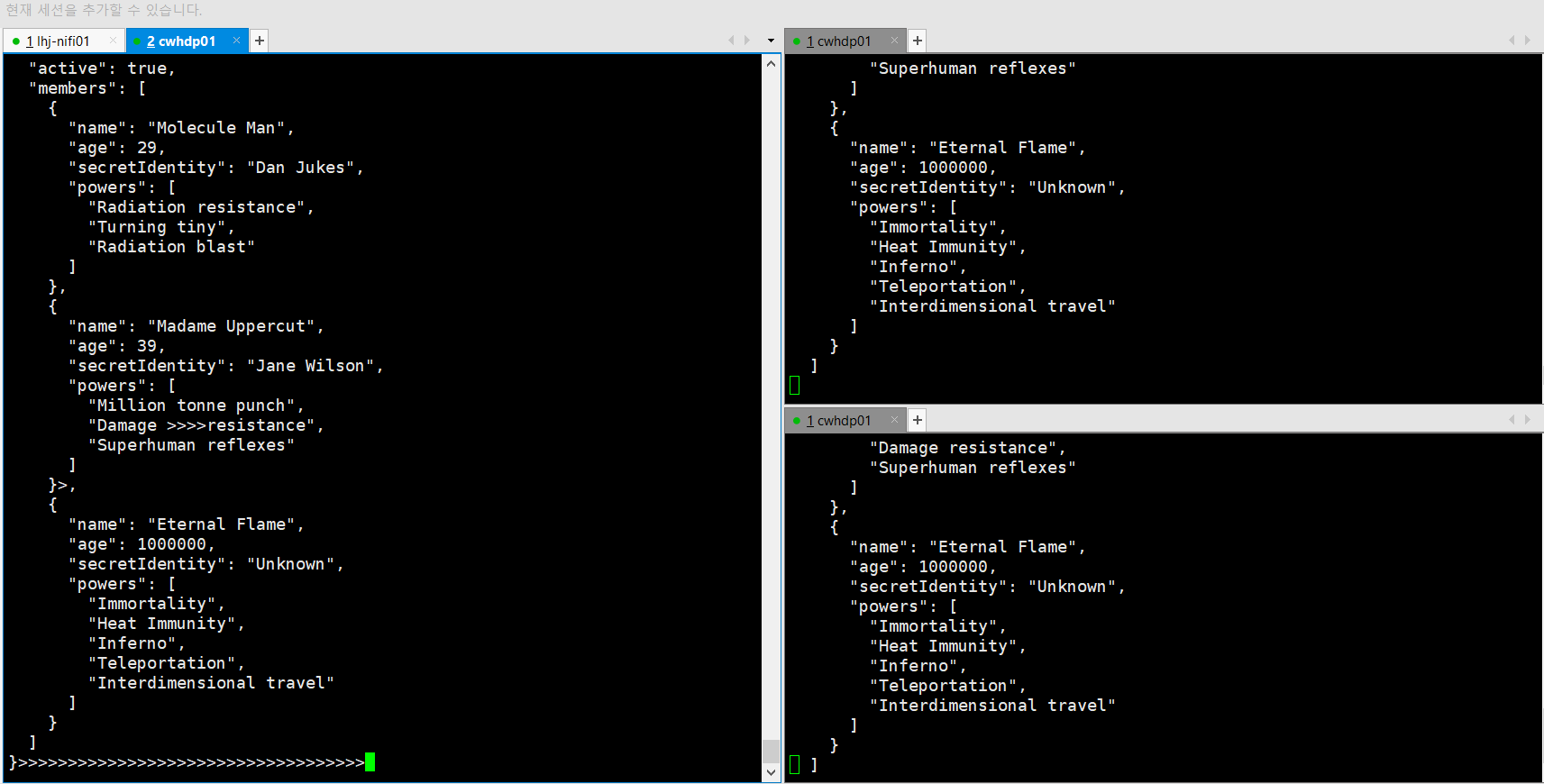

option들을 붙여서 실행한 producer와 consumer

json 형태로 producer와 consumer 를 켯을때

추후 더 아는게 있다면 추가할 예정