book title : 딥러닝을 위한 수학

pages : 146 ~ 148

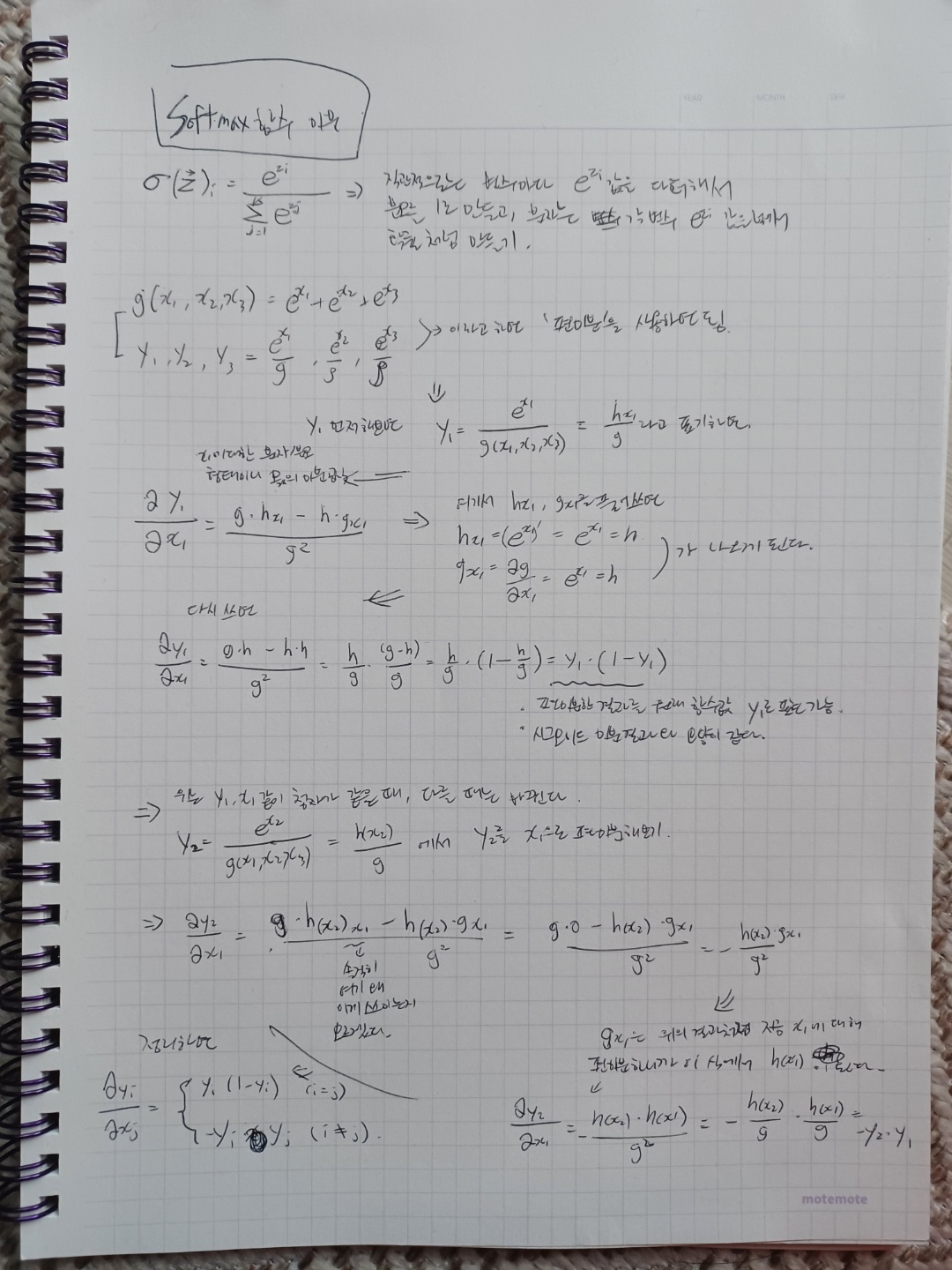

key concepts :

- 소프트맥스(softmax) 함수

- 시그모이드는 비슷하게 엮이는 게 있는데 시그모이드는 아래와 같다.

- 사실 두 함수의 관계는 이렇게 볼 수 있다.

- n=2일 때 소프트맥스 함수는 시그모이드 함수가 되고,

- 시그모이드를 n=3 이상으로 확장한 게 소프트맥스라고 보면 된다.

- 소프트맥스 미분에 관련해서는 이 책이 그리 친절하게 설명하고 있지 않아서 다른 자료를 참고해서 이해해보려 했다.

- 결과적으로, 아니면 일 때의 미분 값이 달라지고, 이것들이 벡터 함수로서 한 벡터 내에 포진하게 되는 것