BeautifulSoup 이란?

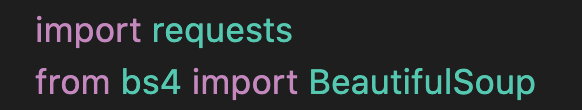

강의를 듣다가 크롤링을 할때 beautifulSoup 이란 라이브러리를 사용하는데

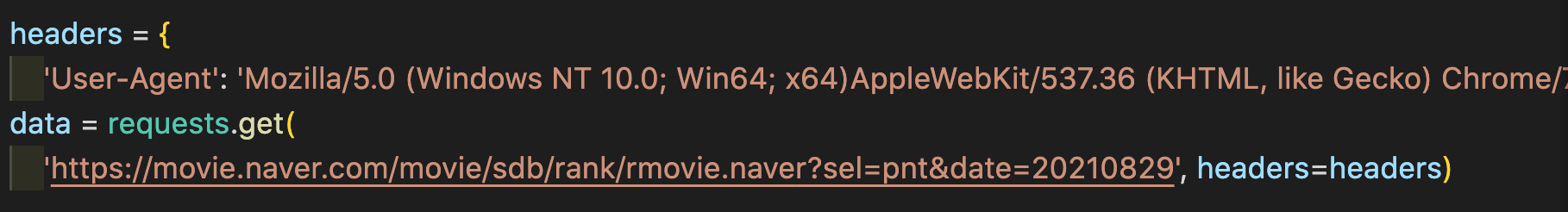

requests로 어차피 받아올 수 있는데 왜 사용할까 하는 의문이 들었다.

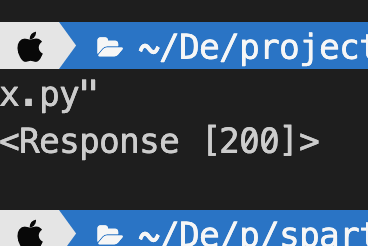

data를 print 로 찍어보니 200 성공코드가 나왔고 data.text를 찍어보니 html 파싱 정보가 나왔다.

이전에 api를 requests 로 요청해서 받아왔던 경험이 있어서 데이터를 requests 로 충분히 받아와 가공할 수 있다고 생각되었는데 애초에 이전에 requests 요청을 보낸 url이 이쁘게 json 형식으로 서버에서 뿌려준 정보여서 바로 사용할 수 있었던 것이었고,

이번에 사용한 url은 html 자체이기 때문에 좀더 가공이 필요한 부분이었다.

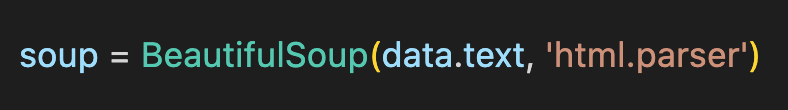

이 가공을 편하게 할수 있게 해주는 것이 beautifulsoup 이다.

requests 로 파싱한 쌩 html 정보를 beautifulsoup 객체한테 이걸 html로 분석해 라고 명령한 것이고 이를 통해 편리하게 가공할수 있는 형태로 변하게 된다.

결론

크롤링을 할때 requests와 beautifulsoup 을 세트로 생각하면 될것 같다.