PyTorch

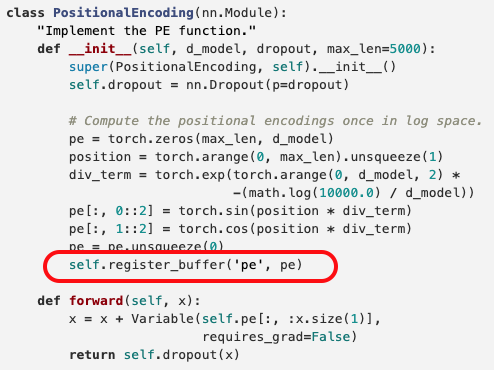

1.pytorch | 모델의 파라미터로 등록하지 않기 위한 register_buffer

pytorch transformer 구현 중 Positinal Encoding 부분에서 self.register_buffer('pe', pe) 와 같이 사용하는 부분이 있어서 검색일반적으로 모델 매개 변수로 간주되지 않는 버퍼를 등록하는 데 사용됩니다. 예를 들어, B

2021년 1월 3일

2.PyTorch Lightning DeepSpeed

PyTorch Lightning DeepSpeed 토치 라이트닝에서 딥스피드를 사용하기 위한 방법 학습 및 정리. DeepSpeed 딥스피드는 딥러닝 학습 optimization 라이브러리이다. 딥스피드를 통해 트랜스포머 모델의 메모리 를 효율적으로 학습할 수 있게

2021년 10월 17일