맥북프로 m4 pro 모델을 구입했으니

팬소리를 한번 내 봐야겠죠? LLM 을 로컬로 돌려보겠습니다.

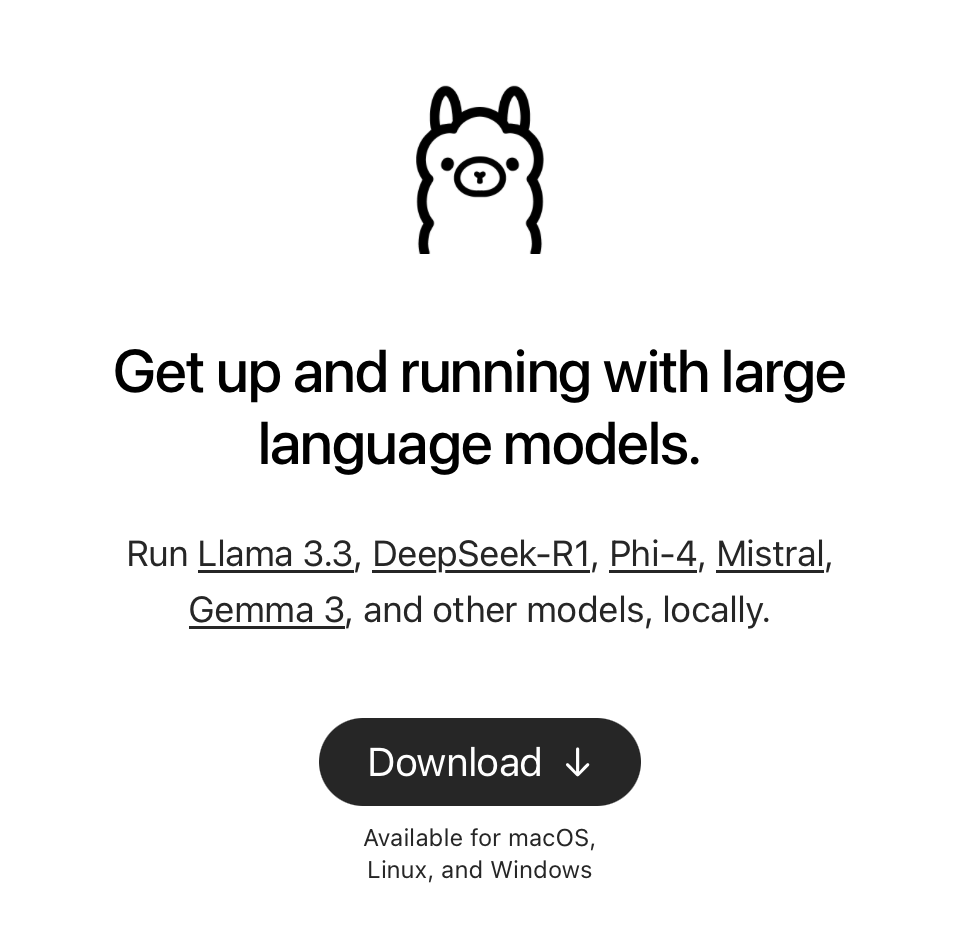

Ollama

Ollama는 로컬 환경에서 실행할 수 있는 대형 언어 모델(LLM) 관리 및 실행 플랫폼입니다. 쉽게 말해, 인터넷 연결 없이도 ChatGPT 같은 AI 모델을 실행할 수 있도록 해주는 툴입니다.

설치

사이트에서 다운로드 후 응용 프로그램으로 이동시켜 주는 것으로 설치 끝

모델 다운로드 및 실행

원하는 모델을 검색 후 터미널에서 ollama run 모델명 을 실행합니다.

% ollama run gemma3:12b

pulling manifest

pulling adca500fad9b... 100% ▕██████████████████████████████████████████▏ 8.1 GB

pulling e0a42594d802... 100% ▕██████████████████████████████████████████▏ 358 B

pulling dd084c7d92a3... 100% ▕██████████████████████████████████████████▏ 8.4 KB

pulling 0a74a8735bf3... 100% ▕██████████████████████████████████████████▏ 55 B

pulling 9031f81160b9... 100% ▕██████████████████████████████████████████▏ 490 B

verifying sha256 digest

writing manifest

success

>>> 안녕

안녕하세요! 무엇을 도와드릴까요? 😊

>>> 너 대화가 되는구나

네, 맞아요! 저는 텍스트 기반으로 대화할 수 있는 인공지능 모델입니다. 궁금한 점이 있거나, 이야기하고 싶

으신 내용이 있다면 언제든지 말씀해주세요. 챗봇이라고 생각하시면 편하실 것 같아요. 😉

>>> 너 언제까지 정보를 알고있어?

저는 2023년 4월까지의 정보를 가지고 있습니다. 그 이후의 새로운 정보나 사건에 대해서는 알지 못할 수 있

어요.

쉽게 말해, 2023년 4월까지의 뉴스, 지식, 데이터 등을 학습했기 때문에 그 시점까지의 정보는 답변할 수 있

지만, 그 이후의 변화는 반영되지 않았다는 뜻입니다.

혹시 특정 시점 이후의 정보가 필요하시면, 검색 엔진을 이용해 찾아보시는 것을 추천드립니다.

>>> Send a message (/? for help)ollama --help 명령을 통해 기능을 확인할 수 있습니다.

% ollama --help

Large language model runner

Usage:

ollama [flags]

ollama [command]

Available Commands:

serve Start ollama

create Create a model from a Modelfile

show Show information for a model

run Run a model

stop Stop a running model

pull Pull a model from a registry

push Push a model to a registry

list List models

ps List running models

cp Copy a model

rm Remove a model

help Help about any command

Flags:

-h, --help help for ollama

-v, --version Show version information

Use "ollama [command] --help" for more information about a command.Docker

Open WebUI 를 구동하기 위해 Docker 를 설치합니다.

brew install --cask dockerHomebrew는 패키지를 두 종류로 나눕니다: Formula(소스코드 빌드)와 Cask(미리 빌드된 앱 설치).

--cask옵션은 Homebrew에게 "이 패키지는 Cask 방식으로 설치해줘"라고 지시합니다.

Docker Desktop처럼 이미 빌드된 앱은--cask를 붙여 설치하는 것이 더 간단합니다.

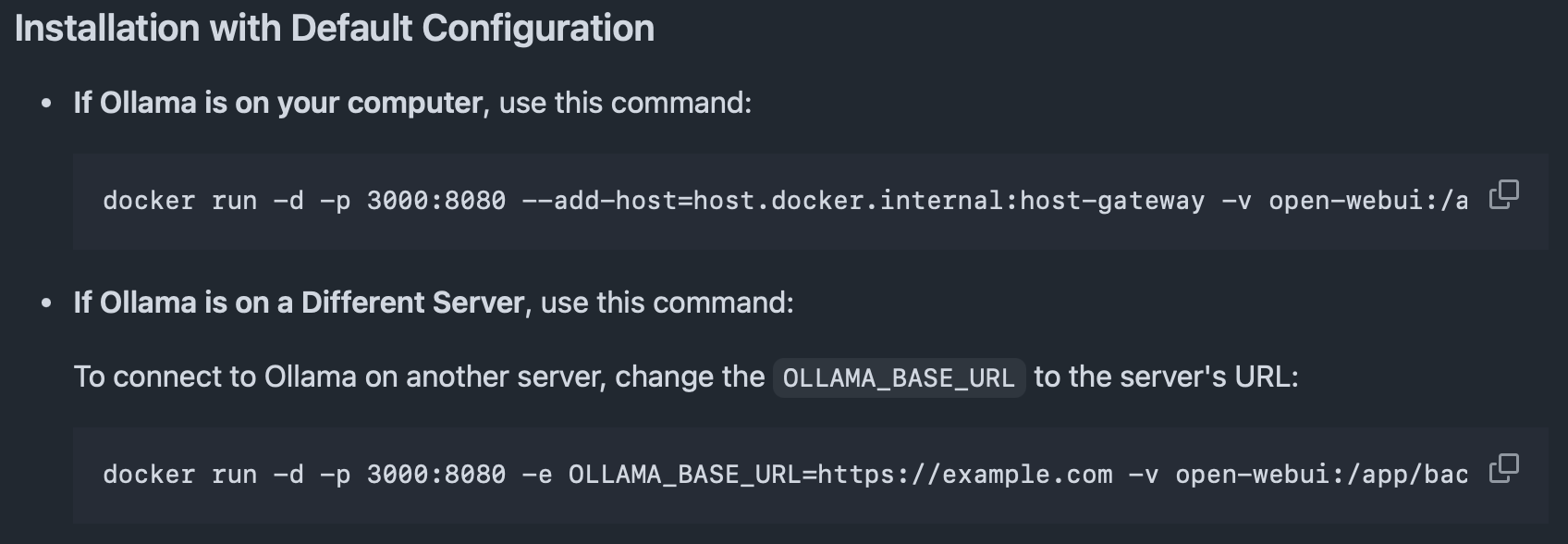

Open WebUI

https://openwebui.com

https://github.com/open-webui/open-webui

설치방법은 Python pip, Docker 를 안내하고 있습니다.

저는 Ollama 를 설치해뒀으니 아래 명령을 사용하겠습니다.

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main컨테이너가 실행되면 http://localhost:3000 에 접속할 수 있습니다.

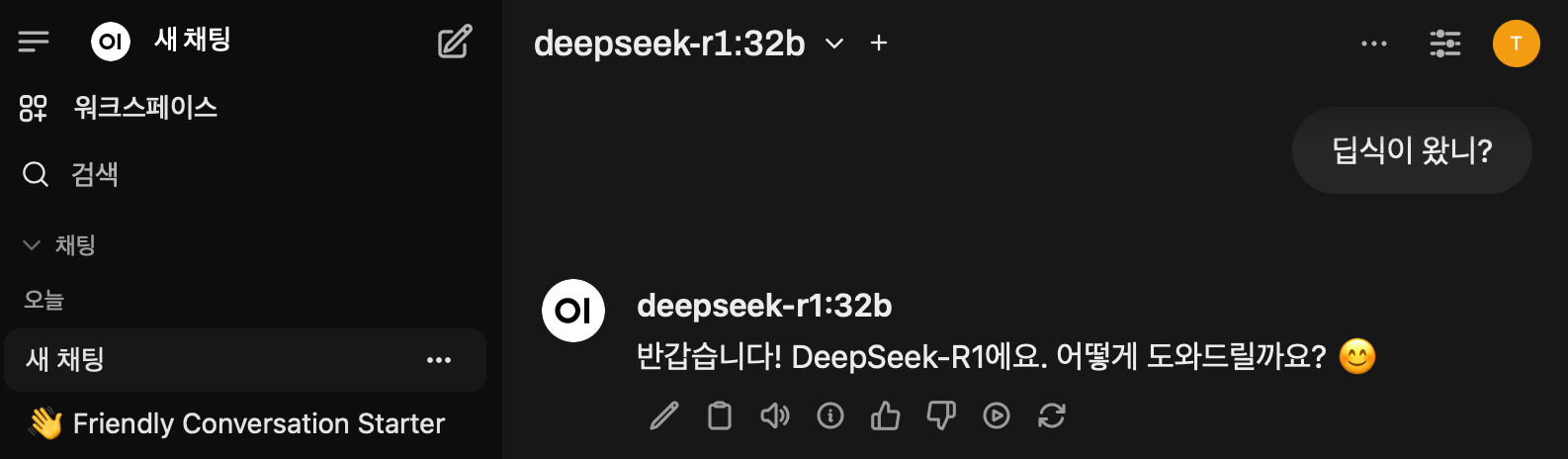

이미 다운로드 된 Ollama 의 모델을 특별한 설정 없이 선택할 수 있네요.

gemma3 12b, deepseek-r1 14b 정도는 쓸만하다고 생각이 드는데 더 넘어가면 팬소리와 함께 오래 기다려야 했습니다.

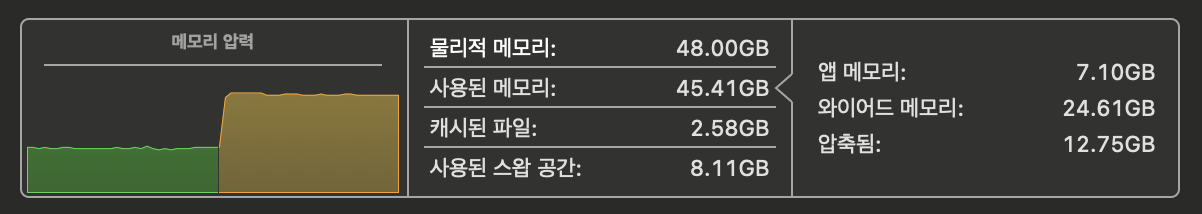

deepseek-r1 32b 와 함께 열일중인 램의 모습 (압력 약 80%)