paper

1.[논문리뷰] Attention Is All You Need

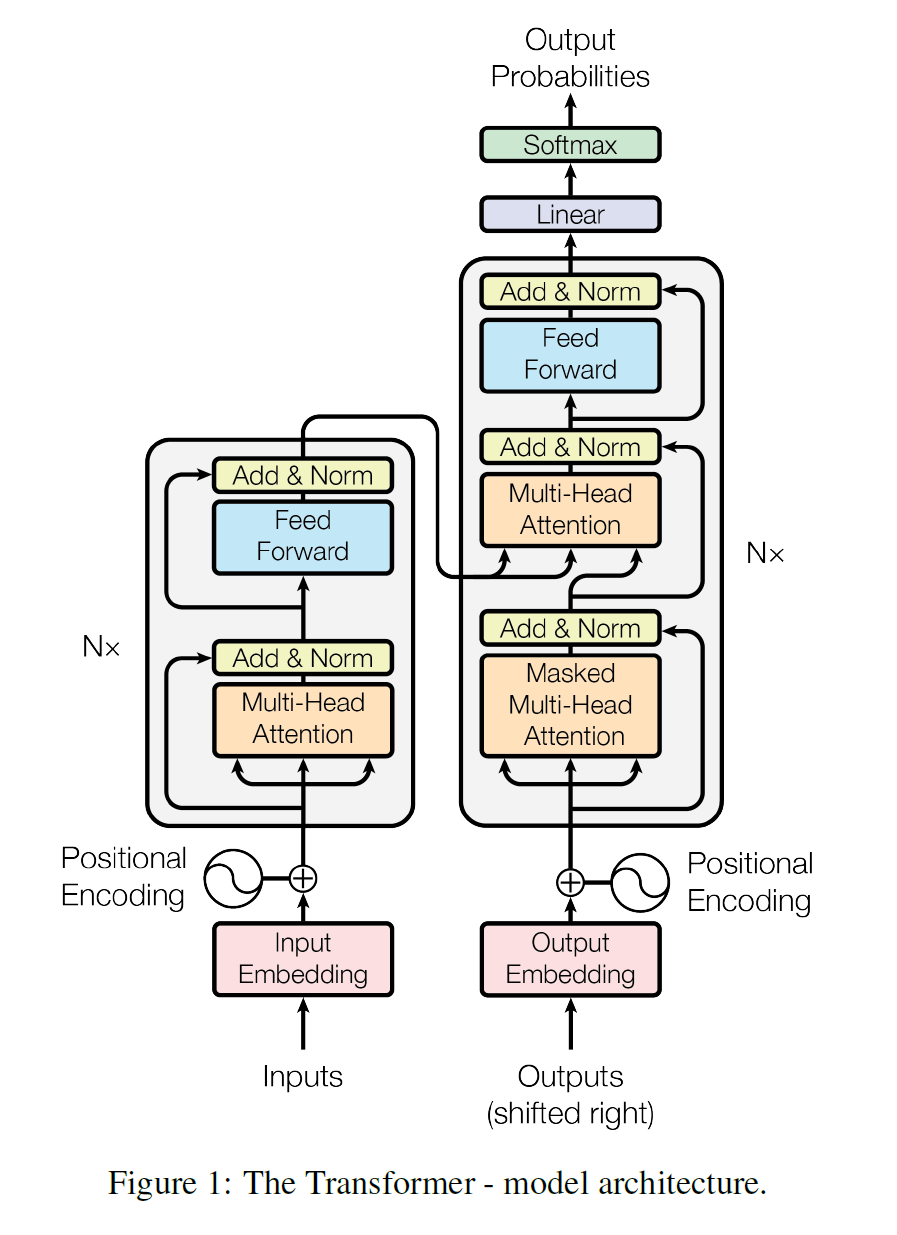

Transformer의 overall architecture은 아래의 그림과 같이 encoder-decoder structure로 이루어져있다. Encoder는 input sequence $(x_1, ..., x_n)$를 받아 연속적인 representation $(y

2.[논문리뷰] RoLA:Low-Rank Adaptation of Large Language Models

arXiv 2021. Paper GithubEdward J. Hu, Yelong Shen, Phillip Wallis, Zeyuan Allen-Zhu, Yuanzhi Li, Shean Wang, Lu Wang, Weizhu ChenMicrosoft Corporation

3.[논문리뷰] Retrieval-Augmented Generation for Knowledge-Intensive NLP Tasks

Retrieval-Augmented Generation for Knowledge-Intensive NLP Tasks 논문은 RAG모델을 통해 언어 모델이 정보 검색과 생성 과정을 결합해 더 신뢰성 있고 정보성이 높은 텍스트를 생성하는 방법을 이야기한다. 이 모델은 특히

4.[논문리뷰] ColBERTv2: Effective and Efficient Retrieval via Lightweight Late Interaction

ColBERTv2: Effective and Efficient Retrieval via Lightweight Late Interaction 논문은 정보 검색 시스템에서 ColBERT 모델의 성능을 더욱 효율적으로 개선하는 방안을 제시한다. ColBERTv2는 효과적인

5.[논문리뷰] Dense Passage Retrieval for Open-Domain Question Answering

Dense Passage Retrieval for Open-Domain Question Answering 논문은 오픈 도메인 질문 응답 시스템에서 고성능의 정보를 효율적으로 검색하기 위해 고안된 Dense Passage Retrieval(DPR) 모델을 제안한다. DP