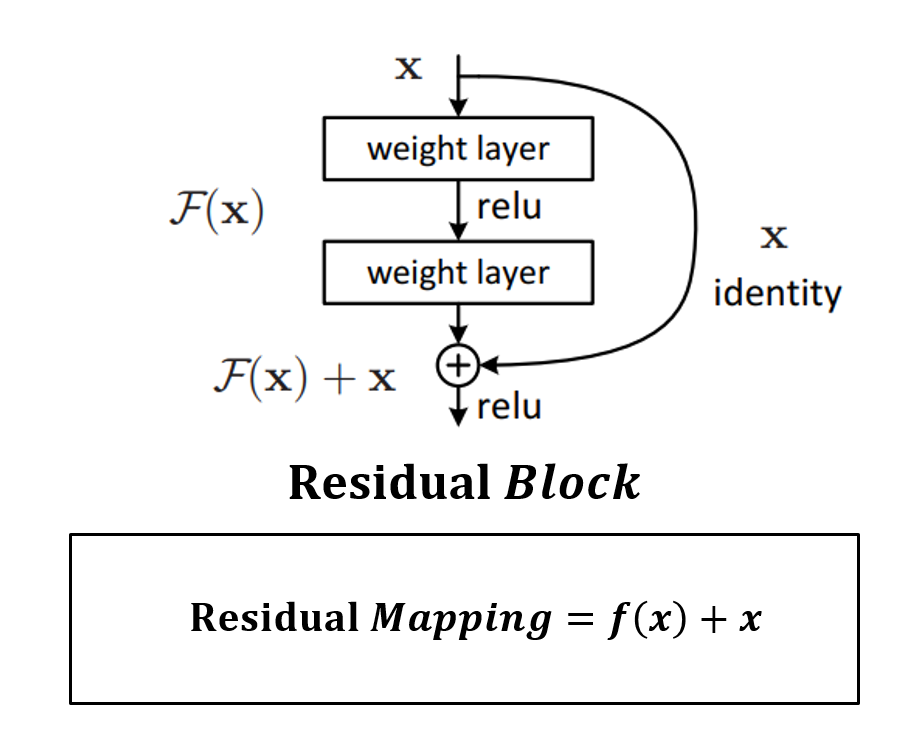

Residual Block(Function, Connection)

Background

- Reference : [Deep Learning] 비선형 함수를 사용하는 이유에 대한 시각적 설명

먼저 간단하게 참고하면 매우 좋은 자료, 시각적으로 접근하니 직관적으로 이해가 되는 너낌

About Residual ~

- Reference : An Overview of ResNet and its Variants

영어라 약간 어려움, 아직 못읽어봄 - Reference : [ML] Residual Block을 활용한 ResNet(Residual Network)

쉽고 좋은 설명 - Reference : ResNet - Residual Connection(잔차연결)

Comment :

CycleGAN 실제사용 코드에서 Generator에 Residual Block이라는 개념을 사용하여 해당 글을 작성하게 되었다.

[?] 인코더와 디코더 사이에만 Residual Block을 넣네? (몇개 넣긴함)

[?] 인코더정도의 깊이는 괜찮지만, 디코더깊이까지 깊어지면 너무 깊어서 Gradient Vanishing 문제가 생겨서 그런건가?

[?] Block속에는 Residual Function이라는 (의미없어보이는) Convolutional layer가 있음, 왜 의미없어보이냐면 입력으로 들어오는 데이터 사이즈 그대로 출력함; + batch normalization은 하긴함

[?] 비선형함수 , 를 '학습'하기 위해서인가?

[?] Residual function; 에서 우리가 원하는 는 결국 이고 (Residual function인) 가 0이 되면, 0이 되게끔 만드는 weight를 학습하면 이니까?

[!] Udacity의 CycleGAN 예제(Yosemite National Park Summer Winter)에서는 Generator속에 Residual block(layer)를 6개나 넣음 n_res_blocks=6