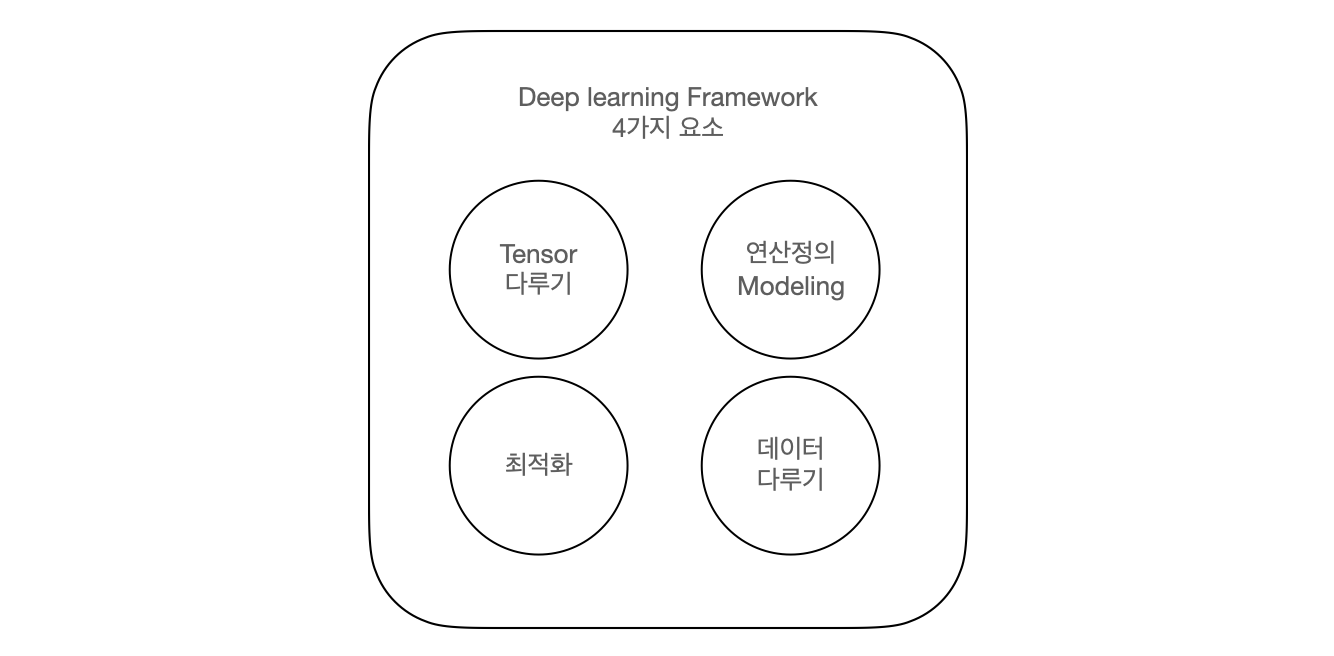

딥러닝 프레임워크 요소

모델을 정의 하는 방법

- Sequencial 사용하기 (간단하지만 자유도가 떨어진다.)

- Functional API model

- Sub class model (가장 자유도가 높다.)

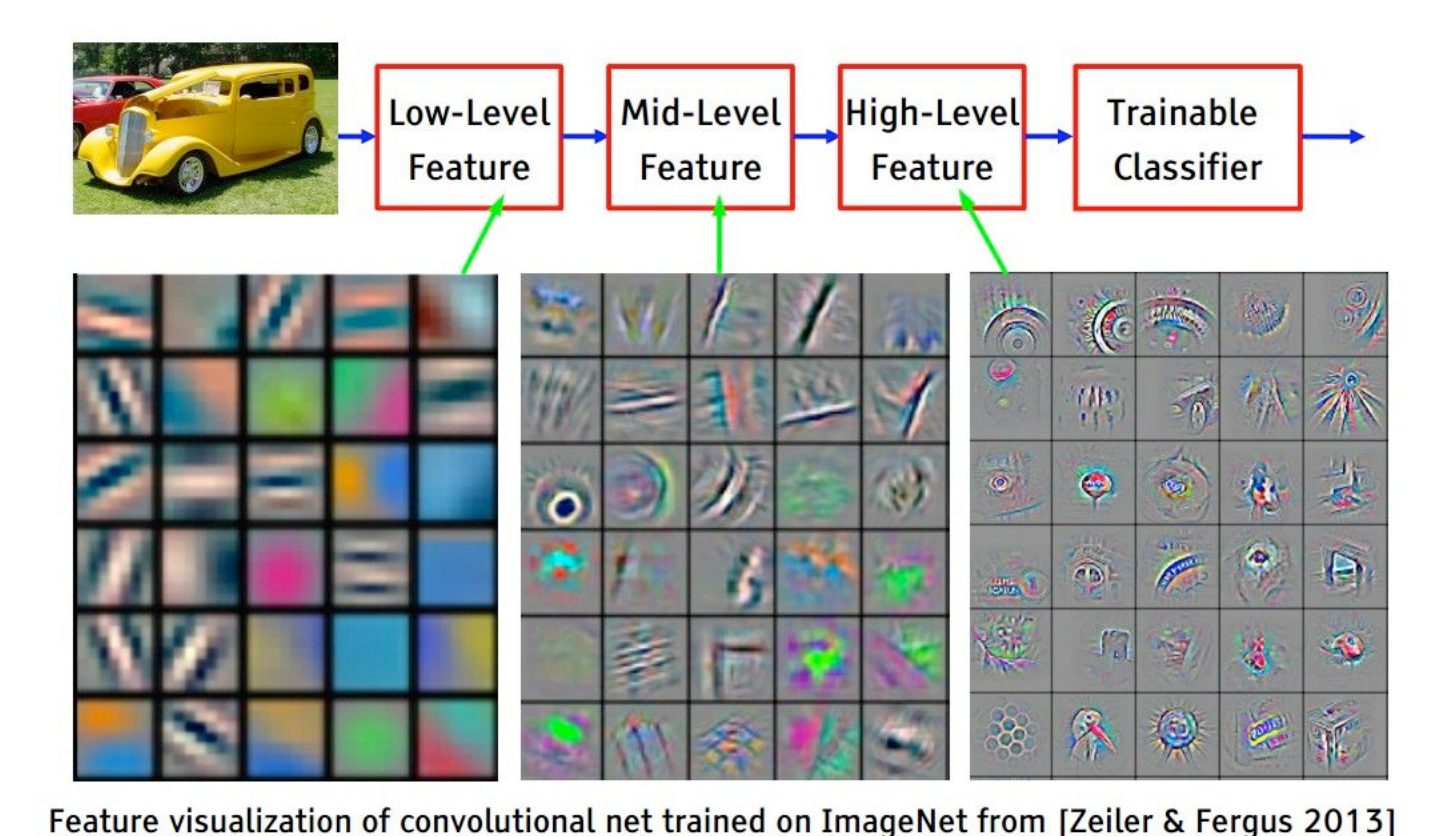

Convolutional Neural Network; CNN

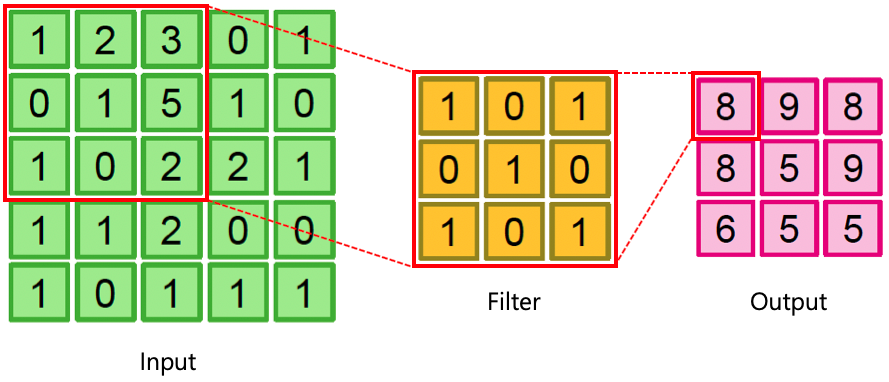

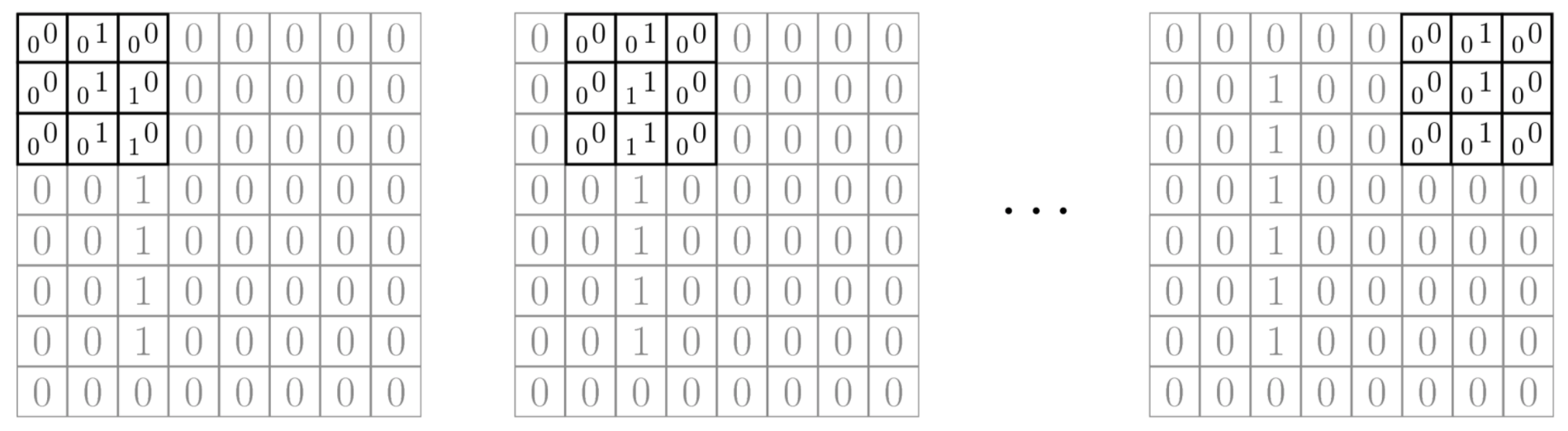

Filter to an image (Convolution layer)

VGGNet

- VGGNet은 2014년 ILSVRC에서 비록 다음에 배울 GoogLeNet에 밀려 2위를 했지만, 훨씬 간단한 구조로 이해와 변형이 쉽다는 장점이 있어 많이 응용된 모델이다. VGGNet의 개발자들은 모델의 깊이가 성능에 얼마나 영향을 끼칠지에 집중하여 연구하였다고 논문에서 밝혔다. 깊은 네트워크를 가지고 있지만, GoogLeNet과 비교하면, 구조가 매우 간단하다. 깊이에 따른 변화를 비교하기 위해, 3x3의 작은 필터 크기를 사용했고, 모델 깊이와 구조에 변화를 주어 실험하였다. 논문에서 언급한 것은 총 6개의 모델로 내용은 다음 표와 같다. 표의 "D" 구조를 VGG16, "E" 구조를 VGG19라고 부른다. 다음 표에서, "conv 3, 64" 는 3x3 컨볼루션(convolution) 연산에 출력 피쳐맵 갯수는 64개라는 뜻이다.

VGGNet에서 사용되는 Layer들

tf.keras.layers.Conv2Dtf.keras.layers.Activationtf.keras.layers.MaxPool2Dtf.keras.layers.Flattentf.keras.layers.Dense

Conv2D

- filters: layer에서 사용할 Filter(weights)의 갯수

- kernel_size: Filter(weights)의 사이즈

- strides: 몇 개의 pixel을 skip 하면서 훑어지나갈 것인지 (출력 피쳐맵의 사이즈에 영향을 줌)

- padding: zero padding을 만들 것인지. VALID는 Padding이 없고, SAME은 Padding이 있음 (출력 피쳐맵의 사이즈에 영향을 줌)

- activation: Activation Function을 지정

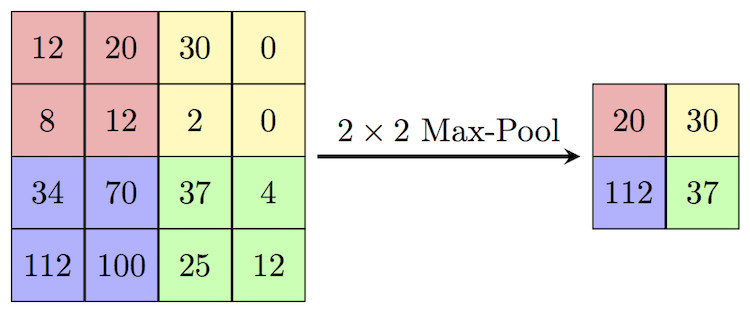

MaxPool2D

- pool_size: Pooling window 크기

- strides: 몇 개의 pixel을 skip 하면서 훑어지나갈 것인지

- padding: zero padding을 만들 것인지

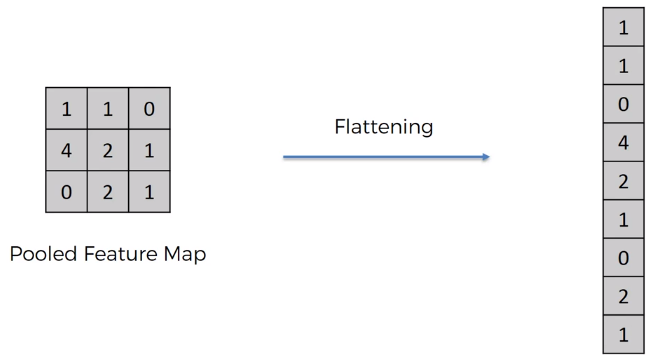

Flatten

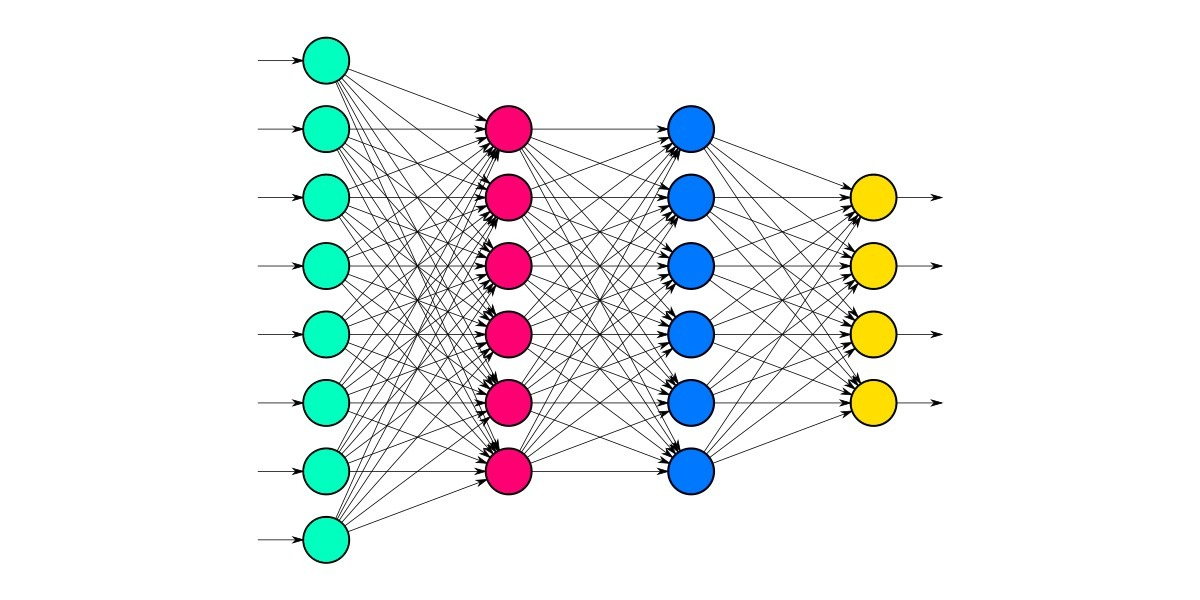

Dense

- units : 노드 갯수

- activation : 활성화 함수

- use_bias : bias 를 사용 할 것인지

- kernel_initializer : 최초 가중치를 어떻게 세팅 할 것인지

- bias_initializer : 최초 bias를 어떻게 세팅 할 것인지

1) Dataloader

- Flatten => 채널 차원 추가로 변경

- Convolution Layer는 주로 이미지데이터처리를 위해 사용되기 때문에, 컬러이미지는 (height, width, 3) 흑백은 (height, width, 1)로 사용한다. ex) (num_data, 28, 28) => (num_data, 28, 28, 1)

import numpy as np

import pandas as pd

import tensorflow as tf

import matplotlib.pyplot as plt

import seaborn as sns

%matplotlib inline

np.random.seed(7777)

tf.random.set_seed(7777)

class DataLoader():

def __init__(self):

# data load

(self.train_x, self.train_y), \

(self.test_x, self.test_y) = tf.keras.datasets.mnist.load_data()

def scale(self, x):

return (x / 255.0).astype(np.float32)

def preprocess_dataset(self, dataset):

(feature, target) = dataset

# scaling #

scaled_x = np.array([self.scale(x) for x in feature])

# Add channel axis 가짜 차원#

expanded_x = scaled_x[:, :, :, np.newaxis]

# label encoding #

ohe_y = np.array([tf.keras.utils.to_categorical(

y, num_classes=10) for y in target])

return expanded_x, ohe_y

def get_train_dataset(self):

return self.preprocess_dataset((self.train_x, self.train_y))

def get_test_dataset(self):

return self.preprocess_dataset((self.test_x, self.test_y))

# shape, dtype 확인하기

mnist_loader = DataLoader()

train_x, train_y = mnist_loader.get_train_dataset()

test_x, test_y = mnist_loader.get_test_dataset()2) Layer들을 이용해 모델 만들기 - Sequencial 방식

from tensorflow.keras.layers import Conv2D, MaxPooling2D, Flatten, Dense

model = tf.keras.Sequential()

# 최초의 레이어는 Input의 shape을 명시해준다. (이 때 배치 axis는 무시한다.)

model.add(Conv2D(32, kernel_size=3, padding='same', activation='relu', input_shape=(28, 28, 1))) # 첫번째 layer input_shape넣어줘야함

model.add(Conv2D(32, kernel_size=3, padding='same', activation='relu'))

model.add(MaxPooling2D())

model.add(Conv2D(64, kernel_size=3, padding='same', activation='relu'))

model.add(Conv2D(64, kernel_size=3, padding='same', activation='relu'))

model.add(MaxPooling2D())

model.add(Flatten())

model.add(Dense(128, activation='relu'))

model.add(Dense(64, activation='relu'))

model.add(Dense(10, activation='softmax'))

model.summary()3) 학습로직

lr = 0.03

opt = tf.keras.optimizers.Adam(lr)

loss = tf.keras.losses.categorical_crossentropy

model.compile(optimizer=opt, loss=loss, metrics=['accuracy'])4) 학습

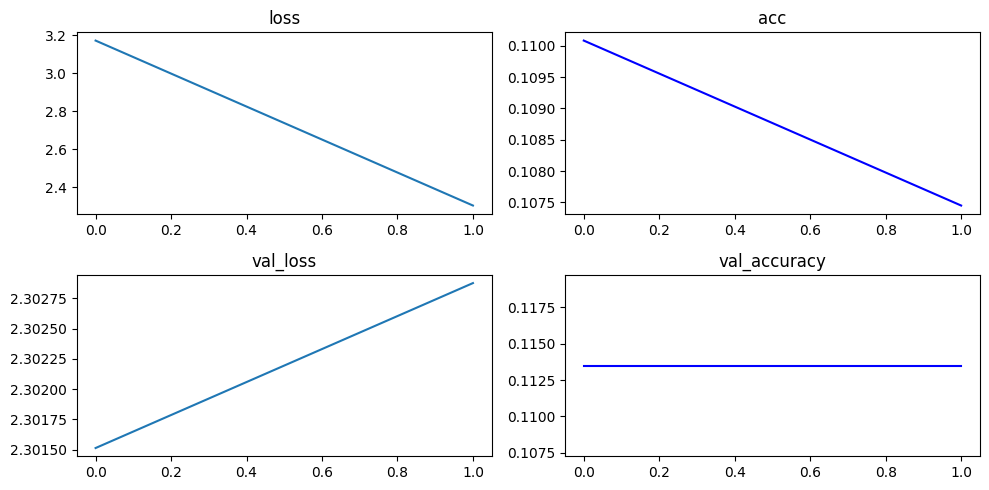

hist = model.fit(train_x, train_y, epochs=2, batch_size=128, validation_data=(test_x, test_y))

hist.history5) 후처리

- epoch늘려야 함

plt.figure(figsize=(10, 5))

plt.subplot(221)

plt.plot(hist.history['loss'])

plt.title("loss")

plt.subplot(222)

plt.plot(hist.history['accuracy'], 'b-')

plt.title("acc")

plt.subplot(223)

plt.plot(hist.history['val_loss'])

plt.title("val_loss")

plt.subplot(224)

plt.plot(hist.history['val_accuracy'], 'b-')

plt.title("val_accuracy")

plt.tight_layout()

plt.show()

+ Functional API

import numpy as np

import pandas as pd

import tensorflow as tf

import matplotlib.pyplot as plt

import seaborn as sns

%matplotlib inline

np.random.seed(7777)

tf.random.set_seed(7777)

from tensorflow.keras.layers import Input, Conv2D, MaxPool2D, Flatten, Dense

input_shape = (28, 28, 1)

inputs = Input(input_shape)

net = Conv2D(32, kernel_size=3, padding='same', activation='relu')(inputs)

net = Conv2D(32, kernel_size=3, padding='same', activation='relu')(net)

net = MaxPool2D()(net)

net = Conv2D(64, kernel_size=3, padding='same', activation='relu')(net)

net = Conv2D(64, kernel_size=3, padding='same', activation='relu')(net)

net = MaxPool2D()(net)

net = Flatten()(net)

net = Dense(128, activation="relu")(net)

net = Dense(64, activation="relu")(net)

net = Dense(10, activation="softmax")(net)

model = tf.keras.Model(inputs=inputs, outputs=net, name='VGG') #name은 모델이름 설정

model.summary()Reference

1) 제로베이스 데이터스쿨 강의자료