introduction

few shot으로 좋은 성능 보여줬지만 update 되는 지식이 필요하다. 그래서 rag쓴다. 이는 knowledge intensive한 open qa 같은 task에서 강점을 보인다.

retrieval LM은 2가지 challenge가 있다

1.LLM이 knowledge를 합성하는 법을 아는 것

2.관련 있는 content를 retrieval하는 것

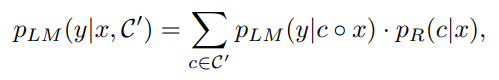

우리는 여기서 간단한 instruction tuning으로 RALM 성능 높힐 수 있는 것을 보인다

우리는 Retrieval augmented dual instruction tuning을 보인다

LM으로는 llama , encoder로는 dual encoder based encoder인 DRAGON+를 사용한다

method

parallel in context retrieval augmentation

x로 retrieval을 해서 top-k 개의 c를 뽑고 이를 parallel하게 ensemble하여 최종 output이 생성된다.