Web 크롤링

- web에 있는 자료(

data)를 쟁기처럼 긁어오는 것!

자동으로 긁어오는것(주기적으로)

- 정기적으로(maybe every hour / a month) - 갱신하면서, 최신화, 자동화

스크래핑

- 한 순간의 데이터를 그냥 가져오는거(한 순간)

- 한 순간

- 업데이트 되면, 무용지물이 될 수 있음

beautifulsoup - HTML로 부터 XML을 뽑아내기 위한 library

에서

id , class 를 selector로 사용하여, 변수로 사용할 수 있게 도와줌

selenium

의 차이!!!

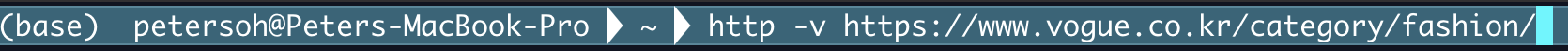

terminal에서 http command를 사용하기 위해선 먼저 이 녀석을 깔아줘야 한다!

pip install --upgrade pip setuptools

pip install --upgrade httpie

# 그리고 밑에 코드를 터미널에서 실행하면!

# http **`request`** 보내기http -v https://www.vogue.co.kr/category/fashion/

코드를 실행하면 서버에서 response로 html 태그로 된 정보가 쏟아진다!

get method / post method

쏟아지는 css 코드 들!

이 selector를 분석해야 한다!

beautifulsoup

-#- id.- class 와 같은selector를 분석하여변수로 사용 할 수 있게 도와줌

참고: BeautifulSoup 공식문서- ``` pip install beautifulsoup4``` - `HTML`과 `XML` 파일로부터 데이터를 뽑아내기 위한 파이썬 `라이브러리`selenium- 브라우저를 실행시켜, 동적인 입력이 필요한 웹을 구동할 수 있는 라이브러리

pip install selenium

pip install webdriver-manager

pip install requests # http통신을 하기 위해서

csv 형태로 저장!! [comma separated value]

python으로 모든것을 제어 할 수 있다!!

selenium

각각의 카테고리를 눌러줘~~~

http

https

더 나아가기

자동화!!!!