1.다음 중 IAM 역할의 올바른 정의는 무엇일까요?

1.다중 사용자 그룹에 속한 IAM 사용자

2.IAM 사용자들을 위한 비밀번호 정책을 정의 하는 IAM 개체

3.AWS 서비스에 요청을 생성하기 위한 일련의 권한을 정의하고, AWS 서비스에 의해 사용될 IAM 개체

4.특정 행동 수행을 위해 IAM 사용자에게 할당된 권한

일부 AWS 서비스는 여러분을 위해 특정 행동을 수행해야 합니다. IAM 역할은 이러한 권한을 할당하기 위해 사용됩니다.

2.다음 중 IAM 보안 도구에 해당되는 것은 무엇인가요?

1.IAM 자격 증명 보고서

2.IAM 루트 계정 관리자

3.IAM 서비스 보고서

4.IAM 보안 관리자

IAM 자격 증명 보고서에는 AWS 계정의 모든 IAM 사용자와 이들의 다양한 자격 증명 상태가 포함되어 있습니다.

3.IAM 사용자에 대해 잘못 서술된 내용을 고르세요.

1.IAM 사용자들은 다중 사용자 그룹에 속할 수 있습니다.

2.IAM 사용자들이 사용자 그룹에 속할 필요는 없습니다.

3.IAM 정책은 IAM 사용자에게 직접 연결될 수 있습니다.

4.IAM 사용자들은 루트 계정 자격 증명을 통해 AWS 서비스에 액세스 합니다.

IAM 사용자들은 자신만의 자격 증명(사용자 이름 & 비밀번호, 혹은 액세스 키)을 통해 AWS 서비스에 액세스합니다.

4.다음 중 IAM 모범 사례에 해당하는 것은 무엇인가요?

1.한 사람에게 다수의 IAM 사용자 생성하기

2.루트 계정 사용하지 않기

3.동료들이 업무를 대신 수행할 수 있도록 AWS 계정 자격 증명을 공유하기

4.보다 쉬운 액세스를 위해 MFA를 활성화하지 않기

루트 계정은 최초 IAM 사용자 생성과 일부 계정/서비스 관리 업무에만 사용됩니다. 일상적인 업무에는 IAM 사용자를 사용하셔야 합니다.

5.IAM 정책은 무엇인가요?

1.AWS 계정들이 상호작용하는 방법을 정의하는 일련의 정책

2.AWS 서비스에 요청을 생성하기 위한 일련의 권한을 정의하며, IAM 사용자, 사용자 그룹 및 IAM 역할에서 사용하게 될 JSON 문서

3.IAM 사용자들의 비밀번호를 정의하는 일련의 정책

4.고객들이 AWS와 상호작용하는 방법을 보여주는, AWS에서 정의한 일련의 정책

6.IAM 권한에는 다음 중 어떤 원칙이 적용되어야 할까요?

1.최대 권한 부여하기

2.직원의 요청이 있을 경우, 더 많은 권한 부여하기

3.최소 권한 부여하기

4.루트 계정 권한 해지하기

사용자에게 필요 이상의 권한을 부여하지 마세요.

7.루트 계정 보안을 향상시키기 위해서는 어떤 작업을 수행해야 할까요?

1.루트 계정에서 권한 제거하기

2.AWS 명령줄 인터페이스(CLI)를 통해서만 AWS 서비스에 액세스하기

3.IAM 사용자를 생성하지 않고, 루트 계정으로만 AWS 계정에 액세스하기

4.다중 인증(MFA) 활성화하기

MFA를 활성화할 경우, 보안에 하나의 층을 더 추가하게 됩니다. 비밀번호가 유출되었거나 도용을 당한 경우에도, 여러분의 계정은 안전합니다.

8.(참/거짓) IAM 사용자 그룹은 IAM 사용자 및 기타 사용자 그룹을 포함할 수 있습니다.

1.O

2.X

IAM 사용자 그룹은 IAM 사용자만을 포함할 수 있습니다.

9.IAM 정책은 하나 이상의 문장으로 구성됩니다. 다음 중 IAM 정책 내 문장의 구성 요소가 아닌 것을 고르세요.

1.효과

2.원칙

3.버전

4.조치

5.리소스

IAM 정책의 문장은 시드, 효과, 원칙, 조치, 리소스, 그리고 조건으로 구성됩니다. 버전은 IAM 정책 자체의 일부이지, 문장의 일부가 아닙니다.

10.다음 중, 할인 폭이 가장 크나, 데이터베이스 혹은 중요 업무에는 적합하지 않은 EC2 구매 옵션은 무엇인가요?

1.전환 가능 예약 인스턴스

2.전용 호스트

3.스팟 인스턴스

스팟 인스턴스는 단기적인 워크로드에 적합하며, 가장 저렴한 EC2 구매 옵션입니다. 하지만 EC2 인스턴스를 손실할 우려가 있기 때문에, 신뢰도가 떨어집니다.

11.EC2 인스턴스 내/외의 트래픽을 제어하기 위해서는 무엇을 사용해야 하나요?

1.네트워크 액세스 제어 리스트(NACL)

2.보안 그룹

3.IAM 정책

보안 그룹은 EC2 인스턴스 레벨에서 운용되며, 트래픽을 제어할 수 있습니다.

12.EC2 예약 인스턴스를 예약할 수 있는 기간은 얼마인가요?

1.1년, 혹은 3년

2.2년, 혹은 4년

3.6개월, 혹은 1년

4.1년에서 3년 사이의 기간

EC2 예약 인스턴스는 1년, 혹은 3년의 기간으로만 예약이 가능합니다.

13.EC2 인스턴스에 고성능 컴퓨팅(HPC) 애플리케이션을 배포하려 합니다. 다음 중 어떤 EC2 인스턴스 유형을 선택해야 할까요?

1.스토리지 최적화

2.컴퓨팅 최적화

3.메모리 최적화

4.범용

컴퓨팅 최적화 EC2 인스턴스는 고성능 프로세서(예: 배치 처리, 미디어 트랜스코딩, 고성능 컴퓨팅, 과학적 모델링 및 머신 러닝, 전용 게이밍 서버 등)가 필요한 집중 컴퓨팅 워크로드에 적합합니다.

14.1년 간 지속적으로 서버를 운영할 계획인 애플리케이션의 경우에는 다음 중 어떤 EC2 구매 옵션을 사용해야 할까요?

1.예약 인스턴스

2.스팟 인스턴스

3.온디맨드 인스턴스

예약 인스턴스는 장기적인 워크로드에 적합합니다. EC2 인스턴스는 1년, 혹은 3년의 기간으로 예약할 수 있습니다.

15.일련의 EC2 인스턴스에 호스팅 될 애플리케이션을 실행하려 합니다. 이 애플리케이션에는 소프트웨어 설치가 필요하며, 최초 실행 중에 일부 OS 패키지를 업데이트해야 합니다. EC2 인스턴스를 실행하려는 경우, 이를 위한 최적의 방식은 무엇일까요?

1.SSH를 통해 각 EC2인스턴스에 연결한 후, 필수 소프트웨어를 설치하고 OS 패키지를 수동으로 업데이트 하기

2.필수 소프트웨어의 설치 및 OS업데이트를 수행하는 bash스크립트를 작성한 후, AWS 지원 센터에 연락해 스크립트 제공하기 이들은 EC2인스턴스를 실행할 때 인스턴스에서 실행됩니다.

3.필수 소프투웨어의 설치 및 OS업데이트를 수행하는 bash스크립트를 작성한 후, 이 스크립트를 EC2인스턴스 실행 시에 EC2사용자 데이터에서 사용하기

EC2 사용자 데이터는 bash 스크립트를 사용해 EC2 인스턴스를 부트스트랩 할 경우에 사용됩니다. 이 스크립트에는 소프트웨어/패키지 설치, 인터넷에서 파일 다운로드 등, 여러분이 원하는 작업을 수행하기 위한 명령어를 포함시킬 수 있습니다.(3)

16.인메모리 데이터베이스를 사용하는 중요 애플리케이션을 위해서는 다음 중 어떤 EC2 인스턴스 유형을 선택해야 할까요?

1.컴퓨팅 최적화

2.스토리지 최적화

3.메모리 최적화

4.범용

메모리 최적화 EC2 인스턴스는 메모리에 대규모 데이터 세트가 필요한 워크로드에 적합합니다.

17.온프레미스에 호스팅된 OLTP 데이터베이스를 갖춘 전자 상거래 애플리케이션이 있습니다. 이 애플리케이션은 인기가 좋아, 데이터베이스가 초당 수천 개의 요청을 지니게 됩니다. 여러분은 데이터베이스를 EC2 인스턴스로 이전하려 합니다. 이렇게 높은 빈도를 보이는 OLTP 데이터베이스를 처리하기 위해서는 어떤 EC2 인스턴스 유형을 선택해야 할까요?

1.컴퓨팅 최적화

2.스토리지 최적화

3.메모리 최적화

4.범용

스토리지 최적화 EC2 인스턴스는 로컬 스토리지의 대규모 데이터 세트에 대해 높은 수준의, 그리고 순차적인 읽기/쓰기 액세스 권한이 필요한 워크로드에 적합합니다.

18.(참/거짓) 보안 그룹은 오직 하나의 EC2 인스턴스에만 연결될 수 있습니다.

1.맞습니다.

2.아닙니다.

19.온프레미스 애플리케이션을 AWS로 이전하려 합니다. 여러분의 기업에는 애플리케이션을 전용 서버에서 실행해야 한다는 엄격한 규정이 있습니다. 또한 비용 절감을 위해 전용 서버 바운드 소프트웨어 라이선스를 사용해야 합니다. 이 경우, 다음 중 어떤 EC2 구매 옵션이 적합할까요?

1.전환 가능 예약 인스턴스컨버터블 예약 인스턴스

2.전용 호스트

3.스팟 인스턴스

전용 호스트는 높은 수준의 규정 준수가 필요한 기업, 혹은 복잡한 라이선스 모델을 가진 소프트웨어에 적합합니다. 이는 가장 비싼 EC2 구매 옵션입니다.

20.데이터베이스 기술을 EC2 인스턴스에 배포하려 합니다. 공급 업체 라이선스는 물리적 코어 및 기반 네크워크 소켓 가시성를 기반으로 비용을 책정합니다. 이 경우, 어떤 EC2 구매 옵션을 사용해야 가시성을 확보할 수 있을까요?

1.스팟 인스턴스

2.온디맨드

3.전용 호스트

4.예약 인스턴스

전용 호스트는 특정 물리적 서버를 예약하여 해당 서버의 모든 리소스를 독점적으로 사용할 수 있는 옵션입니다. 따라서 라이선스 비용이 물리적 코어 및 기반 네트워크 소켓 가시성에 기반하여 책정되기 때문에 전용 호스트를 사용하면 이러한 비용을 최적화할 수 있습니다.

21.NodeJS 애플리케이션을 호스트하게 될 EC2 인스턴스를 실행했습니다. 모든 필수 소프트웨어를 설치하고 애플리케이션을 구성한 후, 액세스를 위해 EC2 인스턴스 공용 IPv4를 기록해 두었습니다. 그 다음, 실행을 중단하고 애플리케이션 구성을 완료하기 위해 EC2 인스턴스를 다시 시작했습니다. 그러나 재시작 후, EC2 인스턴스에 액세스할 수 없었으며 EC2 인스턴스 공용 IPv4가 변경된 것을 알게 되었습니다. 이 경우, EC2 인스턴스에 고정적인 공용 IPv4를 할당하려면 어떻게 해야 할까요?

1.EC2 인스턴스에 탄력적 IP할당

2.EC2 인스턴스 OS에서, 네트워크 구성을 DHCP에서 정적으로 변경한 뒤 공요 IPv4에 할당

3.AWS지원 센터에 연락해 EC2인스턴스를 위한 정적 공용 IPv4요청

4.불사능, EC2 인스턴스에는 고정 사설 IPv4만 할당 가능

탄력적 IP는 여러분이 원하는 기간만큼 소유할 수 있는 공용 IPv4로, 한 번에 하나의 EC2 인스턴스에만 연결할 수 있습니다.

22.스팟 플릿은 한 세트의 스팟 인스턴스로, 선택적 ..............입니다.

1.예약 인스턴스

2.온디맨드 인스턴스

3.전용 호스트

4.전용 인스턴스

스팟 플릿은 한 세트의 스팟 인스턴스로, 선택적 온디맨드 인스턴스입니다. 이를 사용하면 가장 낮은 가격의 스팟 인스턴스를 자동으로 요청할 수 있습니다.

23.EC2 인스턴스 플릿에서 대규모의 데이터 분석을 수행하는 애플리케이션이 있습니다. 여러분은 EC2 인스턴스들이 서로 소통하면서도 가장 높은 수준의 네트워킹 성능을 유지했으면 합니다. 이런 경우, 다음 중 어떤 EC2 배치 그룹을 선택해야 할까요?

1.분산 배치 그룹

2.클러스터 배치 그룹

3.분할 배치 그룹

클러스터 배치 그룹을 사용하면 EC2 인스턴스들이 나란히 위치하게 되어 고성능의 컴퓨팅 및 네크워킹 성능을 제공하게 됩니다.

24.EC2 인스턴스 플릿에 호스팅된 중요 애플리케이션이 있습니다. 이 애플리케이션에서 AZ 실패가 일어난 경우, 최대 가용성을 달성했으면 합니다. 이런 경우, 다음 중 어떤 EC2 배치 그룹을 선택해야 할까요?

1.클러스터 배치 그룹

2.분할 배치 그룹

3.분산 배치 그룹

분산 배치 그룹은 EC2 인스턴스를 여러 AZ에 걸쳐 서로 다른 물리적 하드웨어에 배치합니다.

25.탄력적 네트워크 인터페이스(ENI)는 다른 AZ에 있는 EC2 인스턴스와 연결될 수 있습니다.

1.맞습니다.

2.아닙니다.

탄력적 네트워크 인터페이스(ENIs)는 특정 AZ로 국한됩니다. 다른 AZ에 있는 EC2 인스턴스에 ENI를 연결할 수는 없습니다.

26.EC2 절전 모드와 관련된 내용 중, 옳지 않은 설명을 고르세요.

1.EC2 인스턴스 루트 볼륨은 반드시 인스턴스 스토어 볼륨이어야 함

2.온디맨드 및 예약 인스턴스를 지원함

3.EC2 인스턴스 RAM은 150GB 미만이어야 함

4.EC2인스턴스 루트 볼륨은 유형은 EBS볼륨이어야 함

EC2 절전 모드를 활성화하기 위해서는 EC2 인스턴스 루트 볼륨 유형이 EBS 볼륨이어야만 하며, 민감한 내용을 보호할 수 있도록 암호화되어야 합니다.

27.us-east-1a에서의 EC2 인스턴스를 종료하여, 이 인스턴스에 연결된 EBS 볼륨을 사용할 수 있게 되었습니다. 팀원이 us-east-1b의 EC2 인스턴스에 이 볼륨을 연결하려 했으나, 연결이 불가능한 상태입니다. 이 경우, 가능성이 있는 원인은 무엇일까요?

1.IAM 권한이 없음

2.EBS 볼륨은 AWS 리전으로 제한되어 있음

3.EBS 볼륨은 가용 영역으로 제한되어 있음

EBS 볼륨은 특정 AZ에 맞춰 생성됩니다. EBS 스냅샷을 활용하면 다른 AZ 간의 이전이 가능합니다.(3)

28.루트 볼륨 유형과 데이터 저장을 위한 기타 EBS 볼륨 유형, 두 개의 EBS 볼륨으로 EC2 인스턴스를 실행했습니다. EC2 인스턴스는 한 달 후에 종료할 예정입니다. 각 EBS 볼륨에 기본적으로 나타날 행위 특성은 무엇일까요?

1.루트 볼륨 유형과 EBS볼륨 유형이 모두 삭제됨

2.루트 볼륨 유형은 삭제되지만, EBS 볼륨 유형은 삭제되지 않음

3.루트 볼륨 유형은 삭제되지 않고, EBS 볼륨 유형은 삭제됨

4.루트 볼륨 유형과 EBS볼륨 유형 모두 삭제되지 않음

루트 볼륨의 경우, ‘종료 시 삭제' 속성이 기본으로 활성화되어 있기 때문에, 기본적으로 삭제되게 됩니다. 기타 EBS 볼륨 유형의 경우, ‘종료 시 삭제' 속성이 기본적으로 비활성화되어 있으므로 삭제되지 않습니다.

29.노스버지니아 리전 us-east-1에서 AMI를 사용하면 어떤 AWS 리전에 있는 EC2 인스턴스라도 실행할 수 있습니다

1.맞습니다.

2.아닙니다.

AMI는 특정 AWS 리전에 국한되며, 각 AWS 리전에는 고유한 AMI가 있습니다. 다른 AWS 리전에서 AMI를 사용해 EC2 인스턴스를 실행하는 것은 불가능하지만, 대상 AWS 리전으로 AMI를 복사해 EC2 인스턴스를 생성하는 것은 가능합니다.

30.다음 중, EC2 인스턴스를 생성할 때 부팅 볼륨으로 사용할 수 있는 EBS 볼륨 유형은 무엇인가요?

1.gp2,gp3,st1,sc1

2.gp2,gp3,io1,io2

3.io1,io2,st1,sc1

EC2 인스턴스를 생성할 때, 부팅 볼륨으로는 다음의 EBS 볼륨 유형만을 사용할 수 있습니다: gp2, gp3, io1, io2, Magnetic(표준)

31.EBS 다중 연결이란 무엇일까요?

1.동일한 EBS볼륨을 다수의 AZ에 있는 다수의 EC2인스턴스에 연결

2.다수의 EBS볼륨을 동일한 AZ에 있는 동일 EC2인스턴스에 연결

3.동일한 EBS볼륨을 동일한 AZ에 있는 다수의 EC2인스턴스에 연결

4.다수의 EBS볼륨을 다수의 AZ에 있는 동일 EC2인스턴스에 연결

EBS 다중 연결을 사용하면, 동일한 EBS 볼륨을 동일 AZ 상에 있는 다수의 EC2 인스턴스에 연결할 수 있습니다. 각 EC2 인스턴스는 완전한 읽기/쓰기 권한을 갖게 됩니다.

32.EC2 인스턴스에 연결되어 있는, 암호화되지 않은 EBS 볼륨을 암호화하려 합니다. 어떻게 해야 할까요?

1.EBS볼륨의 EBS스냅샷을 생성하고, 스냅샷을 복사한 뒤 복사된 스냅샷을 암호화하는 옵션을 체크합니다. 그 후, 암호화된 스냅샷을 사용해 새로운 EBS볼륨을 생성합니다.

2.EBS볼륨을 선택하고, Edit속성을 선택한 후, KMS옵션을 사용해 암호화 옵션을 체크합니다.

3.암호화된 EBS볼륨을 새로 생성한 후, 암호화되지 않은 EBS볼륨의 데이터를 새로운 EBS볼륨으로 복사합니다.

4.AWS지원 센터에 EBS볼륨 암호화를 요청합니다.

1

33.대량의 데이터 세트를 처리하는, 다수의 AZ에 걸친 EC2 인스턴스 플릿이 있습니다. 동일한 데이터가 NFS 드라이브로서 모든 EC2 인스턴스에서 액세스할 수 있게 만들기 위해서는 어떤 방법을 추천할 수 있을까요?

1.EBS사용

2.EFS사용

3.인스턴스 스토어 사용

EFS는 네트워크 파일 시스템(NFS)으로 여러 AZ 상에 있는 EC2 인스턴스에 동일한 파일 시스템을 마운트할 수 있게 해줍니다.

34.EC2 인스턴스에 호스팅된 애플리케이션에 고성능 로컬 캐시를 포함시키려 합니다. EC2 인스턴스 종료 시, 캐시가 소실되어도 문제가 없는 상황입니다. 이런 경우, 솔루션 아키텍트로서 어떤 스토리지 메커니즘을 추천할 수 있을까요?

1.EBS사용

2.EFS사용

3.인스턴스 스토어 사용

EC2 인스턴스 스토어는 최적의 디스크 I/O 성능을 제공합니다.

35.기반 스토리지에 310,000의 IOPS가 필요한 고성능 데이터베이스를 실행하고 있습니다. 어떤 방법을 추천할 수 있을까요?

1.EBS gp2드라이브 사용

2.EBS io1드라이브 사용

3.EC2 인스턴스 스토어 사용

4.EBS io2 Block Express 드라이브 사용

- EBS gp2 볼륨 유형으로 달성할 수 있는 최대 IOPS는 16,000입니다.

- EBS io1 혹은 io2 볼륨 유형으로 달성할 수 있는 최대 IOPS는 64,000입니다.

- EC2 인스턴스에서 데이터베이스를 인스턴스 스토어를 사용하여 실행 가능하지만, EC2 인스턴스가 중지 시 데이터가 손실이라는 문제가 있습니다 (문제 없이 다시 시작할 수 있음). 한 가지 솔루션은 인스턴스 스토어가 있는 다른 EC2 인스턴스에서 복제 메커니즘을 설정하여 대기 복사본을 가질 수 있다는 것입니다. 또 다른 솔루션은 데이터에 대한 백업 메커니즘을 설정하는 것입니다. 요구 사항을 검증하기 위해 아키텍처를 설정하는 방법은 모두 사용자에게 달려 있습니다. 이 사용 사례에서는 IOPS 기준이므로 EC2 인스턴스 스토어를 선택해야 합니다.

36.EC2 인스턴스를r4.large에서 r4.4xlarge로 확장하는 것은 .....................(이)라고 합니다.

1.수평 확장성

2.수직 확장성

2

37.EC2 인스턴스의 수를 스케일링하는 오토 스케일링 그룹을 실행하는 것은 .....................(이)라고 합니다.

1.수평 확장성

2.수직 확장성

1

38.Elastic Load Balancer는 .......................(을)를 제공합니다.

1.애플리케이션에 사용 가능한 정적 IPv4

2.애플리케이션에 사용 가능한 정적 DNS 이름

3.애플리케이션에 사용 가능한 정적 IPv6

AWS에서 관리하는 기반 인프라가 변경되었다고 하더라도, AWS가 정적 엔드 포인트를 사용해 로드 밸런스로 액세스할 수 있기를 원하는 이유입니다.(2)

39.Elastic Load Balancer가 관리하는 10개의 EC2 인스턴스 상에서 웹사이트를 실행 중입니다. 웹사이트의 사용자들은 웹사이트에서 다른 페이지로 이동할 대마다 새로 인증을 해야한다는 점에 대해 불만을 토로하고 있습니다. 하지만 여러분의 기기와 하나의 EC2 인스턴스를 지닌 개발 환경에서는 아무 문제 없이 작동을 하고 있기 때문에 곤혹스러운 상황입니다. 무엇이 원인일까요?

1.웹사이트가 다수의 EC2인스턴스에서 호스팅되어 문제가 발생함

2.IP주소를 확인할 수 없기 때문에 EC2인스턴스가 사용자들을 로그아웃 시키고, 그 대신 ELB IP주소를 받은 것

3.Elastic Load Balancer가 고정 세션을 활성화하지 않은 것

ELB 고정 세션 기능은 동일한 클라이언트에 대한 트래픽이 항상 동일한 대상으로 리다이렉트되도록 해줍니다(예: EC2 인스턴스) 이는 클라이언트들이 세션 데이터를 소실하지 않게 해줍니다.

40.Application Load Balancer를 사용해 EC2 인스턴스에서 호스팅된 웹사이트의 트래픽을 분배하고 있습니다. 그런데 여러분의 웹사이트가 Application Load Balancer의 IP 주소인 사설 IPv4 주소에서 들어오는 트래픽만을 확인하고 있는 것으로 나타났습니다. 이런 경우, 웹사이트로 연결된 클라이언트들의 IP 주소를 받으려면 어떻게 해야 할까요?

1.웹사이트의 프론트엔드를 수정해 사용자들이 모든 요청에서 자신의 IP를 보낼 수 있도록 만들기

2.웹사이트의 백엔드를 수정해 X-Forwarded-For 헤더로부터 클라이언트 IP주소를 가져오도록 만들기

3.웹사이트의 백엔드를 수정해 X-Forwarded-Port 헤더로부터 클라이언트 IP주소를 가져오도록 만들기

4.웹사이트의 백엔드를 수정해 X-Forwarded-Proto 헤더로부터 클라이언트 IP주소를 가져오도록 만들기

Application Load Balancer를 사용하여 EC2 인스턴스에 트래픽을 배분하는 경우, 요청을 받게 되는 IP 주소는 ALB의 사설 IP 주소가 됩니다. 클라이언트의 IP 주소를 받기 위해, ALB는 클라이언트의 IP 주소를 포함하고 있는 X-Forwarded-For라는 헤더를 추가합니다.

41.Elastic Load Balancer가 관리하는 한 세트의 EC2 인스턴스 상에 애플리케이션을 호스팅했습니다. 일주일 후, 사용자들은 가끔씩 애플리케이션이 작동하지 않는다며 호소하기 시작했습니다. 문제점을 조사한 결과, 일부 EC2 인스턴스가 이따금 충돌한다는 문제점이 발견되었습니다. 사용자들이 충돌하는 EC2 인스턴스에 연결되지 않도록 보호하기 위해서는 어떻게 해야 할까요?

1.ELB 상태 확인 활성화

2.ELB 고착도 활성화하기

3.SSL 종료 활성화

4.영역간 로드 밸런싱 활성화

ELB 상태 확인을 활성화하면, ELB가 비정상(충돌) EC2 인스턴스로는 트래픽을 보내지 않게 됩니다.

42.어떤 기업에서 솔루션 아키텍트로 근무하고 있는 여러분은 1초에 수백만 개의 요청을 받게 될 고성능의, 그리고 지연 시간이 적은 애플리케이션을 위한 아키텍처를 설계해달라는 요청을 받았습니다. 다음 중 어떤 종류의 Elastic Load Balancer를 사용해야 할까요?

1.Application Load Balancer(ALB)

2.Classic Load Balancer(CLB)

3.Network Load Balancer(NLB)

Network Load Balancer는 애플리케이션이 필요로 할 경우 가장 높은 성능과 가장 낮은 지연 시간을 제공합니다.

43.Application Load Balancer가 지원하지 않는 프로토콜을 고르세요.

1.HTTP

2.HTTPS

3.TCP

4.WebSocket

Network Load Balancer는 TCP와 UDP 프로토콜을 모두 지원합니다.

44.Application Load Balancer는 트래픽을 다른 대상 그룹으로 라우팅할 수 있습니다. 이때 확인할 내용으로 사용할 수 없는 것을 고르세요

1.클라이언트의 위치(지리적)

2.호스트 이름

3.요청 URL경로

4.소스 IP-주소

ALB는 URL 경로, 호스트 이름, HTTP 헤더 및 쿼리 문자열을 기반으로 트래픽을 다른 대상 그룹으로 라우팅할 수 있습니다.(1)

45.Application Load Balancer의 대상 그룹에 등록된 대상이 될 수 없는 것을 고르세요.

1.EC2 인스턴스

2.Network Load Balancer(NLB)

3.사설 IP주소

4.Lambda 함수

2

46.규정 준수를 위해, 고정된 정적 IP 주소를 최종 사용자에게 노출하여 사용자들이 안정적이고, 규제 기관의 승인을 받은 방화벽 규칙을 작성할 수 있도록 하려 합니다. 이런 경우, 다음 중 어떤 종류의 Elastic Load Balancer를 사용해야 할까요?

1.탄력적 IP가 연결된 Application Load Balancer

2.Network Load Balancer(NLB)

3.Classic Load Balancer(CLB)

Network Load Balancer는 AZ 당 하나의 정적 IP 주소를 가지며, 여기에 탄력적 IP 주소를 연결할 수 있습니다. Application Load Balancer와 Classic Load Balancer를 정적 DNS 이름으로 사용할 수 있습니다.

47.Application Load Balancer 내에 사용자 지정 애플리케이션 기반 쿠키를 생성하려 합니다. 다음 중 쿠키의 이름으로 사용 가능한 것은 무엇인가요?

1.AWSALBAPP

2.APPUSERC

3.AWSALBTG

4.AWSALB

다음의 쿠키 이름은 ELB가 선점하고 있습니다(AWSALB, AWSALBAPP, AWSALBTG).

48.us-east-1에 있는 한 세트의 EC2 인스턴스에 트래픽을 배분하는 Network Load Balancer가 있습니다. us-east-1b AZ에 2개의 EC2 인스턴스, us-east-1e AZ에는 5개의 EC2 인스턴스가 있습니다. 여러분은 us-east-1b AZ에 있는 EC2 인스턴스의 CPU 사용률이 더 높다는 것을 발견했습니다. 조사를 거친 결과, 두 개의 AZ에 걸쳐 분배된 트래픽의 양은 동일한 것으로 나타났습니다. 이 경우, 어떻게 문제를 해결해야 할까요?

1.영역간 로드 밸런싱 활성화

2.고정 센서 활성화

3.ELB 상태 확인 활성화

4.SSL 종료 활성화

영역간 로드 밸런싱을 활성화하면, ELB가 모든 AZ에 있는 등록된 EC2 인스턴스 전체에 동등하게 분배됩니다.

49.다음 중 하나의 리스너로 다수의 SSL 인증서를 가져올 수 있도록 해주는 Application Load Balancer와 Network Load Balancer의 기능은 무엇인가요?

1.TLS 종료

2.서버 이름 표식(SNI)

3.SSL 보안 정책

4.호스트 헤더

2

50.다음과 같은 호스트 이름을 기반으로, 트래픽을 3개의 대상 그룹으로 리다이렉팅하도록 구성된 Application Load Balancer가 있습니다: users.example.com, api.external.example.com, checkout.example.com. 이 각각의 호스트 이름에 HTTPS를 구성하려 합니다. 이런 작업을 위해서는 ALB를 어떻게 구성해야 할까요?

1.HTTP를 HTTPS로 리다이렉팅하는 규칙 사용

2.보안 그룹 SSL 인증서 사용

3.서버 이름 표식(SNI)사용

서버 이름 표식(SNI)을 사용하면 동일한 리스너 상에 있는, 자체 SSL 인증서를 가진 다수의 HTTPS 애플리케이션을 노출시킬 수 있습니다. 더 많은 정보는 여기를 참고하세요: https://aws.amazon.com/blogs/aws/new-application-load-balancer-sni/

51.원하는 용량과 최대 용량을 모두 3으로 구성한 오토 스케일링 그룹에 의해 관리되고 있는, 한 세트의 EC2 인스턴스에 호스팅된 애플리케이션이 있습니다. 또한, CPU 사용률이 60%에 이르면 ASG를 스케일 아웃하도록 구성된 CloudWatch 경보도 생성해 뒀습니다. 해당 애플리케이션은 현재 갑자기 많은 양의 트래픽을 전송 받아 80% CPU 사용률에서 실행되고 있는 상태입니다. 이런 경우, 무슨 일이 일어나게 될까요?

1.아무 일도 일어나지 않음

2.희망 용량은 4까지 올라가는 반면, 최대 용량은 3에 머뭄

3.희망 용량은 4까지 올라가는 반면, 최대 용량은 4에 머뭄

오토 스케일링 그룹은 스케일 아웃 시, (구성된) 최대 용량을 넘어설 수 없습니다.

52.Application Load Balancer가 관리하는 오토 스케일링 그룹이 있습니다. ASG가 ALB 상태 확인을 사용하도록 구성을 해둔 상태인데, EC2 인스턴스가 비정상인 것으로 보고되었습니다. EC2 인스턴스에는 무슨 일이 일어나게 될까요?

1.ASG가 인스턴스는 계속 실행하되, 애플리케이션은 재시작할 것

2.ASG가 EC2인스턴스를 분리하고 실행 상태로 둘 것

3.ASG가 EC2인스턴스를 종료할 것

오토 스케일링 그룹이 EC2 상태 확인(기본 설정)이 아닌 Application Load Balancer의 상태 확인을 기반으로 EC2 인스턴스의 상태를 판단하도록 구성할 수 있습니다. EC2 인스턴스가 ALB의 상태 확인에 실패할 경우, 이는 비정상인 것으로 표시되어 종료되며 ASG는 새로운 EC2 인스턴스를 실행합니다.

53.여러분의 상사가 애플리케이션이 데이터베이스로 보내는 분당 요청 수를 기반으로 오토 스케일링 그룹을 스케일링하라고 요청했습니다. 어떻게 해야 할까요?

1.CloudWatch 사용자 지정 지표를 생성한 후 ASG를 스케일링하기 위한 CloudWatch 경보 생성

2.불가능한 작업이라고 공손히 설명해 주기

3.상세 모니터링을 활성화한 후 ASG스케일링을 위한 CloudWatch 경보 생성하기

백엔드-데이터베이스 연결에는 ‘분당 요청'에 해당하는 CloudWatch 지표가 존재하지 않습니다. CloudWatch 경보를 생성하려면 CloudWatch 사용자 지정 지표를 먼저 생성해야 합니다.

54.한 애플리케이션이 애플리케이션 로드 밸런서(ALB)와 오토 스케일링 그룹(ASG)을 통해 배포되었습니다. 이 상태에서 ASG의 크기를 수동으로 조정해 EC2 인스턴스의 평균 연결 개수가 약 1,000개가 되도록 조정 정책을 정의하려고 합니다. 어떤 조정 정책을 사용해야 합니까?

1.단순 조정 정책

2.단계 조정 정책

3.대상 추적 조정 정책

4.예약된 조정 정책

ALB만이 EC2 인스턴스로 액세스할 수 있게 할 수 있는 가장 안전한 방법입니다. 규칙에서 보안 그룹을 참조하는 것은 매우 강력한 규칙으로, 이 내용을 바탕으로 많은 시험 문제가 출제됩니다. 그러니 이에 관련된 내용은 반드시 숙지하도록 하세요!(3)

55.오토 스케일링 그룹(ASG)과 네트워크 로드 밸런서로 구성된 환경이 있습니다. ASG에 있는 애플리케이션은 HTTP 프로토콜을 지원하고 로드 밸런서 상태 확인(Health Check)을 사용하도록 설정돼 있습니다. 다음 중 현재 사용하고 있는 TCP 상태 확인을 HTTP 상태 확인으로 변경하는 방법은 무엇입니까?

1.로드 밸런서 애플리케이션 로드 밸런서로 변경한다.

2.상태 확인 방식을 HTPP로 변경한다.

NLB는 TCP, HTTPS 및 HTTP 상태 확인을 지원합니다.(2)

56.한 웹 사이트가 애플리케이션 로드 밸런서 뒤에 있는 오토 스케일링 그룹의 EC2 인스턴스에서 호스팅되고 있습니다. 현재 HTTP로 서비스 중인 웹 사이트를 HTTPS로 바꾸는 작업을 진행하고 있습니다. ACM 인증서를 발급받아 애플리케이션 로드 밸런서에 적용한 상태입니다. 사용자들이 HTTP가 아닌 HTTPS를 사용해 웹 사이트에 접속하게 하려면 어떻게 해야 합니까?

1.모든 고객에게 HTTPS 대신 HTTP를 사용하라는 이메일을 보낸다.

2.애플리케이션 로드 밸런서가 HTTP를 HTTPS로 리디렉션하도록 설정한다.

3.DNS 레코드가 HTTP를 HTTPS로 리디렉션하도록 설정한다.

2

57.아마존 RDS가 지원하지 않는 데이터베이스 를 선택하세요.

1.몽고DB

2.MYSQL

3.마리아DB

4.Microsoft SQL 서버

RDS는 MySQL, PostgreSQL, MariaDB, Oracle, MS SQL Server, Amazon Aurora를 지원합니다.

58.한 가지 용도로 상황이 발생하지 않도록 유지하면서 MySQL 데이터베이스를 사용할 수 있도록 하기 위해 새로운 솔루션을 계획하고 있습니다. 무엇을 해야 할까요?

1.분류해 복제 생성

2.활동 활성화

3.다중 AZ 활성화

다수 AZ는 전체 AZ가 의심되는 경우의 재난 복구를 계획하는 데 도움이 됩니다. 전체 AWS 리전이 유사한 경우에 대비해 계획을 세울 때, AWS 리전 예비 백업과 사본을 보내드립니다.

59.RDS 데이터베이스가 웹사이트에서 요청량을 처리하는 데 어려움을 겪고 있습니다. 백만 명의 사용자가 대부분의 뉴스를 이해하는 경우, 뉴스가 자주 나타나는 편은 아닙니다. 이 문제를 해결하기 위해 사용하기에 적합한 솔루션이 무엇입니까?

1.ElasiCache 설치

2.RDS 다중 AZ

3.RDS 선두 복제본

시험을 관련하여 주의하시기 바랍니다. 이 문제에서는 이러한 문제를 해결하기 위해 사용자가 "안 되는" 것이 무엇인지 묻고 있습니다. ElastiCache RDS 순위표 복제본은 규모 조정에 도움이 됩니다.(2)

60.RDS 데이터베이스에 보고된 복제본을 설정해 두었지만, 복구 미디어 포스트를 업데이트할 시 업데이트가 바로 존재하는 것에 대해 사용자가 불만을 토로하고 있습니다. 이 경우, 가능성이 있는 이유는 무엇일까요?

1.사유에 버그가 존재함

2.숫자는 복제된 복제를 선택하며, 사용자는 일관성 있게만 복제할 수 있습니다.

3.그 대신에 AZ를 설정해야 합니다.

이 경우에는 사용자가 올바른 복제본을 선택하고, 선택한 복제본이 일관성 있게 업데이트되도록 하는 것이 해결책이 될 것입니다.-GPT 답변(2)

61.다음 RDS (Aurora) 기능들 중, 사용 시 SQL 연결 문자열을 변경하지 않으려는 것은 무엇입니까?

1.다중AZ

2.분류해 복제

다수의 AZ는 활성화 상태의 데이터베이스 종류와 성과가 동일하게 비슷한 연결을 유지합니다.

다중AZ를 사용하면 Amazon Aurora 데이터베이스의 고가용성을 향상시킬 수 있습니다. 이 기능을 활성화하면 프라이머리 데이터베이스와 동일한 가용 영역에 대기 중인 스탠바이 데이터베이스가 생성되어 장애 발생 시 자동으로 전환됩니다. 이 경우 SQL 연결 문자열을 변경할 필요가 없습니다.

62.이 기능은 Application Load Balancer가 관리하는 오토 스케일링 그룹에서 관리하는 EC2를 활용하는 플릿에서 실행되고 있습니다. 사용자들이 계속 재로그인을 원하지 않는 상황이지만, 일부 EC2에만 국한되지 않을 수도 있다고 생각에 고정 세션은 활성화되지 않습니다. 어떻게 해야 할까요?

1.EC2에 있어 ALB가 아닌 자체 맞춤형 로드 밸런서 사용하기

2.세션 데이터를 RDS에 저장하기

3.세션 데이터를 ElastiCache에 저장하기

4.세션 데이터를 공유하여 EBS볼륨을 저장하기

세션 데이터를 ElastiCache에 저장하는 방법은 서로 다른 EC2가 필요하기 때문에 사용자의 상태를 회수할 수 있기 때문에 사용하는 경우가 많습니다.

63.현재 어떤 분석 기능이 주요 특징으로 RDS 데이터베이스에 대한 쿼리를 수행하고 있습니다. 이러한 쿼리는 언제든지 실행되어 RDS 데이터베이스의 성능을 저하시키고 사용자 환경에 영향을 미치게 됩니다. 사용자 환경을 종료하려면 어떻게 해야 할까요?

1.정체성 복제 설정

2.다수의 AZ 설정

3.밤에 분석 쿼리 실행

즐겨찾는 복제본을 설정하면 분석이 쿼리를 수행할 수 있고, 이 쿼리가 주요 참여 RDS 데이터베이스에는 영향을 미치기 때문에 도움이 되지 않습니다.

64.주 AWS 리전에 데이터베이스의 복사본을 만들어 두어려주도록 했습니다. 이러한 작업을 쉽게 구현하기 위해서는 실제 데이터베이스의 사용을 권장할 수 있습니까?

1.RDS 선두 복제본

2.RDS 다중 AZ

3.오로라 순위 복제

4.오로라 글로벌 데이터베이스

Aurora 데이터베이스를 사용하면 최대 5개의 2차까지 Aurora 복제본을 가질 수 있습니다.

65.사용자들이 연결될 때, ElastiCache Redis 클러스터의 보안을 보관하도록 하여 포스트를 입력하도록 하시겠습니까?

1.Redis 인증 사용하기

2.IAM 정품 사용하기

3.보안그룹 사용하기

Redis 클러스터에 연결할 때 인증을 사용하는 것은 보안을 강화하는 좋은 방법 중 하나입니다. Redis는 비밀번호를 통한 간단한 인증을 제공하므로, 올바른 비밀번호를 갖춘 사용자만이 클러스터에 접근할 수 있습니다.

66.여러분이 일하는 기업은 RDS MySQL 5.6을 데이터베이스로 사용하는 Node.js 기능을 갖추고 있습니다. Java로 프로그래밍하는 새로운 기능은 대시보드 생성을 위해 많은 양의 분석 워크로드를 수행할 것입니다. 이 경우, 주요 업무에 발생하는 지장을 돕기 위해 보존할 수 있는 방법 중 가장 비용 효율적인 솔루션은 무엇입니까?

1.RDS 데이터베이스에 AZ를 활성화하고 대기 데이터베이스에서 분석 워크로드 실행하기

2.다른 AZ에 읽기 본제본을 생성하고 데이터베이스의 복제본에 분석 로드 실행하기

3.다른 AZ에 읽기 복제를 생성하고 소스 데이터베이스에 분석 워크로드 실행하기

읽기 전용 복제본을 사용하여 분석 워크로드를 처리하면서, Multi-AZ 설정을 사용하여 고가용성을 유지할 수 있습니다.(2)

67.RDS PostgreSQL 데이터베이스의 특정 리전에서 중단이 발생했을 때 데이터베이스가 신속하게 다른 AWS 리전에서 이해 작업을 할 수 있도록 할 수 있도록 복구 전략을 시도하겠습니다. DR 데이터베이스는 가용성이 매우 높아야 합니다. 가장 선호하는 방식은 무엇입니까?

1.공유하기 전에 복제를 생성하여 메인데이터베이스에서 AZ를 활성화합니다.

2.다른 서두에 있는 복제물을 구성하는 것은 앞서 말한 복제물에서 다수의 AZ를 활성화한다.

3.공유하기 전에 복제를 구성하는 것은 중요 복제에서 다수의 AZ를 활성화한다.

4.데이터베이스 메인에서 멀티 리전(Multi-Region)설정을 활성화합니다.

일반적으로는 여러 리전 간에 데이터베이스를 복제하고, DR용 데이터베이스를 두는 방식이 고가용성을 최대화하면서 안정적인 복구를 가능케 하는 방법입니다.(2)

68.사무실(On-premise)에서 관리하는 MySQL 데이터베이스를 RDS로 연결합니다. 데이터베이스와 복잡한 기능과 개발자가 매우 많은 상태입니다. 모든 개발자는 회사의 AWS 계정에 IAM 사용자로 등록되어 있습니다. 모든 개발자에 대해 DB 사용자를 생성하지 않고 MySQL RDS DB에 액세스할 수 있다고 하면 가장 적절한 방법은 무엇입니까?

1.IAM 사용자는 기본적으로 RDS데이터베이스에 접근할 수 있습니다.

2.Amazon Cognito를 사용합니다.

3.IAM데이터베이스 인증을 활성화합니다.

IAM 데이터베이스 인증은 AWS Identity and Access Management (IAM)을 사용하여 MySQL RDS 데이터베이스에 대한 인증을 관리하는 방법입니다. 이를 통해 개발자들은 별도의 MySQL 데이터베이스 사용자를 생성하지 않고도 IAM 사용자 자격 증명을 통해 RDS에 액세스할 수 있습니다.

이 방법을 사용하면 개발자가 IAM 사용자로 등록되어 있으면 해당 IAM 사용자의 IAM 역할을 사용하여 MySQL RDS에 연결할 수 있습니다. MySQL RDS에 대한 액세스 권한은 IAM 역할 정책에 설정되며, 개발자는 IAM 자격 증명을 사용하여 RDS에 로그인할 수 있습니다.

69.다음 중 RDS 분류 복제와 다중 AZ로의 복제 작업을 적절하게 설명하는 설명은 무엇입니까?

1.주요 이점은 복제를 사용하고, 다수의 AZ도 복제를 사용함

2.다수의 복제는 복제를 사용하고, 다수의 AZ는 혼합 복제를 사용합

3.선호하는 복제는 혼합 복제를 사용하고, 다수의 AZ도 혼합 복제를 사용함

4.주요 선호 복제는 혼합 복제를 사용하고, 다수의 AZ는 복제를 사용함

"다수의 AZ는 혼합 복제를 사용함"은 다중 가용 영역(Multi-AZ) 설정에서 혼합 복제를 사용한다는 것을 의미합니다. 이는 주 데이터베이스와 다중 AZ에 있는 복제본 간에 비동기 복제를 사용하여 가용성을 높이는 방식입니다(2)

70.플러그인되지 않은 RDS DB 파일을 플러그인하는 방법은 무엇입니까?

1.AWS 콘솔에서 RDS DB를 제외하고 고른 후, Actions를 선택하며느 바로 KMS를 잡을 수 있습니다.

2.RDS DB중단을 중단한 후, AWS 콘솔에서 바로 가능

3.플러그인되지 않은 RDS DB의 스냅샷을 생성하고, 스냅샷을 복사해 '암호화 활성화하기' 상자를 체크한 뒤, RDS DB에 포함되지 않은 스냅샷 복구하기

3

71.RDS 데이터베이스를 위해 최대 .............개의 고유한 복제본을 가질 수 있습니다.

1.3

2.7

3.15

3

72.다음 중 IAM을 활용한 웹 서버 인증을 지원하지 않는 RDS 데이터베이스 기술은 무엇입니까?

1.신탁

2.포스트그레SQL

3.MYSQL

IAM 기반의 인증은 RDS MySQL 및 RDS PostgreSQL에서 사용할 수 있지만, RDS 신탁(Oracle Database)에서는 지원되지 않습니다.

73.캡슐화되지 않은 RDS DB가 있는 상태에서 복제된 복제본이 생성되었습니다. RDS 정당한 복제본을 구성할 수 있도록 구성할 수 있습니까?

1.아니오

2.예

플러그인되지 않은 RDS DB에는 플러그인된 복제본을 생성할 수 없습니다.

74.강제로 실행 중인 클러스터를 데이터베이스로 사용하고 있습니다. 여러분의 개발 팀은 많은 양의 워크로드를 수행할 수 있는, 규모를 축소한 디자인에서 디자인 버전을 실행하는 경우가 많습니다. 작동은 대부분의 시간 동안 사용됩니다. CIO는 여러분에게 시각을 배려하는 동시에 팀을 해 줄 것을 요청했습니다. 어떤 방법을 사용하면 될까요?

1.Aurora 글로벌 데이터베이스 사용하기

2.RDS 데이터베이스 사용하기

3.Aurora 서버를 사용하기

4.EC2에 Aurora를 실행하고, EC2인증이 밤에 승인받고 읽기 작성하기

Aurora Serverless

실제 사용량이 기반하여 자동으로 데이터베이스 인스턴스화 및 자동 스케일링이 이루어짐.

비정기적, 간헐적, 또는 예측할 수 없는 워크로드에 적합함.

용량 계획이 필요하지 않음.

초당 결제로 인해 더 경제적일 수 있음.

75.하나의 Aurora DB 클러스터는 여러 개의 Aurora 그룹을 복제할 수 있습니까?

1.5

2.10

3.15

3

76.Amazon Aurora는 ..........................데이터베이스를 모두 지원합니다.

1.MYSQL과 MariaDB

2.MYSQL과 PostgreSQL

3.Oracle과 MariaDB

4.Oracle과 MS SQL서버

Postgres와 MySQL이 호환됨.

77.여러분은 게임 개발업체에서 아키텍트로 근무하고 있습니다. 하나의 게임에서, 고대 점수를 기반으로 플레이어들의 순위를 매겨야 합니다. 여러분의 영역이 게임 리더보드 생성을 위해 기꺼이 고가용적인 솔루션을 설계해 구현하는 것을 요청했습니다. 무엇을 해야 할까요?

1.MYSQL에 RDS사용

2.아마존 오로라 사용

3.캐멤시트에 ElasriCache사용

4.Redis에 ElastiCache사용 - 선택되지 않은 설정

게임 리더보드 생성은 매우 복잡함.

Redis의 Sorted sets는 고유성과 요소 순서를 모두 보장함.

새로운 요소가 추가될 때마다 실시간으로 순위가 매겨진 다음 올바른 순서로 추가됨.

78.AWS 기반 작업 데이터베이스의 완전한 커스터마이징이 필요합니다. AWS 서비스 사용의 이점을 누릴 수 있는 장점이 있습니다. 어떤 것을 추천하는가?

1.업무용 RDS

2.업무용 RDS 맞춤형

3.EC2에 작업 배포

RDS Custom: Oracle과 Microsoft SQL Server에서만 사용 가능, 기저 운영 체제와 데이터베이스에 대한 관리자 권한 전체를 가짐.(2)

79.재해 복구 및 감사 목적으로 Aurora 데이터베이스에 대한 장기 백업을 저장해야 합니다. 어떤 것을 추천하는가?

1.자동 백업 활성화

2.온디맨드 백업활동

3.Aurora 데이터베이스 복제 사용

3

80.여러분의 개발팀은 데이터에 최대한 빨리 액세스해야 하기 때문에 Aurora 데이터베이스에 대해 읽기 및 테스트를 수행하고자 합니다. 어떤 분들을 도와주실 건가요?

1.이는 Aurora 데이터베이스 복제본 만들기

2.데이터베이스에 대해 테스트 수행

3.DB스냅샷을 만들어 새 데이터베이스로 복원하기

4.오로라 복제 기능 사용

Aurora는 다중 마스터 및 읽기 전용 복제를 지원하므로, 원본 데이터베이스와 동기화된 읽기 전용 복제본을 생성하여 읽기 작업을 분산시킬 수 있습니다. 이는 효과적인 테스트 환경을 구성하는 데 도움이 됩니다.

81.RDS 데이터베이스에 100개의 EC2를 제외하고 연결되지 않은, 유지 관리 시 응용 구조가 정말 모든 데이터베이스의 RDS에 다시 연결되는 데 많은 시간이 허락하는 것을 확인했습니다. 이 문제를 어떻게 개선할 수 있는지?

1.모든 것을 구성하다

2.다수의 AZ채용

3.다중 AZ활성화

4.RDS 앱 사용

4

82.여러분은 Amazon Route 53 Registrar를 위해 mycoolcompany.com를 구매했으며, 이 도메인이 Elastic Load Balancer인 my-elb-1234567890.us-west-2.elb.amazonaws.com를 가리키게끔 하려 합니다. 이런 경우, 다음 중 어떤 Route 53 레코드 유형을 사용해야 할까요?

1.CNAME

2.별칭

Route 53에서 별칭 레코드를 사용하면 ELB의 DNS 주소를 직접 지정할 수 있습니다.

83.새로운 Elastic Beanstalk 환경을 배포한 상태에서, 5%의 프로덕션 트래픽을 이 새로운 환경으로 다이렉트하려 합니다. 이를 통해 CloudWatch 지표를 모니터링하여, 새로운 환경에 있는 버그를 제거할 수 있게 됩니다. 이런 작업을 위해서는 다음 중 어떤 Route 53 레코드 유형을 사용해야 할까요?

1.단순

2.가중치 기반

3.지연 시간

4.장애 조치

가중치 기반 라우팅 정책을 사용하면 가중치(예: 백분율)를 기반으로 트래픽의 일부를 리다이렉트할 수 있습니다. 트래픽의 일부를 애플리케이션의 새로운 버전으로 보내는 방식은 흔히 사용되는 방식입니다.

84.Route 53 레코드의 myapp.mydomain.com 값이 새로운 Elastic Load Balancer를 가리키도록 업데이트를 했는데도 불구하고, 사용자들은 여전히 기존의 ELB로 리다이렉트 되고 있는 상태입니다. 이런 경우, 가능성이 있는 원인은 무엇일까요?

1.별칭 레코드 때문

2.CNAME 레코드 때문

3.TTL 때문

4.Route 53 상태 확인 때문

각 DNS 레코드는 클라이언트들이 이러한 값들을 캐시할 기간을 지정하고 DNS 요청으로 DNS 리졸버에 과부하를 일으키지 않도록 지시하는 TTL(타임 투 리브)을 갖습니다. TTL 값은 값을 캐시해야 하는 기간과 DNS 리졸버로 들어가야 하는 요청의 수 사이의 균형을 유지할 수 있도록 설정되어야 합니다.

85.두 AWS 리전, us-west-1 및 eu-west-2에 호스팅 된 애플리케이션이 있습니다. 애플리케이션 서버의 사용자에 대한 응답 시간을 최소화하여, 사용자들에게 최상의 사용자 경험을 제공하려 합니다. 이 경우, 다음 중 어떤 Route 53 라우팅 정책을 사용해야 할까요?

1.다중 값

2.가중치 기반

3.지연 시간

4.지리적 위치

지연 시간 라우팅 정책은 사용자와 AWS 리전 사이에서 발생하는 지연 시간을 평가하여 지연 시간(예: 응답 시간)을 최소화할 수 있는 DNS 응답을 수신할 수 있게 해줍니다.

86.프랑스를 제외한 국가에 있는 사람들이 여러분의 웹사이트로 액세스해서는 안 된다는 법적 요구 사항이 있습니다. 이 경우, 다음 중 어떤 Route 53 라우팅 정책을 사용해야 할까요?

1.지연 시간

2.단순

3.다중 값

4.지리적 위치

지리적 위치 라우팅을 사용하면 특정 지역 또는 국가에 대한 트래픽을 특정 리전으로 라우팅할 수 있습니다

87.GoDaddy를 위해 도메인을 구매했으며, Route 53을 DNS 서비스 제공자로 사용하려 합니다. 이를 위해서는 어떤 작업을 수행해야 할까요?

1.도메인 전환 요청하기

2.사설 호스팅 영역을 생성하고 타사 Registrar NS 레코드 업데이트 하기

3.공용 호스팅 영역을 생성하고 Route 53 NS 레코드 업데이트 하기

4.공용 호스팅 영역을 생성하고 타사 Registrar NS 레코드 업데이트 하기

공용 호스팅 영역은 인터넷을 통해 웹사이트로 요청을 보내는 사람들이 사용할 것을 전재하고 있습니다. 마지막으로, NS 레코드는 타사 Registrar에 업데이트되어야 합니다.

88.다음 중 유효한 Route 53 상태 확인이 아닌 것을 고르세요.

1.SQS 대기열 모니터링하는 상태 확인

2.엔드 포인트를 모니터링하는 상태 확인

3.다른 상태 확인을 모니터링하는 상태 확인

4.CloudWatch 경보를 모니터링하는 상태 확인

"SQS 대기열 모니터링하는 상태 확인"은 유효한 Route 53 상태 확인이 아닙니다. Route 53은 DNS와 관련된 서비스로서, SQS (Simple Queue Service) 대기열이나 다른 AWS 서비스를 직접 모니터링하지 않습니다. Route 53 상태 확인은 주로 엔드 포인트, 다른 상태 확인, 또는 CloudWatch 경보 등을 모니터링하는 데 사용됩니다.

89.웹사이트 TriangleSunglasses.com는 Application Load Balancer가 관리하는 오토 스케일링 그룹에서 관리 중인 EC2 인스턴스 플릿에 호스팅되어 있습니다. ASG는 웹사이트로 들어가는 트래픽을 온디맨드 기반으로 스케일링하도록 구성되었습니다. 비용 절감을 위해, ASG가 ALB로 통하는 트래픽을 기반으로 스케일링을 하도록 구성해 둔 상태입니다. 솔루션의 고가용성을 보장하기 위해, ASG를 업데이트하고 최소 용량을 2로 설정했습니다. 요구 사항을 충족시키되, 비용을 더욱 절감하려면 어떤 작업을 해야 할까요?

1.ALB를 제거하고 탄력적 IP를 대신 사용하기

2.두 개의 EC2인스턴스 예약하기

3.최소 용량 1로 줄이기

4.최소 용량 0으로 줄이기

어떤 상황이건 2개의 EC2 인스턴스를 실행하면 추가적인 비용을 절감할 수 있습니다.

90.다음 중 "무상태" 애플리케이션 티어를 설계하는 데에 도움이 되지 않는 것을 고르세요.

1.세션 데이터를 Amazon RDS에 저장하기

2.Amazon ElastiCache에 세션 데이터 저장하기

3.클라이언트 HTTP 쿠키에 세션 데이터 저장하기

4.EBS 볼륨에 세션 데이터 저장하기

"무상태" 애플리케이션 티어는 세션 상태를 애플리케이션 서버에서 유지하지 않고 외부 저장소 또는 클라이언트에 저장하여 수행됩니다.

EBS 볼륨은 특정 AZ에 저장되며, 한 번에 하나의 EC2 인스턴스에만 연결될 수 있습니다.

91.관리 중인 Linux EC2 인스턴스 100s에 소프트웨어 업데이트를 설치하려 합니다. 이 업데이트를 EC2 인스턴스로 동적으로 로딩되어야 하며, 많은 양의 연산을 요구해서는 안 되는 공유 스토리지에 저장하고자 합니다. 어떤 방법을 사용해야 할까요?

1.EBS에 소프트웨어 업데이트를 저장하고 각 AZ의 한 마스터로부터 데이터 복제 소프트웨어를 사용해 동기화하기

2.EFS에 소프트웨어 업데이트를 저장하고 스타트업 시 EFS를 네트워크 드라이브로 마운트하기

3.소프트웨어 업데이트를 EBS 스냅샷으로 패키징하고 새로운 소프트웨어 업데이트 각각에 EBS 볼륨 생성하기

4.Amazon RDS에 소프트웨어 업데이트 저장하기

EFS는 EC2 인스턴스의 100s에 동일한 파일 시스템을 마운트할 수 있게 해주는 네트워크 파일 시스템(NFS)입니다. EFS에 소프트웨어 업데이트를 저장하면 각 EC2 인스턴스가 이들을 평가할 수 있게 됩니다.

EFS는 여러 인스턴스 간에 파일을 공유하고, 파일 시스템을 마운트하는데에 있어서 간단한 설정만 필요하므로 연산 부하가 적을 수 있습니다.

92.솔루션 아키텍트로서, 여러분은 복잡한 ERP 소프트웨어 스위트를 AWS Cloud로 이전하려 합니다. 오토 스케일링 그룹이 관리하는 한 세트의 Linux EC2 인스턴스에 소프트웨어를 호스팅할 계획입니다. 소프트웨어가 Linux 기기를 준비하는 데에는 보통 한 시간 이상이 걸립니다. 스케일 아웃이 발생할 경우, 설치 과정을 빠르게 만들기 위해서는 어떤 방법을 추천할 수 있을까요?

1.Golden AMI사용

2.EC2 사용자 데이터를 이용해 부트스트랩

3.Amazon RDS에 애플리케이션 저장

4.EFS로부터 애플리케이션 설치 파일 회수

Golden AMI는 설치되고 구성된 전체 소프트웨어를 포함한 이미지이기 때문에, 향후 이 AMI로부터 EC2 인스턴스를 빠르게 부팅할 수 있습니다.

93.애플리케이션을 개발 중에 있으며, 최소 비용을 사용해 이 애플리케이션을 Elastic Beanstalk으로 배포하려 합니다. 이를 위해서는, 애플리케이션을 .................. 에서 실행해야 합니다.

1.단일 인스턴스 모드

2.고가용성 모드

문제에서 애플리케이션이 아직 개발 단계에 있으며 비용을 절감하고자 한다고 언급하고 있습니다. 단일 인스턴스 모드는 하나의 EC2 인스턴스와 하나의 탄력적 IP를 생성합니다.

94.애플리케이션을 Elastic Beanstalk으로 배포하던 도중, 배포 프로세스가 극도로 느리다는 것을 알게 되었습니다. 로그를 검토한 결과, 종속성이 매 배포 당 각 EC2 인스턴스로 리졸브된다는 사실을 발견했습니다. 영향을 최소화하면서 배포 프로세스를 빠르게 하려면 어떻게 해야 할까요?

1.코드에서 일부 종속성을 제거

2.종속성을 Amazon EFS에 두기

3.종속성을 포함하는 Golden AMI를 생성해 그 이미지를 EC2인스턴스 실행에 사용

Golden AMI는 전체 소프트웨어, 종속성 및 구성을 포함하는 이미지이기 때문에, 향후 이 AMI로부터 EC2 인스턴스를 빠르게 부팅할 수 있습니다.

95.25GB 크기의 파일을 S3에 업로드하려 시도 중이지만, 오류가 발생하고 있습니다. 이 경우, 가능성이 있는 원인은 무엇일까요?

1.S3의 파일 크기 제한이 5GB임

2.요청된 AWS 리전의 S3서비스가 차단된 상태

3.5GB보다 크기가 큰 파일을 업로드할 때는 멀티파트 업로드를 사용함

파일 크기가 100MB가 넘는 경우에는 멀티파트 업로드가 권장됩니다.

96.dev라는 이름의 새로운 S3 버킷을 생성하려 하던 중 오류가 발생했습니다. S3 버킷이 생성된 적이 없는 새로운 AWS 계정을 사용 중입니다. 이 경우, 가능성이 있는 원인은 무엇일까요?

1.S3버킷 생성에 필요한 IAM권한의 부재

2.S3버킷 이름은 전역에서 고유해야 하며 deV는 이미 사용 중임

2

97.이미 많은 파일을 포함하고 있는 S3 버킷에 버전 관리를 활성화한 상태입니다. 기존의 파일은 다음 중 어떤 버전을 가지고 있을까요?

1.1

2.0

3.-1

4.null

4

98.S3 버킷 정책을 업데이트해 IAM 사용자들이 S3 버킷 내의 파일을 읽기/쓰기할 수 있도록 허가했으나, 한 명의 사용자가 PutObject API 호출을 수행할 수 없다며 불만을 토로하고 있습니다. 이 경우, 가능성이 있는 원인은 무엇일까요?

1.S3버킷 정책에 문제가 있음

2.사용자에게 권한이 없음

3.연결된 IAM정책 내에 이 사용자를 부인하는 사항이 명시되어 있음

4.AWS 지원 센터에 연락해 문제를 해결해 줄 것을 요청해야 함

IAM 정책 내의 명시적인 부인(DENY)은 S3 버킷 정책보다 우선적으로 고려됩니다.

99.S3 버킷에 있는 콘텐츠를 다른 AWS 리전에서 완전히 가용할 수 있게 만들려고 합니다. 이는 팀원들이 적은 대기 시간과 비용으로 데이터 분석을 수행하는 데 도움이 됩니다. 이런 경우에 사용해야 하는 S3 기능은 무엇입니까?

1.Amazon CloudFront 배포

2.S3버전 관리

3.S3정적 웹 사이트 호스팅

4.S3 복제

S3 복제를 사용하면 S3 버킷에 있는 데이터를 동일한 또는 다른 AWS 리전으로 복제할 수 있습니다.

100.S3 버킷이 3개 있습니다. 하나는 원본 버킷 A이고, 나머지 둘은 대상 버킷 B와 C입니다. 버킷 A에 있는 객체를 버킷 B와 C 양쪽 모두에 복제하려고 합니다. 어떻게 구성해야 합니까?

1.버킷 A에서 B로 복제하고, 버킷 A에서 C로 복제하도록 설정한다.

2.버킷 A에서 B로 복제하고, 버킷 B에서 C로 복제하도록 설정한다.

3.버킷 A에서 C로 복제하고, 버킷 C에서 B로 복제하도록 설정한다.

1

101.다음 중 Glacier 딥 아카이브 검색 모드가 아닌 것은?

1.긴급(1~5분)

2.표준(12시간)

3.대량(48시간)

1

102.다음 중 Glacier 유연 검색 모드가 아닌 것은?

1.즉시(10초)

2.긴급(1~5분)

3.표준(3~5시간)

4.대량(5~12시간)

1

103.어떤 방법을 사용해야 S3 버킷으로 객체가 업로드되었음을 알 수 있을까요?

1.S3 Select

2.S3 액세스 로그

3.S3 이벤트 알림

4.S3 분석

S3 이벤트 알림은 버킷에서 발생하는 이벤트에 대한 알림을 구성하는 데 사용됩니다. 객체 업로드는 S3 이벤트 중 하나이며, Lambda 함수, SQS 대기열 또는 SNS 주제와 같은 대상에게 알림을 보낼 수 있습니다.

104.S3 버전 관리가 활성화된 S3 버킷이 있습니다. 이 S3 버킷은 여러 객체를 지니고 있으며, 비용 절감을 위해 오래된 버전을 삭제하려 합니다. 오래된 객체 버전의 삭제를 자동화하기 위해서 사용할 수 있는 최선의 방법은 무엇인가요?

1.S3 수명 주기 규칙 - 만료 조치

2.S3 수명 주기 규칙 - 전환 조치

3.S3 액세스 로그

1

105.서로 다른 티어 간의 S3 객체 전환을 자동화하기 위해서는 어떻게 해야 할까요?

1.AWS Lambda

2.CloudWatch Events

3.S3 수명 주기 규칙

S3 수명 주기 규칙은 객체의 수명 주기를 관리하고, 객체를 자동으로 다른 스토리지 클래스로 이동시키거나 삭제하는 데 사용됩니다.

106.멀티파트 업로드를 사용해 S3 버킷으로 크기가 큰 파일을 업로드하던 도중, 네트워크 문제로 인해 완료되지 않은 부분의 상당량이 S3 버킷에 저장되었습니다. 완료되지 않은 부분은 불필요하며, 여러분의 비용을 소모합니다. 완료되지 않은 부분을 삭제하기 위해 사용할 수 있는 최적의 접근법은 무엇인가요?

1.AWS Lambda로 오래된/완료되지 않은 각 부분을 루프하여 삭제

2.AWS 지원 센터에 오래된/완료되지 않은 부분을 삭제해 줄 것을 요청

3.S3수명 주기 정책을 사용해 오래된/완료되지 않은 부분의 삭제를 자동화

S3 수명 주기 정책을 설정하면 여러분이 정의한 조건에 따라 객체를 자동으로 관리할 수 있습니다. 이 정책을 사용하면 완료되지 않은 멀티파트 업로드의 부분들을 자동으로 삭제할 수 있습니다. 주로 완료되지 않은 부분은 특정 시간 동안 보존되므로 수명 주기 정책을 활용하여 이를 자동으로 삭제할 수 있습니다.

107.S3 수명 주기 규칙에 대한 추천 사항을 찾고 있습니다. 서로 다른 스토리지 계층 간의 객체 이동에 필요한 최적의 일수는 어떻게 분석할 수 있을까요?

1.S3인벤토리

2.S3분석

3.S3수명 주기 규칙 관리자

S3 분석은 S3 버킷의 액세스 패턴 및 통계에 대한 분석 정보를 제공합니다. 특히, S3 분석을 사용하면 객체의 최근 액세스 패턴을 이해하고, 이를 기반으로 객체를 특정 스토리지 클래스로 전환하기 위한 최적의 수명 주기 규칙을 결정할 수 있습니다.

108.Amazon RDS PostgreSQL을 사용하여 S3에 파일의 인덱스를 구축하려 합니다. 인덱스 구축을 위해서는 파일 콘텐츠 자체의 메타데이터를 포함하고 있는 S3에 있는 각 객체의 첫 250바이트를 읽는 작업이 필수적입니다. S3 버킷에는 총 50TB에 달하는 100,000개 이상의 파일이 포함되어 있습니다. 이 경우 인덱스를 구축하기 위한 효율적인 방법은 무엇일까요?

1.RDS 가져오기 기능을 사용해 S3로부터 PostgreSQL로 데이터를 로드하고, SQL 쿼리를 실행해 인덱스 구축하기

2.S3버킷을 트래버스하고, 파일을 하나씩 읽어 들여 첫 250바이트를 추출한 후, RDS에 해당 정보를 저장하는 애플리케이션 생성

3.S3버킷을 트래버스하고, 첫 250바이트에 대한 바이트 범위 패치를 발행한 후, RDS에 해당 정보를 저장하는 애플리케이션 생성

4.S3버킷을 트래버스하고, S3 Select를 사용해 첫 250바이트를 얻은 후, RDS에 해당 정보를 저장하는 애플리케이션 생성하기

S3 버킷에 있는 객체들을 하나씩 읽어오며, 그 중에서 각 객체의 처음 250바이트를 추출하여 RDS에 저장하는 애플리케이션을 만든다는 의미(3)

이 방법은 S3 객체의 첫 250바이트를 효율적으로 추출할 수 있도록 S3의 Range GET 요청을 사용하며, 그 정보를 RDS에 저장하는 방식입니다. S3 Select는 전체 객체의 내용을 분석하므로, 객체의 크기가 크면 효율성이 떨어질 수 있습니다.

109.S3 버킷으로 업로드하려는 대규모의 데이터셋이 온프레미스로 저장되어 있습니다. 이 데이터셋은 10GB 파일로 분할되어 있습니다. 대역폭은 좋으나, 인터넷 연결은 불안정합니다. 이 경우, 데이터셋을 S3에 업로드하는 프로세스를 빠르게, 그리고 인터넷 연결 문제 없이 처리하려면 어떤 방법을 사용해야 할까요?

1.멀티파트 업로드만 사용

2.S3 Select와 S3전송 가속화 사용

3.S3멀티파트 업로드와 S3전송 가속화 사용하기

멀티파트 업로드를 사용하면 대용량 파일을 여러 부분으로 나누어 동시에 업로드할 수 있습니다. 이는 대역폭을 최대한 활용하여 빠르게 업로드할 수 있는 방법입니다. S3 전송 가속화는 AWS의 글로벌 네트워크를 통해 빠르고 안정적인 전송을 지원합니다.(3)

110.S3에 저장된 데이터셋의 서브셋을 .csv 형식으로 회수하려 합니다. 컴퓨팅 및 네트워크 비용 최소화를 위해 한 달 분의 데이터와 10개 열 중 3개의 열만 회수하려고 합니다. 무엇을 사용해야 할까요?

1.S3분석

2.S3액세스 로그

3.S3 Select

4.S3인벤토리

S3 Select은 SQL 쿼리와 유사한 형식으로 S3 객체 내부의 데이터를 처리하는 기능을 제공합니다. 이를 사용하면 필요한 데이터만을 선택적으로 추출할 수 있으며, 이는 데이터 전송량을 최소화하고 원하는 서브셋을 효율적으로 회수하는 데 도움이 됩니다.

간단한 SQL문을 사용하여 행 및 열로 필터링할 수 있음

111.회사에서 AWS의 인트라넷 규정 준수 및 규제 검토를 준비하고 있습니다. 회사는 현재 암호화되지 않은 S3 버킷에 파일을 저장하고 있으며, 규정 준수 및 규제 검토에 필요할 경우 해당 파일은 반드시 암호화해야 합니다. 다음 중 S3 버킷의 모든 파일을 가장 효율적이고 경제적인 방식으로 암호화할 수 있는 S3 기능은 무엇입니까?

1.S3액세스 포인트

2.S3교차 리전 복제(CRR)

3.S3배치 작업

4.S3수명 주기 규칙

S3 배치 작업을 사용하여 S3 버킷의 모든 파일을 효율적으로 암호화할 수 있습니다.

단일 요청으로 기존 S3 객체에 대한 대량 작업을 수행하는 서비스.

112.고객이 S3에서 파일 암호화가 수행되도록 하고 싶지만 암호화 키는 AWS 저장하지 않고 본인이 온전히 관리하고 싶다고 합니다. 이럴 경우 ........................... 를 사용할 것을 권장합니다.

1.SSE-S3

2.SSE-KMS

3.SSE-C

4.Client-Side Encryption(클라이언트 측 암호화)

SSE-C를 사용하면 암호화는 AWS 서버 측에서 수행되고, 암호화 키에 관한 모든 제어권은 이용자가 갖습니다.

113.근무하고 있는 회사에서 데이터를 암호화해 S3에 저장하고 싶어 합니다. 회사에서는 암호화 키를 AWS에 저장하고 관리하는 것은 상관없지만, 암호화 키의 순환 정책에 대한 제어권은 유지하고 싶어 합니다. 이럴 경우 ....................를 사용할 것을 권장합니다.

1.SSE-S3

2.SSE-KMS

3.SSE-C

4.Client-Side Encryption(클라이언트 측 암호화)

SSE-KMS를 사용하면 암호화가 AWS 서버 측에서 진행되고 암호화 키 관리도 AWS에서 하지만, 암호화 키 순환 정책에 관한 제어권은 모두 이용자에게 있습니다. 암호화 키는 AWS에 저장됩니다.

114.회사에서 AWS의 암호화 프로세스를 신뢰할 수 없다며 애플리케이션 측에서 암호화하기를 원합니다. 이럴 경우 ....................를 사용할 것을 권장합니다.

1.SSE-S3

2.SSE-KMS

3.SSE-C

4.Client-Side Encryption(클라이언트 측 암호화)

클라이언트 측 암호화를 사용하면 이용자가 직접 암호화를 수행해야 하며 이용자가 암호화 키에 대한 모든 제어권을 갖습니다. 직접 암호화를 수행하고 암호화된 데이터는 AWS로 보냅니다. AWS는 암호화 키를 모르기 때문에 해당 데이터를 복호화할 수 없습니다.

115.S3 버킷에서 파일을 로드하는 웹 사이트가 있습니다. Chrome 브라우저에서 파일 URL을 직접 입력하면 정상적으로 가져오는데, 웹 사이트를 통해 같은 파일을 로드하려고 하면 동작하지 않습니다. 무엇이 문제입니까?

1.버킷 정책이 잘못되었다.

2.IAM정책이 잘못되었다.

3.CORS가 잘못되었다.

4.암호화가 잘못되었다.

교차 출처 리소스 공유(CORS)는 한 도메인에 로드된 클라이언트 웹 애플리케이션이 다른 도메인에 있는 리소스와 상호 작용할 수 있도록 고안된 방식입니다. CORS에 대한 자세한 설명은 아래 링크를 참고하십시오: https://docs.aws.amazon.com/AmazonS3/latest/dev/cors.html

116.한 전자 상거래 업체는 고객 데이터와 주문 데이터를 S3 버킷에 저장하고 있습니다. 이 업체의 CEO가 고객 목록과 각 고객에게서 발생한 수익을 보여주는 보고서를 생성하려고 합니다. S3 버킷에 있는 파일에 저장된 고객 데이터 중에는 보고서에 노출하면 안 되는 민감 정보가 포함되어 있습니다. 민감 정보를 노출하지 않고 보고서를 생성하려면 어떤 방법을 사용해야 합니까?

1.S3객체 Lambda를 사용해 보고서 생성 애플리케이션으로 객체를 반환하기 전에 객체를 변경한다.

2.새로운S3버킷을 생성한다. Lambda함수를 만들어 각 파일에서 민감 정보를 삭제하는 작업을 진행하고 해당 파일을 새로 만든 S3버킷으로 이동시킨다.

3.S3객체 잠금을 사용해 보고서 생성 애플리케이션이 민감 정보를 가져가지 못하도록 잠금 처리한다.

S3 객체에 Lambda 함수를 연결하여 해당 객체가 클라이언트에게 전달되기 전에 민감한 정보를 가공할 수 있습니다. Lambda 함수를 사용하여 민감한 정보를 제거하거나 가공한 후에 보고서 생성 애플리케이션으로 전달됩니다. 이렇게 하면 보고서 생성 프로세스에서 민감한 정보를 노출하지 않으면서도 필요한 정보만을 활용할 수 있습니다.(1)

117.직원 중에 누군가가 접근 권한이 없는 S3 버킷 파일에 접근하려 했던 것으로 의심됩니다. 해당 직원에게 알리지 않고 사실 여부를 확인하려면 어떻게 해야 합니까?

1.S3 액세스 로그를 활성화하고 Athena로 로그를 분석한다.

2.해당 직원의 IAM정책을 제한하고 CloudTrail로그를 확인한다.

3.버킷 정책을 사용한다.

S3 액세스 로그가 S3 버킷에 대한 모든 요청을 로그 파일에 기록하면, Amazon Athena를 사용해 해당 로그 파일에 대해 서버리스 분석을 실행할 수 있습니다.

118.증가하는 연합 사용자들(Federated Users)에게 임시 URL을 제공해 해당 사용자들이 S3 버킷의 특정 위치로 파일을 업로드할 수 있게 하려고 합니다. 어떤 기능을 사용해야 합니까?

1.S3 CORS

2.S3 미리 서명된 URL

3.S3 버킷 정책

S3 미리 서명된 URL은 S3 버킷에서 제한된 시간 동안 일부 작업을 수행할 수 있도록 권한을 부여해 만든 임시 URL입니다.

119.회사에는 규정상 백업된 데이터베이스를 4년 동안 보관해야 한다는 의무가 있습니다. 백업된 데이터가 지워지지 않도록 보관하려면 어떤 구성을 사용해야 합니까?

1.볼트 잠금 정책이 적용된 Glacier볼트

2.제한적인 Linux권한이 있는 EFS네트워크 드라이브

3.버킷 정책이 적용된 S3

1

120.S3 버킷에 있는 모든 파일이 기본적으로 암호화되게 하고 싶습니다. 이를 달성하기 위한 최적의 방법은 무엇입니까?

1.HTTPS 연결을 강제하는 버킷 정책을 사용한다.

2.기본 암호화를 활성화한다.

3.버전 관리를 활성화한다.

기본 암호화를 활성화하면 S3에서 새로운 객체를 생성할 때마다 해당 객체에 대한 암호화가 강제됩니다. 이는 사용자가 암호화를 따로 설정하지 않아도 됩니다.

121.S3 버킷에서 버전 관리를 활성화했고 파일 삭제 시에는 각별히 더 주의를 기울이고자 합니다. 실수로 영구 삭제되는 것을 방지하려면 어떤 설정을 활성화해야 합니까?

1.버킷 정책을 사용한다.

2.MFA Delete 활성화한다.

3.파일을 암호화한다.

4.버전 관리를 비활성화한다.

MFA Delete는 사용자가 S3 객체를 삭제하기 전에 MFA 코드를 사용하도록 강제합니다. 우발적인 삭제를 방지하기 위한 부가 보안 장치입니다.

122.회사에서 S3 버킷에 데이터와 파일을 저장하고 있습니다. 이 파일 중 일부는 회사 규정 준수 정책에 따라 정해진 기간 동안 보관해야 하며 덮어쓰거나 삭제되지 않도록 보호해야 합니다. 이런 경우에 사용할 수 있는 S3 기능은 무엇입니까?

1.S3 객체 잠금 - 보존 거버넌스 모드

2.S3 버전 관리

3.S3 객체 잠금 - 보존 규정 준수 모드

4.S3 Glacier 볼트 잠금

회사에서 S3 버킷에 데이터와 파일을 보관하면서 일부 파일은 규정 준수 정책에 따라 특정 기간 동안 보존되어야 하고 덮어쓰거나 삭제되지 않도록 보호해야 한다면, 사용할 수 있는 S3 기능은 S3 객체 잠금 - 보존 규정 준수 모드입니다.

123.다음의 S3 객체 잠금 설정 중에서 객체 또는 객체 버전을 무기한 덮어쓰거나 삭제할 수 없도록 방지하고, 수동으로 삭제할 수 있는 기능만을 제공하는 설정은 무엇입니까?

1.보존 거버넌스 모드

2.보존 규정 준수 모드

3.법적 보존

Legal Hold 법적 보관

객체를 보관 모드나 보관 기간과는 상관없이 무기한으로 보호

s3:PutObjectLegalHold IAM 권한을 가진 사용자는 어떤 객체에든 법적 보관을 설정하거나 제거할 수 있음

124.Application Load Balancer가 관리하는 EC2 인스턴스 플릿에 호스팅된 웹사이트를 제공하는 CloudFront 배포가 있습니다. 모든 클라이언트가 미국에 있는데도 불구하고, 타 국가로부터 일부 악성 요청이 들어오고 있다는 점을 발견했습니다. 오직 미국으로부터의 사용자들만을 허가하고, 다른 국가는 차단하려면 어떻게 해야 할까요?

1.CloudFront 지리적 제한 사용하기

2.원본 액세스 ID 사용하기

3.보안 그룹을 설정한 뒤 이를 CloudFront 배포에 연결하기

4.Route53 지연 시간을 사용해 이를 CloudFront 분배로 연결하기

1

125.S3 버킷 상에 호스팅된 정적 웹사이트가 있습니다. 요청을 더 잘 처리하고 성능을 향상시키기 위해 S3 버킷을 가리키는 CloudFront 배포를 생성했습니다. 얼마 후, 여러분은 아직도 사용자들이 S3 버킷에서 웹사이트로 직접 액세스할 수 있다는 것을 알게 되었습니다. 여러분은 사용자들이 CloudFront만을 통해서 웹사이트로 액세스하게끔 하려 합니다. 이를 위해서는 어떻게 해야 할까요?

1.클라이언트들에게 이메일을 보내 S3 엔드 포인트를 사용하지 말 것을 요청

2.CloudFront 배포를 구성해 원본 액세스 ID를 생성한 후, S3버킷이 오직 CloudFront 배포 OAI 사용자들이 보내는 요청만을 수락하도록 업데이트

3.클라이언트가 CloudFront로 리다이렉팅되도록 S3액세스 포인트 사용

S3 버킷은 CloudFront 배포의 Origin Access Identity (OAI)를 사용하여 직접 액세스되는 것을 거부하고, CloudFront 배포를 통해서만 액세스할 수 있도록 보호할 수 있습니다.

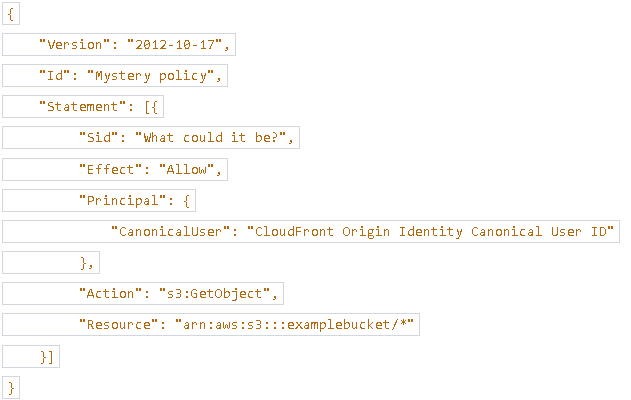

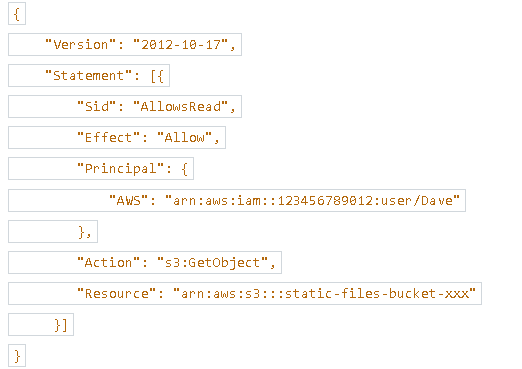

126.이 S3 버킷 정책이 하는 역할은 무엇인가요?

1.CloudFront에서 GetObject요청이 올 경우, 이를 암호화하도록강제

2.CloudFront 배포 원본 액세스 ID에서 오는 S3 버킷 콘테츠만이 평가될 수 있도록 허가

3.S3버킷에 대한 GetObject유형의 요청만 허가

이 정책은 "Effect"가 "Allow"이므로 허용 정책입니다.

"Principal" 필드에서는 "CloudFront Origin Identity Canonical User ID"라는 특정 CloudFront 배포의 원본 액세스 ID에 대한 권한을 지정하고 있습니다.

"Action" 필드에서는 "s3:GetObject"로 설정되어 있어, 해당 액세스 ID로부터의 GetObject 요청을 허용합니다.

"Resource" 필드에서는 "arn:aws:s3:::examplebucket/*"로 설정되어 있어, 이 정책은 "examplebucket"이라는 S3 버킷의 모든 객체에 대한 GetObject 권한을 부여합니다.(2)

127.한 워드프레스 웹 사이트가 EC2 오토 스케일링 그룹의 EC2 인스턴스 세트에서 호스팅되고 있습니다. 이 웹 사이트는 콘텐츠를 3일 동안 캐싱하도록 설정한 CloudFront에 의해 배포되고 있는데, 새로 출시한 버전의 웹 사이트는 캐시된 콘텐츠가 만료될 때까지 3일 동안 기다리지 않고 프로덕션에 즉시 릴리스하려고 합니다. 이 문제를 해결할 수 있는 가장 쉽고 효율적인 방법은 무엇입니까?

1.AWS Support로 지원 티켓을 열어 CloudFront 캐시를 삭제한다.

2.CloudFront 캐시를 무효화한다.

3.EC2 캐시를 무효화한다.

원하는 변경 사항이 CloudFront에 즉시 반영되도록 하려면 해당 콘텐츠를 CloudFront 캐시에서 무효화해야 합니다. 이를 통해 변경된 내용을 웹사이트 사용자에게 빠르게 제공할 수 있습니다.

128.한 회사에서 AWS로 미디어 공유 웹 사이트를 배포하고 있습니다. CloudFront를 사용해 미국과 유럽에 있는 고객에게만 짧은 지연 시간으로 컨텍스트를 제공할 예정입니다. 얼마 뒤 CloudFront에서 엄청난 비용이 발생했습니다. 다음 중 미국와 유럽만을 대상으로 하여 비용을 절감할 수 있는 CloudFront 기능은 무엇입니까?

1.CloudFront 캐시 무효화

2.CloudFront 가격 등급

3.CloudFront 캐시 동작

4.오리진 액세스 제어(OAC)

비용 절감을 위해 CloudFront를 분산할 엣지 로케이션의 수를 줄일 수 있음(2)

129.한 기업에서 웹 애플리케이션을 AWS 클라우드로 이전해 EC2 오토 스케일링 그룹에 있는 EC2 인스턴스 세트를 사용하려고 합니다. 웹 애플리케이션은 여러 개의 컴포넌트로 구성되어 있기 때문에 특정 웹 애플리케이션 컴포넌트로 라우팅하려면 호스트 기반 라우팅 기능이 필요합니다. 이 웹 애플리케이션은 이용객이 아주 많기 때문에 고객들의 방화벽 화이트리스트에 등록될 수 있도록 정적 IP 주소를 사용해야 합니다. 또한 이 애플리케이션을 이용하는 고객들이 전 세계에 흩어져 있으므로 짧은 지연 시간으로 서비스를 제공해야 합니다. 다음 중 정적 IP 주소를 할당하고 전 세계에 짧은 지연 시간으로 서비스를 제공하는 데 도움이 될 만한 AWS 서비스는 무엇입니까?

1.AWS Global Accelerator + 애플리케이션 로드 밸런서

2.Amazon CloudFront

3.네트워크 로드 밸런서

4.애플리케이션 로드 밸런서

AWS Global Accelerator: 글로벌 액세스를 통해 안정적이고 빠른 글로벌 배포를 제공하는 서비스입니다. Global Accelerator를 사용하면 고객들이 정적 IP 주소를 통해 액세스할 수 있습니다.

애플리케이션 로드 밸런서: 호스트 기반 라우팅을 지원하고 EC2 인스턴스 세트에 대한 트래픽을 분산시키는 로드 밸런서 서비스입니다.

이 두 가지 서비스를 조합하여 정적 IP 주소를 할당하고 글로벌 액세스를 제공할 수 있습니다.

130.수백 TB의 데이터를 Amazon S3로 이전한 후, EC2 인스턴스 플릿을 사용해 처리해야 합니다. 광대역은 1Gbit/초입니다. 여러분은 데이터를 더 빠르게 이전하고, 가능하면 전송 중에 데이터를 처리했으면 합니다. 어떤 방법을 추천할 수 있을까요?

1.자체 네트워크 사용하기

2.Snowcone 사용하기

3.AWS 데이터 이전 사용하기

4.SnowballEdge 사용하기

Snowball Edge는 컴퓨팅 능력을 갖추고 있으며, 데이터가 Snowball로 이동하는 동안 데이터를 사전에 처리할 수 있도록 해주므로 정답입니다.

131.테이프 백업에 가상 인피니트 스토리지를 노출하려고 합니다. 여러분은 사용 중인 것과 동일한 소프트웨어를 유지하고, iSCSI와 호환 가능한 인터페이스를 사용하려 합니다. 어떤 방법을 사용해야 할까요?

1.AWS Snowball

2.AWS Storage Gateway - 테이프 게이트웨이

3.AWS Storage Gateway - 볼륨 게이트웨이

4.AWS Storage Gateway - 파일 게이트웨이

2

132.여러분의 EC2 Windows 서버는 Windows의 보안 메커니즘을 준수하며, Microsoft Active Directory와 통합된 네트워크 파일 시스템을 마운트하여 일부 데이터를 공유해야 합니다. 어떤 방법을 추천할 수 있을까요?

1.Windows용 Amazon FSx(파일 서버)

2.Amazon EFS

3.Lustre용 Amazon FSx

4.파일 게이트웨이를 지닌 Amazon S3

- FSx for Windows는 완전 관리형 Windows 파일 시스템 공유 드라이브.

- Microsoft Active Directory 통합을 지원하므로, ACL(액세스 제어 목록)로 사용자 할당량을 추가해 액세스를 제어할 수 있음.

- Linux EC2 인스턴스에 마운트할 수 있음.

- Microsoft의 분산 파일 시스템 (Distributed File System, DFS) 네임스페이스를 지원 (파일 시스템 그룹화).(1)

133.여러분은 수백 TB의 데이터를 AWS S3로 최대한 빨리 이전시켜야 합니다. 여러분의 네트워크 대역폭을 사용해보려 했으나, 업로드 프로세스가 완료되기까지 약 3주가 소요됩니다. 이런 경우 어떤 접근법이 권장될까요?

1.AWS Storage Gateway - 볼륨 Gateway

2.S3 멀티파트 업로드

3.AWS Snowball 엣지

4.AWS 데이터 이전 서비스

AWS Snowball 엣지를 사용하면 데이터를 로컬로 수집하고 Snowball 엣지에 저장한 후, 해당 장치를 AWS로 반환하여 데이터를 S3로 이전할 수 있습니다. 이는 대량의 데이터를 빠르게 이전하고 네트워크 대역폭의 제약을 극복하는 데 도움이 됩니다.

134.S3에 대규모의 데이터셋이 저장되어 있습니다. 여러분은 NFS, 혹은 SMB 프로토콜을 사용해 온프레미스 서버를 통해 이 데이터셋에 액세스하려 합니다. 또한, 온프레미스 Microsoft AD를 통해 이러한 파일에 대한 액세스를 인증하고자 합니다. 무엇을 사용해야 할까요?

1.AWS Storage Gateway - 볼륨 Gateway

2.AWS Storage Gateway - 파일 Gateway

3.AWS Storage Gateway - 테이프 Gateway

4.AWS 데이터 이전 서비스

- Amazon S3 File Gateway는 NFS 및 SMB 프로토콜을 사용하여 구성된 S3 버킷에 액세스할 수 있음

- 최근에 사용된 데이터는 파일 게이트웨이에 캐시로 저장됨

- 각 파일 게이트웨이에 대한 IAM Role을 사용하여 버킷 액세스 설정

- SMB 프로토콜을 사용하는 경우에는 사용자 인증을 위해 Active Directory (AD)와 통합해야 함

135.기업의 인프라를 온프레미스에서 AWS Cloud로 이전시킬 계획을 가지고 있습니다. 여러분은 이전시키려는 온프레미스 Microsoft Windows 파일 서버를 갖고 있습니다. 어떤 AWS 서비스를 사용하는 것이 가장 적절할까요?

1.Windows용 Amazon FSx(파일 서버)

2.AWS Storage Gateway - 파일 Gateway

3.AWS가 관리하는 Microsoft AD

- Amazon FSx는 Microsoft Windows 파일 서버에 대한 관리형 서비스로, 기업의 파일 공유 및 파일 시스템 요구 사항을 충족하는 데 사용됩니다.

- FSx는 Windows 파일 시스템을 사용하여 온프레미스 Windows 파일 서버와 호환성이 있으며, 데이터의 안정적인 저장, 백업, 복원, 확장 가능한 성능 등을 제공합니다.

136.고성능 컴퓨팅(HPC)과 전산 유전학 연구를 수행하기 위해 IOPS를 최대화해 줄 분산 POSIX 준수 파일 시스템이 필요한 상황입니다. 이 파일 시스템은 수백만 개의 IOPS로 손쉽게 스케일링할 수 있어야 합니다. 어떤 방법을 추천할 수 있을까요?

1.Max를 가진 EDSIO 활성화

2.Lustre용 Amazon FSxLustre용 Amazon FSx

3.EC2 인스턴스 상에 마운팅된 Amazon S3

4.EC2 인스턴스 스토어

- Amazon FSx for Lustre는 높은 성능을 제공하는 관리형 파일 시스템으로, 수백만 개의 IOPS를 제공할 수 있습니다.

- Lustre는 고성능 컴퓨팅 워크로드에 특히 효과적이며, 확장 가능한 파일 시스템이 필요한 HPC 환경에서 많이 사용됩니다.

- Amazon FSx for Lustre는 AWS에서 Lustre 파일 시스템을 쉽게 프로비저닝하고 관리할 수 있는 서비스를 제공합니다

137.FSx 파일 시스템에 있는 다음 배포 옵션 중에서 AZ 내에 복사된 장기 스토리지를 제공하는 것은 무엇인가요?

1.스크래치 파일 시스템

2.영구 파일 시스템

이는 데이터가 동일한 AZ 내에서 복제되는 장기 스토리지를 제공합니다. 실패한 파일들은 수 분 내로 교체됩니다.(2)

138.다음 중 AWS 전송 제품군이 지원하지 않는 프로토콜은 무엇인가요?

1.파일 전송 프로토콜(FTP)

2.SSL을 통한 파일 전송 프로토콜(FTP)

3.전송층 보안(TLS)

4.보안 파일 전송 프로토콜(FTP)

AWS 전송 제품군은 FTP 프로토콜을 사용해 S3, 혹은 EFS 내부/외부로 파일을 전송하는 관리 서비스입니다. 따라서 TLS를 지원하지 않습니다.

139.회사는 AWS의 FSx for Windows 파일 서버 스토리지에 저장된 수많은 파일과 데이터를 사용하고 있습니다. 이 파일들은 현재 AWS에 호스팅된 리소스에서 사용됩니다. 이 파일들을 온프레미스에서 짧은 지연 시간으로 액세스할 수 있어야 합니다. 이를 달성하는 데 도움이 될 만한 AWS 서비스는 무엇입니까?

1.S3파일 게으트웨이

2.FSx for Windows File Server 온프레미스

3.FSx 파일 게이트웨이

4.볼륨 게이트웨이

- FSx 파일 게이트웨이는 온프레미스 환경에서 AWS의 FSx 파일 서버 스토리지에 접근하는 데 사용됩니다.

- FSx 파일 게이트웨이를 설정하면 온프레미스에서도 AWS의 파일 서버에 액세스할 수 있습니다.

- 이를 통해 데이터를 동기화하고 사용자는 지연 시간이 짧은 형태로 파일 서버의 데이터를 사용할 수 있습니다.

- 볼륨 게이트웨이는 온프레미스와 클라우드 간에 블록 스토리지의 연결을 허용하는데 사용됩니다.

- 그러나 이는 파일 수준이 아닌 블록 수준의 연결이므로 주어진 상황에서는 파일 게이트웨이가 더 적절할 수 있습니다.

140.솔루션 아키텍트가 한 스타트업의 온프레미스 서버를 AWS로 이전하는 작업을 계획하고 있습니다. 현재 회사의 인프라는 공유 NFS 스토리지에 호스팅된 여러 개의 서버와 30TB의 데이터로 구성되어 있습니다. 아키텍트는 Amazon S3를 사용해 데이터를 호스팅하기로 결정했습니다. 데이터를 온프레미스에서 S3로 효율적으로 이전할 수 있는 AWS 서비스는 무엇입니까?

1.AWS Storage 테이프 Gateway

2.Amazon EBS

3.AWS Transfer Family

4.AWS DataSync

- AWS DataSync는 대량의 데이터를 안전하고 빠르게 온프레미스에서 Amazon S3로 이전할 수 있는 서비스입니다.

- DataSync는 고성능 네트워크를 통해 데이터를 전송하며, 병렬 처리 및 자동 오류 복구 기능을 제공하여 효율적인 데이터 이전을 지원합니다.

- NFS(Network File System)와 호환되므로 공유 NFS 스토리지에서 쉽게 데이터를 Amazon S3로 전송할 수 있습니다.

AWS Transfer Family는 SFTP 및 FTPS 프로토콜을 통해 데이터를 전송하기 위한 서비스입니다. NFS와는 직접적인 호환성이 없으며, 주로 파일 전송 프로토콜을 통한 전송에 사용됩니다.

141.S3 버킷에 있는 다량의 데이터를 EFS 파일 시스템으로 옮기는 데 가장 적합한 AWS 서비스는 무엇입니까?

1.AWS Snowball

2.AWS DataSync

3.AWS Transfer Family

4.AWS Backup

- 대용량의 데이터를 한 곳에서 다른 곳으로 옮김

- 다음으로 동기화할 수 있다.

- Amazon S3 (Glacier를 포함한 모든 스토리지 클래스)

- Amazon EFS

- Amazon FSx (Windows, Lustre, NetApp, OpenZFS 등)(2)

142.한 머신 러닝 업체가 S3 버킷에 호스팅된 데이터 세트를 기반으로 연구를 진행하고 있습니다. 업체는 다른 사람들이 연구에 활용할 수 있도록 데이터 세트 중 일부를 공개하기로 결정했지만, S3 버킷 자체를 퍼블릭(Public)으로 설정하는 건 원치 않습니다. 또한 데이트 세트는 FTP 프로토콜로 접근할 수 있어야 합니다. 최소한의 노력으로 이 요구 사항을 충족하려면 어떻게 해야 합니까?

1.AWS Transfer Family를 사용한다.

2.FTP 서버가 설치된 EC2 인스턴스를 만들고 S3에 있는 데이터를 EC2 인스턴스로 복사한다.

3.AWS Storage Gateway를 사용한다.

4.S3의 데이터를 복사해 EFS 파일 시스템으로 옮긴 다음, FTP 프로토콜에 노출시킨다.

- Transfer Family: FTP, FTPS, SFTP 프로토콜을 사용하여 Amazon S3 또는 Amazon EFS 위에서 파일 전송을 제공하는 완전 관리형 서비스

- S3 APIs나 EFS 네트워크 파일 시스템을 사용하지 않고 FTP 프로토콜만 사용함

- 사용 사례: 파일 공유, 공개 데이터셋 공유, CRM, ERP 등

143.Amazon FSx for NetApp ONTAP는 다음 중 ………………를 제외한 나머지 프로토콜과 호환됩니다.

1.NFS

2.SMB

3.FTP

4.iSCSI

- NFS, SMB, iSCSI 프로토콜과 호환되는 파일 시스템

- 지정 시간 복제 기능을 통한 즉각적인 복제(새로운 워크로드 테스트에 유용)

144.온프레미스 ZFS 파일 시스템을 AWS로 마이그레이션 하는데 가장 적합한 AWS 서비스는 무엇입니까?

1.Amazon FSx for OpenZFS

2.Amazon FSx for NetApp ONTAP

3.Amazon FSx for Windows File Server

4.Amazon FSx for Lustre

- Amazon FSx for OpenZFS는 ZFS 파일 시스템을 기반으로 하며, 온프레미스에서 ZFS를 사용하고 있는 경우 이를 AWS로 쉽게 마이그레이션할 수 있는 서비스입니다.

- OpenZFS는 데이터 무결성 및 고급 스냅샷 기능을 제공하며, FSx for OpenZFS는 이러한 기능을 클라우드에서 제공합니다.

145.회사에서는 Amazon S3 파일 게이트웨이를 실행해 S3 버킷에 데이터를 호스팅하고 있으며, SMB를 사용해 해당 데이터를 온프레미스에 마운트할 수 있습니다. 현재 데이터는 S3 Standard 스토리지 클래스에 호스팅되어 있는데 S3에 드는 비용을 절감하기 위해 데이터 중 일부를 S3 Glacier로 옮기기로 결정했습니다. 데이터를 S3 Glacier로 자동으로 옮길 수 있는 가장 효율적인 방법은 무엇입니까?

1.S3 Glacier로 데이터를 옮기는 Lambda함수를 만들고 Amazon EventBridge를 사용해 매일 주기적으로 실행시킨다.

2.S3배치 작업을 사용해 S3에 있는 모든 파일을 매일 S3 Glacier로 이동시킨다.

3.S3 수명 주기 정책을 사용한다.

4.AWS DataSync를 사용하여 매일 S3 Glacier로 데이터를 복제한다.

5.데이터를 S3 Glacier로 직접 전송하도록 S3 File Gateway를 구성한다.

- S3 수명 주기 정책은 S3 객체에 대한 자동 이동 및 삭제 규칙을 설정할 수 있는 방법을 제공합니다.

- 수명 주기 정책을 사용하여 데이터를 Glacier로 자동으로 이동시킬 수 있습니다.

- 이 방법은 비용을 절감하면서도 데이터를 안전하게 보관할 수 있습니다.

- Lambda 함수 및 EventBridge를 사용하여 주기적으로 실행하는 방법이지만, S3 수명 주기 정책이 더 간단하고 효과적일 수 있습니다.

- S3 배치 작업은 일괄적으로 여러 객체를 처리하는 데 사용됩니다. 그러나 주기적으로 실행되는 것보다는 수명 주기 정책이 더 적합할 수 있습니다.

- AWS DataSync는 데이터를 동기화하고 복제하는 데 사용되는 서비스이며, 주로 다른 용도에 사용됩니다. S3 수명 주기 정책이 S3 Glacier로 이동에 더 적합합니다.

- S3 File Gateway는 S3를 파일 시스템으로 마운트하는 서비스이며, 직접적으로 Glacier로 데이터를 이동시키는 목적에는 적합하지 않을 수 있습니다.

146.사내 서버에 있는 중요 파일과 문서를 주기적으로 AWS에 동기화시켜 복사본을 따로 보관하고자 합니다. 이럴 경우에 도움을 줄 수 있는 AWS 서비스는 무엇입니까?

1.AWS Database Migration Service

2.Amazno EFS

3.AWS DataSync

AWS DataSync는 온프레미스 스토리지 시스템과 AWS 스토리지 서비스 또는 AWS 스토리지 서비스 간의 데이터 이동을 단순화, 자동화, 가속화시켜주는 온라인 데이터 전송 서비스입니다.

147.일년 중 최대 세일 기간인 블랙 프라이데이를 준비하고 있는 전자 상거래 웹사이트가 있습니다. 트래픽은 100배가 증가할 것으로 예상됩니다. 이 웹사이트는 이미 SQS 표준 대기열을 사용하고 있습니다. SQS 대기열은 어떻게 준비해야 할까요?

1.AWS지원 센터에 연락해 SQS표준 대기열을 준비해줄 것을 요청

2.SQS대기열에 오토 스케일링 활성화

3.SQS대기열 용량 늘리기

4.SQS이 자동으로 스케일링해줄 것이므로 아무 조치도 취하지 않음

SQS 대기열과 오토 스케일링 그룹이 있을 때 ASG 내의 EC2 인스턴스에 메시지를 SQS 대기열에서 폴링합니다 이는 오토 스케일링 그룹을 자동으로 대기열 크기에 따라 확장시키기 위함으로 CloudWatch 지표인 대기열 길이를 보고 결정할 수 있습니다.(4)

148.소비자들이 한 번에 10개의 메시지를 폴링하고 1분 내로 이에 대한 처리를 완료하는 SQS 대기열이 있습니다. 잠시 후, 여러분은 동일한 SQS 메시지를 다른 소비자들도 수신하여 메시지가 한 번 이상 처리되었음을 알게 되었습니다. 이 문제를 해결하기 위해서는 어떻게 해야 할까요?

1.롱 풀링 활성화

2.메시지 생성 시 메시지에 DelaySeconds 파라미터 추가

3.가시성 시간 초과 늘리기

4.가시성 시간 초과 줄이기

- SQS 롱 폴링이 활성화되면, Amazon SQS는 반환할 메시지가 없을 경우의 빈 응답 수를 감소시키고, 거짓 빈 응답(SQS 메시지는 사용할 수 있으나 응답에 포함되지 않은 경우)을 제거합니다.

- SQS 가시성 시간초과는 Amazon SQS가 다른 소비자들의 메시지 재수신 및 재처리를 막는 기간입니다. 가시성 시간초과는 대기열에서 소모된 메시지만을 감춤 처리합니다. 가시성 시간초과를 증가시키면 소비자들이 더 오랜 시간 동안 메시지를 처리할 수 있게 해주며, 메시지의 중복 읽기를 방지합니다.(기본: 30초, 최소: 0초, 최대: 12시간)

- 가시성 시간 제한이 너무 짧을 경우 (초 단위), 처리할 시간이 충분하지 않으면 다른 소비자가 메시지를 여러 번 읽고 해당 요청이 여러 번 처리될 수 있음(답:3)

149.다음 중 어떤 SQS 대기열 유형을 사용해야 메시지가 순차적으로, 단 한 번만 처리될까요?

1.SQS 표준 대기열

2.SQS 데드 레터 대기열

3.SQS 대기열 지연

4.SQS FIFO 대기열

SQS FIFO(First-In-First-Out) 대기열은 SQS 표준 대기열의 모든 기능을 가지고 있으며, 다음과 같은 두 기능이 추가됩니다. 첫 번째, 어떤 메시지를 보내고 수신했는지에 대한 오더가 엄격하게 보존됩니다. 메시지는 한 번만 전송되며, 소비자가 해당 메시지를 처리하고 삭제할 때까지 사용할 수 있습니다. 두 번째, 복제된 메시지는 대기열에 들어오지 않습니다.

150.3개의 서로 다른 애플리케이션으로 동일한 메시지를 보내려 합니다. 3개의 애플리케이션 모두 SQS를 사용하고 있습니다. 이를 위해, 어떤 접근법을 선택하는 것이 가장 적절할까요?

1.SQS 복제 기능을 사용

2.SNS + SQS 팬아웃 패턴을 사용

3.3개의 SQS 대기열에 개별적으로 메시지 전송하기

흔히 사용되는 패턴으로, 단 하나의 메시지를 SNS 주제로 전송한 뒤, 다수의 SQS 대기열로 ‘팬 아웃’합니다. 이 방식에는 다음의 기능이 포함되어 있습니다: 완전히 분리되어 있고, 데이터 손실이 없으며, 향후 더 많은 SQS 대기열(더 많은 애플리케이션)을 추가할 수 있습니다.(2)

151.한 Kinesis Data Stream에 6개의 샤드가 프로비저닝되어 있습니다. 이 데이터 스트림은 보통 5MB/초의 속도로 데이터를 수신하며, 8MB/초의 속도로 데이터를 전송합니다. 이따금 트래픽이 2배까지 증가하여 ProvisionedThroughputExceededException 예외 처리가 발생합니다. 이 문제를 해결하려면 어떻게 해야 할까요?

1.더 많은 샤드 추가

2.Kinesis 복제 활성화

3.SQS를 Kinesis의 버퍼로 사용

Knesis Data Stream의 용량 제한은 데이터 스트림 내에 있는 샤드의 수에 의해 결정됩니다. 이러한 제한은 데이터 처리량, 혹은 읽기 데이터 호출에 의해 초과될 수 있습니다. 각 샤드는 1MB/초 만큼의 들어오는 데이터와 2MB/초 만큼의 나가는 데이터를 허용합니다. 충분한 용량을 제공하려면 데이터 스트림의 샤드 수를 증가시켜야 합니다.

152.한 웹사이트 내에서 사용자들이 클릭하는 순서, 사용자들이 보내는 시간 및 탐색이 어디에서 시작되고 어떻게 종료되는지 등의 클릭스트림 데이터를 분석하고자 합니다. Amazon Kinesis를 사용하기로 했고, 웹사이트가 이러한 클릭스트림 데이터를 Kinesis Data Stream로 전송하도록 구성한 상태입니다. Kinesis Data Stream으로 전송된 데이터를 확인하던 중, 데이터가 순서대로 정렬되어 있지 않으며, 한 개별 사용자로부터 온 데이터가 여러 샤드에 분산되어 있다는 것을 알게 되었습니다. 이 경우, 어떻게 문제를 해결해야 할까요?

1.샤드가 너무 많으므로 오직 1개의 샤드만 사용해야 함

2.다수의 소비자를 사용해서는 안되므로, 오직 하나만을 사용하면 데이터가 재정렬될 것

3.Kinesis로 보내지는 각 레코드에 사용자의 신원을 나타내는 파티션 키를 추가해야 함

Kinesis Data Stream은 각 데이터 레코드에 연결된 파티션 키를 사용해 주어진 데이터 레코드가 어느 샤드에 속하는지 판단합니다. 각 사용자의 신원을 파티션 키로 사용할 경우, 각 유저에 대한 데이터가 정렬되어 동일한 샤드로 보낼 수 있습니다.

153.대량의 실시간 데이터를 생성하는 애플리케이션을 실행 중이며, 이 데이터를 S3와 Redshift로 로딩하려 합니다. 또한 이 데이터들은 목적지에 도달하기 전에 변환되어야 합니다. 이를 위해, 선택할 수 있는 가장 적절한 아키텍처는 무엇인가요?

1.SQS + AWS Lambda

2.SNS + HTTP Endpoint

3.Kinesis Data Streams + Kinesis Data Firehose

- 이는 실시간 데이터를 S3와 Redshift로 로딩하기 위한 완벽한 기법 조합입니다. Kinesis 데이터 파이어호스는 AWS Lambda를 사용하는 커스텀 데이터 변환을 지원합니다.

- Kinesis Data Streams는 대량의 스트림 데이터를 처리하는 데 사용되며, 데이터를 실시간으로 전달할 수 있습니다.

- Kinesis Data Firehose는 Kinesis Data Streams로부터 데이터를 수신하고, S3 또는 Redshift와 같은 목적지에 데이터를 로드하며, 변환 작업을 수행할 수 있습니다.

- Kinesis Data Firehose는 목적지에 데이터를 자동으로 로드하고 변환할 수 있는 관리형 서비스로 편리하게 사용할 수 있습니다.(3)

154.다음 중 AWS SNS를 지원하지 않는 구독자를 고르세요.

1.Amazon Kinesis Amazon Kinesis Data Streams

2.Amazon SQS

3.HTTP(S) Endpoint

4.AWS Lambda

현재 Kinesis Data Firehose는 지원되지만, Kinesis Data Streams는 지원되지 않습니다.

155.다음 중 사용자들에게 이메일 알림을 보내려 할 때 도움이 되는 AWS 서비스는 무엇인가요?

1.AWS Lambda를 갖는 Amazon SQS

2.Amazon SNS

3.Amazon Kinesis

- Amazon SNS는 푸시 알림, SMS, 이메일 등 다양한 종류의 알림을 효과적으로 관리하고 전송하는 서비스입니다.

- 이메일 알림을 보내기 위해선 이메일 주제 및 본문을 정의하고, 이메일 구독자를 추가하여 알림을 받도록 설정할 수 있습니다.

- 다양한 프로토콜을 지원하여 여러 경로로 알림을 전송할 수 있습니다.

156.여러 마이크로 서비스 애플리케이션을 온프레미스로 실행 중이며, 이들은 MQTT 프로토콜을 지원하는 메시지 브로커를 사용해 통신하고 있습니다. 애플리케이션을 새로 엔지니어링하거나 코드를 수정하는 작업 없이, 이 애플리케이션들을 AWS로 이전시키려 합니다. MQTT 프로토콜을 지원하는 관리 메시지 브로커를 활용하기 위해서는 다음 중 어떤 AWS 서비스를 사용해야 할까요?

1.Amazon SQS

2.Amazon SNS

3.Amazon Kinesis

4.Amazon MQ

Amazon MQ는 JMS, NMS와 같은 업계 표준 API를 지원하며 AMQP, STOMP, MQTT 및 WebSocket 등을 비롯한 메시징 프로토콜을 지원합니다.

157.한 전자 상거래 기업에서 수백만 건의 트랜잭션이 발생할 만한 마케팅 프로모션을 기획하고 있습니다. 이 기업의 웹 사이트는 오토 스케일링 그룹의 EC2 인스턴스에 호스팅되어 있고 Amazon Aurora를 데이터베이스로 사용하고 있습니다. 지난 번에 개최한 프로모션에서는 Aurora 데이터베이스의 병목 현상 때문에 수많은 거래가 실패했습니다. Aurora 데이터베이스에서 감당할 수 없을 정도로 많은 트랜잭션이 발생했기 때문입니다. 이렇게 많은 트랜잭션을 처리하고 트랜잭션 실패를 방지하려면 어떻게 해야 합니까?

1.SQS를 버퍼로 사용해 Aurora에 쓰기 작업을 수행한다.

2.웹 사이트를 EC2 인스턴스 대신 AWS Fargate에서 호스팅한다.

3.Aurora를 SQL서버용 RDS로 마이그레이션한다.

- SQS를 사용하여 쓰기 작업을 버퍼링하고, Aurora에 대한 쓰기 작업을 분산하여 처리할 수 있습니다.

- SQS를 통해 비동기적으로 데이터베이스에 쓰기 작업을 수행하면 트래픽의 급증에 대응할 수 있으며, 트랜잭션 실패를 방지할 수 있습니다.

158.회사에서 Amazon Kinesis Data Streams을 사용해 클릭 스트림 데이터를 수집하여 분석 작업을 수행하고 있습니다. 며칠 뒤에 캠페인이 예정되어 있고 트래픽은 예측이 불가능하며 100배까지 증가할 수도 있습니다. 이런 경우에 적합한 Kinesis Data Stream 용량 모드는 무엇입니까?

1.프로비저닝된 모드

2.온디맨드 모드

- 온디맨드 모드는 트래픽에 따라 자동으로 확장되기 때문에 예측 불가능한 트래픽 증가에 대응하기에 적합합니다.

- 사용한 시간에 따라 비용이 청구되므로 트래픽이 급증할 때만 필요한 용량을 할당받을 수 있습니다.

- 트래픽이 감소하면 자동으로 용량이 축소되어 비용을 최소화할 수 있습니다.

159.온프레미스로 호스팅된 다중 도커 기반의 애플리케이션이 있으며, 이를 AWS로 이전시키려 합니다. 여러분은 인프라를 프로비저닝하거나 관리할 의향이 없으며, 그냥 컨테이너를 AWS 상에서 실행하려고 합니다. 이 경우, 다음 중 어떤 AWS 서비스를 선택해야 할까요?

1.Elastic Container Service(ECS)

2.Elastic Container Registry(ECR)

3.AWS Fargate

4.Elastic Kubernetes Service(EKS)

AWS Fargate를 사용하면 서버를 관리할 필요 없이 AWS 상에서 컨테이너를 실행할 수 있습니다.

160.Amazon Elastic Container Service(ECS)에는 두 가지의 실행 유형이 있습니다. ..................와 ..................입니다.

1.Amazon EC2 실행 유형과 Fargate 실행 유형

2.Amazon EC2 실행 유형과 EKS 실행 유형

3.Fargate 실행 유형과 EKS 실행 유형

Amazon Elastic Container Service(ECS)에는 Amazon EC2 실행 유형과 AWS Fargate 실행 유형이 있습니다. 이 두 실행 유형은 각각 컨테이너를 실행하는 데 사용되는 서비스 모델을 나타냅니다. EC2 실행 유형은 EC2 인스턴스를 사용하여 컨테이너를 실행하고 관리하며, Fargate 실행 유형은 서버리스 컴퓨팅을 사용하여 인프라 관리 없이 컨테이너를 실행합니다.

161.ECS 클러스터(EC2 실행 유형) 상에 호스팅된 애플리케이션이 있습니다. 여러분은 ECS 태스크가 S3 버킷으로 파일을 업로드하게 하려 합니다. 이를 위해서는 다음 중 어떤 ECS 태스크 용 IAM 역할을 수정해야 할까요?

1.EC2 인스턴스 프로파일

2.ECS 태스크 역할

ECS 태스크 역할은 ECS 태스크 자체가 사용하는 IAM 역할입니다. 컨테이너가 S3, SQS 등의 다른 AWS 서비스를 호출하려 할 때 사용합니다.

162.도커 컨테이너 상에서 실행 중인 WordPress 웹사이트를 온프레미스에서 AWS로 이전하려 합니다. ECS 클러스터에서 애플리케이션을 실행하기로 했으나, 도커 컨테이너가 웹사이트 파일, 이미지, 영상을 비롯한 동일한 WordPress 웹사이트 콘텐츠에 액세스할 수 있게끔 하려 합니다. 이를 위해서는 어떤 방법이 권장될까요?

1.EFS 볼륨 마운트

2.EBS 볼륨 마운트

3.EC2 인스턴스 스토어 사용

EFS 볼륨은 서로 다른 EC2 인스턴스와 서로 다른 ECS 태스크 간의 공유가 가능합니다. 컨테이너의 영구적인 다중 AZ 공유 스토리지로 사용될 수 있습니다.

163.EC2 인스턴스로 구성된 ECS 클러스터 상에 애플리케이션을 배포하려 합니다. 현재, 클러스터는 DynamoDB에 대한 API 호출을 성공적으로 발행한 애플리케이션 하나를 호스팅하고 있습니다. S3로의 API 호출을 발행하는 두 번째 애플리케이션을 추가하려는데, 권한 부여 관련 문제가 발생했습니다. 이 문제를 해결하고 적절한 보안을 유지하기 위해서는 어떤 방법을 사용해야 할까요?

1.EC2 인스턴스 역할을 수정해 S3에 대한 권한 추가

2.새 애플리케이션을 위한 IAM 역할 생성

3.Fargate 모드 활성화

4.ECS 태스크를 허용하도록 S3 버킷 정책 수정

새로운 애플리케이션에는 DynamoDB와 S3에 대한 권한이 필요하므로, 각각의 서비스에 대한 권한을 부여하는 새로운 IAM 역할을 생성하는 것이 더 적절합니다. EC2 인스턴스 역할을 수정하는 것은 현재 사용 중인 애플리케이션에 영향을 미칠 수 있으므로 새로운 IAM 역할을 생성하여 해당 역할을 새로운 애플리케이션에 할당하는 것이 좋습니다.(2)

164.온프레미스 도커 기반 애플리케이션을 Amazon ECS로 이전하려 합니다. 여러분은 도커 허브 컨테이너 이미지 라이브러리를 컨테이너 이미지 리포지토리로 사용하고 있었습니다. 다음의 대체 AWS 서비스들 중 Amazon ECS와 완전히 통합되어 있는 서비스는 무엇인가요?

1.AWS Fargate

2.Elastic Container Registry(ECR)

3.Elastic Kubernetes Service(EKS)

4.Amazon EC2

Amazon ECR은 컨테이너 이미지를 손쉽게 저장, 관리, 공유 및 배포할 수 있도록 해주는 완전 관리형 컨테이너 레지스트리입니다. ECR은 Amazon ECS와 완전히 통합되어 있어, ECS를 사용하여 컨테이너를 실행하고 관리하는 동안 ECR에서 컨테이너 이미지를 쉽게 가져올 수 있습니다.

165.Amazon EKS는 다음 중 ………………..를 제외한 나머지 노드 타입을 지원합니다.

1.관리형 노드 그룹

2.자체 관리형 노드

3.AWS Fargate

4.AWS Lambda

관리형 노드 그룹 (Managed Node Group):

- EKS에서 제공하는 EC2 인스턴스를 사용하는 노드 그룹입니다.

- 클러스터에 쉽게 노드를 추가하거나 제거할 수 있습니다.

자체 관리형 노드 (Self-Managed Node):

- 사용자가 직접 관리하는 EC2 인스턴스를 사용하는 노드입니다.

- EKS 클러스터에 수동으로 노드를 추가하거나 제거할 수 있습니다.

AWS Fargate:

- 서버리스 컨테이너 서비스로, 노드를 직접 관리하지 않고 컨테이너를 실행할 수 있습니다.

- EC2 인스턴스나 다른 노드 유형 없이 컨테이너를 실행할 수 있습니다.

AWS Lambda:

- AWS Lambda는 서버리스 컴퓨팅 서비스로, 함수를 실행할 때에만 자원이 할당됩니다.

- Lambda는 EKS에서 직접적으로 노드로 사용되지 않습니다.(4)

166.한 개발자가 컨테이너를 사용해 자신의 로컬 머신에서 실행하고 있는 웹 사이트와 API를 모두 AWS에 배포하려고 합니다. 이 개발자는 AWS에 익숙하지 않고 다양한 AWS 서비스에 대해 잘 알지 못합니다. 개발자가 AWS 모범 사례를 따라 가장 쉬운 방식으로 웹 사이트와 API를 빌드하고 배포할 수 있는 AWS 서비스는 다음 중 무엇입니까?

1.AWS App Runner

2.EC2 인스턴스 + 애플리케이션 로드 밸런서

3.Amazon ECS

4.AWS Fargate

1

167.데이터를 프로세싱하는 데에 대략 1시간 정도가 걸리는 Lambda 함수를 생성했습니다. 코드를 머신에서 로컬로 실행했을 때에는 문제가 없었으나, Lambda 함수를 호출할 때는 3초가 지난 후 ‘시간초과' 오류가 발생하여 실패합니다. 어떻게 해야 할까요?

1.Lambda의 시간초과를 25분으로 구성

2.Lambda의 메모리를 10GB로 구성

3.코드를 다른 곳(예:EC2 인스턴스)에서 실행

Lambda의 최대 실행 시간은 15분입니다. 코드를 EC2 인스턴스처럼 다른 곳에서 실행할 수도 있고, Amazon ECS를 사용할 수도 있습니다.(3)

168.DynamoDB 표를 생성하기 전에는 DynamoDB 테이블이 실행될 EC2 인스턴스를 프로비저닝해야 합니다.

1.맞습니다.

2.아닙니다.

DynamoDB는 프로비저닝, 패치, 혹은 관리할 서버가 없고 설치, 유지 및 운용해야 할 소프트웨어가 없는 서버리스 서비스입니다. DynamoDB는 용량 조정 및 성능 유지를 위한 테이블의 확장 및 축소를 자동으로 스케일링합니다. 이는 프로비저닝(RCU & WCU 지정) 및 온디맨드 (사용한 만큼의 비용 책정) 용량 모드 모두를 제공합니다.

169.DynamoDB 테이블을 10 RCU와 10 WCU로 프로비저닝했습니다. 한 달 후, 더 많은 읽기 트래픽을 처리하기 위해 RCU를 증가시키려 합니다. 어떻게 해야 할까요?

1.RCU는 증가, WCU는 동일하게 유지

2.RCU와 WCU 모두를 증가시켜야 함

3.RCU증가 및 WCU 감소

RCU와 WCU는 분리되어 있으므로, 각 값을 개별적으로 증가/감소시킬 수 있습니다.(1)

170.DynamoDB를 데이터베이스로 사용하는 전자 상거래 웹사이트가 있습니다. 곧 크리스마스 세일 기간에 들어갈 예정이며, 굉장히 인기가 높은 몇몇 항목들이 높은 조회수를 기록할 것으로 예상하고 있습니다. 안타깝게도 작년에는 높은 트래픽의 양으로 인해 ProvisionedThroughputExceededException 예외 처리 오류가 발생했었습니다. 이 오류의 재발을 방지하려면 어떻게 해야 할까요?

1.RCU를 아주 높은 값으로 설정

2.DAX클러스터 생성하기

3.세일 기간 중 데이터베이스를 DynamoDB 밖으로 이전시키기

DynamoDB Accelerator(DAX)는 완전 관리형에, 고가용성을 갖춘 DynamoDB 용 인메모리 캐시이며, 최대 10배까지 성능을 향상시켜 줍니다 이는 가장 자주 사용되는 데이터를 캐시해 DynamoDB 테이블의 핫 키에서 과도한 양의 읽기를 오프로딩 해주어 ‘ProvisionedThroughputExceededException’ 예외 처리 오류를 방지합니다.

171.DynamoDB를 데이터 저장소로 사용하는 모바일 애플리케이션을 개발했습니다. 신규 사용자가 가입한 후 환영 이메일을 자동으로 보내려고 합니다. 이를 달성하는 가장 효율적인 방법은 무엇일까요?

1.CloudWatch Event를 사용해 Lambda 함수를 매 분 실행하여 테이블에 등록된 새로운 사용자를 스캔하게 만들기

2.SNS와 DynamoDB 통합을 활성화

3.DynamoDB Streams을 활성화하고 이메일을 보내기 위해 Lambda 함수를 호출하도록 구성

DynamoDB Streams을 사용하면, DynamoDB 테이블의 항목 레벨 수정의 시간 순서를 파악할 수 있습니다. 이는 AWS Lambda에 통합되어 있기 때문에, 이벤트에 실시간으로 자동 응답하는 트리거를 생성할 수 있습니다.

172.서버리스 API를 생성하기 위해서는 Amazon API Gateway를 ......................와(과) 통합해야 합니다.

1.EC2 인스턴스

2.Elastic Load Balancing

3.AWS Lambda

3

173.엣지 최적화 API 게이트웨이를 사용할 경우, API Gateway가 모든 AWS 리전의 CloudFront 엣지 로케이션에 존재하게 됩니다.

1.아닙니다.

2.맞습니다.

엣지 최적화 API Gateway는 지리적으로 분산된 클라이언트에 가장 적합합니다. API 요청은 가장 가까운 CloudFront 엣지 로케이션으로 라우팅되며, 이는 지연 시간을 향상시킵니다. API Gateway는 여전히 하나의 AWS 리전에 존재합니다.(1)

174.여러분은 DynamoDB를 데이터 저장소로 활용하여 원활하고 지속적인 사용 경험을 제공하는 프로덕션 환경에서 애플리케이션을 실행하고 있습니다. 하지만 예측할 수 없는 대량의 요청을 테스트하려면 개발 모드에서도 애플리케이션을 실행해야 있습니다. 이런 경우에 제안할 수 있는 가장 경제적인 솔루션은 무엇입니까?

1.개발 및 프로덕션 환경 모두에서 오토 스케일링을 활성화하고 프로비저닝된 용량 모드를 사용한다.

2.프로덕션 환경에는 프로비저닝된 용량 모드 및 오토 스케일링을 사용하고 개발 환경에는 온디맨드 용량 모드를 사용한다.

3.개발 환경에는 프로비저닝된 용량 모드 및 오토 스케일링을 사용하고 프로덕션 환경에는 온디맨등 용량 모드를 사용한다.

4.개발 및 프로덕션 환경 모두에서 온디맨드 용량 모드를 사용한다.

- Provisioned Mode (default)

- 초당 읽기/쓰기 수를 예측하여 미리 지정

- 용량을 사전에 계획해야 함

- 프로비저닝된 읽기 용량 단위 (RCU) 및 쓰기 용량 단위 (WCU)에 대해 비용을 지불

- RCU 및 WCU에 대한 오토 스케일링 가능

- On-Demand Mode

- 읽기/쓰기가 작업량에 따라 자동으로 확장/축소

- 용량 계획이 필요하지 않음

- 사용한 만큼 비용을 지불하며, 비용이 더 비싸지만 ($$$) 사용량에 따라 유연하게 대응할 수 있음

- 예측할 수 없는 작업량이나 급격한 증가가 예상되는 경우에 적합(답:2)

175.CloudFront 배포를 통해 전역적으로 제공되는 애플리케이션이 있습니다. 인증 요청이 오리진까지 전달되게 하는 대신, CloudFront 엣지 로케이션에서 사용자를 인증하려 합니다. 이 요구 사항을 만족시키기 위해서는 어떤 방법을 사용해야 할까요?

1.Lambda@Edge

2.API Gateway

3.DynamoDB

4.AWS 글로벌 액셀러레이터

Lambda@Edge는 CloudFront의 기능으로, 사용자에 가깝게 코드를 실행하도록 해주어 성능을 향상시키고 지연 시간을 줄여 줍니다.

176.DynamoDB 테이블 내 항목의 최대 크기는 ...................입니다.

1.1 MB

2.500 KB

3.400 KB

4.400 MB

3

177.AWS 서비스(예: Lambda)를 사용해 서버리스 워크플로를 구축할 수 있으며 사람의 승인을 지원하는 AWS 서비스는 무엇입니까?

1.AWS Lambda

2.Amazon ECS

3.AWS Step Functions

4.AWS Storage Gateway

- Lambda 함수를 조율하기 위한 서버리스 워크플로우를 시각적으로 구축할 수 있는 서비스

- 기능: 시퀀스, 병렬 처리, 조건부 실행, 타임아웃, 오류 처리 등

- Lambda 함수 뿐만 아니라 EC2, ECS, 온프레미스 서버, API Gateway, SQS 큐 등 다양한 AWS 서비스와 통합 가능

- 사람이 개입해서 승인을 해야만 진행되는 단계를 설정할 수 있음

- 주문 처리, 데이터 처리, 웹 애플리케이션 등 구성하기 복잡한 다양한 워크플로우를 시각적으로 구성하려고 할 때 사용함(3)

178.한 회사가 Lambda, DynamoDB, Step Functions으로 구성된 AWS에 서버리스 애플리케이션을 보유하고 있습니다. 지난달에 애플리케이션으로 들어오는 요청 개수가 증가하여 DynamoDB 비용이 증가하였고 요청 처리 속도도 느려지기 시작했습니다. 추가 조사를 진행한 결과, 요청의 대부분은 DynamoDB 테이블의 쿼리에 대한 읽기 요청이었습니다. 스로틀링을 방지하고 비용을 효율적으로 절감하려면 어떤 방법을 사용해야 합니까?

1.Redis가 설치된 EC2인스턴스를 사용하고 이를 Lambda 함수와 DynamoDB테이블 사이에 위치시킨다.

2.DynamoDB를 Aurora로 마이그레이션하고 ElastiCache를 사용해 자주 요청되는 읽기 데이터를 캐싱한다.

3.DynamoDB를 S3으로 마이그레이션하고 CloudFront를 사용해 자주 요청되는 읽기 데이터를 캐싱한다.

4.DynamoDB 액셀러레이터(DAX)를 사용해 자주 요청되는 읽기 데이터를 캐싱한다.

- DynamoDB를 위한 완전 관리형 무결졀 인메모리 캐시

- DynamoDB 테이블에 읽기 작업이 많을 때 DAX 클러스터를 생성하고 데이터를 캐싱하여 읽기 혼잡을 해결함

- 캐시된 데이터에 대한 마이크로초 수준의 지연 시간

- 애플리케이션 로직 수정이 필요하지 않음 (기존 DynamoDB API와 호환됨)

- 캐시의 기본 TTL 기본값은 5분

- 이는 비용 효율적이고 스로틀링을 방지하는 데 도움이 됩니다.(마지막 줄은 GPT답변 추가함)

179.여러분이 DevOps 엔지니어로 일하고 있는 축구 회사에는 서버 쪽에 DynamoDB 테이블을 둔 웹 사이트가 있습니다. 현재 시청자 의견에 대한 보고서를 생성하기 위해 분석 팀과 함께 업무를 진행하고 있습니다. 분석 팀은 DynamoDB의 데이터를 JSON 포맷으로 S3 버킷에 호스팅한 다음, 거기서 작업을 시작하고 보고서를 생성하기를 원합니다. DynamoDB 데이터를 JSON 파일로 변환하는 데 가장 적합한 경제적인 방식은 무엇입니까?

1.DynamoDB 테이블을 선택하고 S3로 내보내기를 선택한다.

2.DynamoDB 데이터를 읽는 Lambda 함수를 만들어 JSON 파일로 변환하고 변환된 파일을 S3 버킷에 저장한다.

3.AWS Transfer Family를 사용한다.

4.AWS DataSync를 사용한다.

- DynamoDB JSON 또는 ION 형식으로 내보냄

- DynamoDB 내보내기를 사용하면 데이터를 특정 시점의 백업 또는 테이블 스캔을 통해 JSON 형식으로 S3 버킷으로 내보낼 수 있습니다.

180.AWS에 호스팅할 예정인 웹 사이트가 현재 개발 진행 중에 있습니다. 이 웹 사이트에는 로그인한 사용자의 사용자 세션과 자동 만료 시간을 저장하고, 만료된 사용자 세션을 삭제해야 한다는 요구 사항이 있습니다. 다음 중 이런 경우에 가장 적합한 AWS 서비스는 무엇입니까?

1.사용자 세션을 S3 버킷에 저장호고 S3 수명 주기 정책을 활성화한다.

2.사용자 세션을 EC2 인스턴스에 로컬로 저장한다.

3.사용자 세션을 DynamoDB 테이블에 저장하고 TTL을 활성화한다.

4.사용자 세션을 EFS 파일 시스템에 저장한다.

- DynamoDB: DynamoDB는 관리형 NoSQL 데이터베이스 서비스로, 빠르고 확장 가능한 성능을 제공합니다.

- 특히, DynamoDB의 TTL 속성을 사용하면 특정 시간 이후에 항목이 자동으로 삭제되도록 설정할 수 있습니다.

- TTL(Time-To-Live): TTL은 DynamoDB 항목의 만료 시간을 나타내는 속성으로, 이를 활성화하면 일정 시간이 지난 후 해당 항목이 자동으로 삭제됩니다. 사용자 세션의 자동 만료 및 삭제를 위해 TTL을 사용할 수 있습니다.(3)

181.여러분이 가진 모바일 애플리케이션에서 애플리케이션 사용자에게 S3 버킷에 있는 개인 공간에 액세스할 수 있는 권한을 부여하려고 합니다. 어떻게 해야 합니까?

1.각각의 애플리케이션 사용자에 대해 IAM 사용자 자격 증명 생성한다.

2.Amazon Cognito 아이덴티티 페더레이션을 사용한다.

3.ASML 아이덴티티 페더레이션을 사용한다.

4.버킷 정책을 사용해 버킷을 퍼블릭으로 만든다.

Amazon Cognito을 사용해 모바일 사용자 계정을 페더레이션하거나 사용자에게 IAM 권한을 제공할 수 있으며, 사용자는 이를 통해 S3 버킷에 있는 개인 공간에 액세스할 수 있습니다.

182.여러분은 AWS에 호스팅할 예정인 새로운 웹 및 모바일 애플리케이션을 개발하고 있으며, 현재 로그인 및 회원 가입 페이지를 구현하는 작업을 진행하고 있습니다. 애플리케이션 백엔드는 서버리스로 되어 있으며 구현에 Lambda, DynamoDB, API Gateway를 사용하고 있습니다. 다음 중 백엔드에 대한 인증을 구성하는 데 가장 쉽고 적합한 방식은 무엇입니까?

1.KMS로 암호화된 DynamoDB 테이블에 사용자의 자격 증명을 저장한다.

2.KMS로 암호화된 S3 버킷에 사용자의 자격 증명을 저장한다.

3.Cognito 사용자 풀을 사용한다.

4.사용자 자격 증명을 AWS Secrets Manager에 저장한다.

- Cognito 사용자 풀: Amazon Cognito는 AWS에서 제공하는 신뢰성 있고 확장 가능한 사용자 관리 및 인증 서비스입니다. Cognito를 사용하면 사용자를 위한 백엔드 인증 및 인증 서비스를 구축할 수 있습니다. 사용자 풀은 사용자 관리, 인증, 그룹화 등을 쉽게 설정하고 관리할 수 있는 서비스입니다.

- 간편한 설정: Cognito를 사용하면 몇 가지 간단한 설정만으로도 사용자 관리와 인증을 쉽게 구현할 수 있습니다. 사용자 풀을 통해 사용자 등록, 로그인, 비밀번호 재설정 등을 관리할 수 있습니다.

- 안전한 저장: Cognito 사용자 풀은 사용자의 자격 증명을 안전하게 저장하고 관리합니다. 사용자 풀을 통해 보안을 고려한 인증 및 인가 기능을 손쉽게 구현할 수 있습니다.

183.여러분이 운영 중인 모바일 애플리케이션에서 등록된 사용자들 모두 S3 버킷에 있는 자신의 폴더에서 이미지를 업로드 또는 다운로드할 수 있게 하려고 합니다. 또한 사용자들이 페이스북과 같은 소셜 미디어 계정을 통해 가입 및 로그인할 수 있게 하고자 합니다. 어떤 AWS 서비스는 사용해야 합니까?

1.AWS Identity and Access Management(IAM)

2.AWS IAM Identity Center

3.Amazon Cognito

4.Amazon CloudFront

Amazon Cognito를 사용하면 웹 및 모바일 앱에 사용자 가입, 로그인, 액세스 제어 기능을 쉽고 빠르게 추가할 수 있습니다. Amazon Cognito는 사용자를 수백만까지 확장할 수 있으며 SAML 2.0 및 OpenID Connect를 통해 Apple, Facebook, Google, Amazon과 같은 소셜 자격 증명 공급자 및 엔터프라이즈 자격 증명 공급자의 로그인을 지원합니다.

184.한 스타트업 회사가 AWS 상에서 자신들의 애플리케이션을 실행하려 합니다. 이 기업에서는 여러분을 솔루션 아키텍트로 고용해, 완전한 서버리스 REST API의 설계 및 구현을 맡겼습니다. 어떤 기술 스택을 사용하는 것을 추천할 수 있을까요?

1.API Gateway + AWS Lambda

2.애플리케이션 로드 밸런서(ALB)

3.Elastic Container Service(ECS) + Elastic Block Store(EBS)

4.Amazon CloudFront + S3

이 옵션은 서버리스 아키텍처의 대표적인 방식 중 하나입니다. API Gateway는 RESTful API를 쉽게 관리하고 배포할 수 있는 서비스이며, AWS Lambda는 코드를 실행하는 서버리스 컴퓨팅 서비스입니다. 이를 조합하여 간편하게 REST API를 구축할 수 있습니다. 장점으로는 확장성이 용이하고, 사용량에 따라 비용을 효율적으로 관리할 수 있습니다(1)

185.다음 AWS 서비스 중 즉시 사용 가능한 캐싱 기능이 없는 것을 고르세요

1.API Gateway

2.Lambda

3.DynamoDB

- Lambda는 즉시 사용 가능한 캐싱 기능을 가지고 있지 않습니다.

- API Gateway는 캐싱 설정을 통해 요청에 대한 응답을 캐싱할 수 있고, DynamoDB는 내장된 캐싱 기능은 아니지만 인메모리 캐싱을 구현할 수 있는 옵션이 있습니다.

- DynamoDB Accelerator(DAX)는 완전 관리형에, 고가용성을 갖춘 DynamoDB 용 인메모리 캐시이며, 초당 수백만 개의 요청이 있어도 최대 10배(밀리초에서 마이크로초까지)의 성능 향상을 제공해 줍니다. DAX는 개발자들이 캐시 무효화, 데이터 수집 혹은 클러스터 관리를 할 필요 없이 DynamoDB 테이블로 인메모리 가속을 추가하기 위한 모든 복잡한 작업을 수행할 수 있게 해줍니다.

186.사용자들에게 전역적으로 배포하고자 하는 대량의 정적 파일이 S3 버킷 내에 저장되어 있습니다. 이 경우, 다음 중 어떤 AWS 서비스를 선택해야 할까요?

1.S3 리전 간 복제

2.Amazon CloudFront

3.Amazon Route 53

4.API Gateway

Amazon CloudFront는 낮은 지연 시간과 빠른 전송 속도로 전역의 고객들에게 데이터, 영상, 애플리케이션 및 API를 전송해 주는 고속 콘텐츠 전송 네트워크(CDN)입니다. Amazon CloudFront에 딱 맞는 사용 사례입니다.

187.ap-northeast-1에 DynamoDB 테이블을 생성했으며, 이 테이블을 eu-west-1에서도 사용할 수 있도록 하기 위해 DynamoDB 글로벌 테이블을 생성하기로 했습니다. DynamoDB 글로벌 테이블을 생성하기 전에는 어떤 기능을 먼저 활성화해야 할까요?

1.DynamoDB 스트림

2.DynamoDB DAX

3.DynamoDB 버전 관리

4.DynamoDB 백업

DynamoDB Streams은 DynamoDB가 변경 로그를 가져오고, 이를 사용해 다른 AWS 리전에 있는 복제 테이블이 서로의 데이터를 복제할 수 있는 기능을 활성화해 줍니다

188.DynamoDB Streams을 사용해 DynamoDB 테이블로 항목이 추가될 때마다 Lambda 함수가 각 아이템을 실행하도록 구성한 상황입니다. 이 함수는 추후 장기적인 처리 업무를 위해 메시지를 SQS 대기열로 삽입하게 되어 있습니다. Lambda 함수를 매번 호출해보면 DynamoDB Stream을 읽을 수는 있으나 SQS 대기열로 메시지를 삽입하지는 못하는 것으로 보입니다. 이 경우, 무엇이 문제일까요?

1.SQS 대기열로 메시지를 삽입할 때는 Lambda를 사용할 수 없으므로, EC2 인스턴스를 대신 사용해야 함

2.Lambda 실행 IAM 역할에 권한이 없음

3.Lambda 보안 그룹이 SQS에 대한 아웃바운드 액세스를 허용해야만 함

4.SQS 보안 그룹이 AWS Lambda를 허용하도록 수정되어야 함

DynamoDB Streams를 사용하여 Lambda 함수를 트리거할 때, 해당 Lambda 함수는 실행되기 위한 IAM 역할을 가져야 합니다. 이 IAM 역할에는 DynamoDB에 대한 읽기 권한과 SQS에 메시지를 쓰기 위한 권한이 모두 포함되어야 합니다.

Lambda 함수를 트리거할 때 IAM 역할에 필요한 권한을 설정하지 않으면 Lambda 함수가 실행되더라도 필요한 작업을 수행할 수 없습니다. (2)

189.S3 버킷에 저장된 영상을 인코딩하고, 인코딩된 영상을 다시 S3 버킷으로 저장할 목적으로만 사용될 마이크로 서비스 애플리케이션의 아키텍처를 생성하려 합니다. 이 마이크로 서비스 애플리케이션의 신뢰도를 높이고, 실패 시 재시도할 수 있는 기능을 부여하고자 합니다. 각 영상 처리에는 최대 25분이 걸릴 수 있습니다. 아키텍처에 사용되는 서비스는 비동기적이어야 하며, 하루 동안 중지되었다가 그 다음 날 인코딩되지 않은 영상부터 다시 작업을 시작할 수 있는 기능을 포함해야 합니다. 이런 경우, 다음 중 어떤 AWS 서비스를 사용하는 게 권장될까요?

1.Amazon S3 + AWS Lambda

2.Amazon SNS + Amazon EC2

3.Amazon SQS + Amazon EC2

4.Amazon SQS + AWS Lambda

- 1.Lambda 함수와 S3를 함께 사용할 경우, Lambda 함수를 즉시 트리거해야 하므로 실행을 다음 날로 연기할 수 없습니다.

- 2.Amazon SNS를 사용할 경우, EC2 실패가 발생하더라도 메시지를 대기열로 다시 집어 넣어 재시도를 할 수 없습니다.

- 답:3.Amazon SQS를 사용하면 메시지를 며칠 간 보관하고 향후에 처리할 수 있으며, EC2 인스턴스를 중단할 수도 있습니다.

- 4.사용 가능한 방법이지만, Lambda 함수의 최대 실행 시간이 15분이기 때문에 이 경우에는 사용이 불가능합니다.

190.여러분은 전 세계에서 이미지를 다운로드하는 사진 공유 웹사이트를 실행하고 있습니다. 여러분은 15GB가 넘는 크기의 아름다운 산 이미지의 마스터 팩을 매 달 웹사이트에 게시합니다. 이 콘텐츠는 Elastic File System(EFS)에 호스팅되어 있으며, Application Load Balancer와 한 세트의 EC2 인스턴스을 통해 배포되었습니다. 여러분은 매달 높은 양의 트래픽을 경험하고 있으며, 이로 인해 EC2 인스턴스의 작업량과 네트워크 비용이 증가하고 있는 상황입니다. 웹사이트를 리팩터링하지 않고 EC2 부하와 네트워크 비용을 줄이기 위해서는 어떤 방법이 권장될까요?

1.마스터 팩을 S3으로 호스팅

2.Application Loda Balancer 캐싱 활성화

3.EC2 인스턴스 스케일 업

4.Amazon CloudFront 배포 생성

Amazon CloudFront는 낮은 지연 시간과 빠른 전송 속도로 전역의 고객들에게 데이터, 영상, 애플리케이션 및 API를 전송해 주는 고속 콘텐츠 전송 네트워크(CDN)입니다. Amazon CloudFront는 Application Load Balancer 앞에서 사용될 수 있습니다.(4)

191.이 AWS 서비스를 사용하면 실시간으로 초당 기가바이트의 데이터를 포착할 수 있고, 리플레이 기능을 통해 이러한 데이터를 여러 개의 소비 애플리케이션으로 전송할 수 있습니다.

1.Kinesis 데이터 스트림

2.Amazon S3

3.Amazon MQ

- 답:1.Amazon Kinesis Data Streams(KDS)은 확장성과 내구성이 뛰어난 실시간 데이터 스트리밍 서비스입니다. 이는 웹사이트, 클릭스트림, 데이터베이스 이벤트 스트림, 금융 거래, 소셜 미디어 피드, IT 로그 및 위치 추적 이벤트 등의 수백 개 소스로부터 초당 GB에 달하는 데이터를 지속적으로 포착할 수 있습니다.

- 2.Amazon S3은 객체 스토리지 서비스로, 재생 기능을 제공하지 않습니다.

- 3.Amazon MQ는 Apache ActiveMQ와 RabbitMQ 용 관리 메시지 브로커 서비스로 AWS 상에 간편하게 메시지 브로커를 설정하고 운용할 수 있게 해줍니다. MQTT와 같은 타 프로토콜을 지원해야 할 경우, Amazon SQS의 대용으로 사용할 수 있습니다.

192.다음 중 SQL 언어 호환성 및 삽입, 업데이트, 삭제와 같은 변환 프로세싱 기능을 통해 관계형 데이터셋의 저장을 보조해주는 데이터베이스는 무엇인가요?

1.Amazon Redshift

2.Amazon RDS

3.Amazon DynamoDB

4.Amazon ElastiCache

2

193.다음 중 Redis API와 호환이 가능한 캐싱 기능을 제공하는 AWS 서비스는 무엇인가요?

1.Amazon RDS

2.Amazon DynamoDB

3.Amazon ElastiSearch

4.Amazon ElastiCache

Amazon ElastiCache는 완전 관리형 인메모리 데이터 스토어로, Redis 혹은 Memcahched와 호환이 가능합니다.

194.온프레미스 MongoDB NoSQL 데이터베이스를 AWS로 이전하려 합니다. 데이터베이스 서버를 관리하고 싶지 않기 때문에 고가용성 및 높은 내구성과 신뢰성을 제공하며, 가급적이면 서버리스인 관리형 NoSQL 데이터베이스를 사용하려 합니다. 이런 경우, 어떤 데이터베이스를 선택해야 할까요?

1.Amazon RDS

2.Amazon DynamoDB

3.Amazon Redshift

4.Amazon Aurora

Amazon DynamoDB는 키-값, 문서, NoSQL 데이터베이스입니다.

195.여러분은 온라인 트랜잭션 프로세싱(OLTP)을 수행하려 합니다. 이 작업에는 오토 스케일링 기능이 내장되어 있고, 기반 스토리지에 대해 최대 복제본 수를 제공하는 데이터베이스를 사용하고자 합니다. 이 경우, 다음 중 어떤 AWS 서비스를 추천할 수 있을까요?

1.Amazon ElastiCache

2.Amazon Redshift

3.Amazon Aurora

4.Amazon RDS

Amazon Aurora는 MySQL 및 PostgreSQL과 호환이 가능한 관계형 데이터베이스입니다. Aurora는 데이터베이스 인스턴스 당 최대 128TB까지 자동 스케일 업하는 분산형, 내결함성 자가 복구 스토리지 시스템이라는 것이 특징입니다. 최대 15개의 지연 시간이 낮은 읽기 전용 복제본, 지정 시간 복구, Amazon S3로의 지속적인 백업, 그리고 3개의 AZ에 대한 복제를 통해 높은 성능과 고가용성을 제공합니다.

196.한 스타트업 회사가 솔루션 아키텍트인 여러분에게 사용자들이 서로 친구가 될 수 있고, 서로의 포스트에 좋아요를 남길 수 있는 소셜 미디어 웹사이트 아키텍처의 구축을 도와달라고 한 상황입니다. 이 회사는 ‘Mike의 친구들이 남긴 포스트에는 몇 개의 좋아요가 있는가?’와 같은 복잡한 쿼리를 수행하려 합니다. 이 경우, 어떤 데이터베이스의 사용을 추천할 수 있을까요?

1.Amazon RDS

2.Amazon Redshift

3.Amazon Neptune

4.Amazon ElastiSearch

Amazon Neptune은 빠르고, 신뢰도가 높은 완전 관리형 그래프 데이터베이스 서비스로 고도로 연결된 데이터셋을 처리하는 애플리케이션을 구축하고 실행하는 데에 도움을 줍니다.

197.각각의 크기가 100MB인 한 세트의 파일들이 있는데, 이 파일을 안전하고 내구성이 높은 키-값 스토어에 저장하려 합니다. 이 경우, 다음 중 어떤 AWS 서비스를 사용하는 게 권장될까요?

1.Amazon Athena

2.Amazon S3

3.Amazon DynamoDB

4.Amazon ElastiCache

Amazon S3는 키-값 스토어가 맞습니다(키는 버킷 내 객체의 전체 경로입니다)!

198.회사의 온프레미스 웹 사이트는 프런트엔드에 ReactJS를 사용하고, 백엔드에 NodeJS를 사용하며 데이터 베이스로 MongoDB를 사용합니다. MongoDB 데이터베이스를 자체 호스팅하려면 여러 유지 보수 작업이 필요한데 이런 문제를 처리할 수 있는 인력과 경험이 부족하여 몇 가지 문제가 발생하고 있습니다. 결국 웹 사이트를 AWS 서버로 옮기기로 결정하였고, ReactJS 프런트엔드 애플리케이션은 S3 버킷에서 호스팅하고 NodeJS 백엔드는 EC2 인스턴스 세트에서 호스팅하기로 했습니다. 코드 변경 없이 높은 확장성과 가용성을 제공하는 MongoDB 데이터베이스를 마이그레이션하려면 어떤 AWS 서비스를 사용해야 합니까?

1.Amazon ElastiCache

2.Amazon DocumentDB

3.Amazon RDS for MongoDB

4.Amazon Neptune

2

199.회사에서 자체 호스팅 중인 온프레미스 Apache Cassandra 데이터베이스를 AWS로 이전하려고 합니다. 다음 중 완전 관리형이면서 가용성 높고 확장 가능한 Apache Cassandra 데이터베이스를 제공하는 AWS 서비스는 무엇입니까?

1.Amazon DocumentDB

2.Amazon DynamoDB

3.Amazon Timestream

4.Amazon Keyspaces

4

200.한 온라인 결제 기업은 자사 인프라를 호스팅하는 데 AWS를 사용하고 있습니다. 애플리케이션 특성상 신용거래, 직불거래와 같은 금융 거래에 대해 정확한 기록을 저장해야 한다는 엄격한 요구 사항이 있습니다. 이러한 거래 기록은 안전하고 변경이 불가능하며 암호화되어 있는 저장소에 저장해야 하고, 암호학적으로 검증이 가능해야 합니다. 이런 사례에 가장 적합한 AWS 서비스는 무엇입니까?

1.Amazon DocumentDB

2.Amazon Aurora

3.Amazon QLDB

4.Amazon Neptune

3

201.한 스타트업에서 기후 변화로 인한 산불 발생을 줄이기 위해 새로운 프로젝트를 진행하고 있습니다. 업체에서는 개발 중인 센서를 숲 전체에 뿌려 산불이 발생하기 전에 이를 감지하는 데 도움이 될만 한 온도, 습도, 기압과 같은 데이터를 수집하려고 합니다. 업체는 매초 다양한 수치를 읽어 저장할 수 있는 수천 개의 센서를 생산할 예정입니다. 센서는 화재 발생 가능성을 예측할 수 있도록 읽어들인 수치를 저장하고 빠르게 분석할 수 있어야 합니다. 이런 경우 데이터 저장에 사용할 수 있는 AWS 서비스는 무엇입니까?

1.Amazon Timestream

2.Amazon Neptune

3.Amazon S3

4.Amazon ElastiCache

1

202.대량의 컬럼형 데이터에 대해 분석 쿼리를 효율적으로 수행할 수 있는 데이터베이스를 구성하고자 합니다. 이 데이터 웨어하우스에 Amazon QuickSight와 같은 보고 및 대시보드 도구를 연결해 사용하려고 합니다. 가장 적합한 AWS 기술을 무엇입니까?

1.Amazon RDS

2.Amazon S3

3.Amazon Redshift

4.Amazon Neptune

3

203.S3 버킷에 저장된 수많은 로그 파일이 저장되어 있습니다. 가능하다면 서버리스로 로그를 필터링하는 간단한 분석 작업을 수행하여 허용되지 않은 작업을 시도한 사용자를 찾으려고 합니다. 이런 경우에 사용할 수 있는 AWS 서비스는 무엇입니까?

1.Amazon DynamoDB

2.Amazon Redshift

3.S3 Glacier

4.Amazon Athena

4

204.솔루션 아키텍트로서 Redshift 클러스터에 대한 재해 복구 계획을 수립하는 업무를 맡았습니다. 어떤 작업을 해야 합니까?

1.다중 AZ를 활성화한다.

2.자동 스냅샷을 활성화한 다음, Redshift 클러스터가 스냅샷을 다른 AWS 리전으로 자동 복사하도록 설정한다.

3.스냅샷을 만들고 Redshift 글로벌 클러스터로 복원한다.

2

205.Redshift에서 클러스터와 데이터 저장소 사이의 모든 COPY와 UNLOAD 트래픽이 VPC를 통하도록 강제하는 기능은 무엇입니까?

1.향상된 VPC 라우팅

2.개선된 VPC 라우팅

3.Redshift Spectrum

1

206.DynamoDB를 데이터 스토어로 사용하는 게임 웹 사이트를 운영하고 있습니다. 사용자들은 가능하다면 부분 일치하는 결과도 포함하여 이름으로 다른 게이머를 찾을 수 있는 검색 기능을 요청해왔습니다. 이 기능을 구현하는 데 적합한 AWS 기술은 무엇입니까?

1.Amazon DynamoDB

2.Amazon Redshift

3.Amazon OpenSearch

4.Amazon Neptune

3

207.이 AWS 서비스를 사용하면 몇 번의 클릭만으로 ETL(추출, 변환, 로드) 작업을 생성, 실행, 모니터링할 수 있습니다.

1.AWS Glue

2.Amazon Redshift

3.Amazon RDS

4.Amazon DynamoDB

1

208.한 회사가 AWS를 사용해 자사의 공용 웹 사이트와 내부 애플리케이션을 호스팅하고 있습니다. 이들 웹 사이트와 애플리케이션에서는 수많은 로그 및 트레이스가 생성됩니다. 로그를 중앙 집중식으로 저장하여 실시간으로 검색하고 분석해 오류와 악의적인 시도를 감지할 수 있도록 만들어야 합니다. 로그를 효율적으로 저장하고 분석하는 데 도움이 되는 AWS 서비스는 무엇입니까?

1.Amazon S3

2.Amazon OpenSearch service

3.Amazon ElastiCache

4.Amazon QLDB

2

209.………………………는 데이터 엔지니어와 분석가가 클러스터를 운영하거나 관리할 필요 없이 Apache Spark, Hive, Presto와 같은 오픈 소스 빅데이터 프레임워크로 구축된 애플리케이션을 쉽고 경제적으로 실행할 수 있게 해줍니다.

1.AWS Lambda

2.Amazon EMR

3.Amazon Athena

4.Amazon OpenSearch Service

2

210.한 전자 상거래 기업은 주문 내역, 고객 정보, 이익, 전년도 매출과 같은 모든 과거 데이터를 Redshift 클러스터에 호스팅하고 있습니다. 전년도 이익과 총매출액을 표시하는 대시보드 및 보고서를 생성해야 한다는 요구 사항이 있었기 때문에, 내년에도 같은 요구 사항이 있을 것으로 보입니다. DevOps 팀은 이와 같은 대시보드를 정의할 수 있고 기본적으로 Redshift와 통합이 가능한 AWS 서비스를 찾는 업무를 맡았습니다. 가장 적합한 AWS 서비스는 무엇입니까?

1.Amazon OpenSearch Service

2.Amazon Athena

3.Amazon QuitSight

4.Amazon EMR

3

211.AWS Glue에서 앞선 Glue ETL 작업 실행 중에 이미 처리된 데이터를 저장하고 추적할 수 있게 해주는 기능은 무엇입니까?

1.Glue Job Bookmarks

2.Glue Elastic Views

3.Glue Streaming ETL

4.Glue DataBrew

1

212.여러분이 DevOps 엔지니어로 일하고 있는 머신 러닝 기업은 S3 버킷에 3TB의 JSON 파일을 저장하고 있습니다. Amazon Athena를 사용해 이 파일에 대한 분석 작업을 수행해야 한다는 요구 사항이 있어 파일 포맷을 JSON에서 Apache Parquet으로 변환하는 방법을 찾고 있습니다. 가장 적합한 AWS 서비스는 무엇입니까?

1.S3 객체 버전 관리

2.Kinesis Data Streams

3.Amazon MSK

4.AWS Glue

4

213.온프레미스 Apache Kafka와 함께 사용하여 여러 웹 사이트로부터 클릭 스트림 이벤트 스트림을 받는 온프레미스 애플리케이션이 있습니다. 이 애플리케이션을 코드 변경 없이 가능한 한 빨리 마이그레이션해야 합니다. 애플리케이션을 EC2 인스턴스에 호스팅하기로 결정했을 때, Apache Kafka를 마이그레이션하기에 가장 적합한 서비스는 무엇입니까?

1.Kinesis Data Streams

2.AWS Glue

3.Amazon MSK

4.Kinesis Data Analytics

3

214.RDS, S3 버킷에 데이터가 저장되어 있고, 데이터에 대한 분석 작업을 수행할 수 있도록 AWS Lake Formation을 데이터 레이크로 사용해 수집, 이동 및 분류하고 있습니다. 회사에는 빅데이터 개발자와 ML 엔지니어가 아주 많기 때문에 민감 정보가 포함되었을 수도 있는 일부 데이터에 대해서는 접근을 제한하려고 합니다. 이런 경우 무엇을 사용해야 합니까?

1.AWS Lake Formation 세분화된 액세스 제어

2.Amazon Cognito

3.AWS Shield

4.S3 객체잠금

1

215.데이터 스트림에 대한 실시간 분석 작업을 수행하기에 가장 적합한 AWS 서비스는 무엇입니까?

1.Amazon SQS

2.Amazon SNS

3.Amazon Kinesis Data Analytics

4.Amazon Kinesis Data Firehose

3

216.(참/거짓) 딥 러닝을 이용해 텍스트를 생동감 있는 음성으로 변환하기 위해서는 Amazon Transcribe를 사용해야 합니다.

1.참

2.거짓

Amazon Transcribe는 고객들로 하여금 음성을 텍스트로 손쉽게 변환할 수 있도록 해주는 AWS 서비스입니다. Amazon Polly는 텍스트를 생동감 있는 음성으로 변환해 주는 서비스입니다.

217.한 회사가 음성을 텍스트로 변환해 주고, 고객의 의도를 인식할 수 있는 챗봇을 구현하려 합니다. 이런 경우, 어떤 서비스를 이용해야 할까요?

1.Transcribe

2.Rekognition

3.Connect

4.Lex

Amazon Lex는 음성 및 텍스트를 사용하는 애플리케이션에 대화형 인터페이스 구축을 위한 서비스입니다. Lex는 음성을 텍스트로 변환하기 위한 고급 자동 음성 인식(ASR) 딥 러닝 기능과 텍스트의 의도를 인식하는 자연어 이해(NLU) 기능을 제공함으로써 매력적인 사용자 경험을 제공하고 현실 같은 대화형 상호 작용이 가능한 애플리케이션을 구축할 수 있도록 해줍니다

218.다음 완전 관리형 서비스 중, 높은 정확성의 예측을 제공하는 서비스는?

1.Personalize

2.SageMaker

3.Lex

4.Forecast

Amazon Forecast는 머신 러닝을 이용해 매우 정확한 예측을 제공하는 완전 관리형 서비스입니다.

219.사진과 영상에서 물체, 사람, 텍스트, 혹은 장면을 찾으려 합니다. 이 경우 어떤 AWS 서비스를 사용해야 할까요?

1.Rekognition

2.Polly

3.Kendra

4.Lex

Amazon Rekognition은 확장성이 좋은 입증된 딥 러닝 기술로, 전문 지식 없이도 머신 러닝을 이용한 사진 및 영상 분석 기능을 손쉽게 애플리케이션에 추가할 수 있도록 해줍니다.

220.어느 스타트업 기업이 맞춤형 사용자 경험을 제공하고자 합니다. 이 경우 어떤 AWS 서비스를 사용해야 할까요?

1.Personalize

2.Kendra

3.Connect

Amazon Personalize는 개발자로 하여금 애플리케이션을 사용하는 고객들에 대한 맞춤형 추천을 손쉽게 생성할 수 있도록 해주는 머신 러닝 서비스입니다

221.어느 연구 팀이 자연어 처리(NLP)를 통해 논문을 주제 별로 묶으려 합니다. 이 경우 어떤 서비스를 사용해야 할까요?

1.Translate

2.Comprehend

3.Lex

4.Rekognition

Amazon Comprehend는 머신 러닝을 사용해 텍스트 내의 의미와 인사이트를 파악해 주는 자연어 처리(NLP) 서비스입니다.

222.어느 기업이 자연스럽고 정확한 단어를 사용해 문서를 다양한 언어로 번역하려 합니다. 이 경우 어떤 서비스를 사용해야 할까요?

1.Transcribe

2.Polly

3.Translate

4.WordTranslator

Amazon Translate는 빠르고, 품질이 높으며 합리적인 비용의 언어 번역을 제공하는 신경망 머신 번역 서비스입니다.

223.한 개발자가 머신 러닝 모델을 빠르게 구축, 훈련 및 배포를 하려 합니다. 이 경우 어떤 서비스를 사용해야 할까요?

1.SageMaker

2.Polly

3.Comprehend

4.Personalize

Amazon SageMaker는 모든 개발자 및 데이터 과학자가 머신 러닝(ML) 모델을 빠르게 구축, 훈련 및 배포할 수 있도록 해주는 완전 관리형 서비스입니다. SageMaker를 사용하면 고품질 모델을 개발을 쉽게 만들어 줌으로써, 머신 러닝 프로세스를 용이하게 합니다.

224.다음 AWS 서비스 중 음성-텍스트 변환을 용이하게 해주는 서비스는 무엇인가요?

1.Connect

2.Translate

3.Transcribe

4.Polly

Amazon Transcribe는 고객들로 하여금 음성을 텍스트로 손쉽게 변환할 수 있도록 해주는 AWS 서비스입니다.

225.다음 서비스 중 머신 러닝에 의해 구동되는 문서 검색 서비스는 무엇인가요?

1.Forecast

2.Kendra

3.Comprehend

4.Polly

Amazon Kendra는 머신 러닝에 의해 가동되는, 높은 정확성으로 사용이 용이한 기업 검색 서비스입니다.

226.한 회사에서 전 세계 고객들이 이용하는 이미지 및 동영상 공유 플랫폼을 운영하고 있습니다. 이 플랫폼은 AWS에서 운영되고 있으며 S3 버킷을 사용해 이미지와 동영상을 호스팅하고, 클라우드 프론트를 CDN으로 사용해 전 세계 고객들에게 지연 시간이 거의 없이 콘텐츠를 제공하고 있습니다. 지난 몇 달 동안 부적절한 콘텐츠가 보이기 시작했다는 불만을 표한 고객이 많았고, 지난주에는 불만 사항 접수가 늘어나기 시작했습니다. 플랫폼에 게시하기 전에 이미지와 동영상을 직원이 수동으로 승인하는 방식에는 아주 많은 시간과 비용이 소요됩니다. 플랫폼의 요구 사항은 부적절하고 불쾌한 이미지와 동영상을 자동으로 감지하고 수동으로 검토할 항목을 표시할 수 있도록 최소 신뢰 임계값 설정 기능을 제공하는 솔루션을 찾는 것입니다. 이런 요구 사항을 충족할 수 있는 AWS 서비스는 무엇입니까?

1.Amazon Polly

2.Amazon Translate

3.Amazon Lex

4.Amazon Rekognition

Amazon Rekognition은 이미지 및 비디오 분석을 위한 기능을 제공하며, 부적절한 콘텐츠, 성인 콘텐츠, 폭력적인 콘텐츠 등을 감지할 수 있는 기능을 가지고 있습니다.

227.전화 통화로 의사와 진료 예약을 할 수 있는 서비스를 제공하는 온라인 의료 회사가 AWS를 사용해 인프라를 호스팅하 고 있습니다. 해당 서비스는 Amazon Connect와 Amazon Lex를 사용하여 전화 수신 및 워크플로 생성, 진료 예약, 진료비 결제를 처리합니다. 회사 방침에 따라 모든 통화는 검토를 위해 녹음되어야 합니다. 하지만 통화를 저장하기 전에 통화 내용에서 개인 식별 가능 정보(PII)를 제거해야 한다는 요구 사항이 있습니다. 통화에서 PII를 삭제하는 데 도움이 되는 서비스는 무엇입니까?