서론

최근 머신 러닝 연구에서 그로킹(Grokking)이라는 현상이 주목받고 있습니다. 이는 모델이 훈련 데이터를 완전히 암기한 후, 오랜 시간이 지나서야 갑자기 보지 못한 데이터에 대해 정확하게 예측하는 현상입니다. 그로킹은 단순히 데이터의 패턴을 학습하는 것을 넘어, 모델이 문제의 본질을 깊이 이해하게 되는 과정으로 볼 수 있습니다. 이번 칼럼에서는 그로킹의 원리와 이를 유도하는 외부 요인들, 그리고 그로킹이 가지는 의미와 잠재력을 탐구해보겠습니다.

용어의 의미

먼저 "그로킹(Grokking)"이라는 용어는 로버트 하인라인의 SF 소설 '낯선 땅 이방인(Stranger in a Strange Land)'에서 처음 사용된 단어로, 깊이 이해하고 완전히 터득한다는 의미를 가지고 있습니다. 한국어로 적절하게 번역하기는 어렵지만, '완전히 이해하다', '본질을 꿰뚫다', '심층적으로 파악하다’ 같은 의미로 해석해볼 수 있다. 딥러닝에서는 모델이 데이터의 패턴을 학습한것이 아니라 데이터의 본질적인 특성과 관계를 깊이 이해하고 이를 바탕으로 정확한 예측을 할 수 있는 상태를 '그로킹에 도달했다'고 할 수 있습니다.

그로킹이란

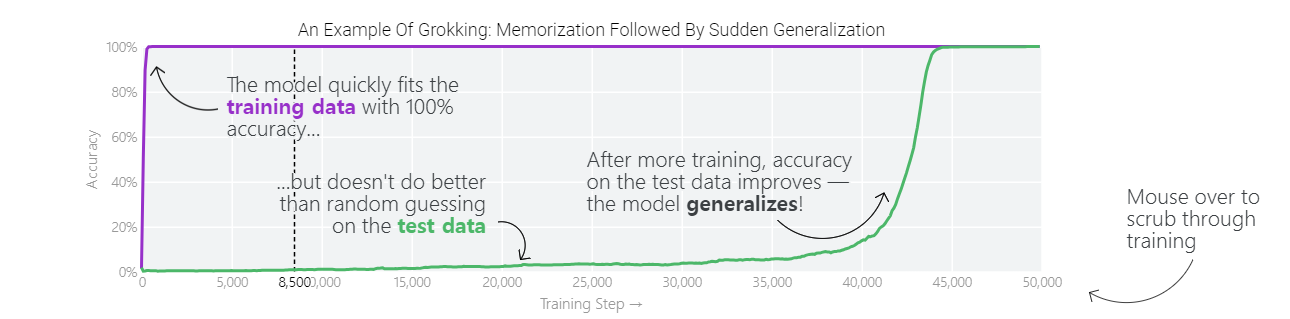

그로킹은 머신 러닝 모델이 훈련 데이터에 대해 과적합(overfitting)한 상태에서, 충분한 훈련 시간을 거친 후 테스트 데이터에 대해 일반화(generalization)된 성능을 보이는 현상을 말합니다. 일반적으로 모델은 훈련 데이터를 학습하면서 점차적으로 테스트 데이터에 대한 성능이 향상되지만, 그로킹 현상에서는 이러한 전환이 매우 갑작스럽게 일어납니다.

그로킹의 발생 조건

그로킹은 자연발생적인 현상이 아니며, 특정 외부 요인들에 의해 유도될 수 있습니다. 이러한 외부 요인들은 다음과 같습니다.

- 모델 크기 축소:

- 작은 모델은 복잡한 패턴을 암기하기보다는 더 단순한 일반화된 패턴을 학습하는 경향이 있습니다. 이는 모델의 파라미터 수를 줄여 과적합을 방지하는 효과를 가져옵니다.

- 가중치 감소 (Weight Decay):

- 가중치 감소는 모델의 가중치 크기를 제한하여 과적합을 방지합니다. 적절한 가중치 감소는 모델이 훈련 데이터의 세부사항을 암기하는 것을 방지하고, 더 일반화된 솔루션을 학습하도록 돕습니다.

- 충분한 훈련 시간:

- 모델이 충분히 오랜 시간 동안 훈련되면, 초기에는 과적합 상태에 머물다가 점차 일반화된 패턴을 학습하게 됩니다. 이는 모델이 초기의 암기 단계에서 벗어나 진정한 이해의 단계로 나아가게 합니다.

- 데이터 크기와 다양성:

- 충분히 큰 데이터셋과 다양한 데이터는 모델이 더 일반화된 패턴을 학습하는 데 도움이 됩니다. 작은 데이터셋은 과적합을 유발할 수 있습니다.

- 정규화 기법 (Regularization Techniques):

- 드롭아웃(Dropout), 배치 정규화(Batch Normalization) 등의 기법은 모델이 특정 패턴을 암기하지 않고, 보다 일반화된 패턴을 학습하도록 합니다.

큰 모델에서 그로킹 현상이 사용되기 어려운 이유

그로킹 현상은 주로 작은 모델에서 관찰되어지는데, 큰 모델에서는 발생하기 어렵다고 알려져있다. 그로킹 현상이 발생하기 어려운 이유를 살펴보면,

- 복잡한 구조와 많은 파라미터:

- 큰 모델은 많은 파라미터를 가지고 있어 과적합의 위험이 더 큽니다. 이러한 모델은 훈련 데이터에 대한 복잡한 패턴을 쉽게 암기할 수 있어 일반화된 패턴을 학습하기 어려울 수 있습니다.

- 작은 모델과 달리, 큰 모델은 다양한 데이터 패턴을 학습할 수 있기 때문에 그로킹 현상이 명확하게 관찰되지 않을 수 있습니다.

- 훈련 시간과 자원:

- 큰 모델을 충분히 훈련시키기 위해서는 많은 시간과 컴퓨팅 자원이 필요합니다. 그로킹 현상을 유도하기 위해서는 긴 훈련 시간이 필요할 수 있는데, 이는 현실적으로 어려울 수 있습니다.

- 작은 모델은 상대적으로 적은 자원으로도 충분한 훈련을 할 수 있지만, 큰 모델은 그렇지 않습니다.

- 정교한 하이퍼파라미터 튜닝:

- 그로킹 현상을 유도하기 위해서는 적절한 하이퍼파라미터 설정이 필요합니다. 큰 모델에서는 하이퍼파라미터 튜닝이 더 복잡하고 시간이 많이 걸릴 수 있습니다.

- 예를 들어, 가중치 감소 비율이나 학습률 등의 하이퍼파라미터를 최적화하는 과정이 더 복잡합니다.

그로킹의 의미와 잠재력

그로킹 현상은 머신 러닝 연구자들에게 몇 가지 중요한 시사점을 제공합니다.

첫째, 모델이 과적합을 넘어서는 과정에서 어떤 메커니즘이 작용하는지 이해하는 데 도움이 됩니다. 이는 모델의 학습 과정을 보다 정교하게 조절할 수 있는 기회를 제공합니다.

둘째, 그로킹은 더 나은 일반화 성능을 갖춘 모델을 개발하는 데 기여할 수 있습니다. 이는 실세계 데이터에 대해 보다 정확하고 신뢰성 있는 예측을 가능하게 합니다.

셋째, 그로킹 연구는 인공지능의 이해 능력을 향상시키는 데 중요한 역할을 할 수 있습니다. 모델이 단순히 데이터를 암기하는 것을 넘어, 문제의 본질을 이해하고 일반화된 솔루션을 찾는 과정은 인공지능의 진정한 발전을 의미합니다.

결론

그로킹 현상은 모델이 일반화된 패턴을 학습하는 과정을 통해 설명력을 증가시킬 가능성이 있습니다. 이는 모델이 더 일관된 예측을 제공하고, 내부 구조를 이해하기 쉽게 만들어 설명력을 높일 수 있습니다. 그러나 그로킹이 항상 설명력을 증가시키는 것은 아니며, 모델의 복잡성이나 패턴의 비선형성에 따라 설명력이 오히려 감소할 수도 있습니다. 따라서, 그로킹 현상을 활용하여 모델의 설명력을 높이기 위해서는 모델의 학습 과정과 결과를 면밀히 분석하고, 이해 가능한 패턴을 찾는 노력이 필요합니다.

-5기 조현성