💎 Scrapy에서 간단하게 fake-useragent 방법을 정리하겠다.

구글에서 scrapy fake useragent 검색을 하면 잘 나온다.

아무래도 크롤링을 하다 보면 User Agent 정보를 headers에 추가해서 전달해줘야 한다. 크롤링 봇일 경우에는 정보를 주지 않는 곳이 꽤 많다.

scrapy-fake-useragent를 사용하면 UserAgent 값을 랜덤으로 생성해 준다.

fake-useragent 설치

간단하게 pip 명령어로 설치 한다.

# scrapy-fake-useragent 설치

pip install scrapy-fake-useragentSetting.py 설정

기본 제공 UserAgentMiddleware 및 RetryMiddleware를 주석 처리 해야한다. Scrapy 버전에 따라 Setting.py를 추가한다.

# 기존에 사용하던 User-agent 설정 주석처리

# USER_AGENT = 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) ~~~~*'

# Scrapy 버전 >=1.0:

DOWNLOADER_MIDDLEWARES = {

'scrapy.downloadermiddlewares.useragent.UserAgentMiddleware': None,

'scrapy.downloadermiddlewares.retry.RetryMiddleware': None,

'scrapy_fake_useragent.middleware.RandomUserAgentMiddleware': 400,

'scrapy_fake_useragent.middleware.RetryUserAgentMiddleware': 401,

}

# Scrapy 버전 <1.0:

DOWNLOADER_MIDDLEWARES = {

'scrapy.contrib.downloadermiddleware.useragent.UserAgentMiddleware': None,

'scrapy.contrib.downloadermiddleware.retry.RetryMiddleware': None,

'scrapy_fake_useragent.middleware.RandomUserAgentMiddleware': 400,

'scrapy_fake_useragent.middleware.RetryUserAgentMiddleware': 401,

}

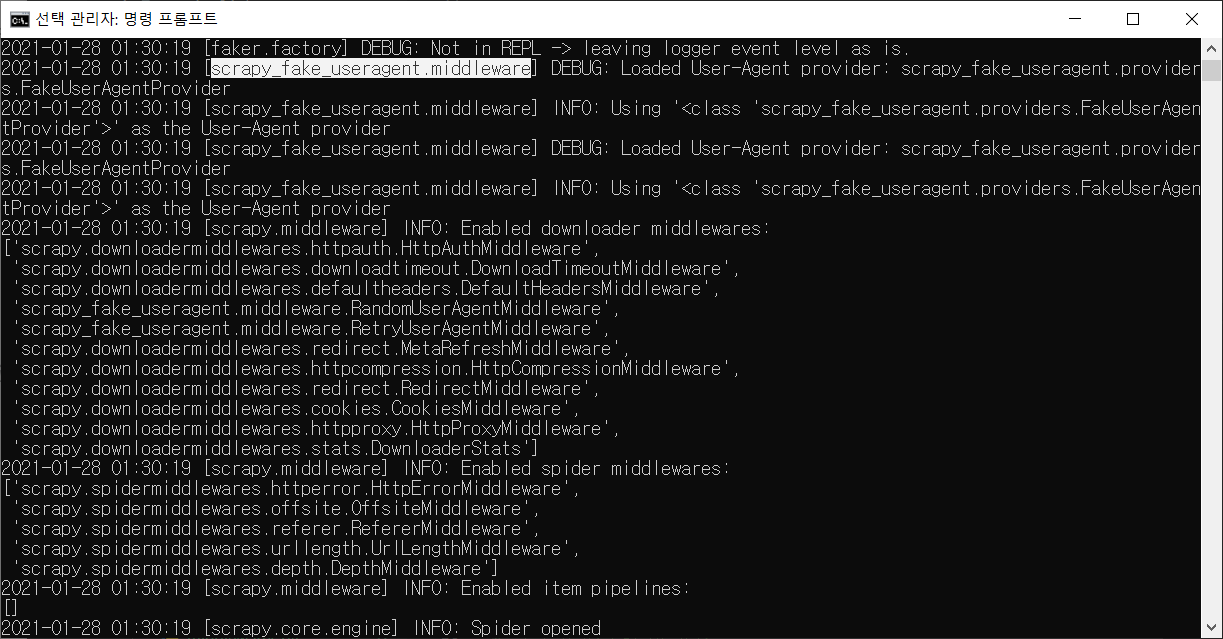

실행하면 scrapy-fake-useragent를 확인 할 수 있다.

✍scrapy-fake-useragent github 링크로 들어가면 자세한 내용을 확인 할 수 있다.