DEEP LEARNING BASIC

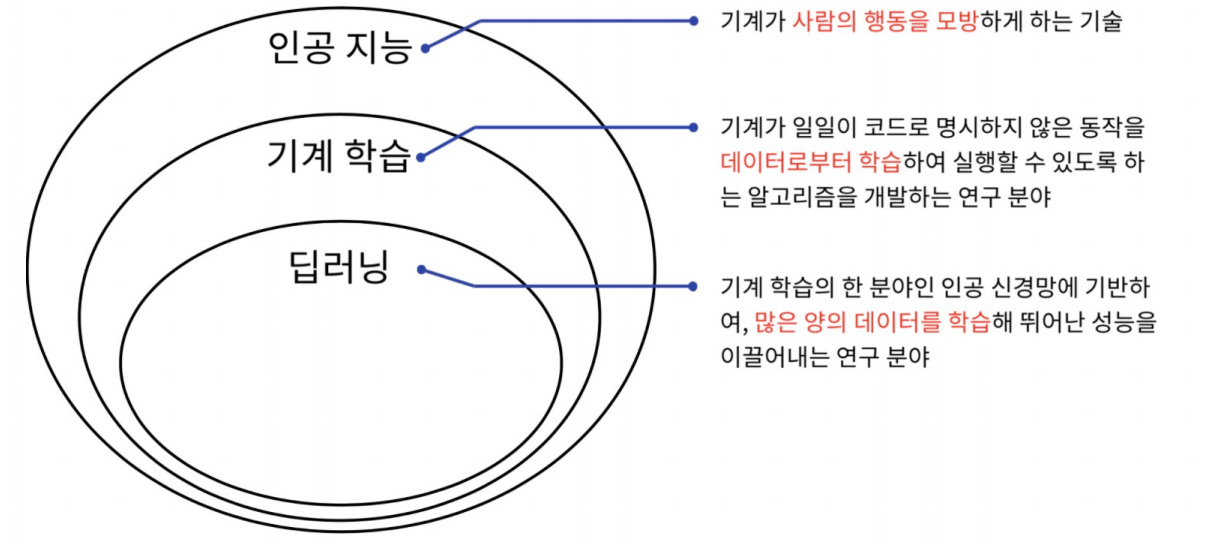

딥러닝의 정의

인공지능 vs 기계학습 vs 딥러닝

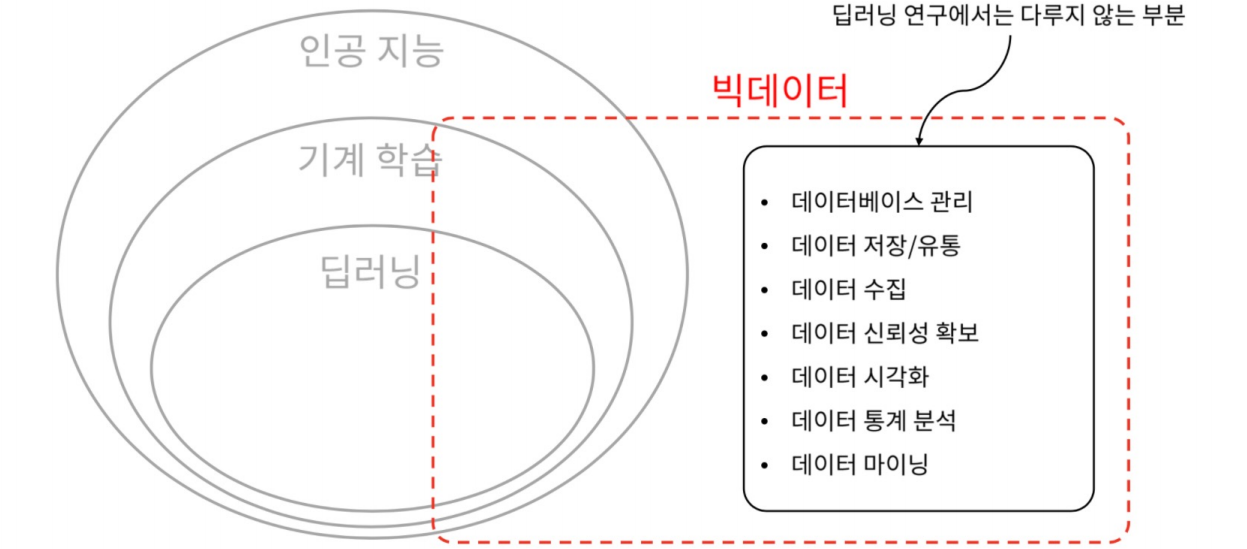

딥러닝 vs 빅데이터

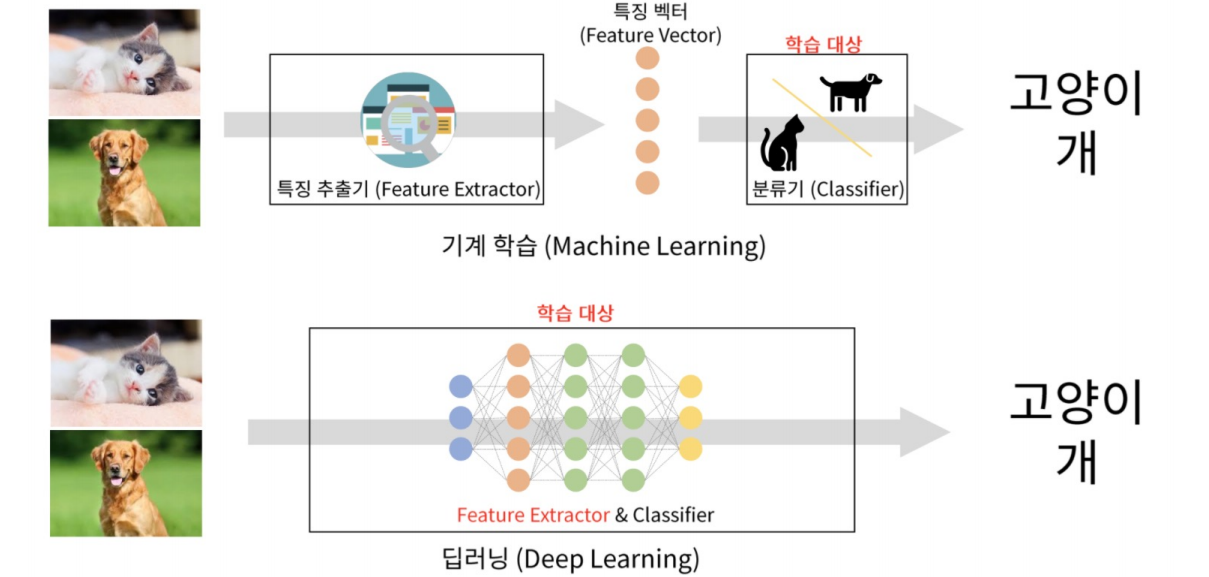

기계학습 vs 딥러닝

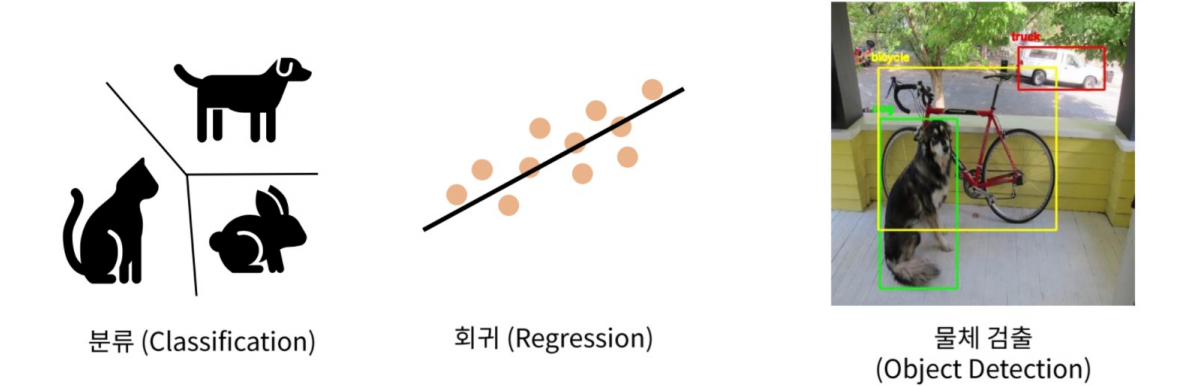

딥러닝으로 가능한 작업_1

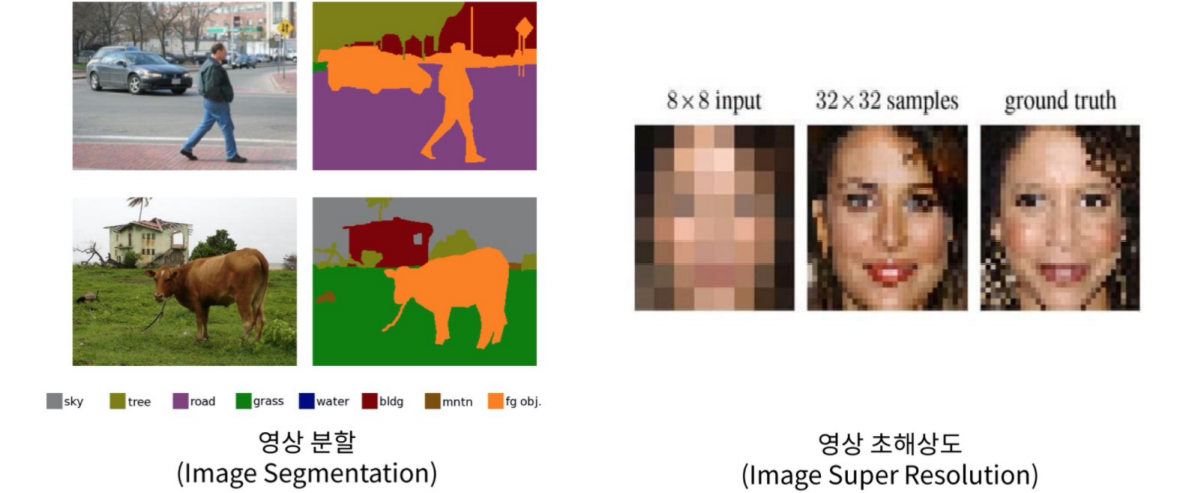

딥러닝으로 가능한 작업_2

딥러닝으로 가능한 작업_3

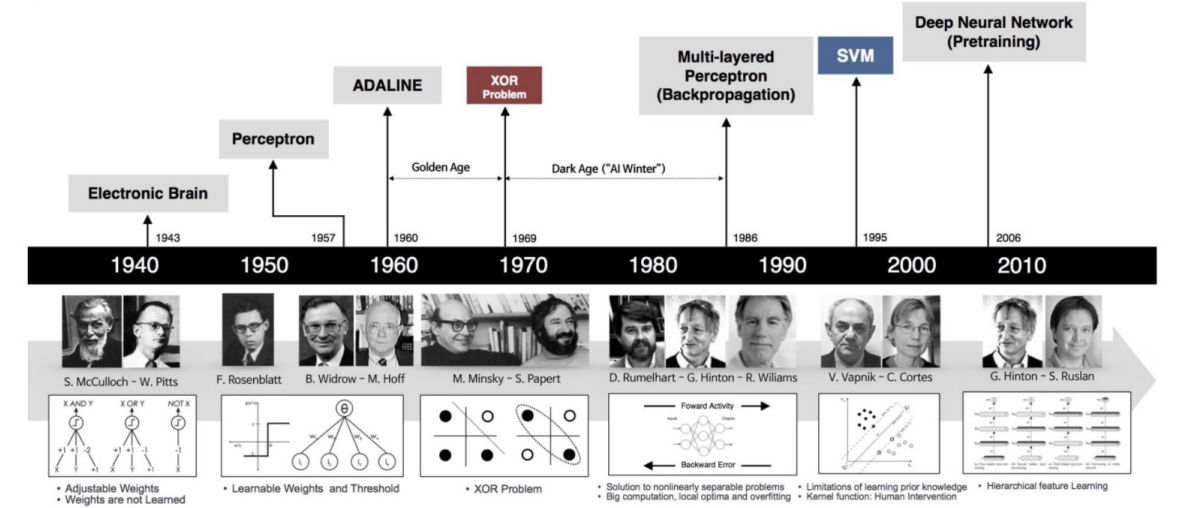

딥러닝의 역사

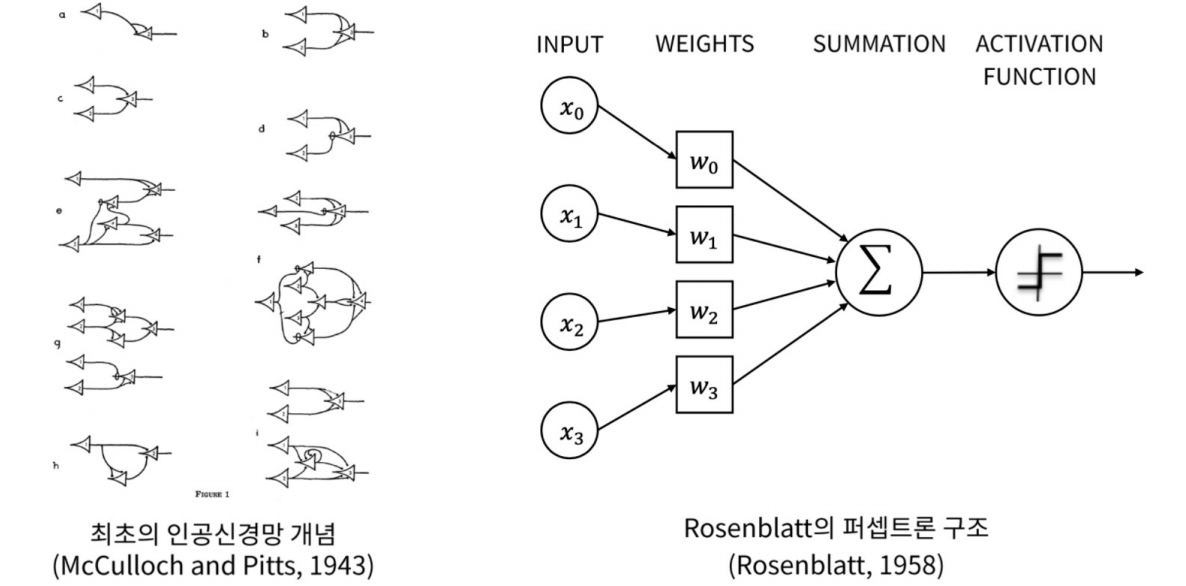

등장 배경 : 인공 신경망

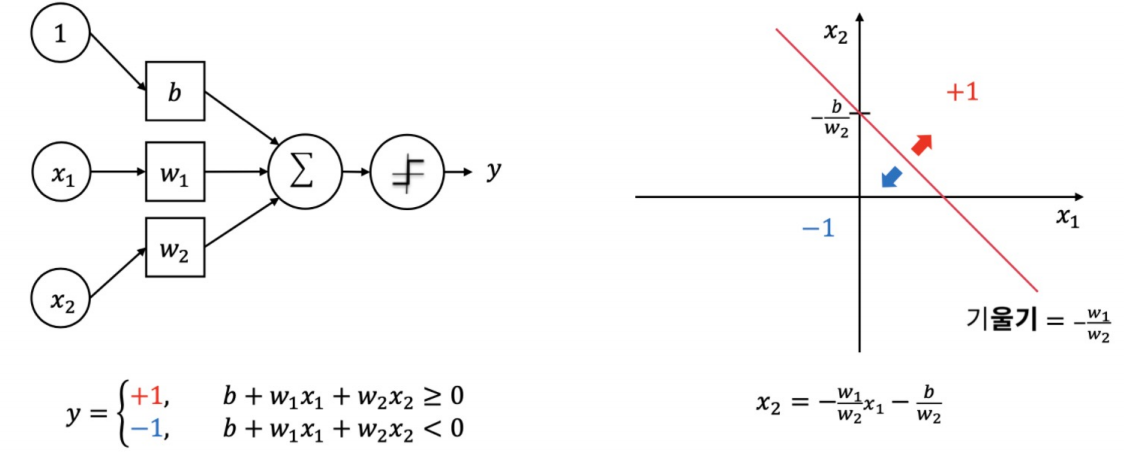

퍼셉트론의 동작

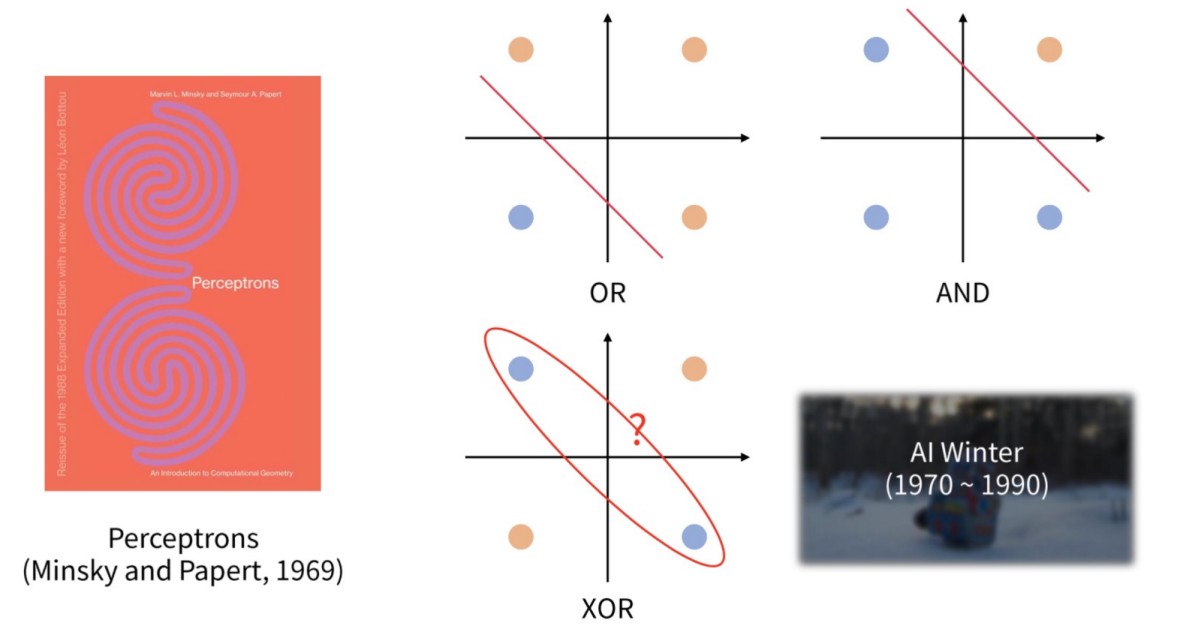

첫번째 AI Winter : XOR 문제

규칙 기반 시스템에 대한 초기 연구가 기대에 미치지 못하면서 시작되었다.

- 1966: 기계 번역의 실패

- 1969 : 퍼셉트론 (초기, 단층 인공 신경망)에 대한 비판)

- 1971-75: 카네기 멜론 대학의 언어 이해 연구 프로그램에 대한 국방고등연구계획국(DARPA)의 불만

- 1973: 라이트힐 보고서(Lighthill report)에 대한 대응으로 영국에서 인공지능 연구가 크게 감소했다.

- 1973–74: DARPA의 학술적 인공지능 연구 전반 축소

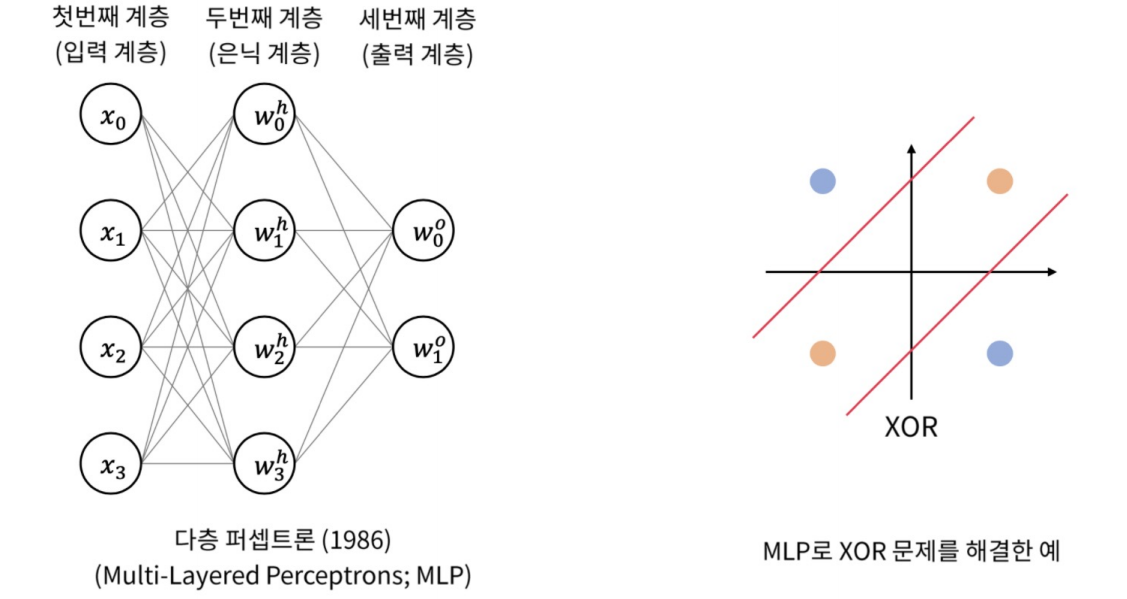

XOR 문제의 해결책 : 다층 퍼셉트론

두번째 AI Winter

전문가 시스템을 사용한 비즈니스 솔루션들이 유지 비용 문제와 시스템의 한계로 인해 산업적 관심을 잃으면서 시작되었다.

- 1987년: 리스프 머신 시장 붕괴

- 1988년: 전략 컴퓨팅 이니셔티브(Strategic Computing Initiative)의 AI에 대한 신규 지출 취소

- 1990년대: 많은 전문가 시스템이 폐기되었다.

- 1990년대: 5세대 컴퓨터 프로젝트의 원래 목표 종료

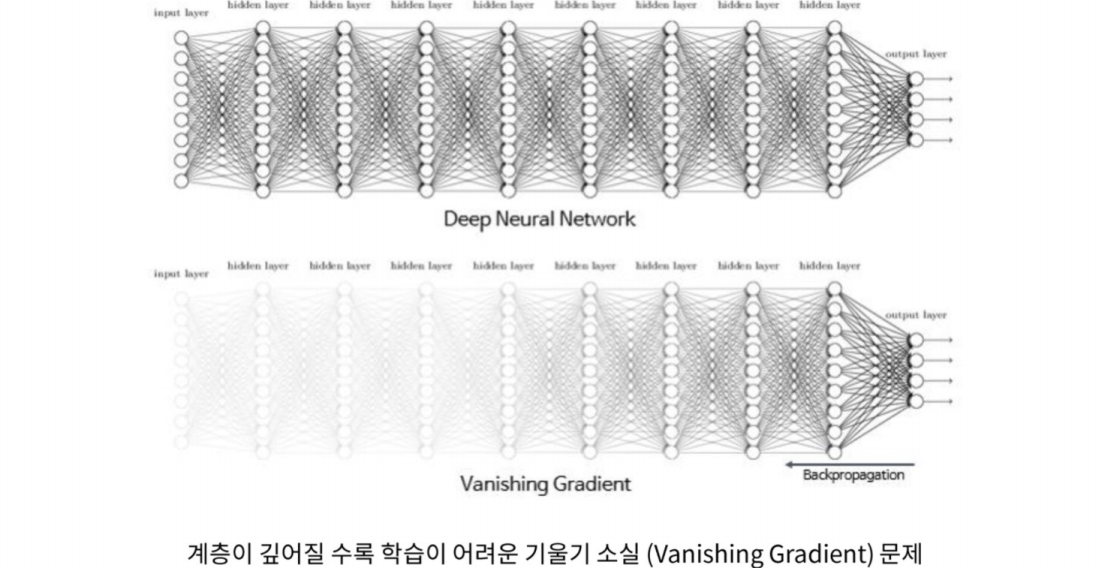

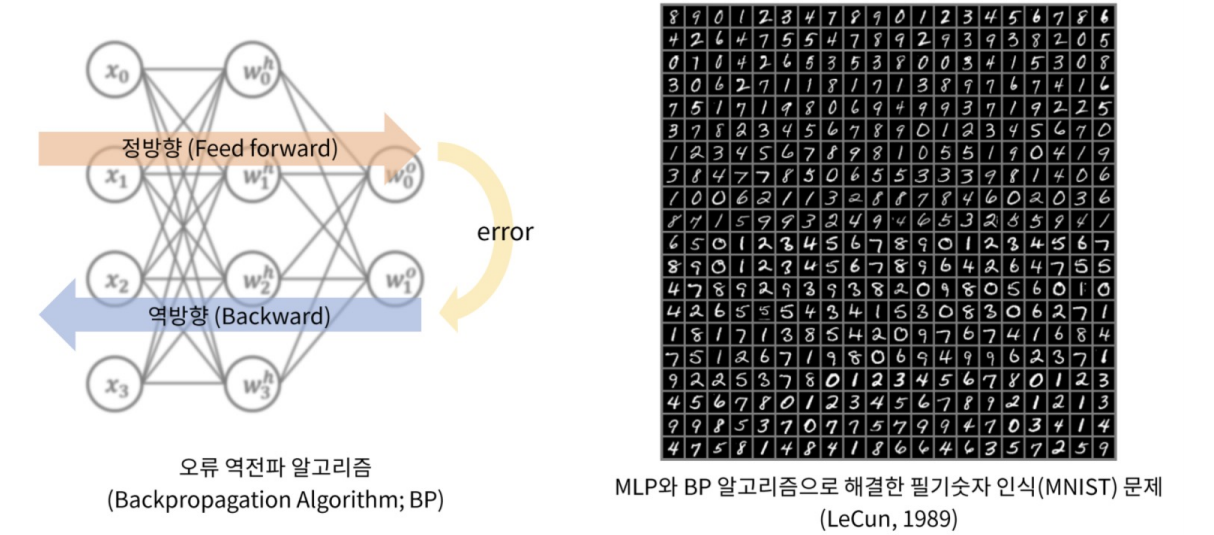

Vanishing Gradient 해결책 : 역전파

이미지넷 경연 대회

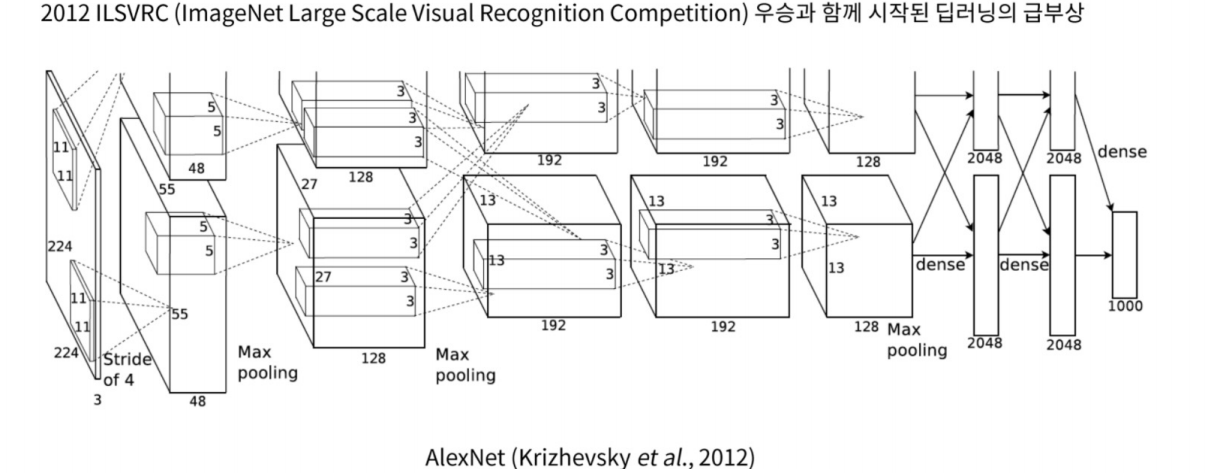

알렉스넷과 딥러닝의 비상

Framework의 등장

Framework의 부상

Cloud 플랫폼의 대중화

하드웨어의 대중화

AI의 영역 확대

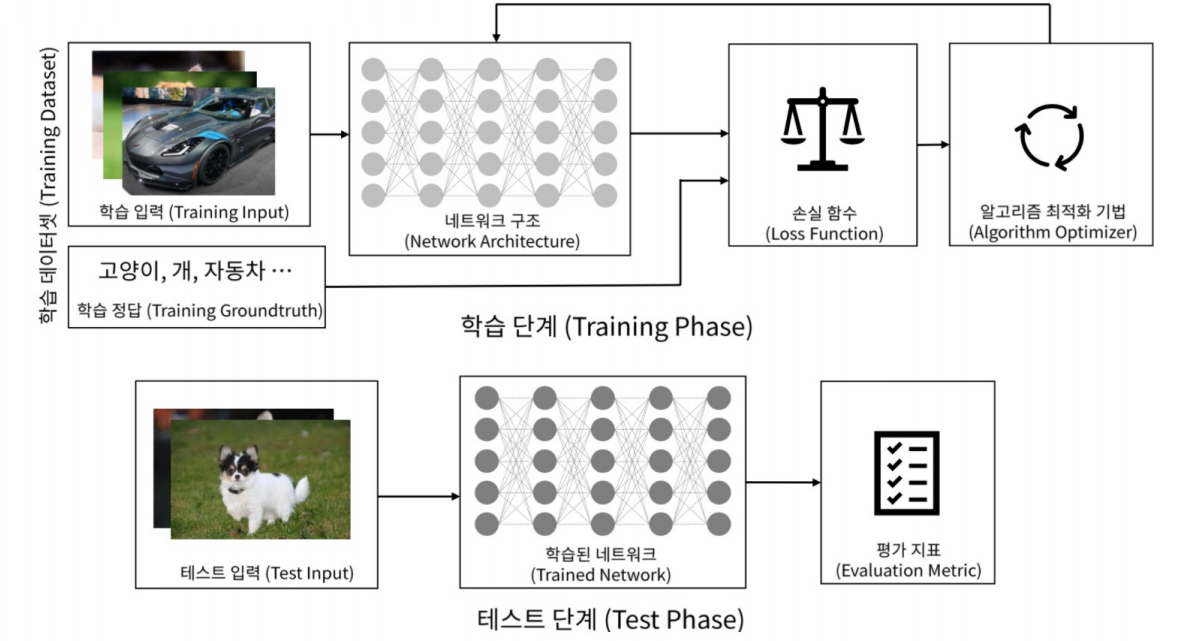

딥러닝의 구조

딥러닝의 구성 요소

신경망

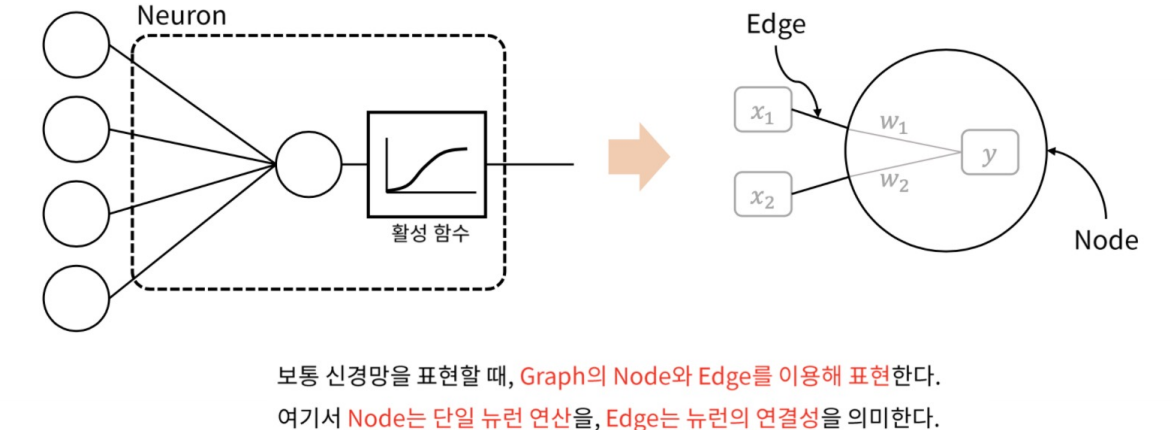

뉴런의 그래프 표현

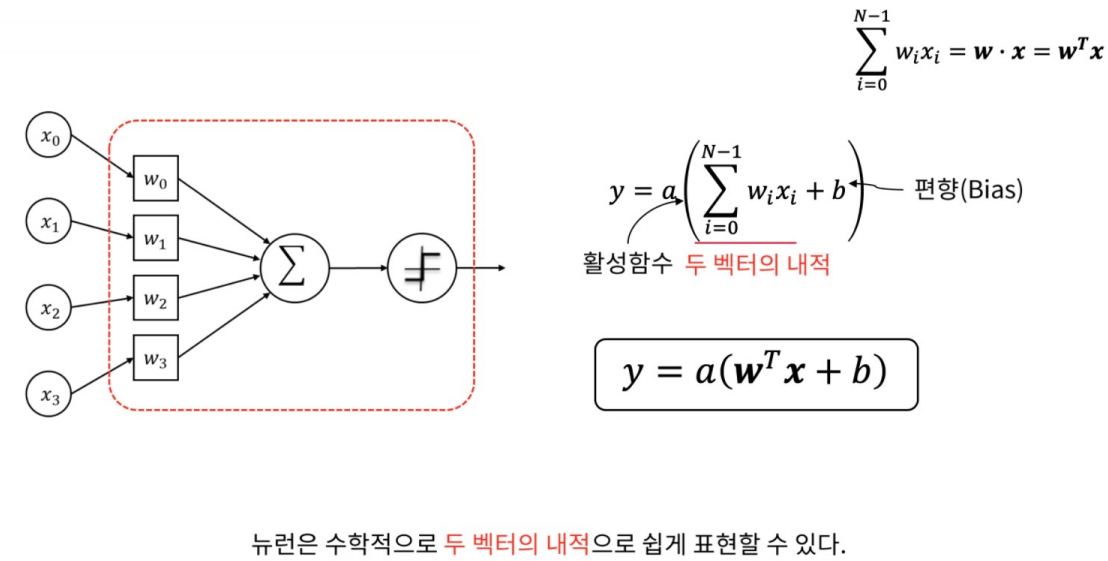

뉴런의 수학적 표현

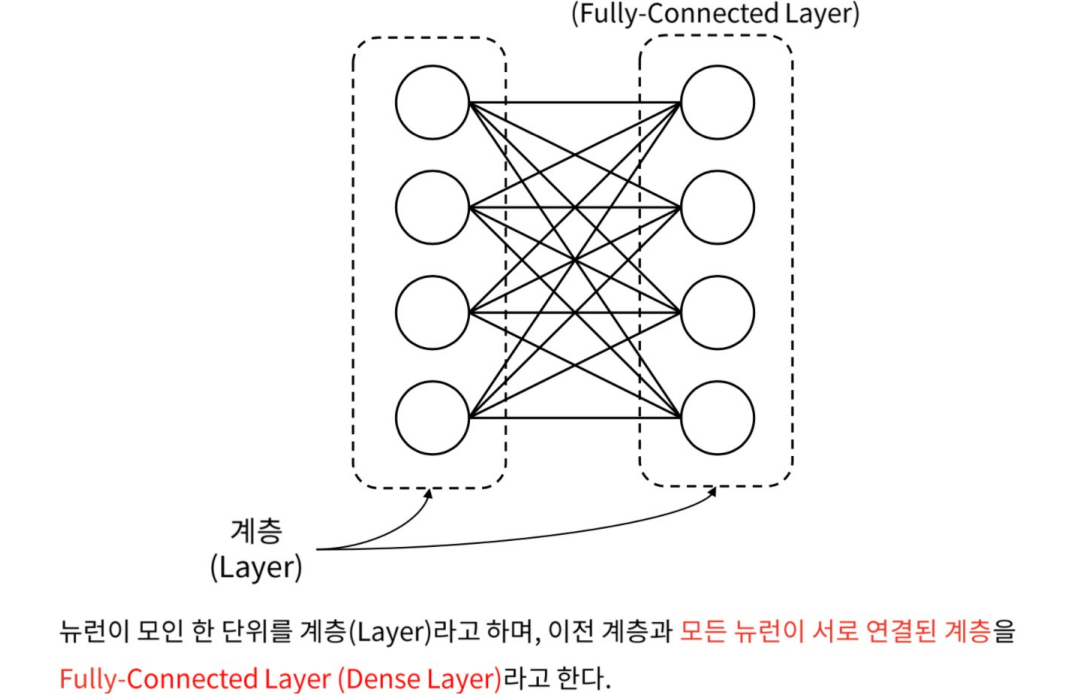

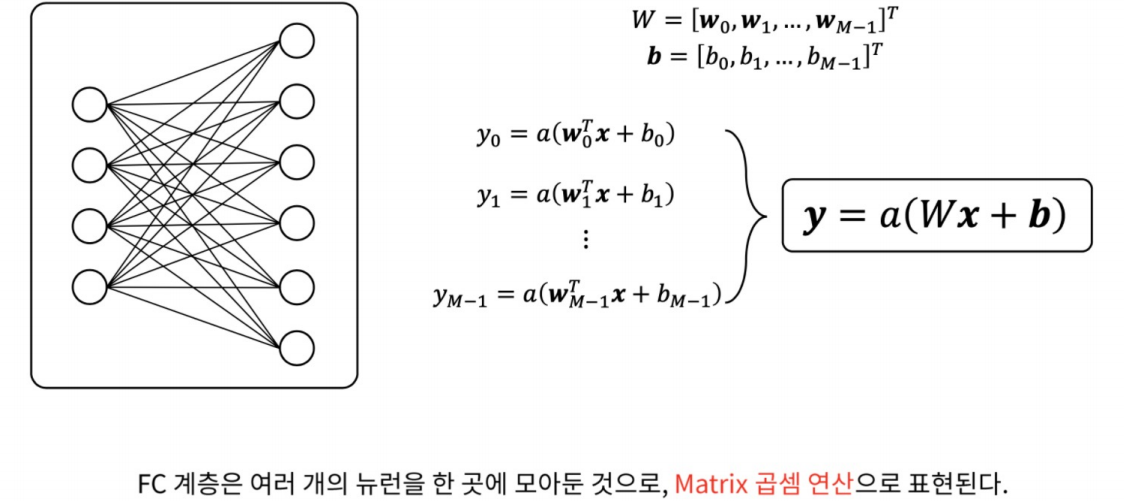

Fully-Connected Layer

Fully-Connected Layer의 수학적 표현

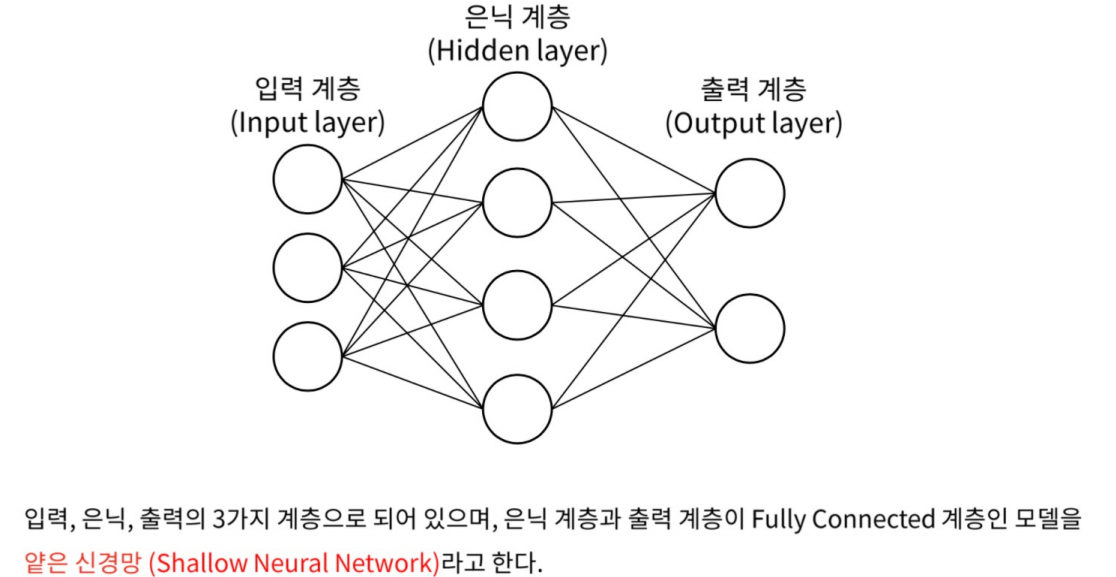

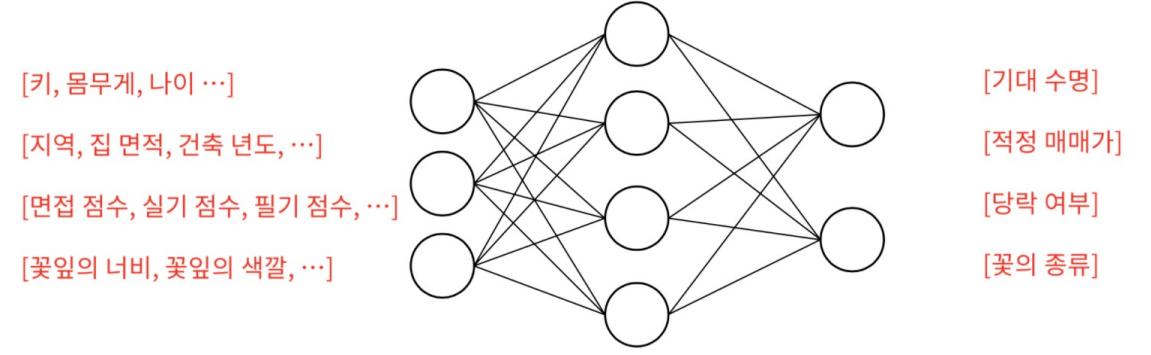

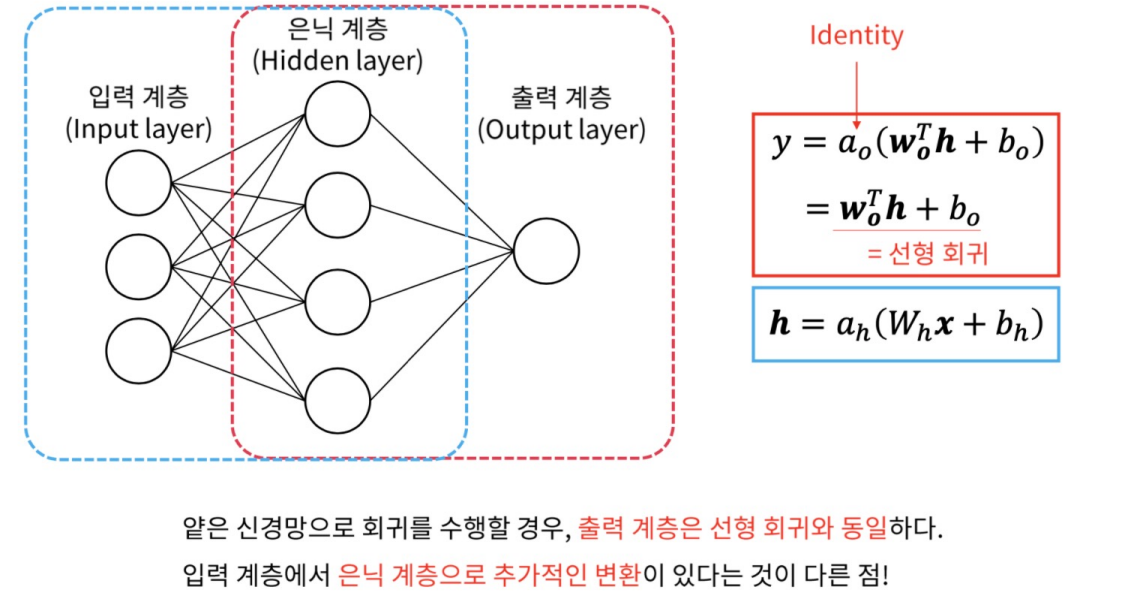

얇은 신경망

얇은 신경망 적용 예시

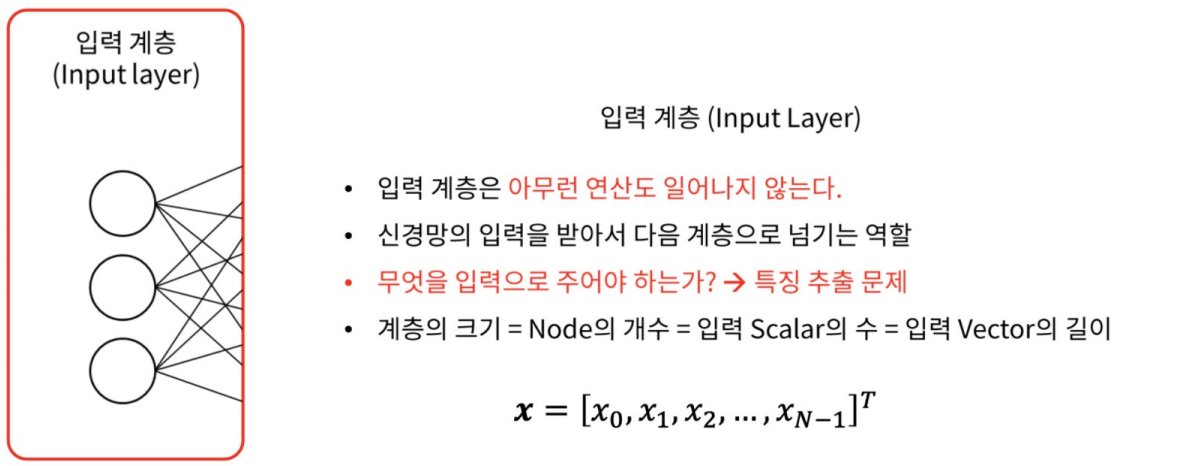

Input Layer

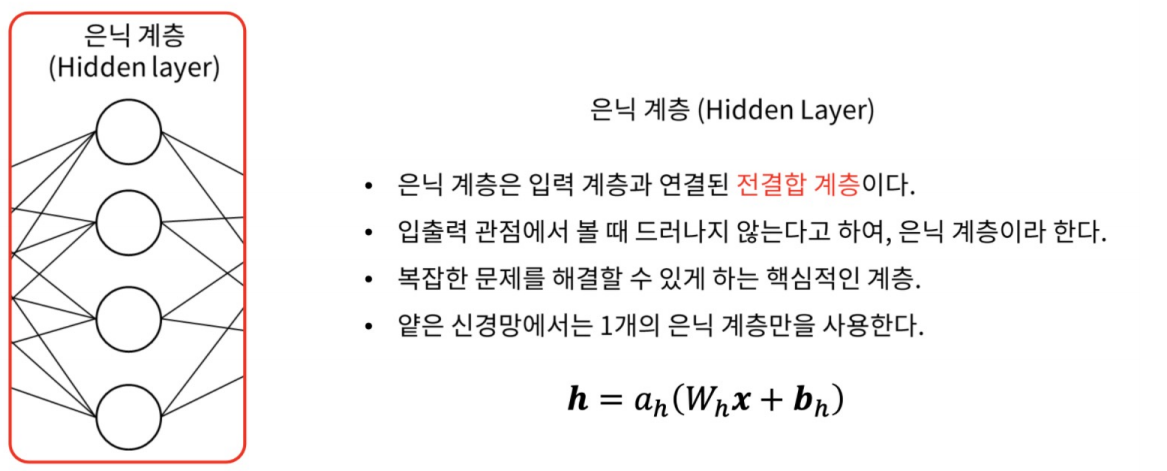

Hidden Layer

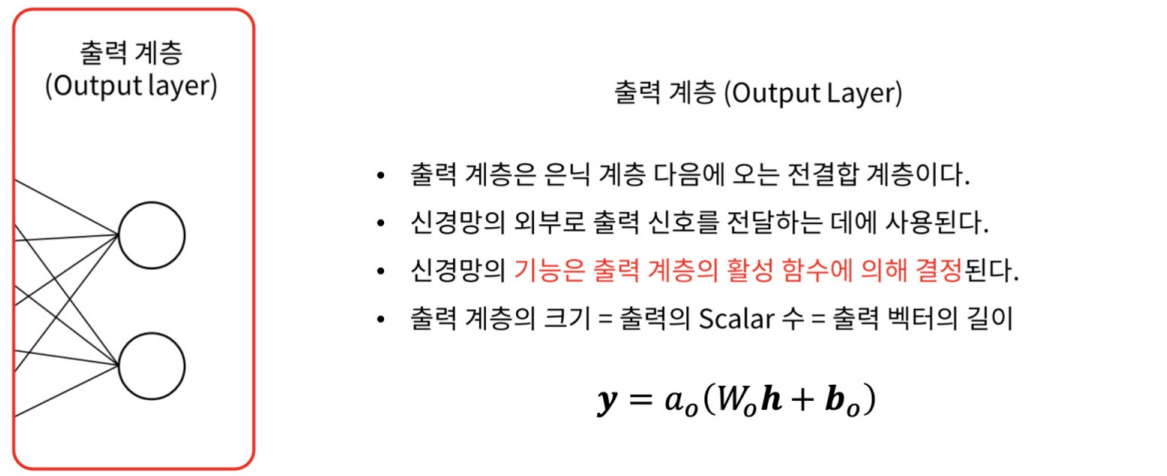

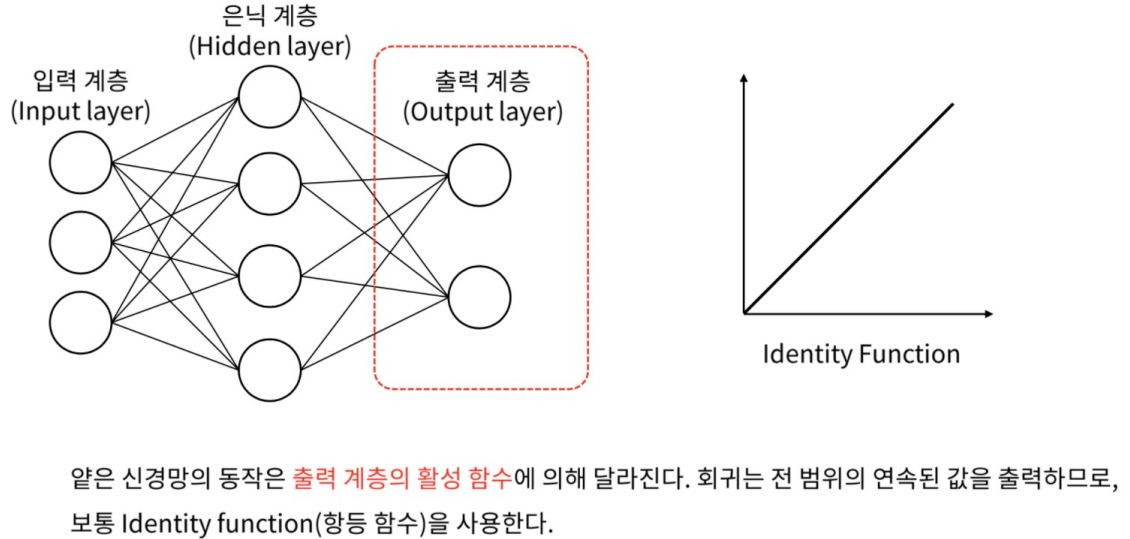

Output Layer

Regression

회귀

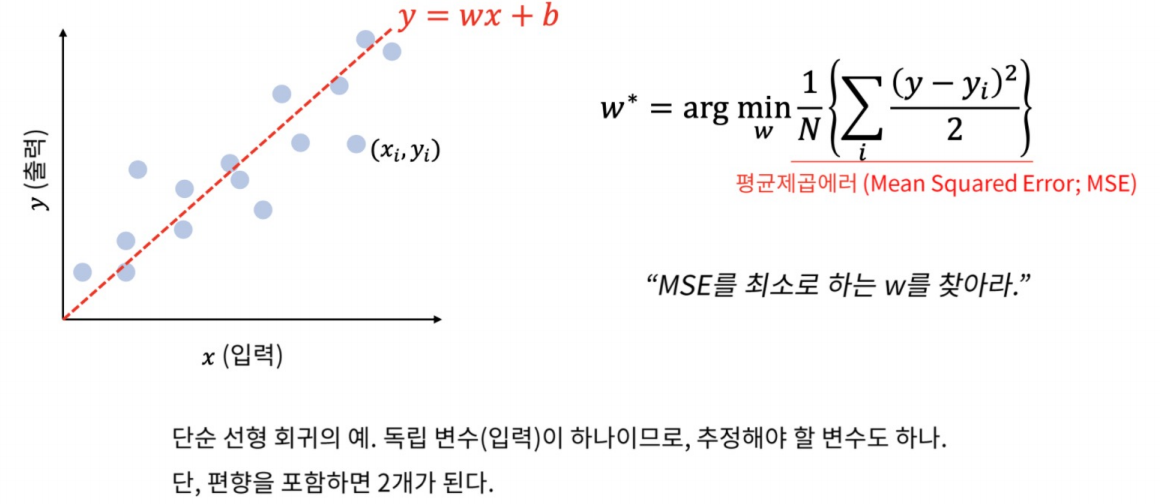

선형 회귀

데이터를 가장 잘 표현하는 선형식을 찾는 동작.

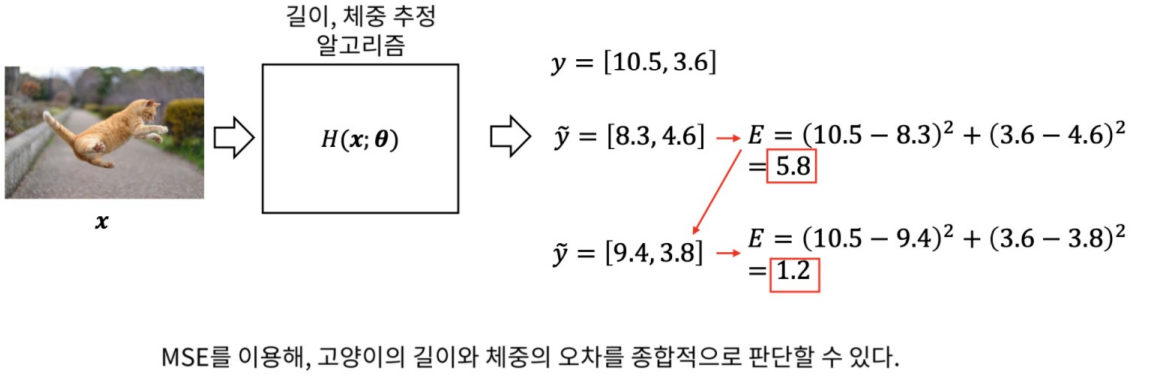

Mean Squared Error

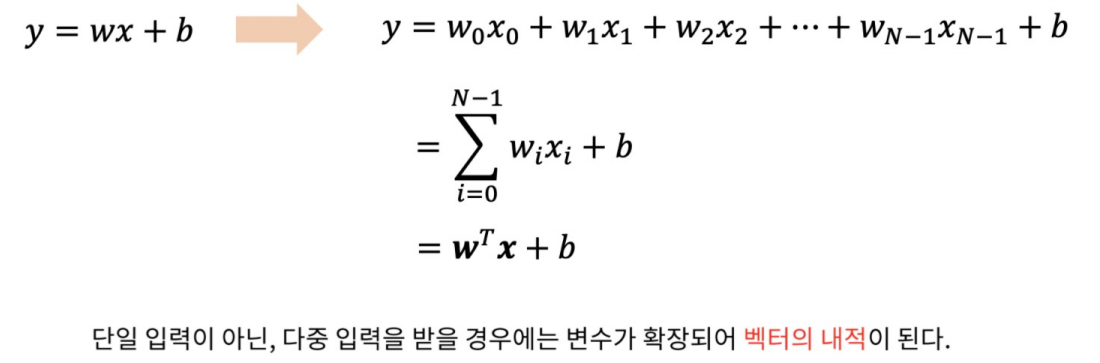

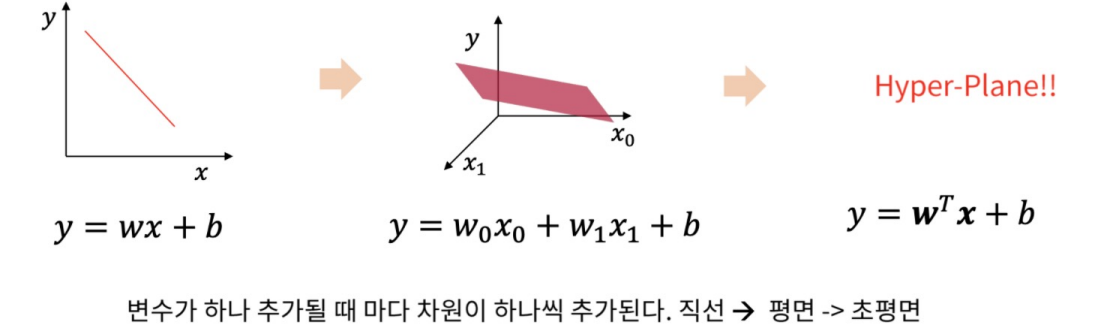

다중 선형 회귀

다중 선형 회귀의 상상

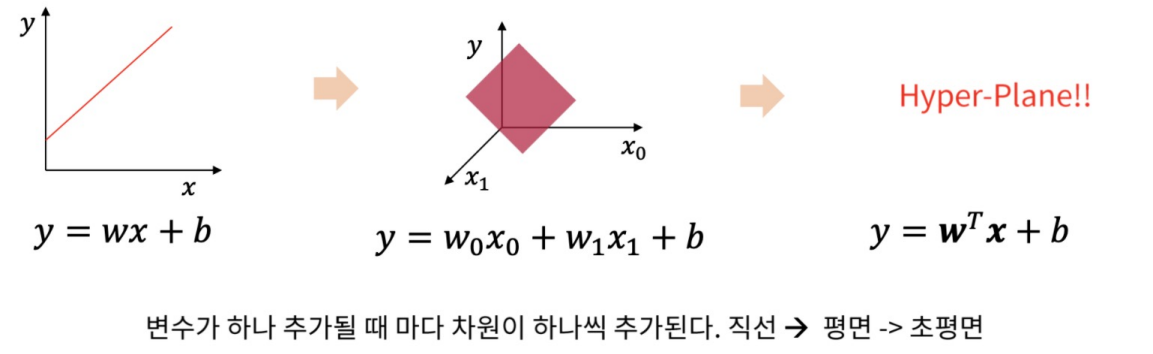

로지스틱 회귀

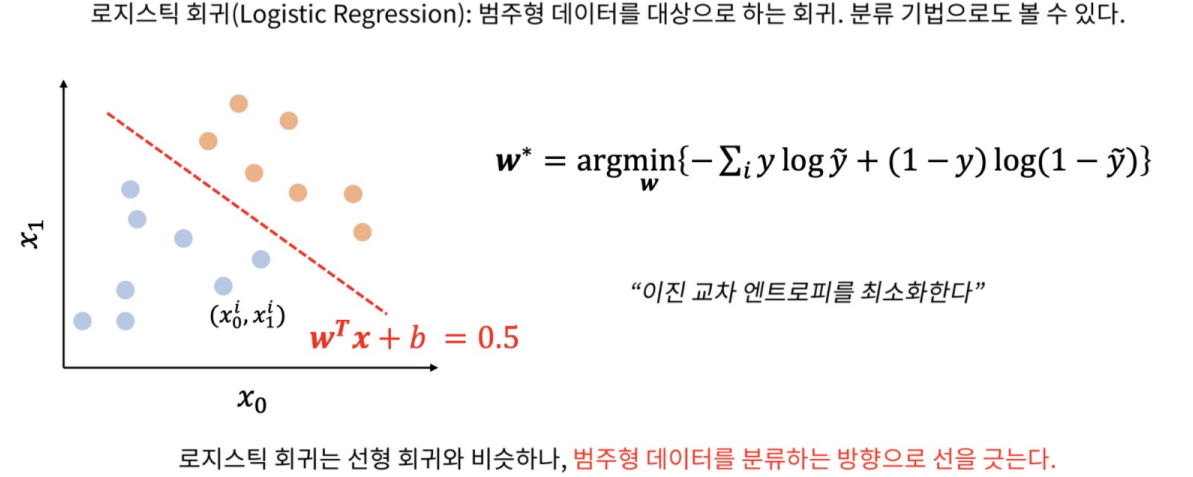

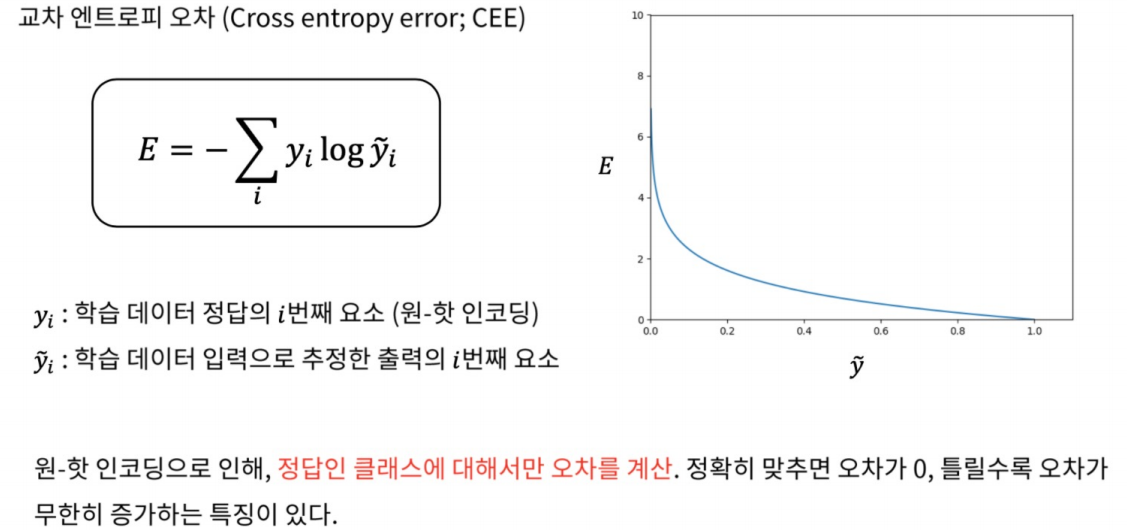

Cross Entropy

Cross Entropy Error

정답과 출력의 비교

다중 로지스틱 회귀의 기하학적 특징

신경망의 회귀

얇은 신경망을 이용한 회귀

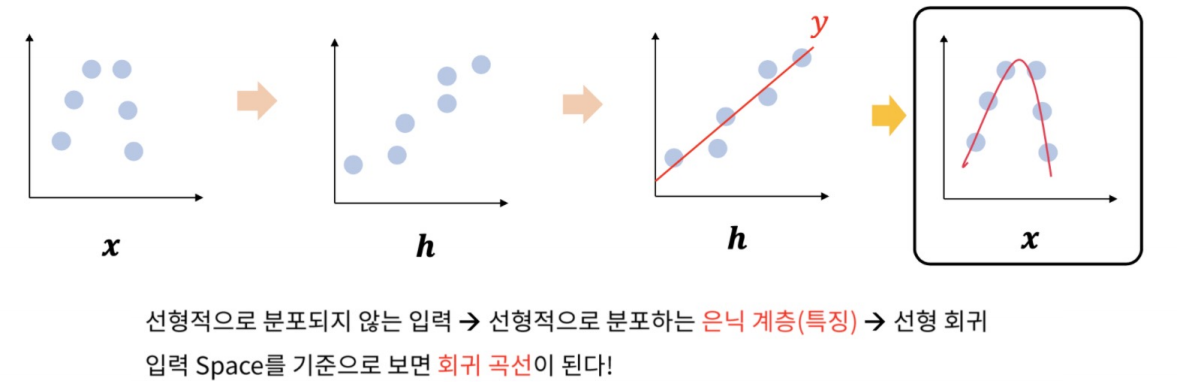

은닉층의 효과

Classification

분류

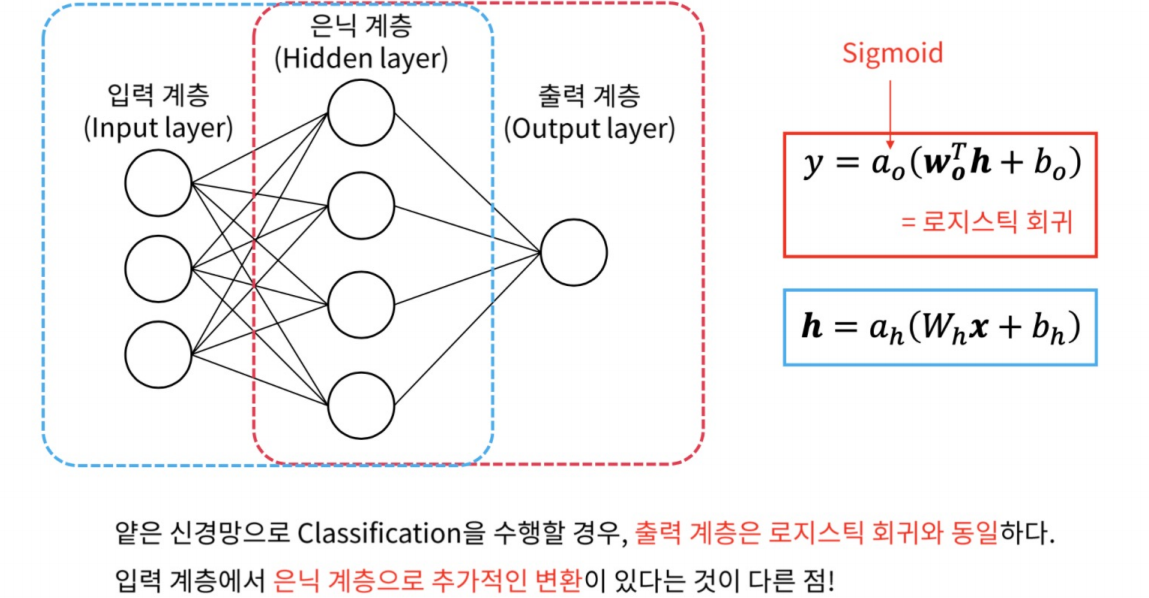

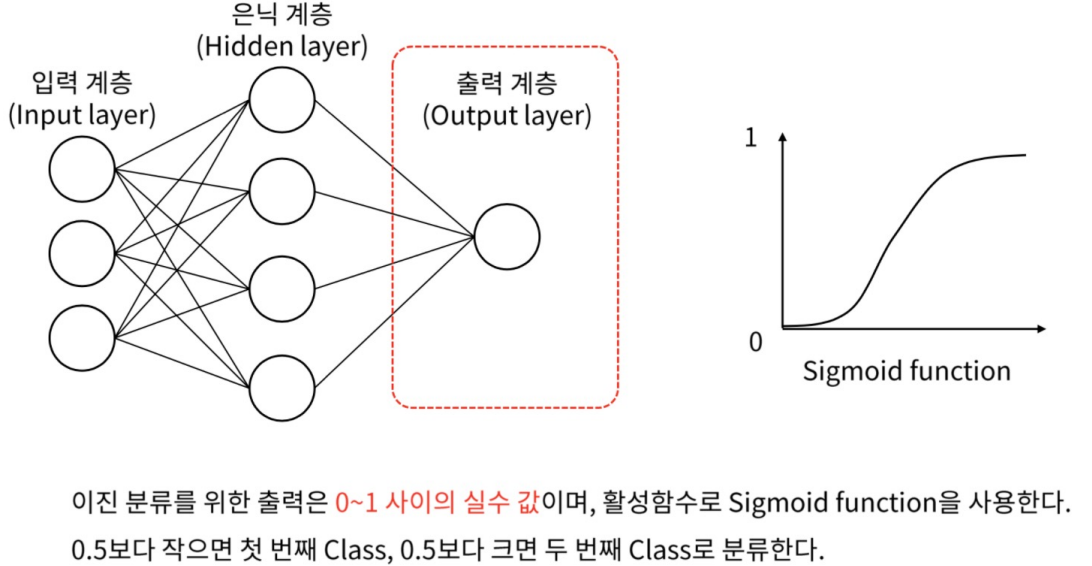

얇은 신경망과 이진 분류

얇은 신경망을 이용한 이진 분류

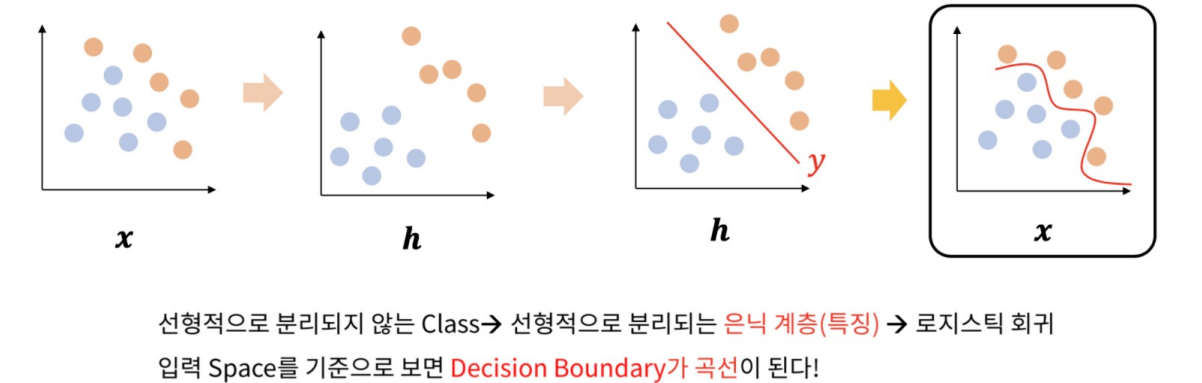

은닉계층과 분류

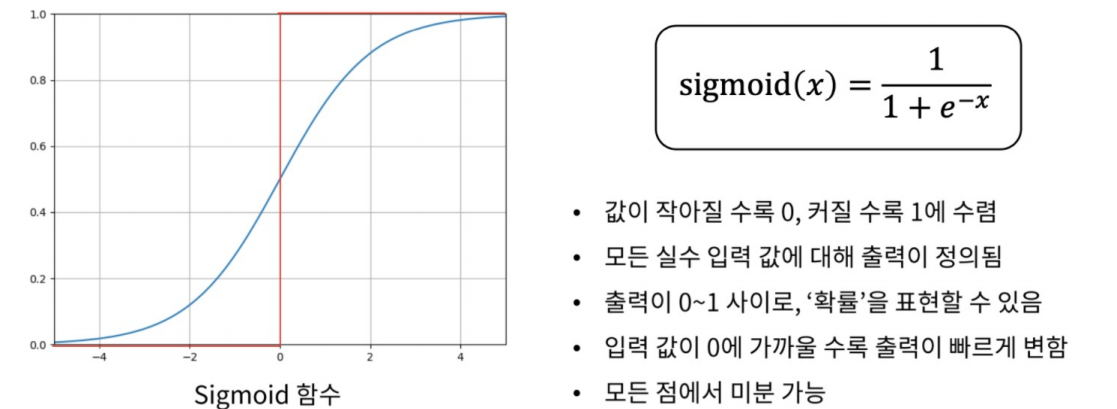

Sigmoid Function

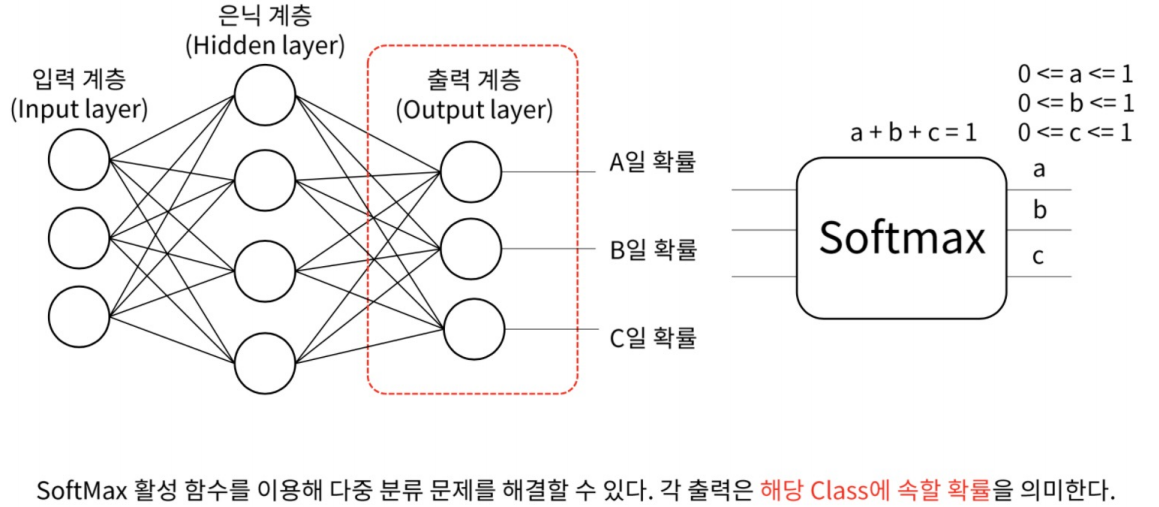

다중 분류

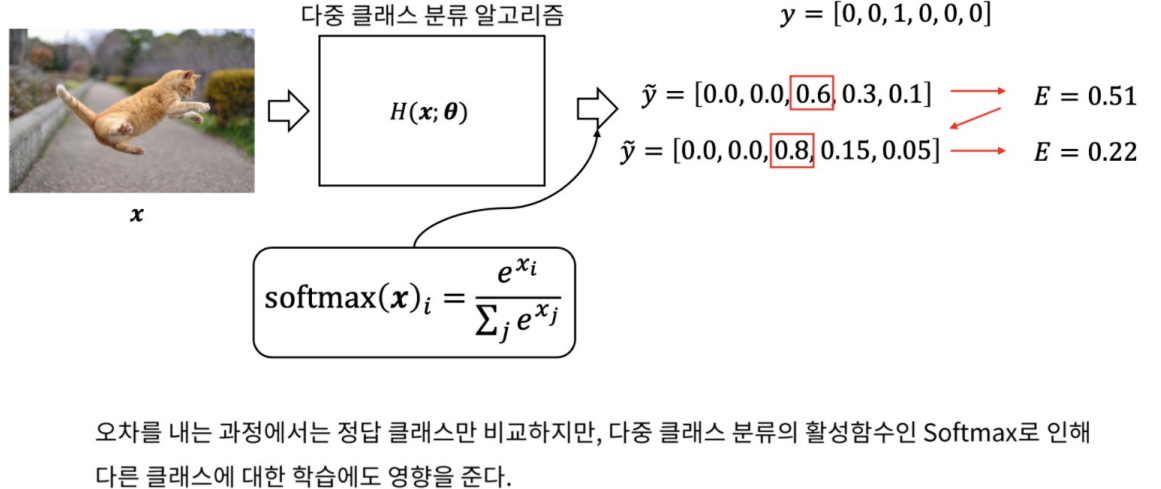

다중 클래스

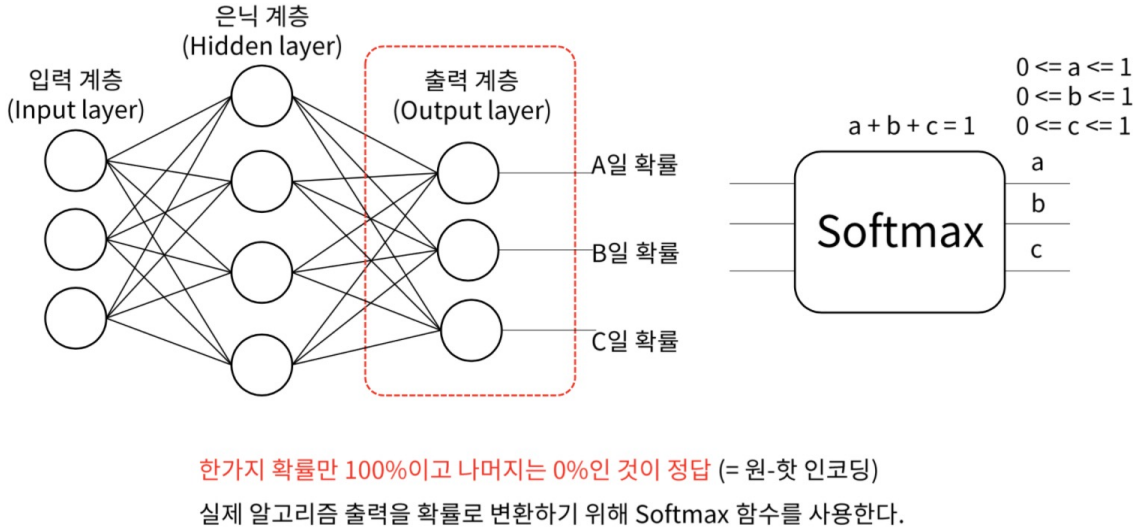

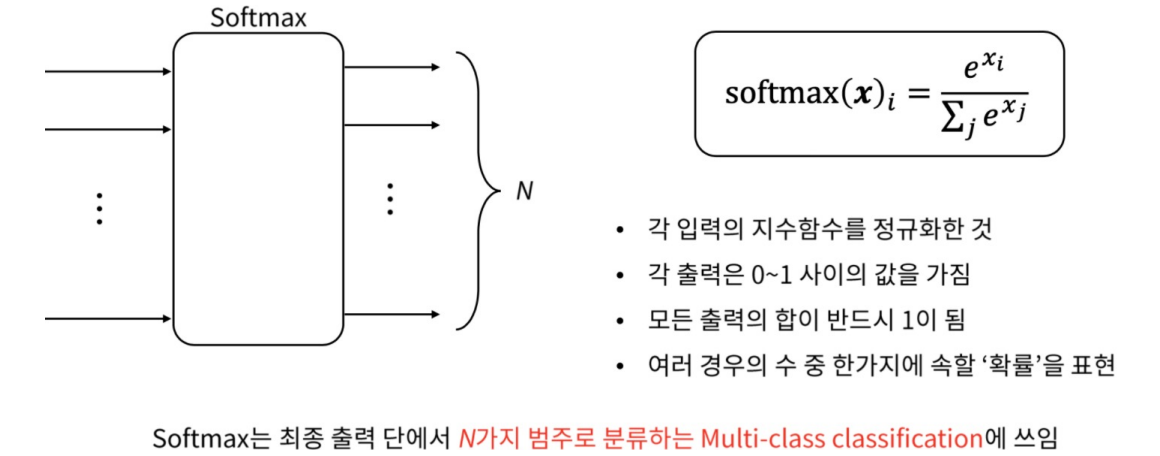

Softmax

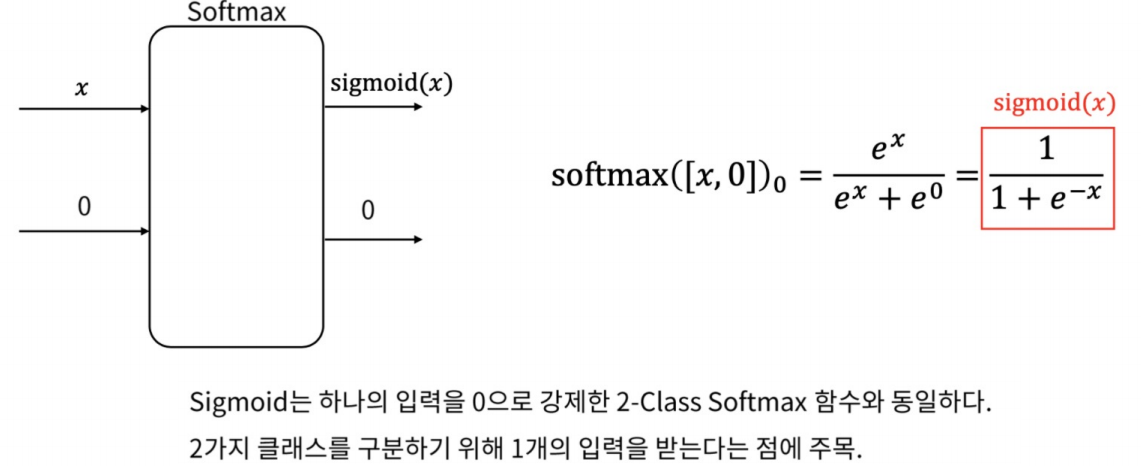

Softmax 와 Sigmoid

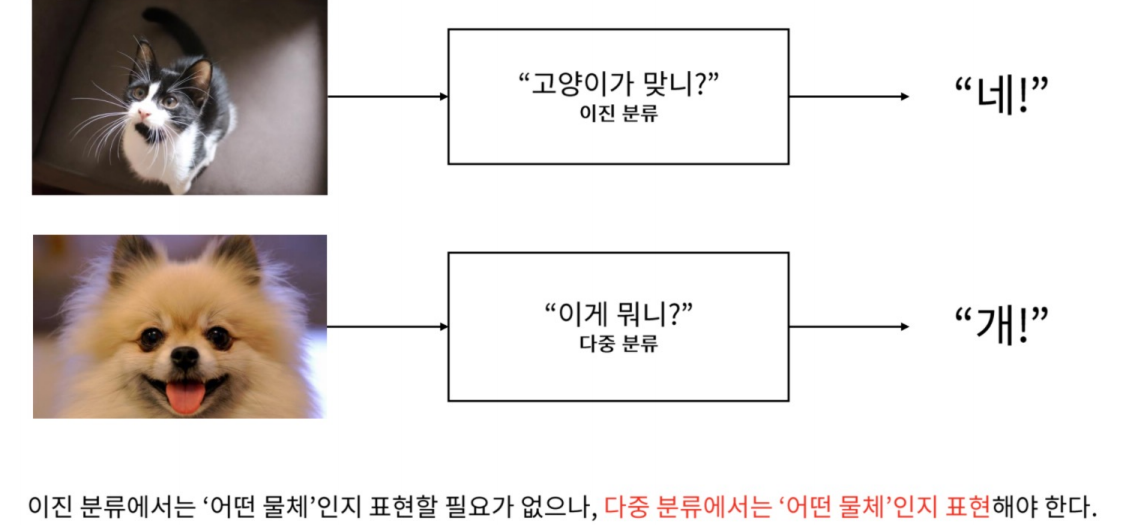

이진분류 vs 다중분류

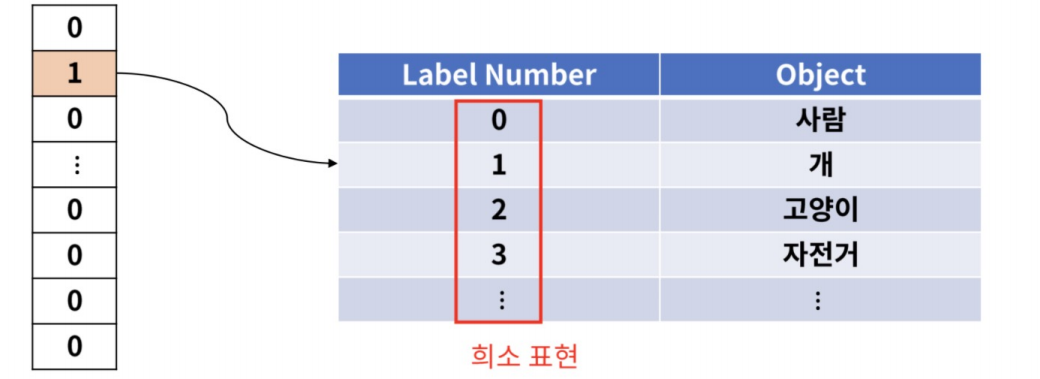

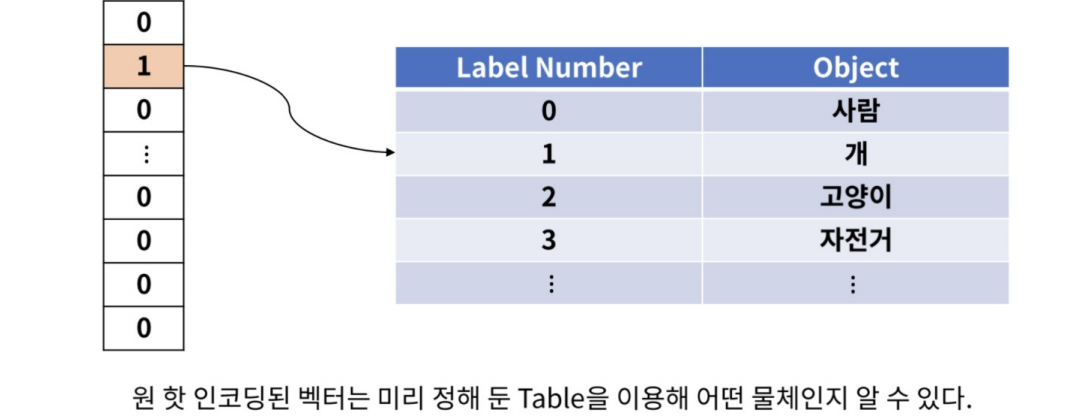

Sparse Vector

대부분의 값이 0이고 크기가 있는 값이 희소하게 나타나는 벡터

One-Hot Encoding

한 개의 값만 1이고 나머지 값은 0인 벡터로 표현하는 기법

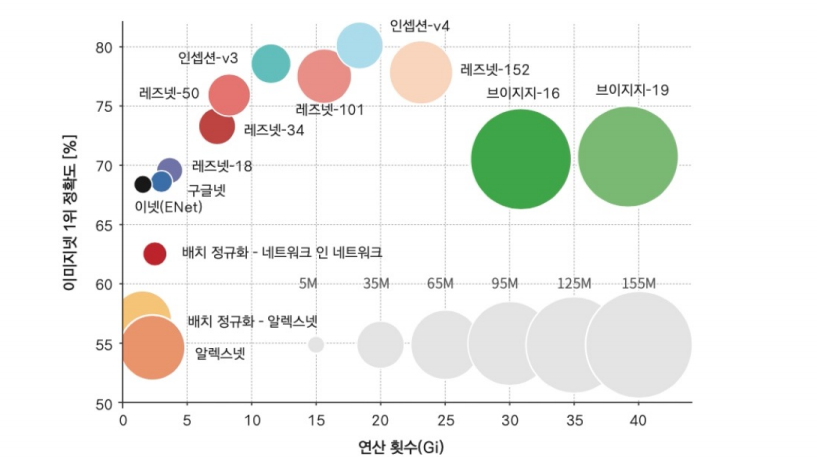

CNN 계열의 네트워크

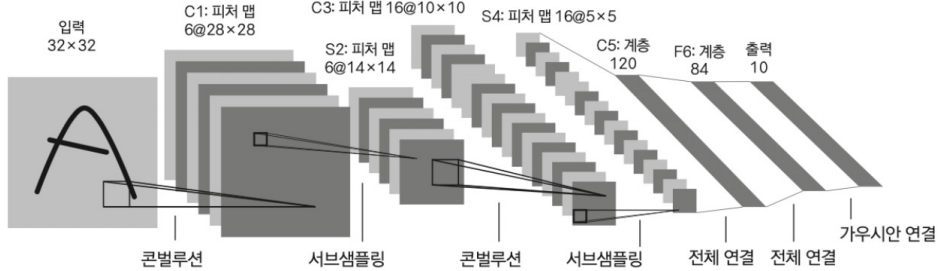

LeNET-5

- 얀 르쿤이 1998년 우편물에 필기체 인식을 위해 개발

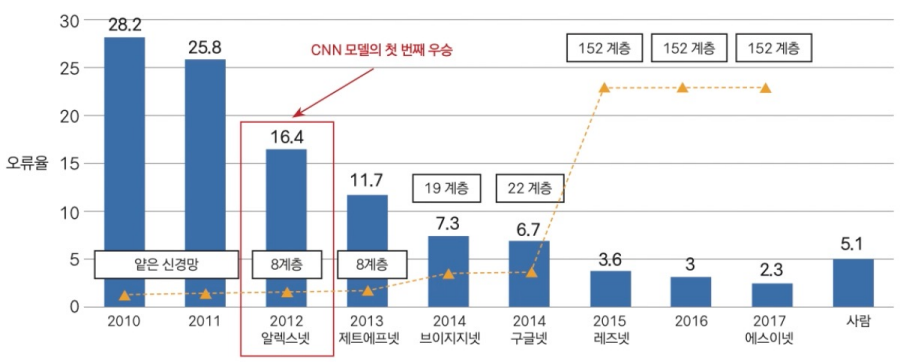

ImageNet

- 이미지넷은 1,400만개의 이미지 데이터와 1000개의 클래스의 데이터

- 2010년부터 대회개최

- CNN 계열의 최초 우승이 2012년 알렉스넷

AlexNet

- 힌튼 교수 연구팀에서 창안

- 2개의 GPU에서 실행 (GTX580)

- 두 개의 conv 넷을 구성하고 하나씩 GPU를 할당하고 중간에 정보 교환

- 이미지넷 데이터를 5~6일 정도 학습

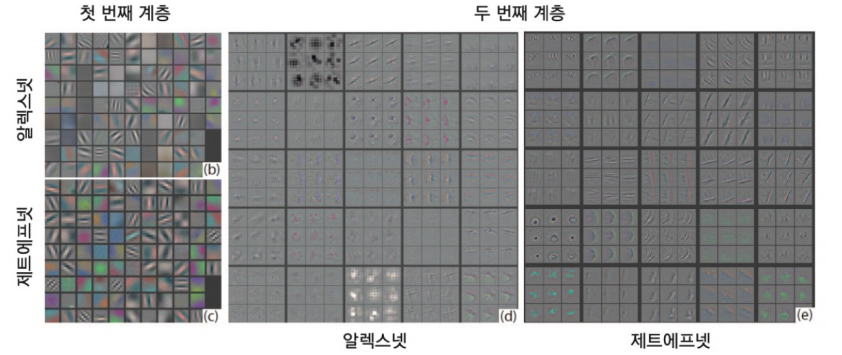

ZFNet

- 2013 ILSVRC 우승.

- 알렉스넷의 문제점을 시각화를 통해 확인 후 해당부분을 개선

- GTX580으로 12일 학습

- 의의는 모델 튜닝만으로도 좋은 결과를 얻을 수 있다는 사례를 남김

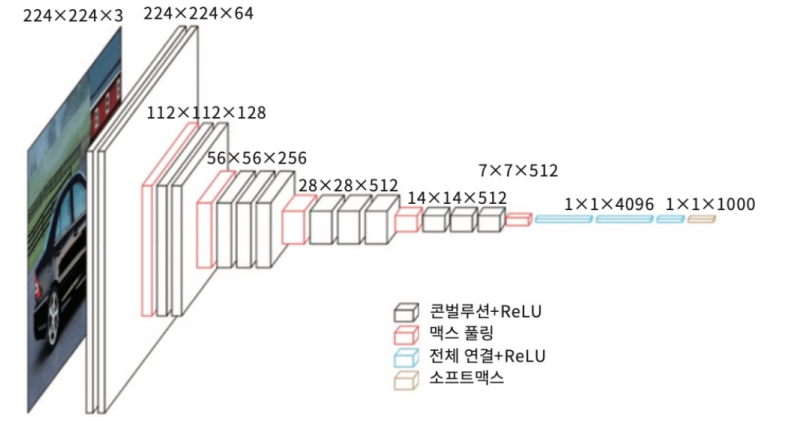

VGGNet

- 2014 ILSVRC 준우승.

- 깊은 신경망. 3x3 컨블루션 필터만을 사용. 매우 단순한 구조

- 작은 필터로 깊은 네트워크를 형성하는 것이 유리함을 보여줌

- VGG는 이미지의 특징을 추출할 때 많이 사용

- 일부 계층의 특징으로 스타일을 생성

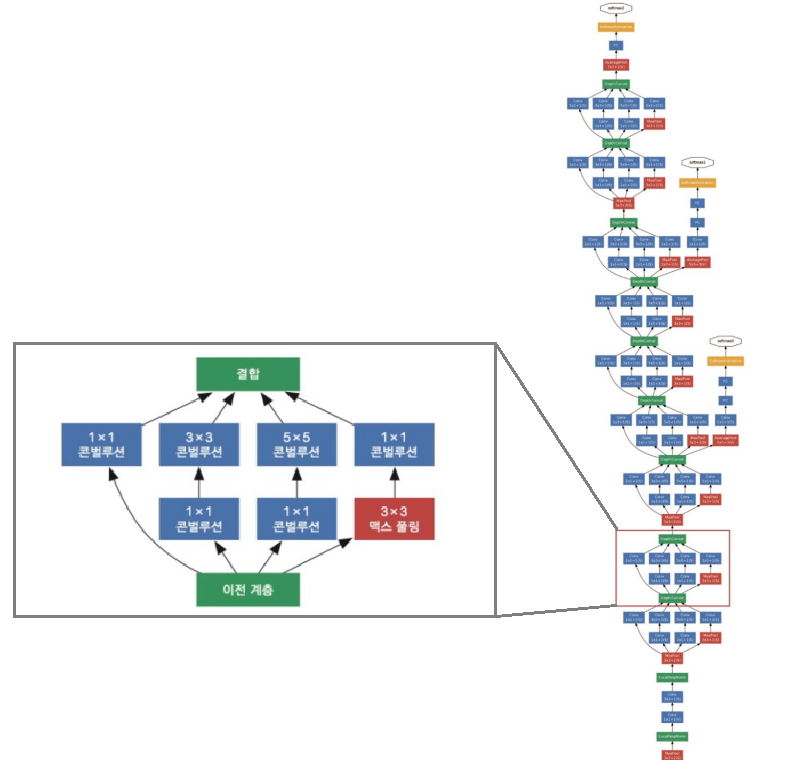

GoogLeNet

- 2014 ILSVRC 우승.

- 이후 InceptionV4로 발전했기 때문에 GoogLeNet을

인셉션v1이라고도 함 - 기존의 방식과 달리 네트워크 속에 네트워크를 두는

방식으로 구성 - 왼쪽에서 빨간색 박스가 인셉션 모듈

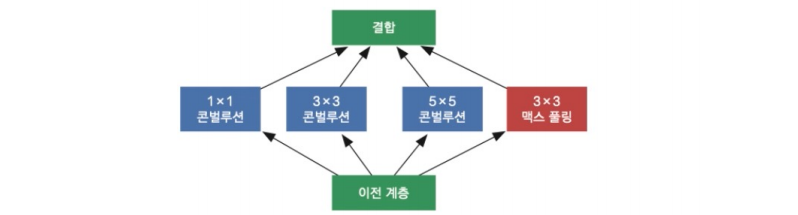

GoogLeNet – 인셉션 모듈

- 1x1, 3x3, 5x5, 맥스풀링으로 구성

- 1x1은 채널의 특성을 인식

- 3x3과 5x5는 서로 다른 크기의 영역에서 공간의 특징과 채널의 특징을 인식

- 맥스 풀링은 가장 두드러진 특징을 인식

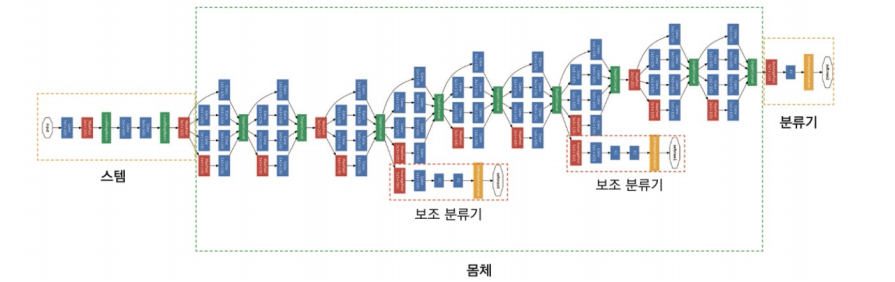

GoogLeNet – 구조

- 스템 : 도입부에는 일반적인 구조로 진행 (Conv – Pool –Conv - Pool)

- 몸체 : 인셉션 모듈 9개

- 최종 분류기 : FC 대선 mean pooling을 통해 파리미터 수를 줄임

- 보조 분류기 : 하위 계층에 그레디언트를 원할히 전달 (훈련때만 사용)

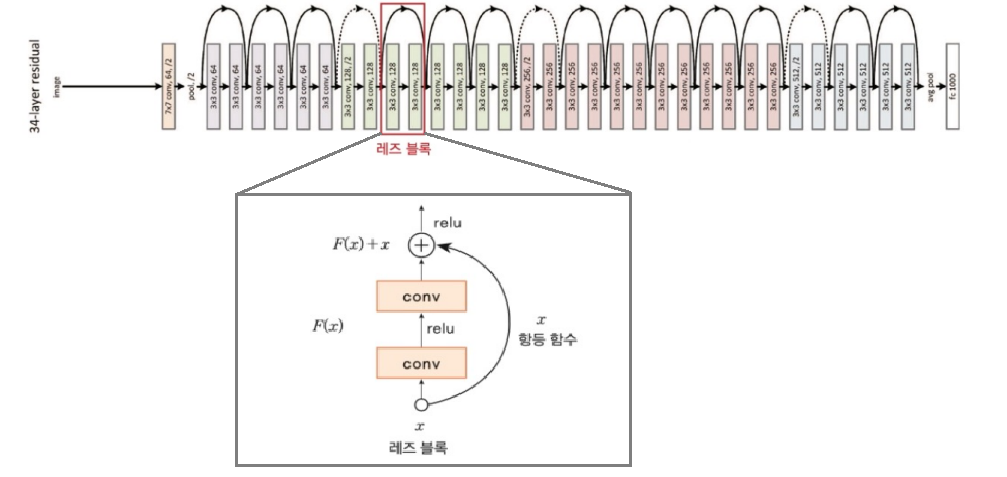

ResNet

- 최초로 사람의 인지능력(5%대)보다 좋은 성능

- 152계층의 엄청난 깊이를 가짐

- Residual connection의 구조를 가짐

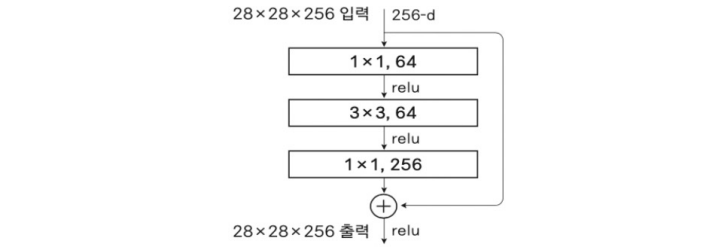

ResNet – Bottelnet

- 3x3 Conv 앞뒤에 1x1 Conv를 배치

- 1x1 Conv로 채널을 줄였다가 다시 확대

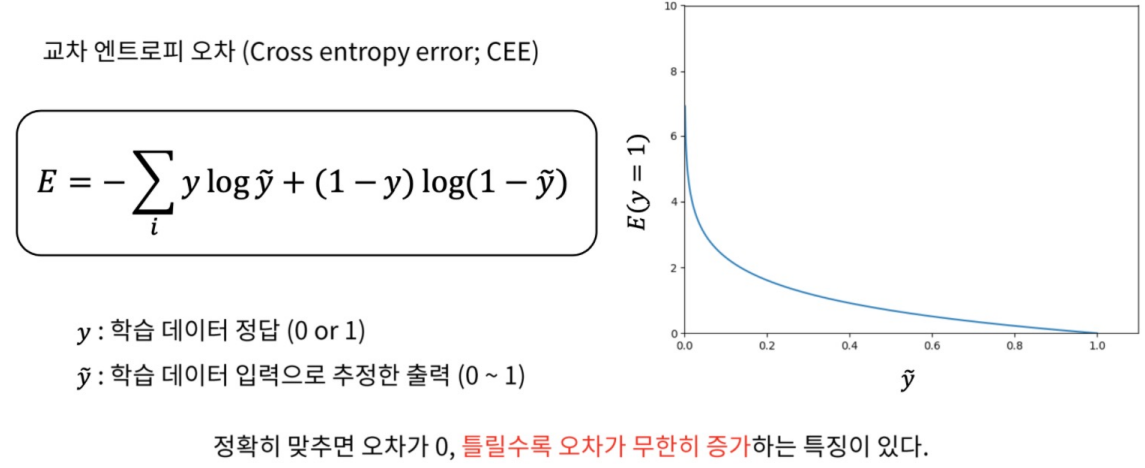

연산 횟수 x 정확도