밑바닥부터 시작하는 딥러닝2를 요약하였습니다.

attention mechanism

seq2seq를 더 강력하게 하기 위해 만들어졌다.

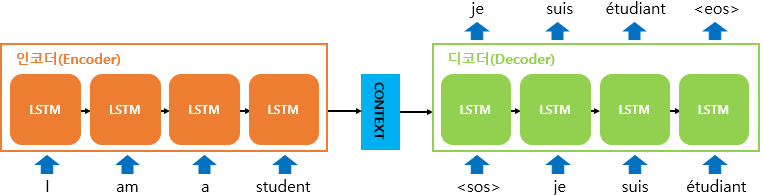

seq2seq (시퀀스-투-시퀀스)는 2개의 RNN을 연결하여 하나의 시계열 데이터를 다른 시계열 데이터로 변환하는 방법이다.

아래 그림과 같은 구조로 이뤄진다.

1. seq2seq의 문제점

seq2seq의 인코더는 고정 길이의 벡터를 출력한다.

즉, 입력 문장의 길이가 길어져도, 항상 같은 길이의 벡터를 출력한다는 것이다.

이것을 개선해보려고 한다!

2. Encoder 개선

인코더의 출력 길이는 입력 문장의 길이에 따라 바뀌도록 한다.

즉, LSTM의 은닉층의 출력을 모두 이용하도록 한다.

RNN 계열 함수 내 파라미터를 아래와 같이 설정하면 된다.

return_sequences=True