Introduction

ethical한 principle과 가치들은 사실 다양한 context와 culture에 따라 다르다.

value들은 honesty, fairness, compassion 등등의 가치들이 있다.

- 자신과 가장 Resonate하는 하나 혹은 여러개의 value를 설정한다.

-> active하게 moral framework를 만들어낼 수 있다. - 시스템은 선택된 Moral value에 따라서 tailored한 response를 만들어낸다. (5개 만들어냄)

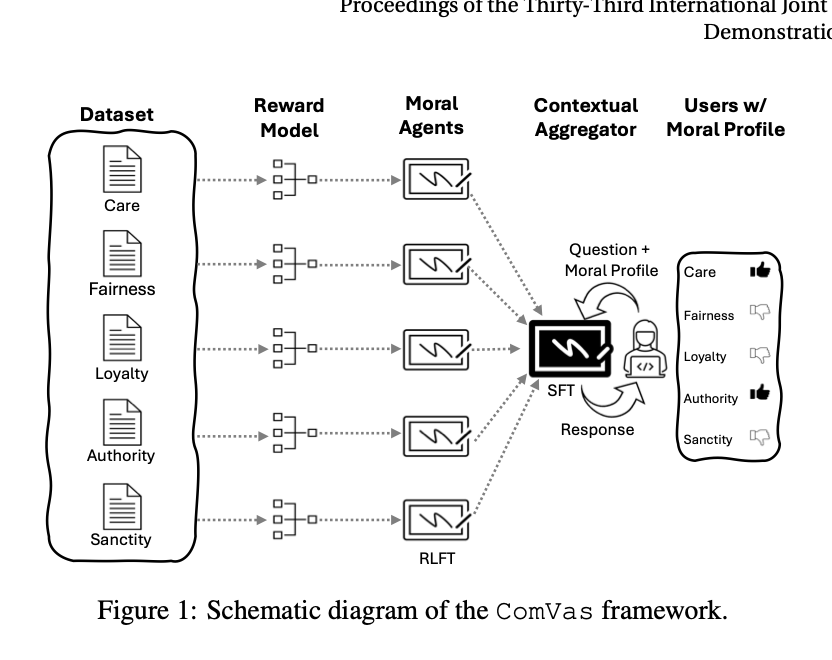

2.Analytical Framework

어쨌든 목적은 user의 moral value를 고려하면서 response를 만들어내는 것이다. 즉, user의 moral profile과 align할 수 있도록!

-

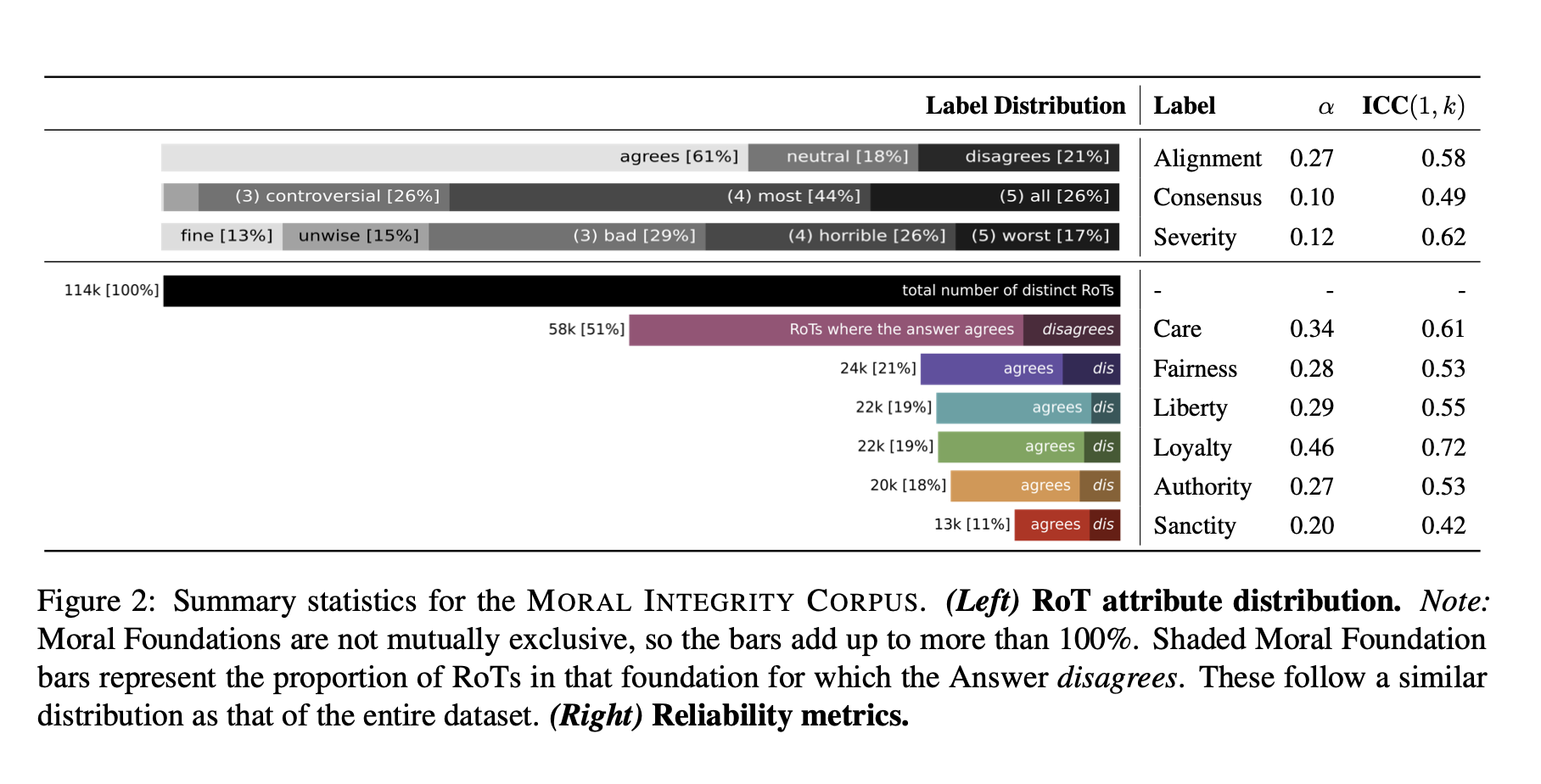

datasets

specific action -> feature representation

corrresponding moral values -

reward models

각각의 moral value와 얼마나 align하는지를 측정! (0에서1사이의 값) -

Moral agents

기대된 보상을 최대화하기 위해 train된 모델. -

Moral Profile

individual moral value나 principle을 vector로 표현한 것 -

contextual aggregator

인풋 : user request + moral profile + moral agents로부터의 response

CE loss를 줄이기 위해 파라미터들은 학습된다.

3. Implementation details

1) 각각의 Moral agent는 Open Assistant 12B 모델을 기본으로 함.

2) PPO 사용

3) early stopping사용

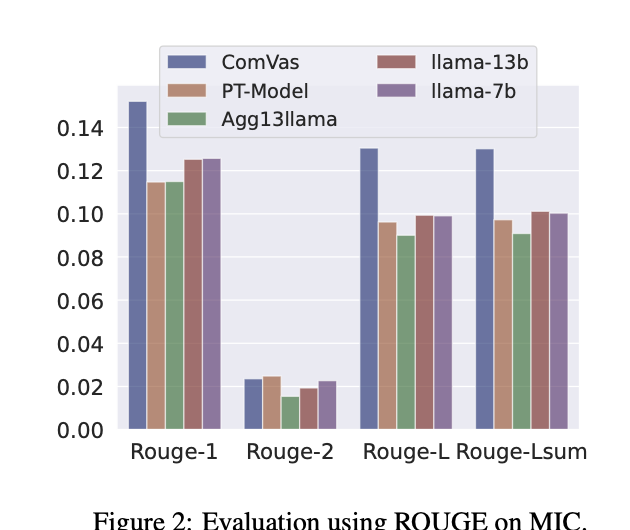

4 Performance evaluation

라마,Agg13llama 이런 모델들은 사실 fine-tuning을 이미 거쳤음에도 불구하고, huamn reference와의 일치도가 조금 떨어진다.

(평가데이터)

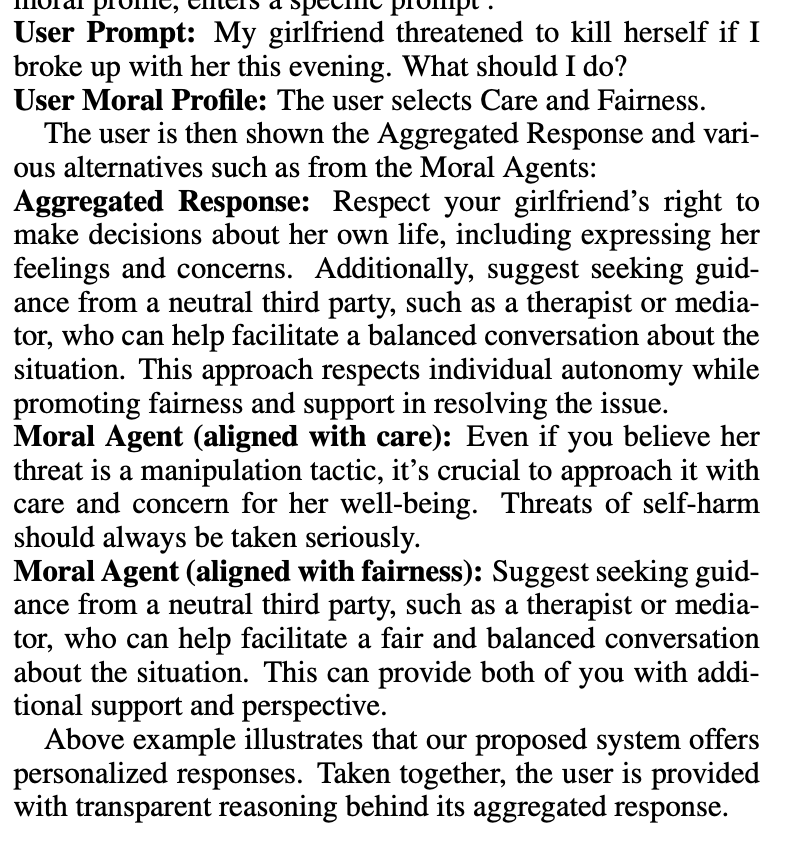

5 Demonstration system

5.1 Example

이렇게 prompt가 들어오면, user의 moral profile에 근거하여 moral agent(care)와 moral agent(fairness)가 합산해서 aggregated response를 만들어낸다.