Meta-Transfer Learning for Zero-Shot Super-Resolution

MZSR

0.기술:한 장의 사진에서 약간의 업데이트만으로 우수한 해상도 복원 성능

1.Transfer learning: 수많은 외부 사진으로 부터 학습된 특정 정보 활용

2.Meta-learning: 다양한 커널에 대해 빠르게 적응할 수 있다

3.연구 배경(이전 기술들의 특징 및 과정)

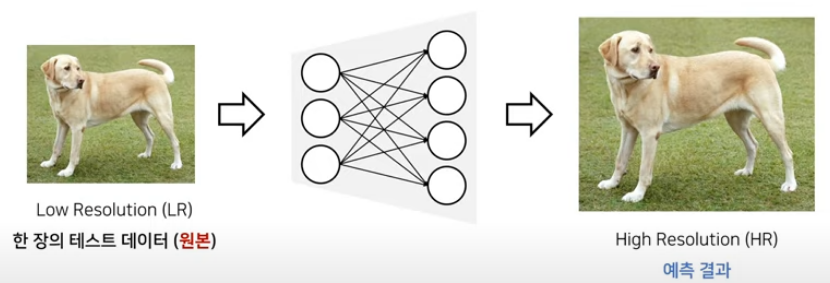

-Single Image Super-Resolution(SISR)

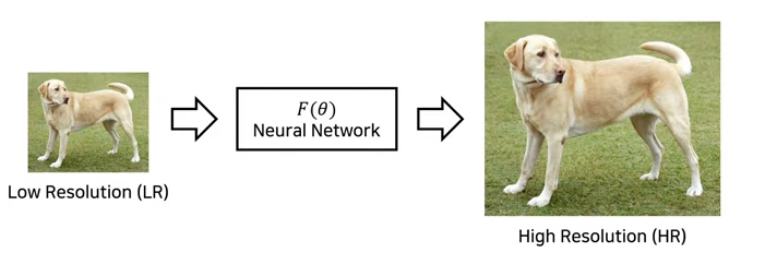

:한 장의 저행사도 이미지(LR)를 고행상도(HR)로 변환하는 방법 연구

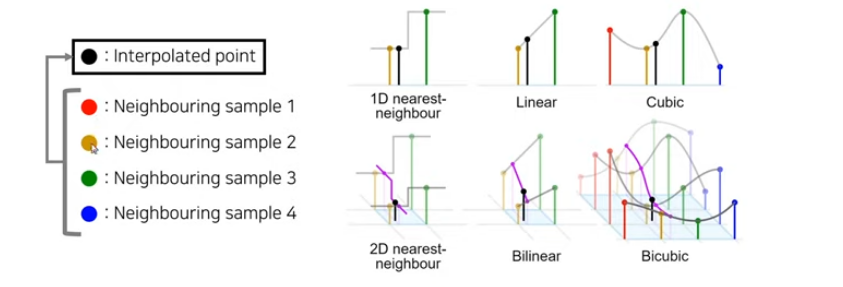

: 딥러닝 이전의 전통적인 방법

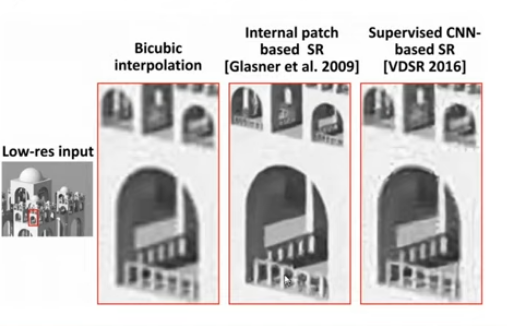

:최근 CNN기반의 접근 방식이 높은 성능

:전통적인 CNN기반의 Super-Resolution은 다음과 같은 모델 이용

-Externally Trained Network(Supervised SISR)

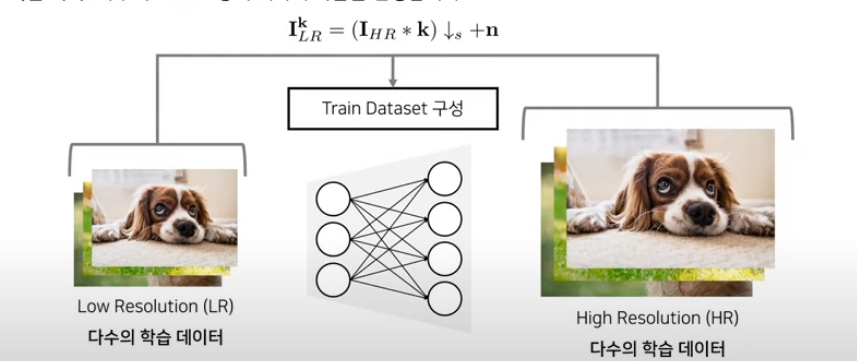

+학습 시기: 다수의 HR-LR쌍에 대해 학습 진행.

-

테스트 시기: 다수의 데이터로 학습된 정보를 기반으로 테스트 데이터에 대한 HR결과 예측.

+단점: bicubic에선 학습을 잘하지만 그 외 데이터 셋에서는 별 효과를 내비치지 못함

-

이미지 자기 반복성

-

한장의 이미지에도 자기 반복성 존재

-

내재된 데이터 반복을 특징으로 가진다.

-internal recurrance를 통해서 이미지 복원도 가능.

-Internally Trained Network(Unsupervised "Zero-Show" SISR)

: recurrences가 명확한 상태일 때 유용함

:내부적인 구조를 잘 학습할 수 있어서 유연서이 높다

+학습 시기: 테스트 이미지 자기 자신으로 부터 추출된 HR-LR쌍 학습진행

--> 한 장의 이미지에 특화된 CNN이 학습

+테스트 시기: 한 장의 이미지에 내재된 특징 정보를 토대로 고해상도에측

-> 단점: 학습된 네트워크는 해당 이미지에서만 사용 가능함.

학습 속도가 느림(수 많은 데이터를 업데이트 해야하기 때문)

-

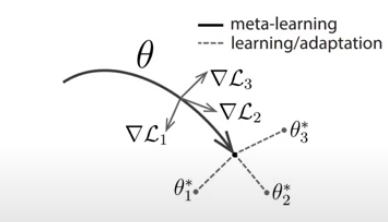

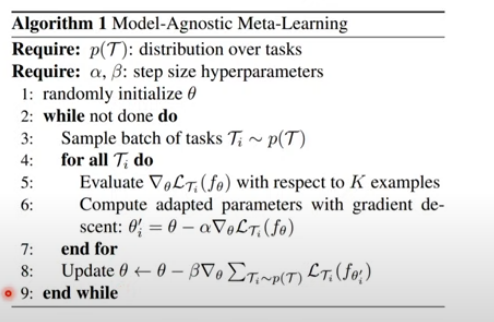

-MAML(Model-Agnostic Meta-Learning)

:모든 테스크에 적용되는 최초 가중치를 탐색하기

:optimization based methods

- 적절한 초기 가중치(weight)를 찾는 방법 -> 다양한 작업에 대해서 빠르게 적응할 수 있는 가중치를 찾아줌.

-->적은 internal recurrance를 가지고 학습이 가능해서 속도가 빨라지게 해주는 아이디어를 제공함 ->Fine-tuning에 도움을 줄 수 있음 --> 학습을 위한 학습을 하는 방식으로 가중치 초기화를 통해서

특정 테스크가 빠르게 진행하도록 도와줌.

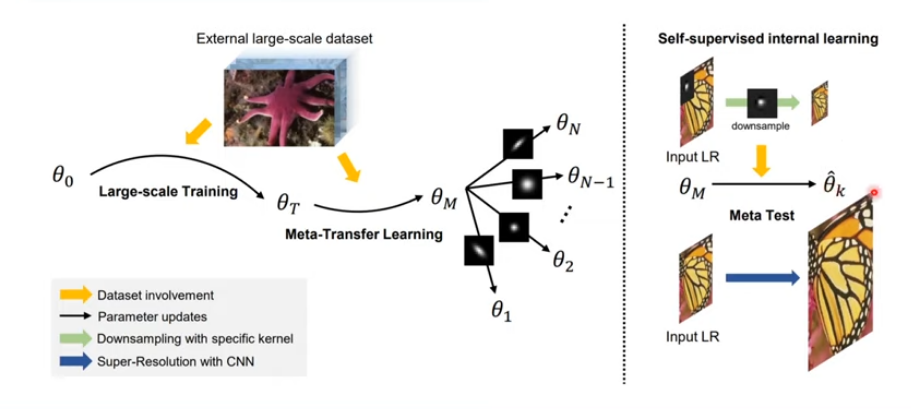

MZSR의 전체 동작 과정

MZSR

일반적인 최초 파라미터를 찾기 위해서 메타 러닝 메소드 사용하여 외부데이터까지 활용하고 자기 반복성도 사용한다.

이로 인해 적응이 빠르고 적용할 수 있는 이미지 조건이 넓다.

레이어가 되게 깊은 cnn모델.

실제 저해상도 모델은 biqbic형태로 다운샘플링이 되지 않은 것도 있다.

노이즈도 다른 분포로 다르게 들어갔을 수도 있다.

다양한 도메인에서 가능한가?(도메인 갭 줄이자)

-->자기 유사성을 이용하자

gradient updates를 통해서 하나의 네트워크 학습시킨다

MAML기법으로 인해서 적은 업데이트를 가지고도 적절한 가중치 찾아서 학습가능

transfer learning - bicubic에 맞춰서 세팅,ZSSR의 장점 살리는 방법

meta-learning - 다양한 테스크 나 커널에 대해 잘 동작하게 만들어준다.MAML기반이다.

- Meta-Test

LR image ->downsample->geneerate 작은 이미지 -> 몇 번의 가중치 update-> 원본 이미지 넣기-> 해상도 높게 나온다

Experiments

-

Training Details

ZSSR에서 사용하는 8 layer CNN architecture 사용

parameter 255K

-

Evaluations on "Bicubic" Downsampling

Set5, NB$D100, PSNR, SSIM이용

Bicucic 커널에는 동작을 못함 그렇지 않은 커널에선 잘함

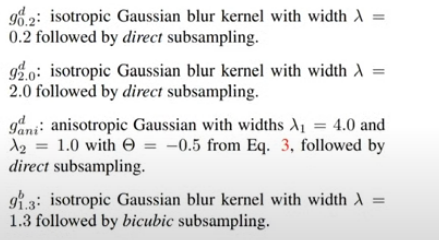

3.Evaluations on Various Blur Kernels

Conclusion

MZSR : 빠르고 유연하며 파라미터 갯수가 적어 가중치가 작다.

Transfer learning 후 빠른 적응을 위해 meta-learning사용

-->새로운 것이 들어와도 적절하게 맞는 가중치를 빠르게 학습시켜줌

--> 좋은 성능, 작은 gradient ->과거의 논문이나 기술 문제 해결