원인 : hive에서 생성한 테이블을 가지고 spark에서 select 할때 데이터를 읽지 못하는 이슈가 있다.

로그에도 정확한 에러가 나오지 않아 찾기 쉽지 않다

INSERT가 되지 않아 디버깅을 하다보니 hive에서는 select가 되지만 spark에서는 spark sql로 select가 되지 않고,

spark.write.parquet로 hdfs파일을 읽으면 데이터가 보이는 현상

에러

WARN HiveMetastoreCatalog: Unable to infer schema for table 테이블명 from file format Parquet (inference mode: INFER_AND_SAVE). Using metastore schema.

이게 힌트가 아닐까 한다..

이는 CREATE 를 SPARK로 하면 이런 현상이 없어짐을 알 수 있는데, 생성된 DDL을 살펴보면 이유를 알 수 있었다.

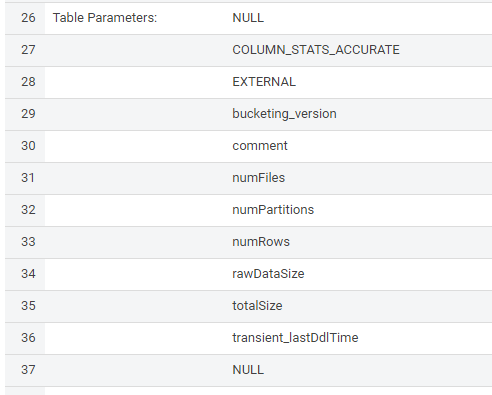

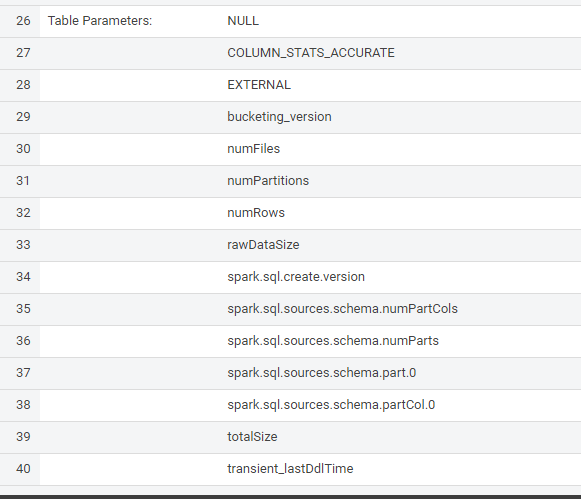

desc formatted 테이블 명

SPARK로 시작하는 부분이 모두 존재 해야 정상적으로 데이터를 읽을 수 있다