🟢 Introduction

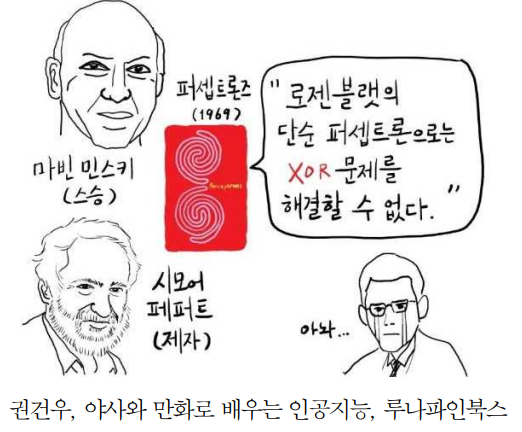

오류역전파가 나오게 된 계기가 무엇일까?

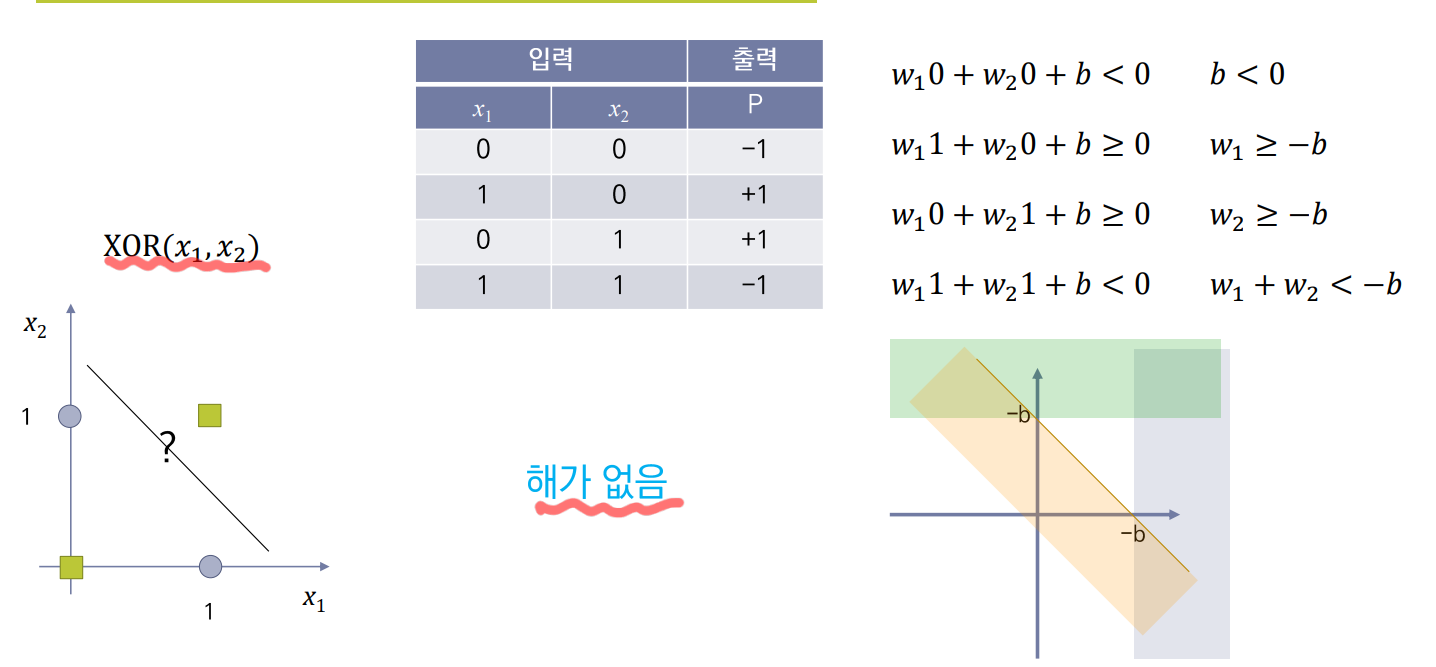

- 1969년 Perceptrons 책에서 XOR 문제는 perceptron으로 해결하지 못하는 것을 수학적으로 증명.

- XOR 문제 해결을 위해서는 multilayer perceptron (MLP) 필요하다는 것을 알게 됨.

- 그러나, MLP를 학습할 수없다고 주장.

No one on earth had found a viable wayto train MLPs good enough to learn such simple functions

지구상 그 누구도 그런 간단한 기능을 배우도록, MLP를 훈련시키는 훌륭한 방법을 찾지 못했다.

결론부터 말하자면, 오류역전파를 통해 MLP를 학습 시킬 수 있다.

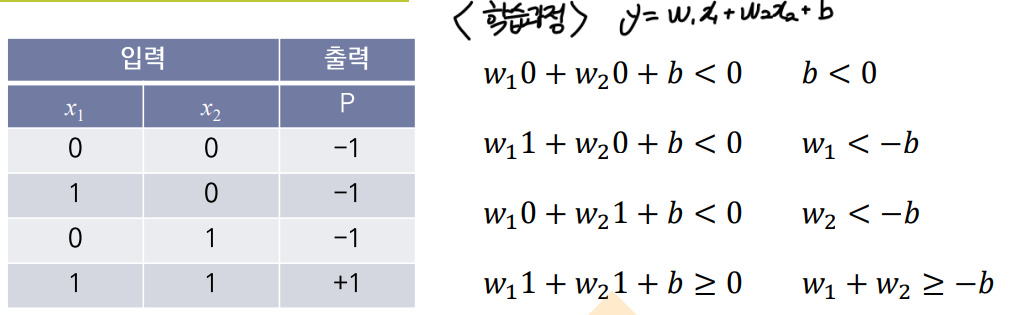

퍼셉트론의 학습 (단층 구조)

MLP의 학습을 보기 전, 단층구조의 퍼셉트론부터 어떻게 학습이 이루어지는 지 살펴보자.

이와 같은 AND게이트를 학습시킨다고 하자.

학습이라 함은 즉, 최적의 (weight)값을 찾는 것이다.

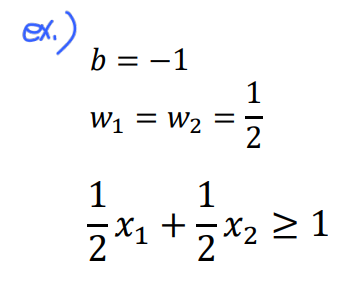

다음과 같은 AND게이트의 입력과 출력이 있을 때, 의 식에 대입하게 되면 다음과 같다.

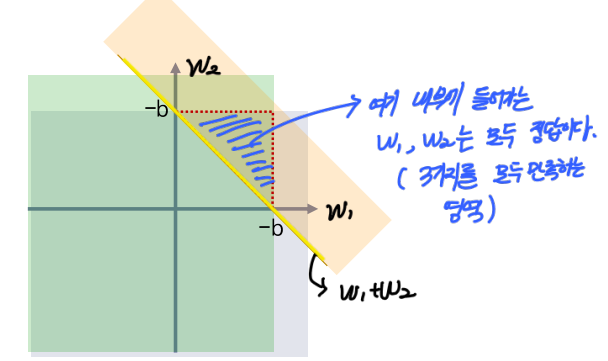

이를 통해 구한 영역을 좌표평면상에 나타내보자.

와 와 세 영역을 나타내고 이들이 겹쳐지는 부분이 바로 정답 가 될 것이다.

해당 영역을 만족하는 는 모두 AND게이트를 정확하게 나타낼 수 있는 "정답"이라고할 수 있다.

- 정답 영역 예시

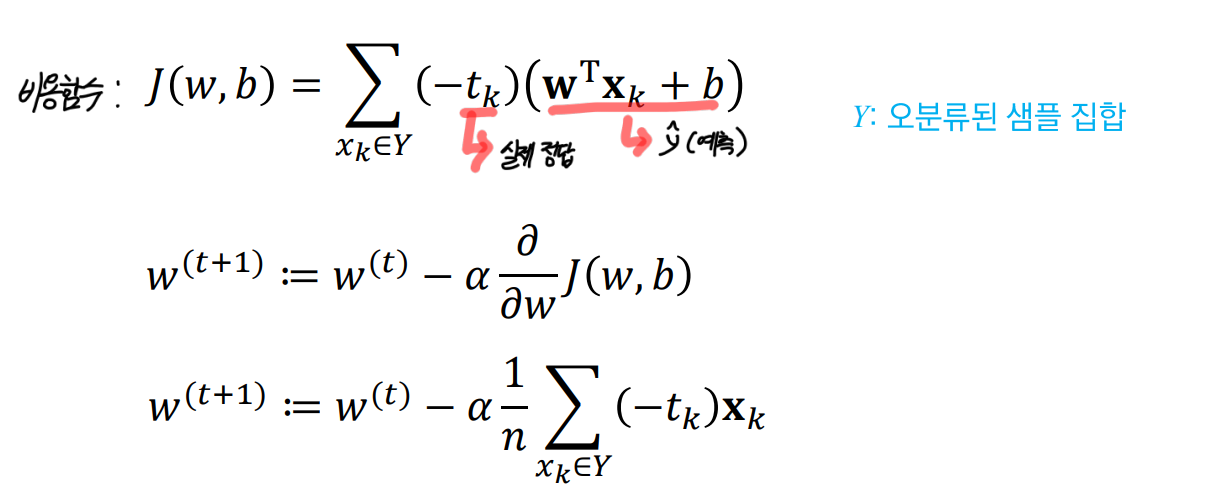

이러한 값의 업데이트는 다음과 같은 비용함수를 통해 이루어진다. (비용함수를 미분하여 경사하강법을 수행)

- 당연하게도 단층 구조로는 XOR을 표현할 수 없다. -> 다층구조를 사용하자!

퍼셉트론의 학습 (다층 구조)

다층구조의 퍼셉트론의 학습은 오류 역전파를 통해서 이루어진다.

(오차 역전파 또는 오류 역전파로 불린다.)

기본적인 weight를 update하는 과정은 기존 Linear resgression 및 logistic regression에서 사용한 방법과 동일하다. 오차가 출력레이어를 통해 나온 예측값과 실제 정답과의 차이인 오차(loss)를 사용하여 weight를 갱신해주는 것이다.

즉, 오차 함수(손실함수 또는 비용함수)를 미분한 값을 빼주는 형식을 통해 갱신하는 Gradient Descent을 수행하게 된다.

오차 역전파

여기서 왜 오차역전파인지를 생각해보자.

결국 이러한 오차는 일련의 MLP를 쭉 통과하며 결과로 나온 예측값에 대한 오차를 말한다.

이러한 오차를 확인하고, 해당 오차를 통해서 각 node의 weight값을 적절하게 update하는 과정이 필요하다.

즉, 마지막 output layer까지 전달된 값으로 오차를 통해, 앞쪽에 있는 node들의 weight의 update에 사용(전파)되는 것이다. 그렇기에 오차가 앞으로(역으로) 전파 되므로 오차 역전파라 불린다.

MLP의 학습 과정

뒤에 나오겠지만, 계산 그래프의 방법으로 훨씬 쉽게 오차 역전파를 수행할 수 있다.

앞쪽에서 시행된 weight의 값을 맨 마지막에 output으로 구해진 결과를 통해 알아낸 오차를 바탕으로 업데이트 하는 것은 여간 어려운 일이 아니다.

결국 해당 오차와 weight간의 관계를 나타내는 비용함수 or 손실함수를 편미분한 값을 통해 update하는 것이기 때문이다.

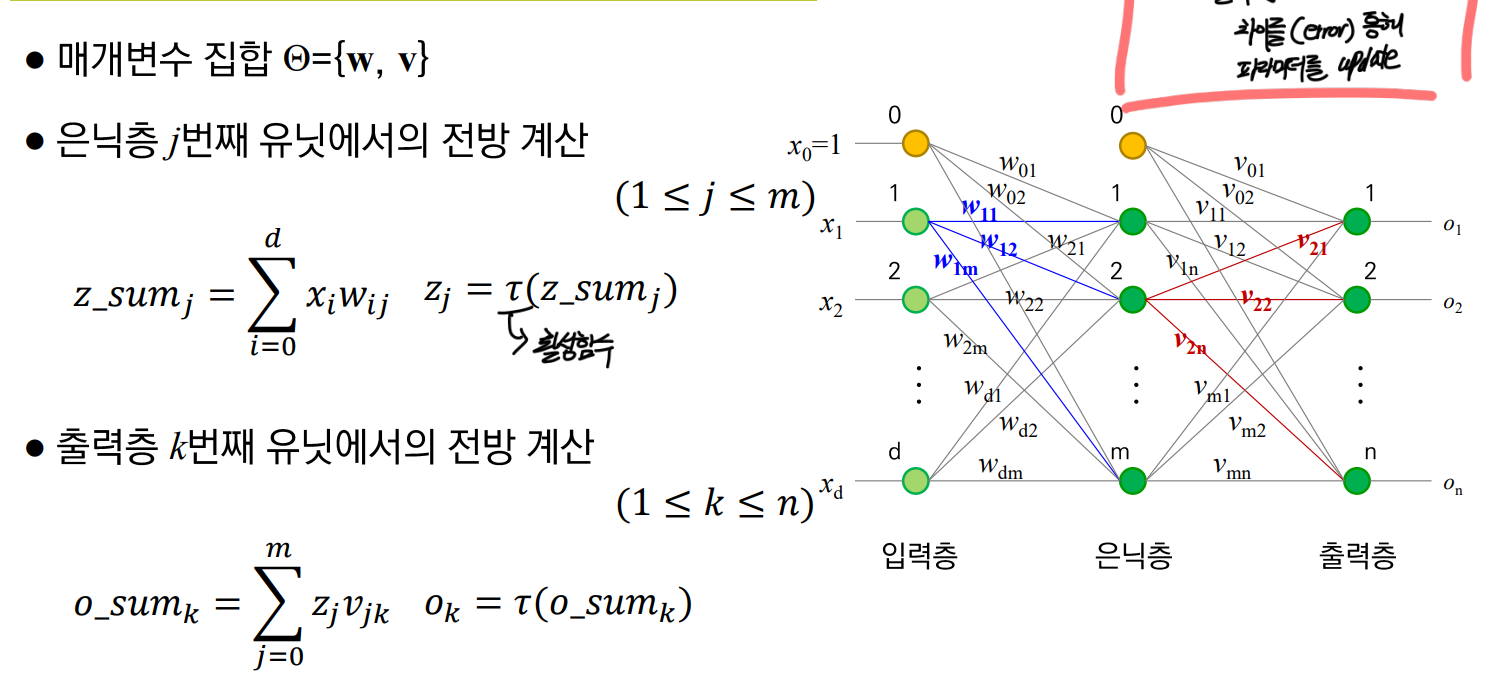

이를 MLP의 예로 살펴보자.

아래 3가지 과정을 거친다.

1) 전방 계산

2) 비용함수 정의(MSE)

3) 가중치 계산(Update)

1) 전방 계산

- 은닉층의 유닛을

z, 출력층의 유닉을o라고 한다.- 은닉층의

z에 전달되는 값은 이전 입력층에서의 유닛들의 값() x 가중치()의 합이다.- 출력층

o에 전달되는 값은 이전 은닉층에서의 값() x 가중치()의 합이다.

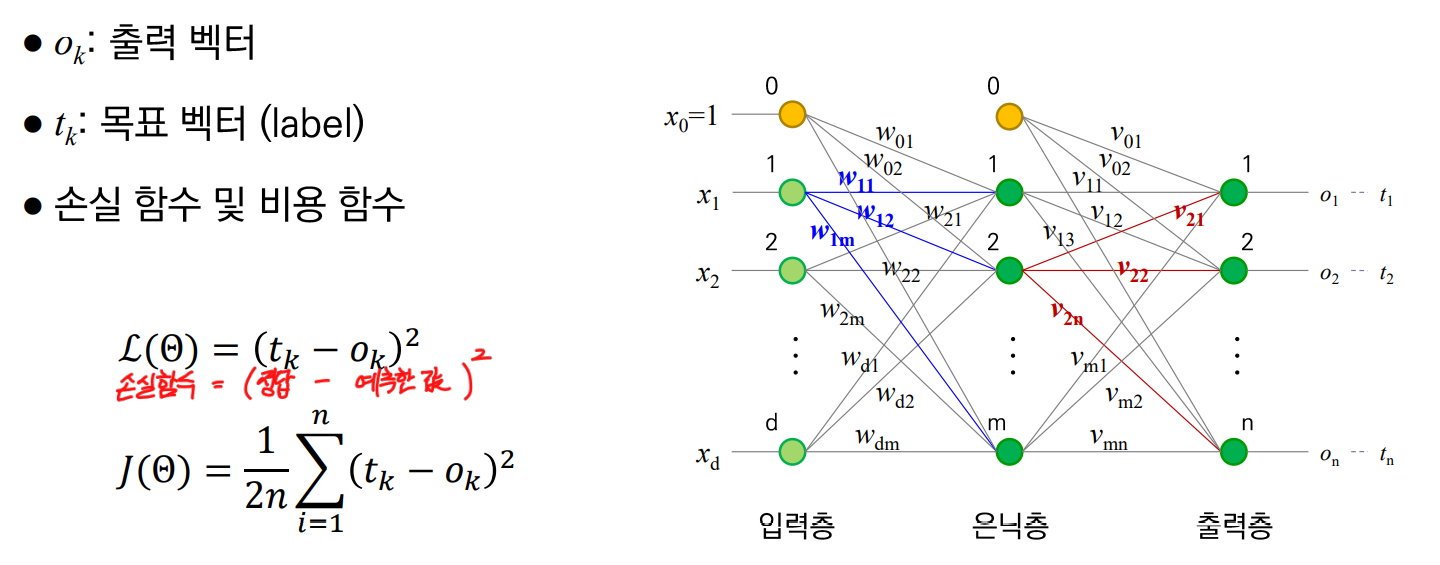

2)비용함수 정의(MSE)

- 비용함수(J)로는 우리에게 익숙한 MSE를 쓴다.

비용함수란 결국, 손실함수(L)를 평균낸 값이므로 다음과 같이 표현된다.

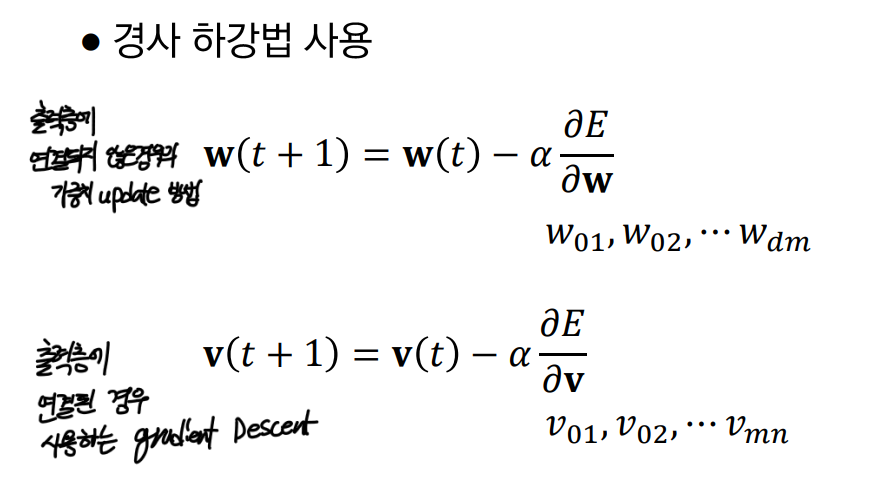

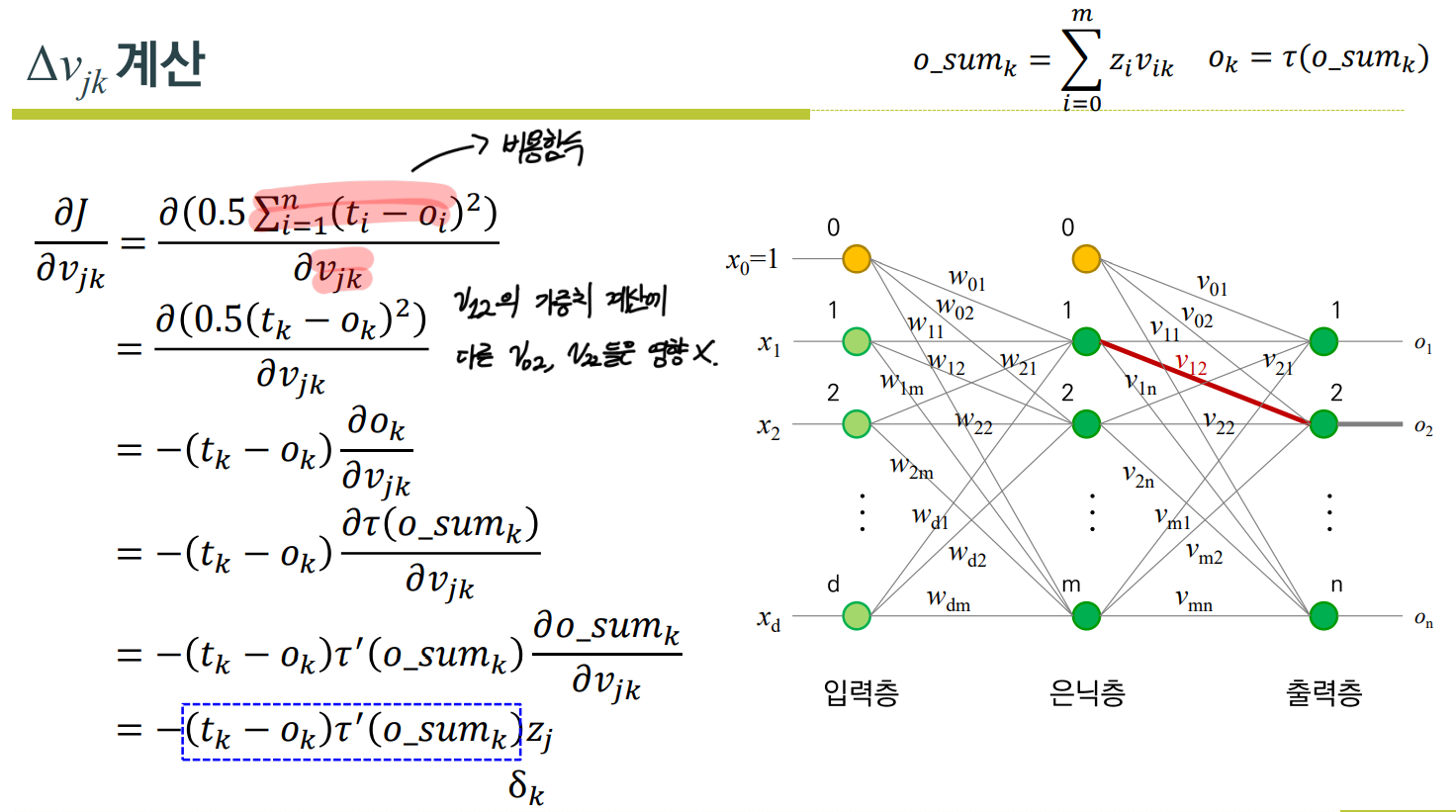

3)가중치 계산(Update)

- 가중치 계산이란 결국, gradient descent를 수행하는 것이다.

- 출력층에 연결된 가중치 w와, 출력층에 연결된 가중치 v를 나눠서 업데이트한다.

위 식처럼w와v에 대해서 비용함수를 각각 편미분하여 값을 구하면 된다.

하지만 이 과정이 상당히 복잡하다.

아래 식을 보자.

그나마 v는 오차가 계산된 최종 출력층과 가까워서 덜 어렵지만, w는 앞으로(먼저 수행된 쪽)갈수록 오차를 구해진 레이어와는 멀어져, 고려해야할 유닛이 더 많아지기에 더욱 복잡해진다.

- V

- W

너무 어렵다. → 계산 그래프를 써보자.

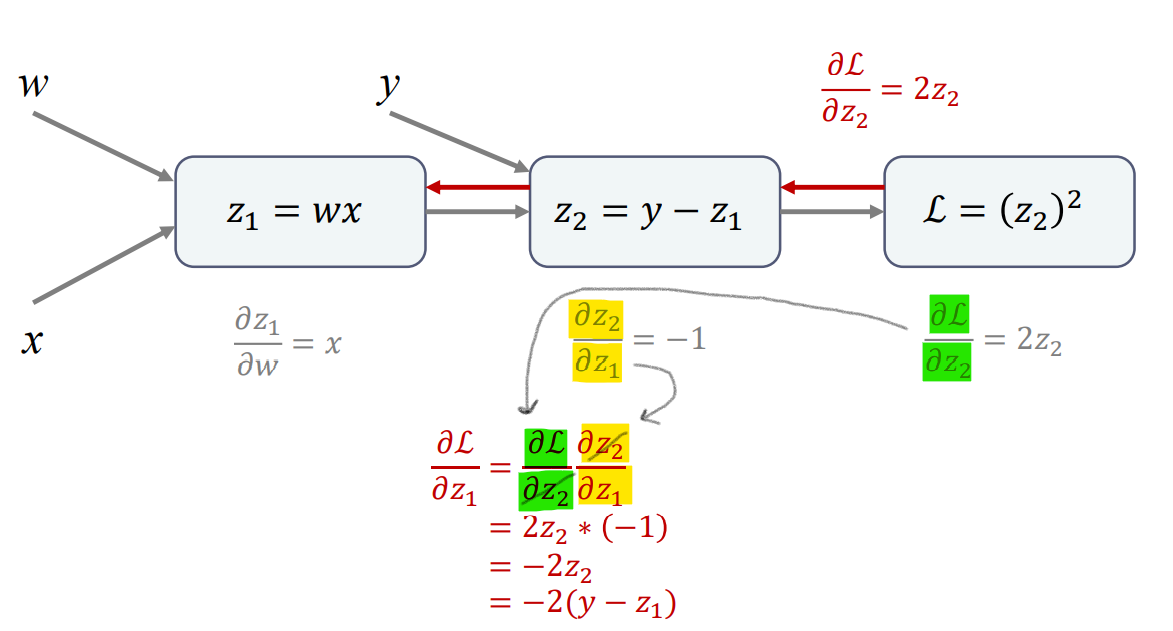

Linear Regression 계산 그래프

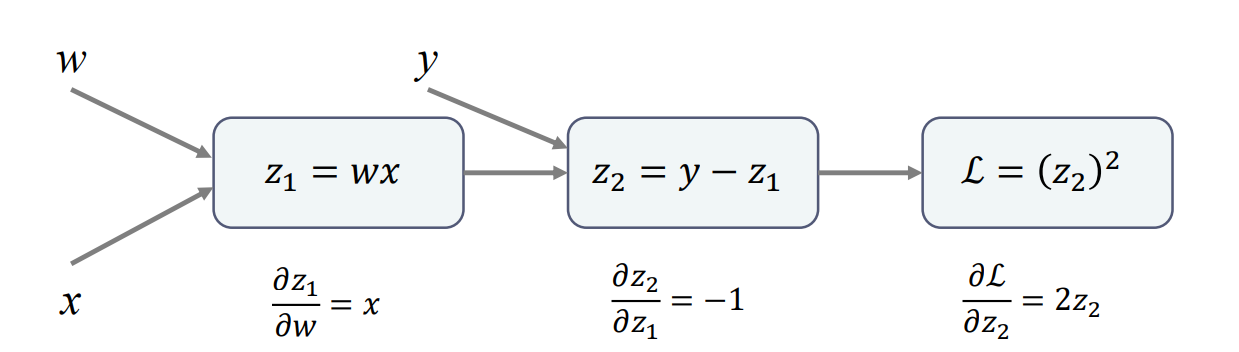

Linear Regression을 예시로 오차역전파가 어떻게 이루어 지는지 살펴보자.

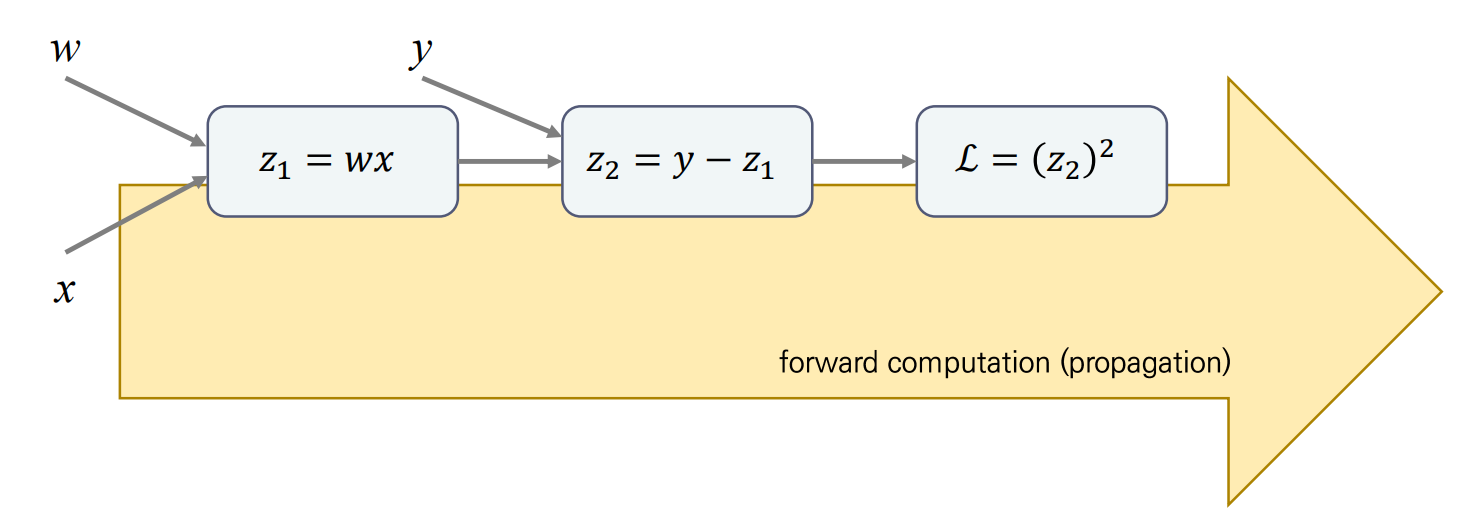

아래와 같은 사진을 계산 그래프라고 하는데, 이와 같은 계산 그래프를 이용하면 쉽게 오차역전파를 계산할 수 있다.

함수의 예를 통해 알아보자.

기본적인 Linear Regression과정은 다음과 같다.

- 예측한 를 정답 값에서 뺀다. (오차를 계산)

- 해당 오차를 제곱한다. (오차의 방향성을 제거(-,+))

- 해당 오차와 weight사이의 관계를 나타내는 함수가 구해진다.(Loss Function)

- 함수를 미분한 값에 적당한 lr를 곱하여 weight값에서 빼준다. (weight 업데이트)

- 이번 계산 그래프에서는 cost function인 MSE가(Batch방식) 아닌 하나의 오차에 대해서 Loss를 통해 업데이트 하는 SGD방식을 살펴본다.

- 4)번 과정에서 weight를 업데이트하기 위한, 함수를 미분한 값()를 구하는 것 까지만 진행해보도록 한다.

계산 그래프

다음과 같은 전방계산을 수행하며, Linear regression이 진행될 것이다.

모델을 정의하고, 예측한 결과에서 실제 값를 뺀 후 제곱한다.

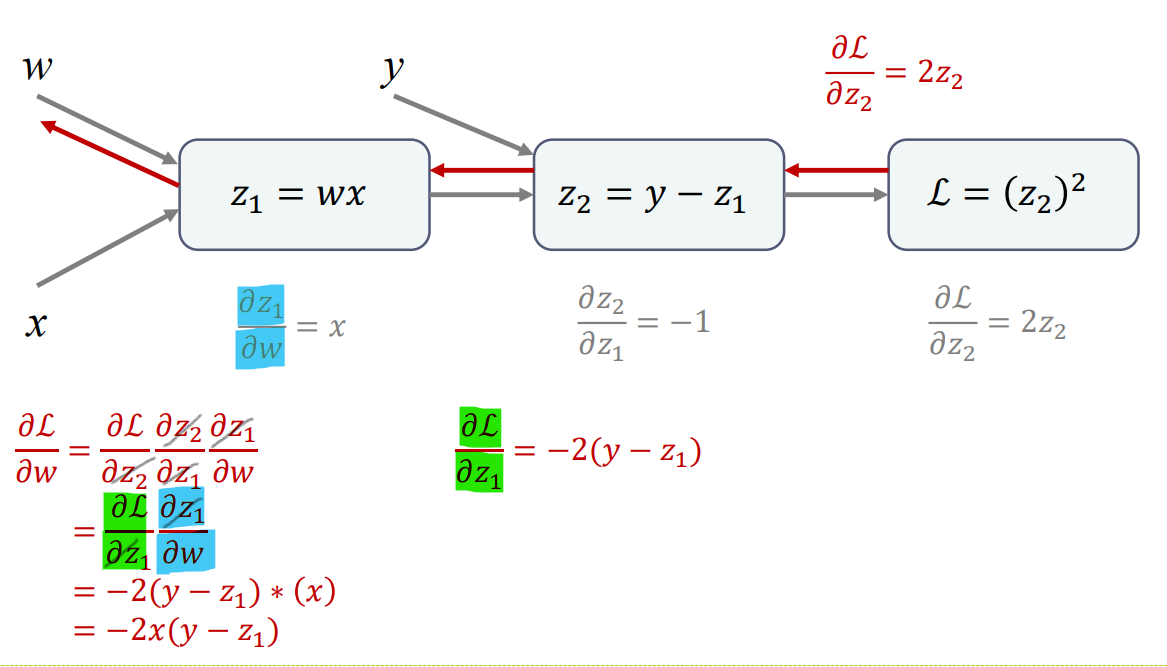

결과적으로 weight를 업데이트하기 위해서는 의 값이 필요하다. (Loss function을 편미분 한 값)

이 값은 Chain Rlue을 사용하면 쉽게 구할 수 있다. 식을 보면 어렵지 않다.

chain rule

체인룰이란, 마치 체인처럼 미분값들이 서로 얽혀 있다는 것인데, 어떤 변수의 변화율을 구하려다보니 3번이 사용되고, 3번 2번이 사용되고, 2번을 구하려니 1번이 사용되는 것을 말한다.

전방계산 시에 미리 편미분값을 저장해 둔 후, 해당 편미분 값을 이용해서 간단하게 편미분값(update에 필요한 값)을 알아내고, 이를 통해 오차역전파를 수행할 수 있는것이다.

체인룰을 사용하면 아래와 같이 이전 값을 통해서 쉽게 구하고자하는 층의 "오차함수의 미분값" 즉, update에 필요한 ()를 구할 수 있는 것이다.

1) 전방 계산 시, 미리 편미분 값(변화량)을 구해둔다.

2) 전방 계산 시, 구한 편미분 값을 통해, 에 대한 의 변화량을 구한다.![]

3) 에 대한 의 변화량을 통해 최종구하고자 하는 에 대한 의 변화량을 구할 수 있다.