Quora Question Pairs

- 문제 정의

- task가 해결하고자 하는 문제가 무엇인가?

quora에 올라온 질문 페어가 동일한 의미를 갖는지 확인 - 데이터셋 소개(대표적인 데이터셋 1개)

- task를 해결하기 위해 사용할 수 있는데 데이터셋이 무엇인가?

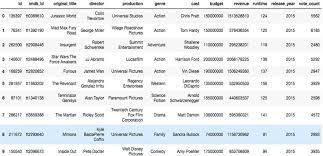

IMDb

- 데이터 구조는 어떻게 생겼는가?

- SOTA 모델 소개(대표적인 모델 최소 2개 이상)

- task의 SOTA 모델은 무엇인가?

ERNIE-Doc-Large, XLNet- 해당 모델 논문의 요약에서 주요 키워드들에 대한 설명

ERNIE-Doc-Large : transformer의 반복

XNLet : 기대되는 likelihood를 최대화 하는 bidirectional context 학습, autoregressive formulation을 통한 BERT 한계 극복 - task가 해결하고자 하는 문제가 무엇인가?

텍스트 분류

- 해당 모델 논문의 요약에서 주요 키워드들에 대한 설명

Qustion Natural Language Inference

-

문제 정의

- task가 해결하고자 하는 문제가 무엇인가?

SQuAD의 이진분류 버전. paragraph가 answer를 포함하는지 안하는지 확인하는 문제. -

데이터셋 소개(대표적인 데이터셋 1개)

- task를 해결하기 위해 사용할 수 있는데 데이터셋이 무엇인가?

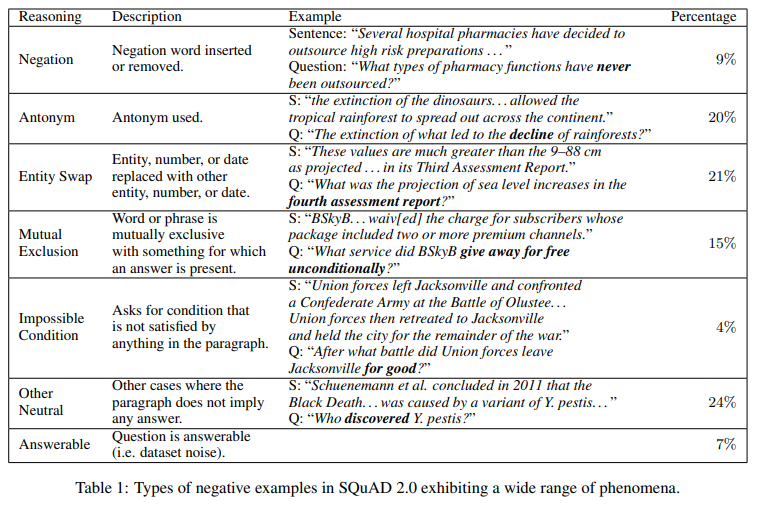

QNLI- 데이터 구조는 어떻게 생겼는가?

- 데이터 구조는 어떻게 생겼는가?

-

SOTA 모델 소개(대표적인 모델 최소 2개 이상)

- task의 SOTA 모델은 무엇인가?

ALBERT, RoBERTa- 해당 모델 논문의 요약에서 주요 키워드들에 대한 설명

ALBERT : Comprehensive empirical evidence, self-supervised loss

RoBERTa : Bert의 pretrained model을 robust하게 최적화하는 접근 - task가 해결하고자 하는 문제가 무엇인가?

text에 질문에 대한 답이 포함되는지를 확인하는 문제

- 해당 모델 논문의 요약에서 주요 키워드들에 대한 설명

Corpus of Linguistic Acceptability

- 문제 정의

- task가 해결하고자 하는 문제가 무엇인가?

영어문장이 언어학적으로 acceptable한지 확인하는 이진분류문제 - 데이터셋 소개(대표적인 데이터셋 1개)

- task를 해결하기 위해 사용할 수 있는데 데이터셋이 무엇인가?

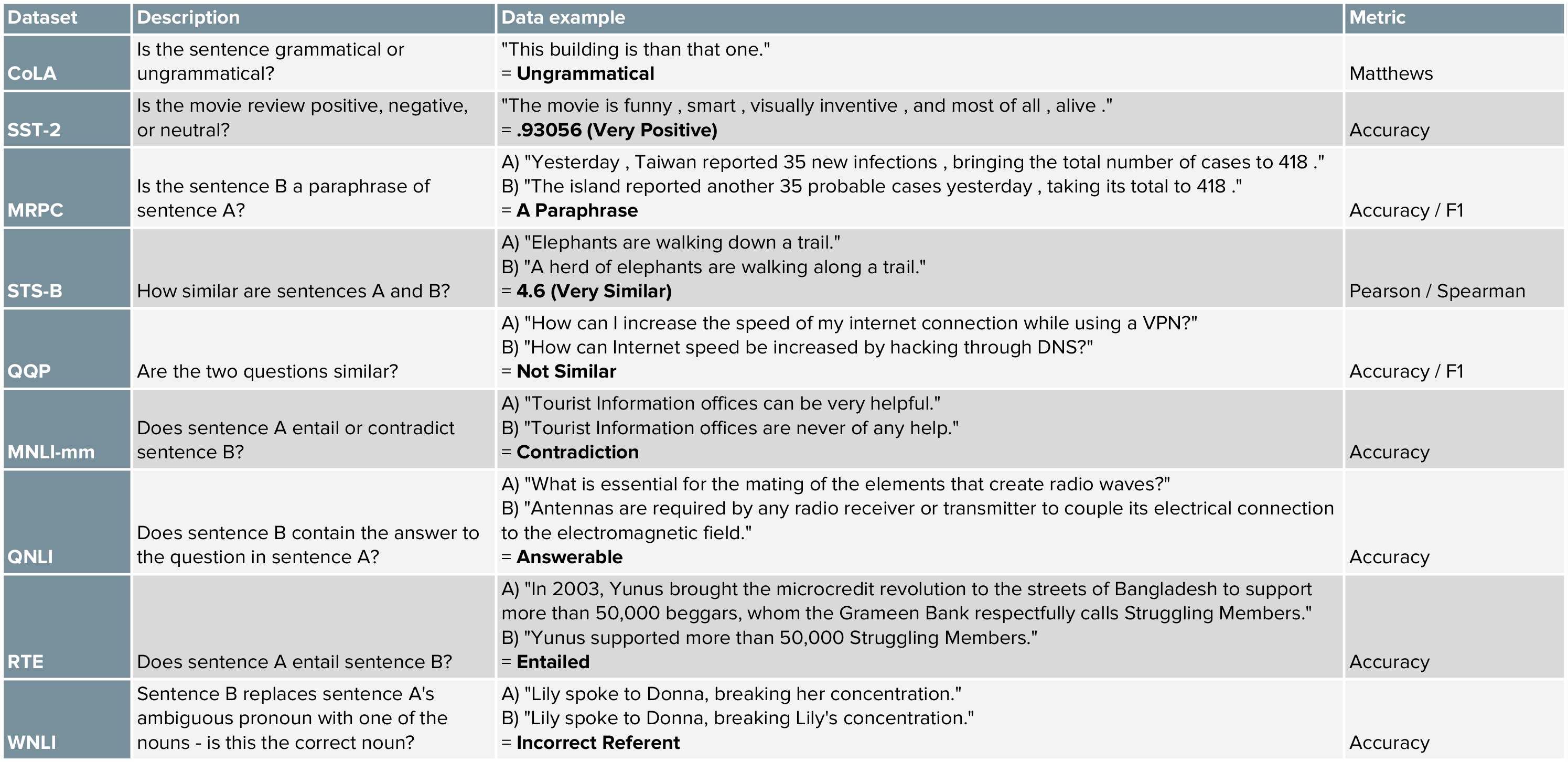

GLUE- 데이터 구조는 어떻게 생겼는가?

- 데이터 구조는 어떻게 생겼는가?

- SOTA 모델 소개(대표적인 모델 최소 2개 이상)

- task의 SOTA 모델은 무엇인가?

T5-11B, ELECTRA- 해당 모델 논문의 요약에서 주요 키워드들에 대한 설명

T5-11B : text-based language problem의 text-to-text format으로의 단순화

ELECTRA : Replaced Token Detection을 활용한 pre-training 기법의 사용 - task가 해결하고자 하는 문제가 무엇인가? 문법성 판단

- 해당 모델 논문의 요약에서 주요 키워드들에 대한 설명

Reference

https://mccormickml.com/2019/11/05/GLUE/

https://vanche.github.io/NLP_Pretrained_Model_BERT(2)/

https://blog.pingpong.us/electra-review/

좋은 글 감사합니다!