The tendency of an artificial neural network to completely and abruptly forget previously learned information upon learning new information

새로운 정보를 학습할 때 이전에 학습된 정보를 망각하는 현상

데이콘 한국어 문장 관계 분류 대회에 참가하여 코드를 실험하던 중, 다음과 같은 수상한 현상이 발생

pretrained된 roberta large 모델을 사용하여 fine tuning 하던 중 loss와 acc가 함께 증가하는 수상한 현상

accuracy를 training accuracy로 잘못 설정했나 싶어 확인하였지만, validation accuracy로 잘 설정되어 있었음

이에 구글링해보니 catastrophic forgetting 이라고 하는 현상의 징후임을 발견

Catastrophic Forgetting

모델이 현재 주어진 데이터를 학습할 때 기존에 배운 지식을 잃는 현상을 Catastrophic Forgetting, 파괴적 망각이라고 칭함

전이 학습, 파인 튜닝시 자주 발생하는 현상

Why? 각 weight 들이 해당 task를 학습할 때 정확히 어떤 correlation이 있는지 모르는 딥러닝에서, 파인 튜닝 시 weight를 섣부르게 바꾸면 기존 task를 망각하는 것은 자연스러운 것

이는 전이 학습의 대표적인 약점으로 이전 학습 dataset과 새로운 학습 dataset간의 연관성이 있더라도 이전 dataset에 대한 정보를 대량으로 손실

가장 쉬운 해결 방법으로는 과거의 데이터와 새로운 데이터를 mix해 처음부터 학습하는 것이나 이는 연산 자원의 낭비가 매우 심함

Continual Learning

이를 해결하기 위한 방법론으로 Continual Learning이 등장

Regularization Methods

우리가 아는 Regularization 방법론은 흔히 loss 함수에 제약을 걸어 정규화하는 방식이나 이는 bias를 크게 만듬

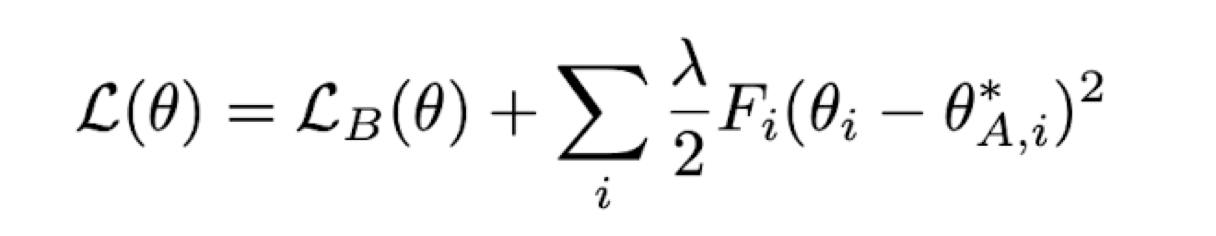

Catastrophic Forgetting을 위해 제안된 regularization인 Elastic Weight Consolidation (EWC: Overcoming catastrophic forgetting in neural networks (James Kirkpatrick et al., 2017))은 second order differential equation을 정규화함

즉 변화량의 변화율을 정규화 하는 것으로 모델을 업데이트 하는 것

Rehearsal Methods

Memory Bucket 혹은 examplar 개념을 활용해 과거 dataset을 저장하고 현재 task에서 추가로 같이 학습하는 방법

대표적으로 iCaRL (Incremental Classifier and Representation Learning (Sylvestre-Alvise Rebuff et al., 2017) 과 같은 방법론 등이 존재하는데 간단하게 과거 데이터셋을 랜덤하게 메모리에 추가하여도 Catastrophic Forgetting 방지에 큰 효과를 줄 수 있음

결론

이외에도 여러가지 방법론이 존재하나, Catastrophic Forgetting을 해결하기 위해서는 간단하게 다른 모델을 사용하는 등의 방법이 있음

생소한 결과물로 인해 뜻 밖의 지식을 습득하여서 유익하였음