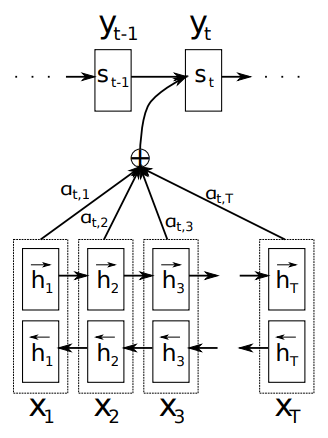

Neural Machine Translation by Jointly Learning to Align and Translate (a.k.a. Bahdanau Attention)

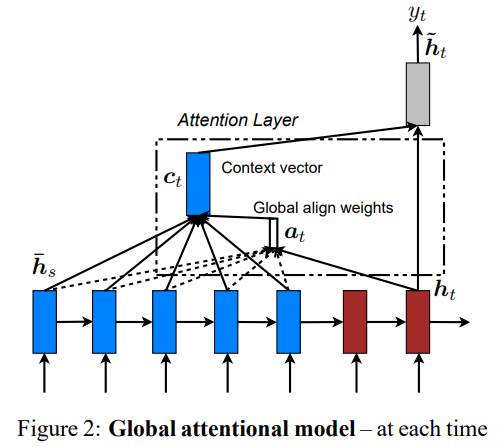

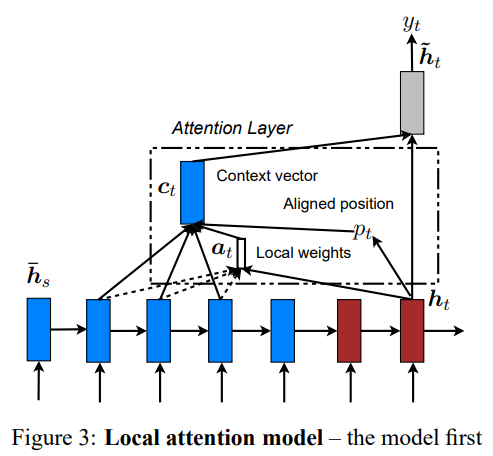

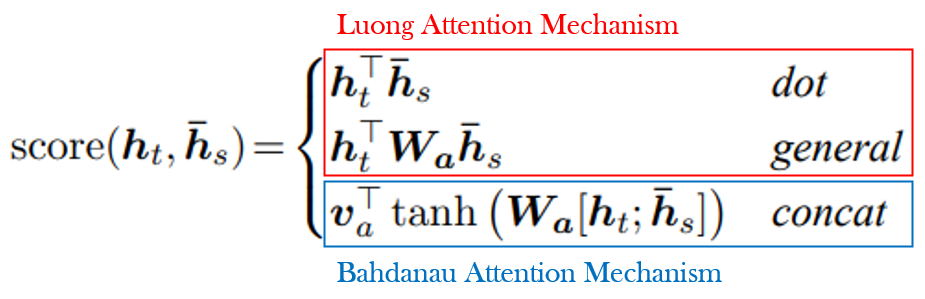

Effective Approaches to Attention-based Neural Machine Translation (a.k.a. Luong Attention)

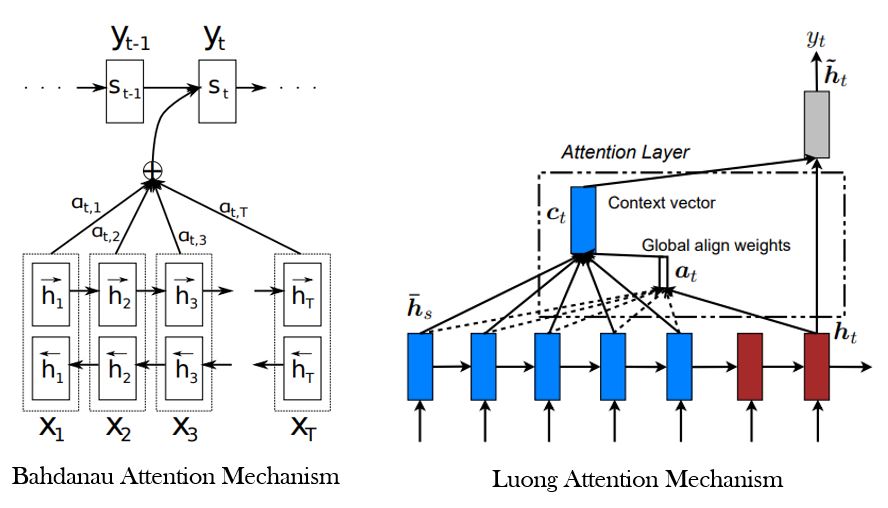

어텐션 메커니즘은 신경망 기계 번역 연구에서 등장한 방법론이다. 두 논문 모두 비슷한 시기에 발행되었다. 여기서 잠깐 논문에 등장하는 모델 구조를 보도록 하자.

Bahdanau Attention

Luong Attention

Attention Mechanism의 원리 증명

학부연구생 시절, Attention Mechanism을 이용하여 논문을 썼던 적이 있다. 논문을 쓰기 위해 Bahdanau Attention과 Luong Attention을 리뷰했던 적이 있다. 두 논문의 구조가 비슷해 보이고, 곱셈(dot)은 덧셈(concat)의 축약화라 생각하여 Bahdanau Attention과 Luong Attention의 결과가 비슷한 이유를 수학적으로 증명할 수 있을 거 같다는 생각을 했다.