Contrastive Learning

Self-Supervised Learning

- Unlabeled dataset을 input으로 받아 사용자가 정의한 문제(Pretext Task)를 학습하게 하여, 데이터의 feature를 학습하는 방법이다.

- Pretext task가 잘 짜여져있다면 Unlabeled dataset을 효과적으로 represnetation 할 수 있다.

Pretext task

- 사용자가 정의한 새로운 모델

- 모델은 pretext task를 학습함으로써 데이터 자체에 대한 이해를 높일 수 있다.

- pre-trained 모델을 Pretext Task에 대하여 학습함으로써 Down Stream Task를 더 잘 해결할 수 있게 된다.

- 주어진 입력 이미지들에 대한 정보를 잘 추출하는 방식

Contrastive Learning

- 입력 샘플 간의 비교를 통해 학습한다.

- self-supervised learning(자기지도학습)에 사용되는 접근법 중 하나이다.

- 샘플 간의 비교를 통해 표현을 학습한다.

- 학습된 표현 공간 상에서 비슷한 데이터는 가깝게, 다른 데이터는 멀게 존재하도록 표현 공간을 학습

- CRL 또한 표현학습을 수행하기 위한 방법 중 하나로 볼 수 있다.

- 같은 이미지로부터 augmentation된 represnetation 쌍의 유사도를 높이고 다른 이미지로부터 augmentation된 쌍의 유사도를 낮추는 방향을 진행된다.

- 큰 베치사이즈를 설정하게 된다.

Postive Pair를 구성할 때는 원본 이미지에서 image transformation을 적용한 augmented image를 생성하여 pair를 구성한다.

- random crop

- resizing

- blur

- color distortion

- perspective disortion

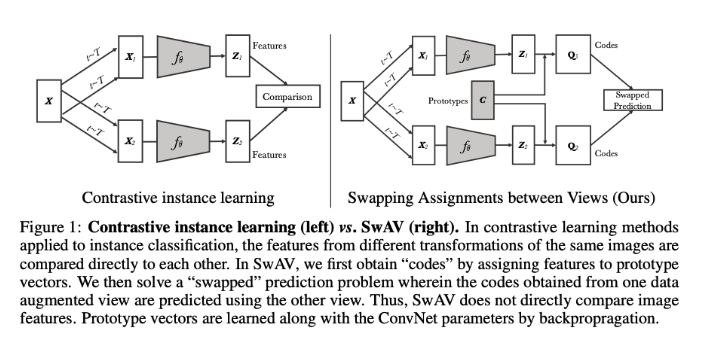

SwAV

- 추출한 feature들을 직접적으로 비교하지 않고, 같은 이미지로부터 파생된 서로 다른 augmentated 이미지에 cluster를 할당하여 서로의 cluster를 맞바꾸어 예측한다.

- 한 쌍의 augmentation을 적용하는 기존의 방법들과 달리, multi-crop이라는 새로운 augmentation 방법을 제안한다.

출처 :Swapping Assignments between multiple Views of the same image