강의 복습 내용

[DAY 33]

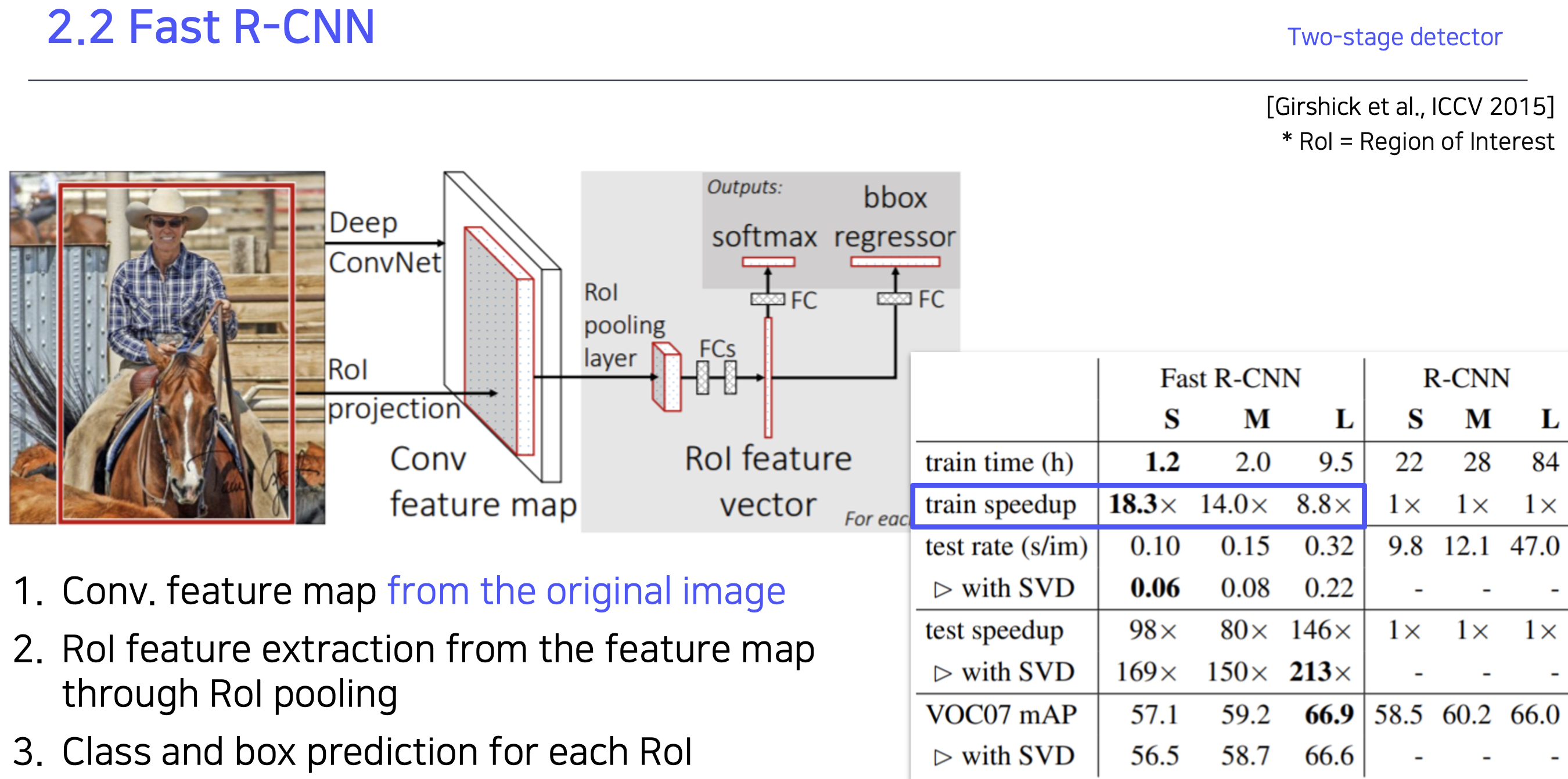

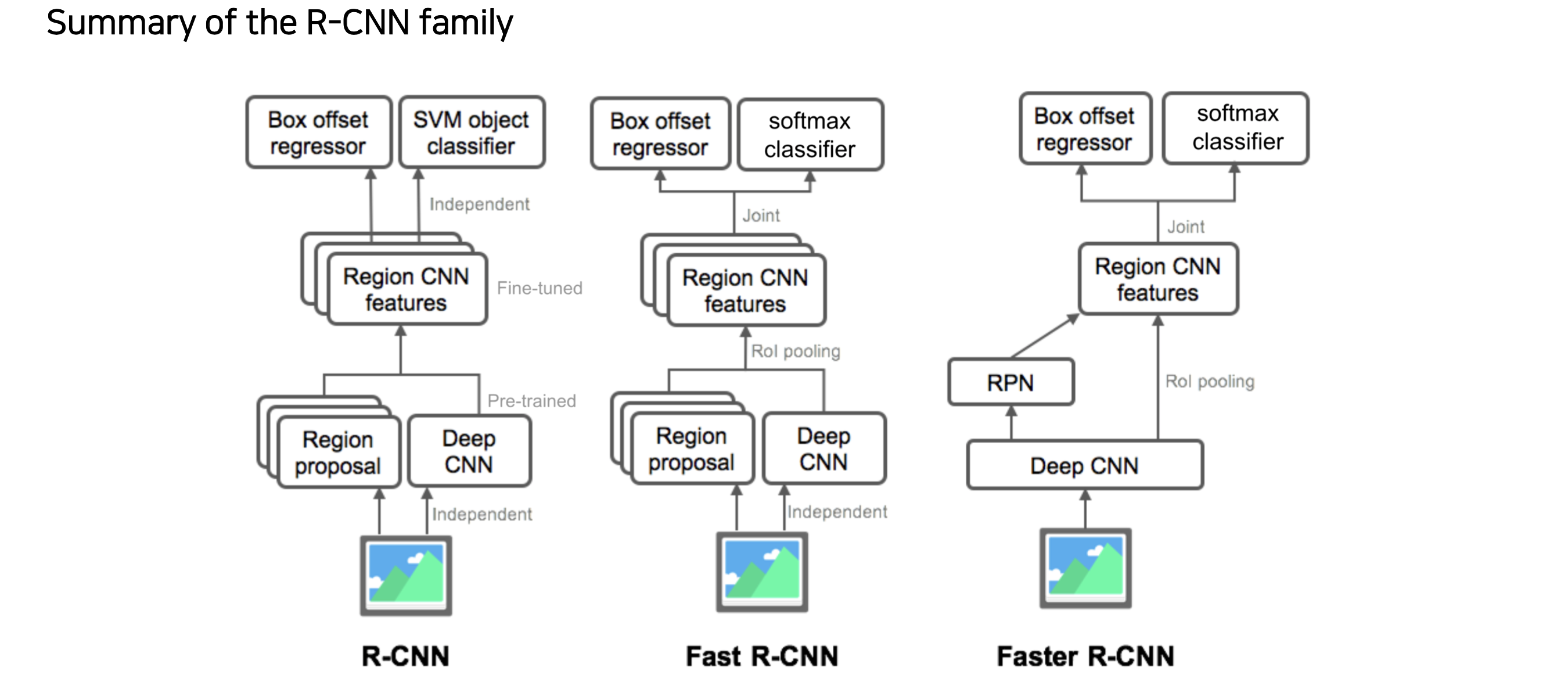

(5강) Object detection

2.3 Faster R-CNN

- Non-Maximum Suppression (NMS)

- Step 1: Select the box with the highest objectiveness score

- Step 2: Compare IoU of this box with other boxes

- Step 3: Remove the bounding boxes with IoU ≥ 50%

- Step 4: Move to the next highest objectiveness score

- Step 5: Repeat steps 2-4

(6강) CNN visualization

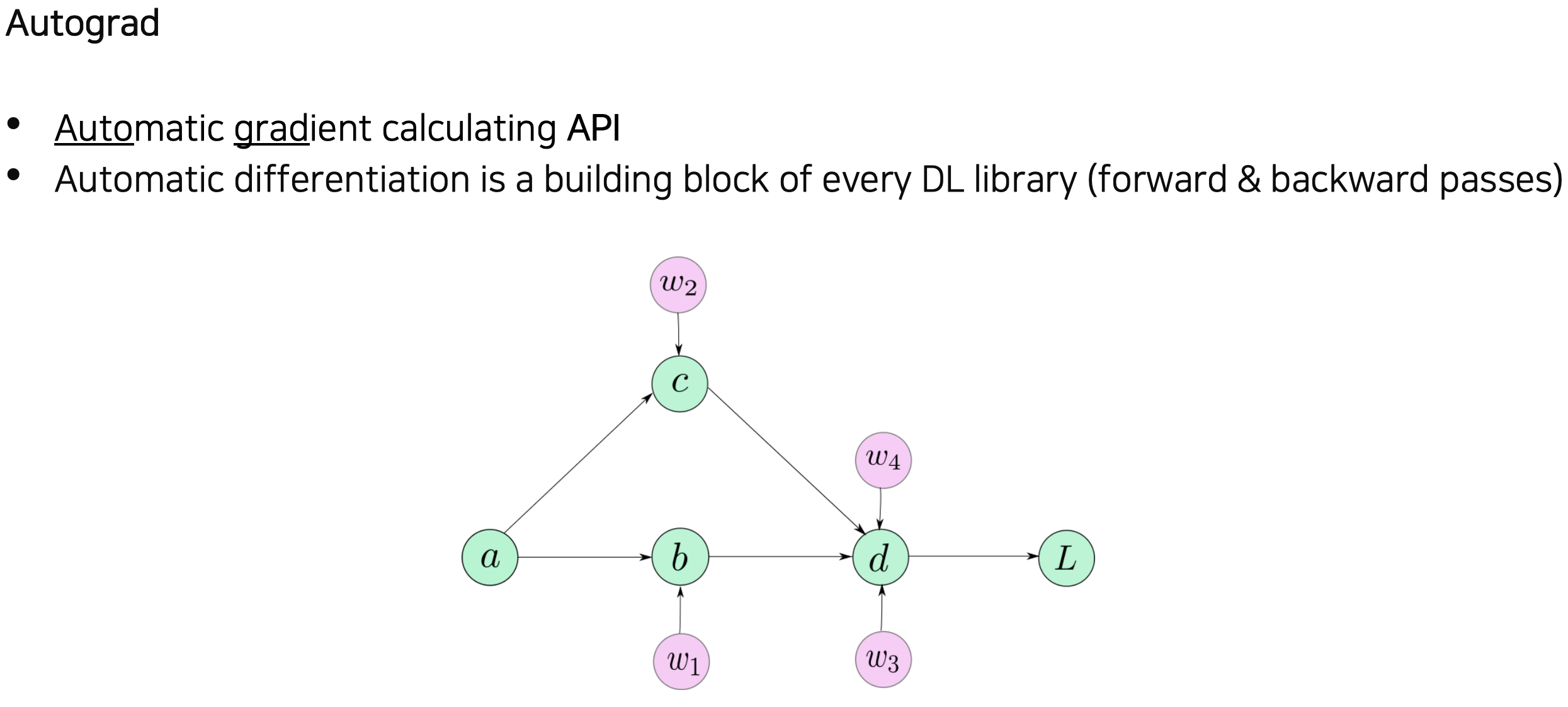

(6강 실습) Introduction to torch.autograd

퀴즈 결과 회고

[퀴즈] CNN visualization (제출용)

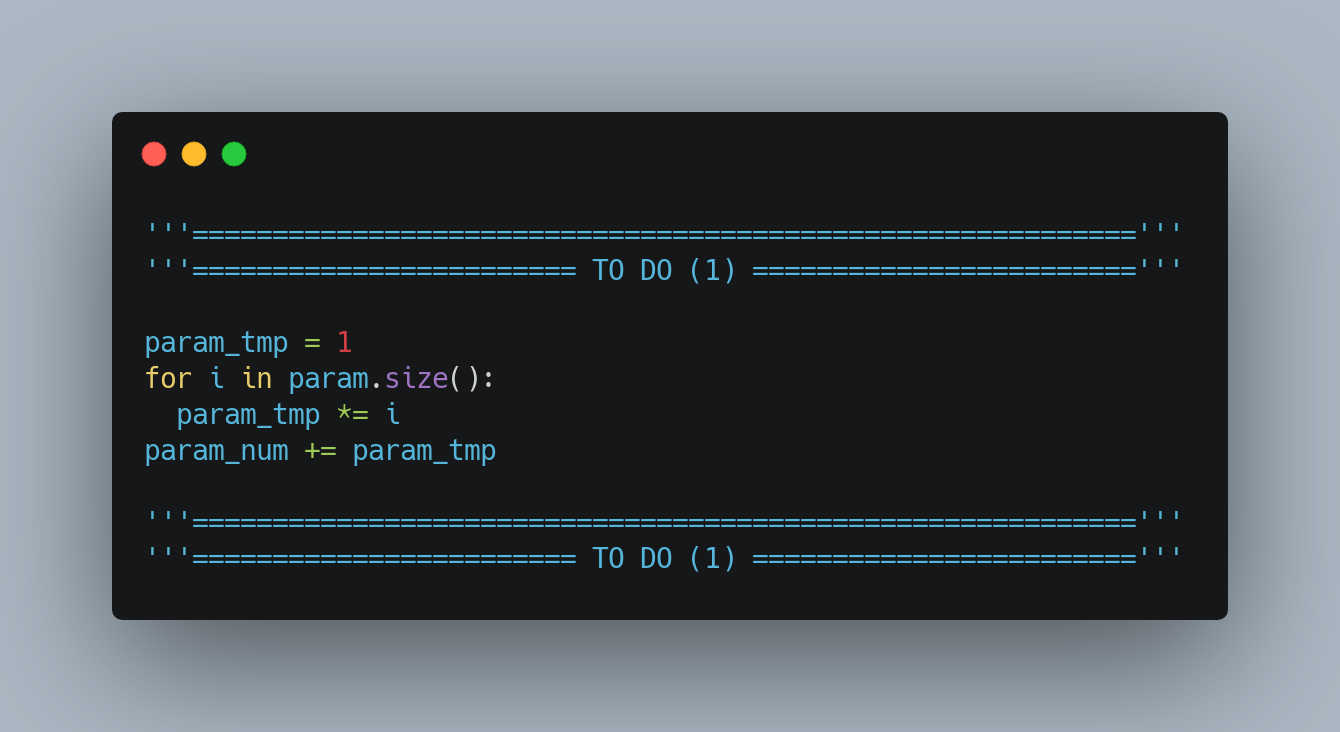

- customedVGG11 모델의 파라미터 전체 갯수는 몇 개 인가요? (가장 비슷한 것을 골라주세요)

- ans : 11000000

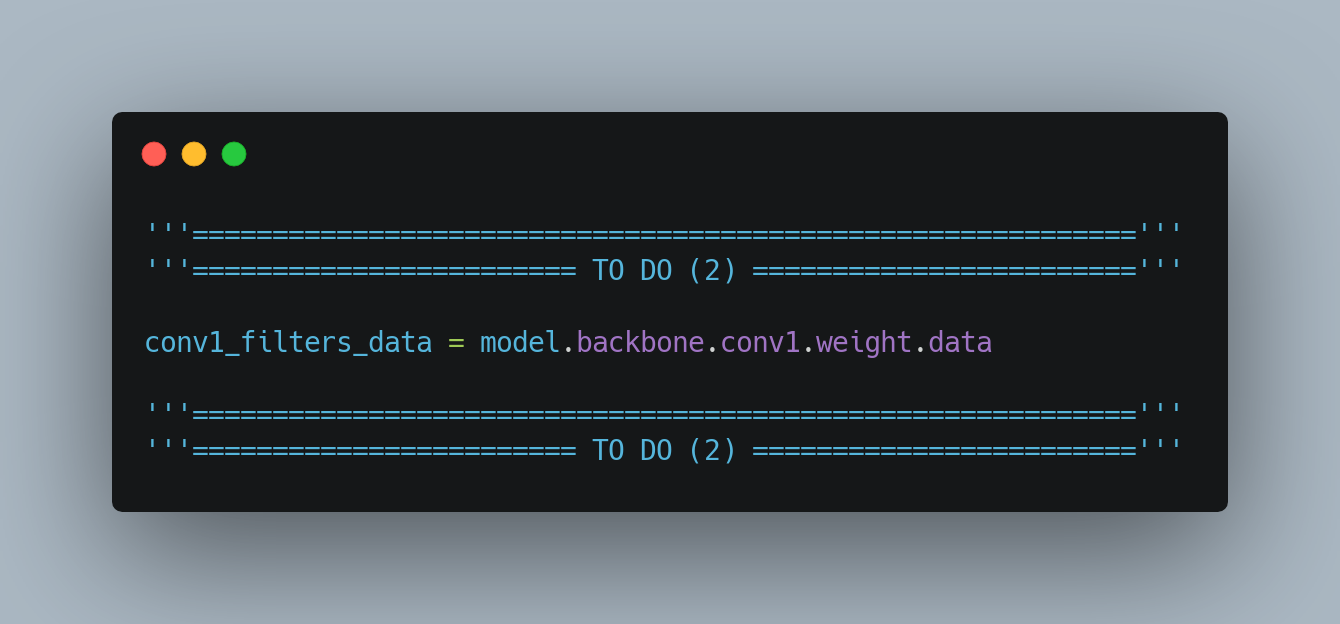

- 문제2-2를 풀고나면, 원하는 input을 넣었을 때, 원하는 타겟 layer에서의 activation map을 확인할 수 있습니다. 마스크를 벗은 데이터(i.e., 0.jpg)를 활용해 first conv. layer의 세번째 커널을 통해 생성되는 activation의 (143, 77) 번째 데이터(i.e., arr[2][142][77])의 소숫점 2째자리까지의 수(i.e., 0.abcd... 에서 ab)는 무엇이었나요?

- ans : 35

- 문제2-3를 풀고나면, blank이미지에 saliency를 그려내게 됩니다. 이 때, 마스크를 쓴 데이터(i.e., 1.jpg)를 input기준으로하여 그려낸 saliency map의 maximum value를 갖는 데이터의 인덱스를 (row, column) 로 두었을 때, row+column의 값은 무엇인가요? (가장 비슷한 답을 선택해주세요)

- ans : 245

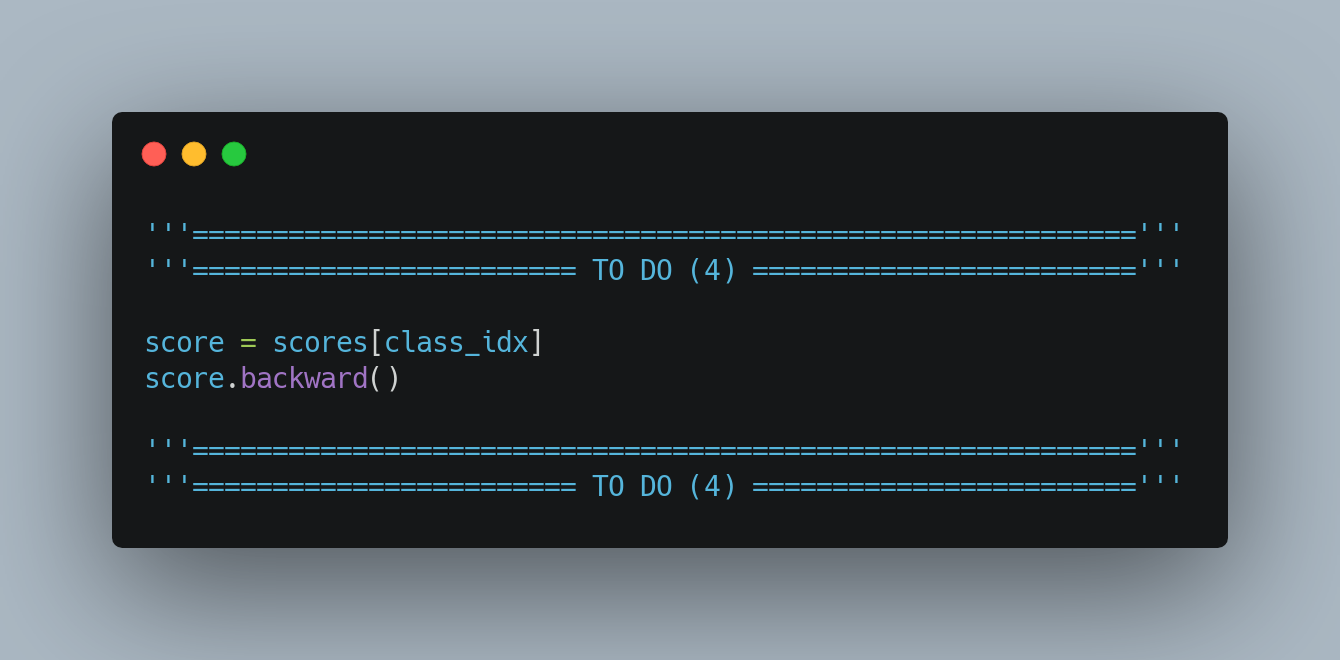

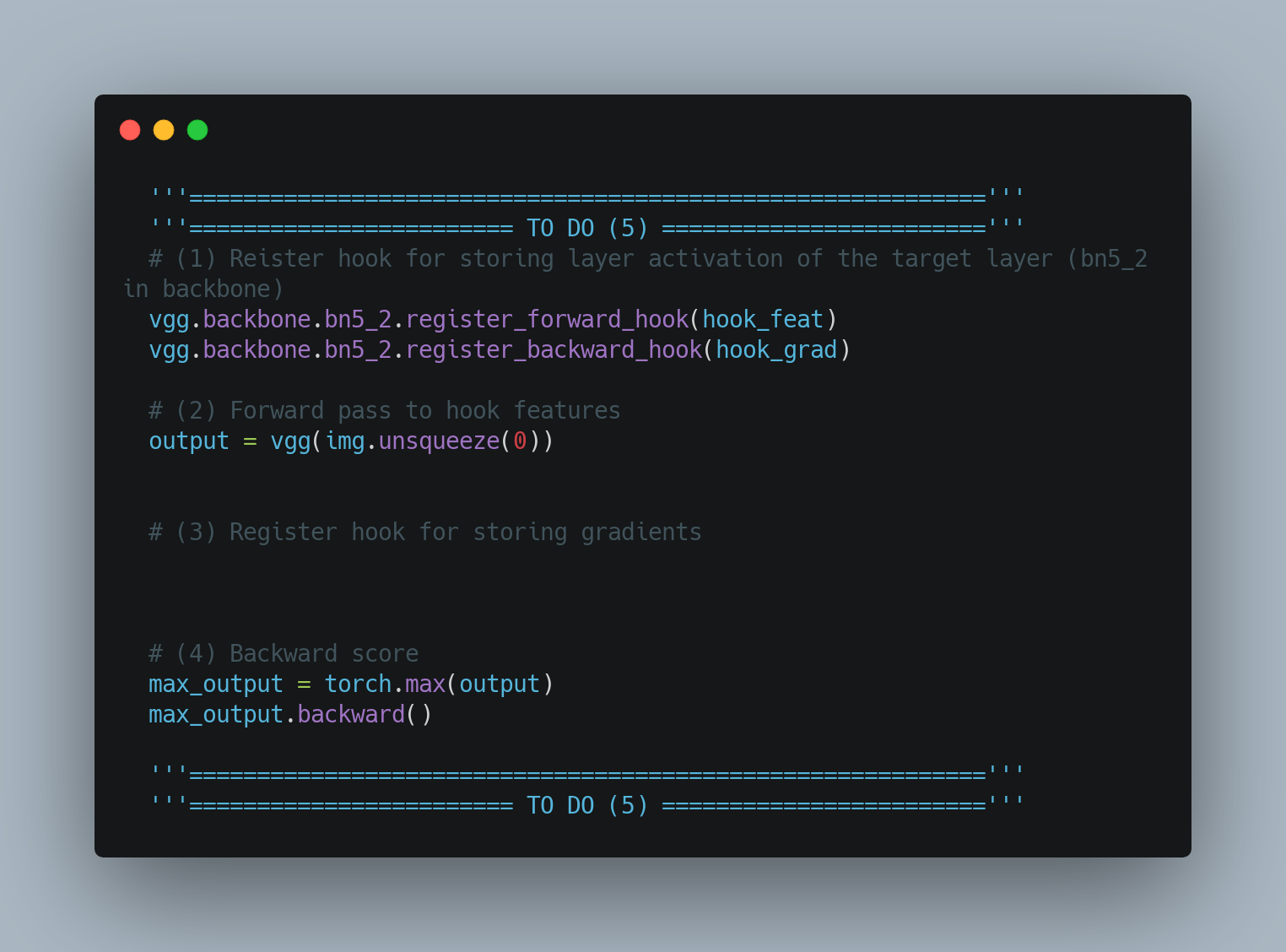

- 문제2-4에서, 모델이 decision을 내릴 때 집중한 부분을 그려내기 위해 gradCAM을 계산합니다. 이 때, 마스크를 쓴 데이터(i.e., 1.jpg)를 input으로하여 계산된 grad-CAM의 maximum value를 갖는 데이터의 인덱스를 (row, column) 로 두었을 때, row+column의 값은 무엇이었나요? (가장 비슷한 답을 선택해주세요)

- ans : 120

Further Question

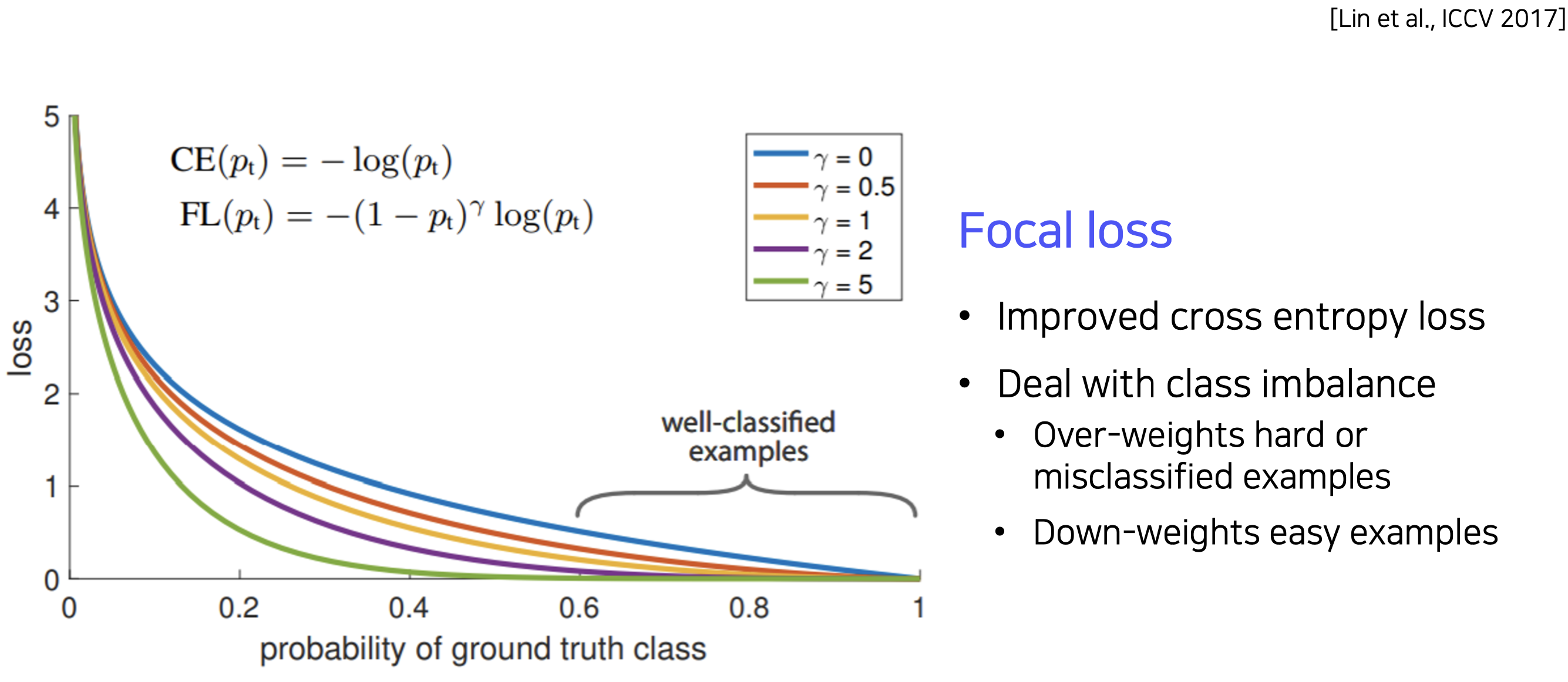

(1) Focal loss는 object detection에만 사용될 수 있을까요?

- class imbalance를 해결하는 개선된 cross entropy loss이기 때문에, 다른 task에서도 cross entropy loss를 대신하여 사용될 수 있을 것 같습니다.

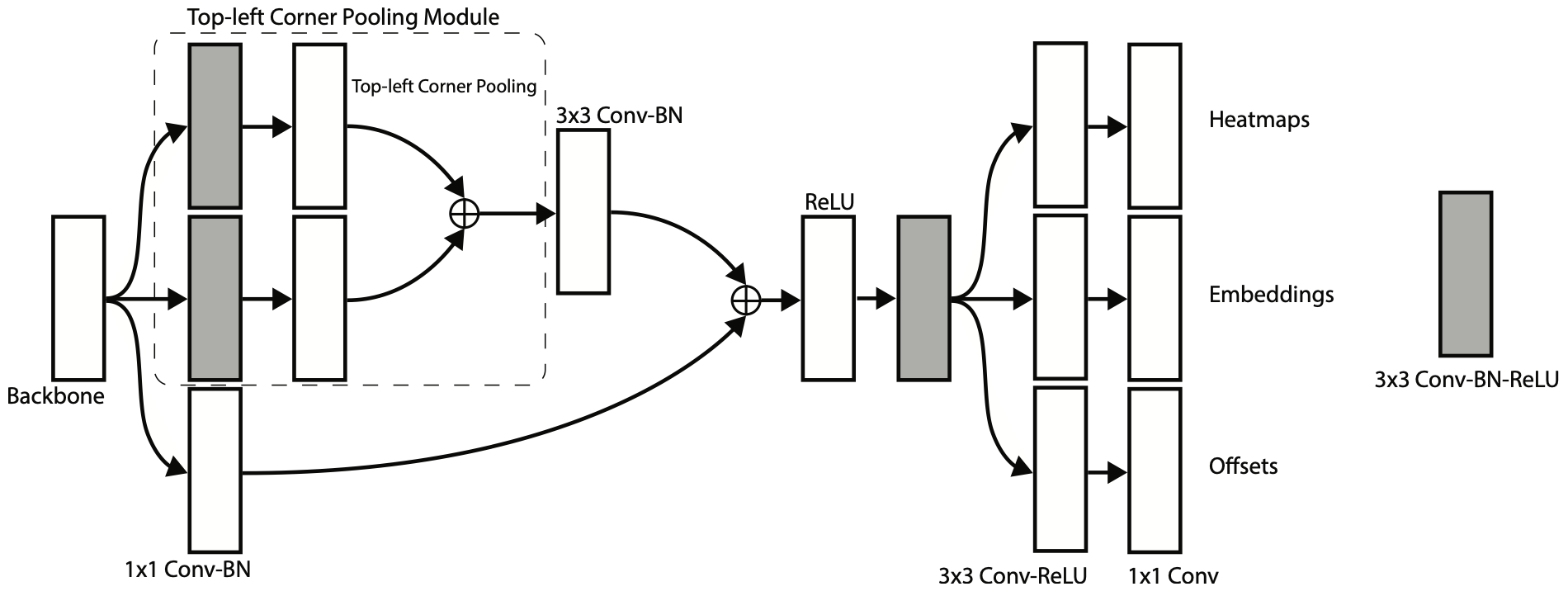

(2) CornerNet/CenterNet은 어떤 형식으로 네트워크가 구성되어 있을까요?

-

CornerNet

-

CenterNet

(1) 왜 filter visualization에서 주로 첫번째 convolutional layer를 목표로할까요?

- 레이어가 깊어질수록 필터 자체의 차원 수가 높기 때문에, 사람이 직관적으로 이해할 수 있는 visualization이 어렵다.

- 따라서 사람이 직관적으로 이해하고 해석할 수 있는 첫번째 convolutional layer를 목표로 한다.

(2) Occlusion map에서 heatmap이 의미하는 바가 무엇인가요?

- Prediction scores are changed according to the location of mask.

(3) Grad-CAM에서 linear combination의 결과를 ReLU layer를 거치는 이유가 무엇인가요?

- 양수 값만을 사용하기 위해 ReLU layer를 거친다.

피어 세션 정리

강의 리뷰 및 Q&A

- (5강) Object detection

- (6강) CNN visualization

- (6강 실습) Introduction to torch.autograd

과제 진행 상황 정리 & 과제 결과물에 대한 정리

[과제] CNN visualization

총평

과제에 오류가 너무 많아서, 안정화된 금요일이 되어서야 마무리할 수 있었습니다.

문제가 불친절하기는 했지만, 덕분에 과제 다운 과제를 하지 않았나 생각합니다.

오늘보다 더 성장한 내일의 저를 기대하며, 내일 뵙도록 하겠습니다.

읽어주셔서 감사합니다!