SOFF.OnStage 지식 나눔 영상입니다!

LLM이란 단어를 들어본 적이 있는가?

정보, 인공지능에 관심이 있는 사람이면 한 번쯤은 들어보았을 LLM은 Large Language Model의 약자이다. 즉, 대량의 데이터를 처리하는 언어모델이다. 최근 Chat GPT의 개발을 통해 더욱 더 많은 관심을 받고 있다. 이러한 LLM 원리는 잘 알고 있는가? 한 번 알아보도록 하자.

-

LLM의 원리

가. 트렌스포머 구조, self-attention

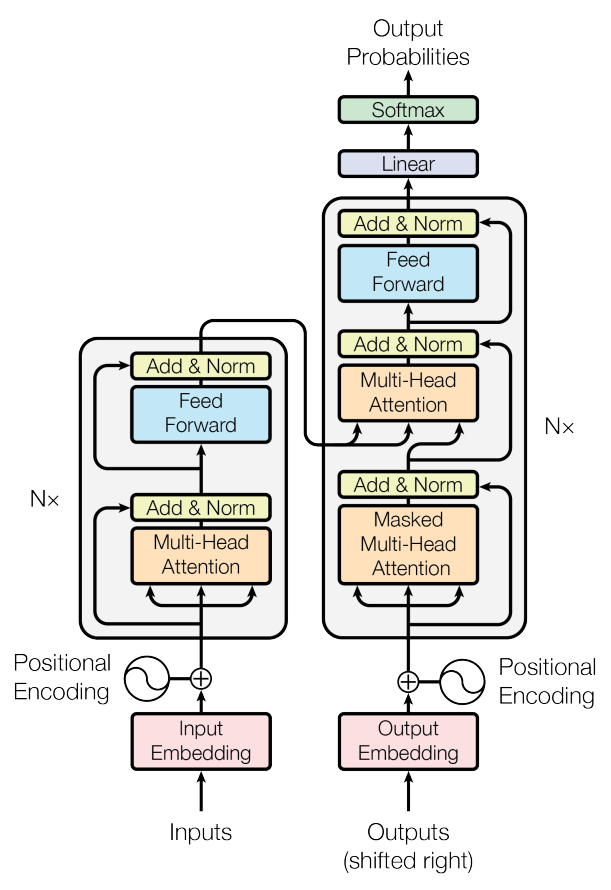

위의 그림은 트랜스포머 구조이다. 질문을 받아드리는 Inputs와 대답을 형성하는 Outputs로 구성되어 있음을 알 수 있다.

위의 그림은 트랜스포머 구조이다. 질문을 받아드리는 Inputs와 대답을 형성하는 Outputs로 구성되어 있음을 알 수 있다.

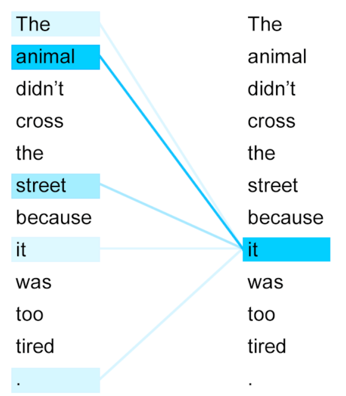

self-attention은 단어간의 유사성을 파악하는 과정을 말한다.

self-attention은 단어간의 유사성을 파악하는 과정을 말한다.나. 벡터 임베딩

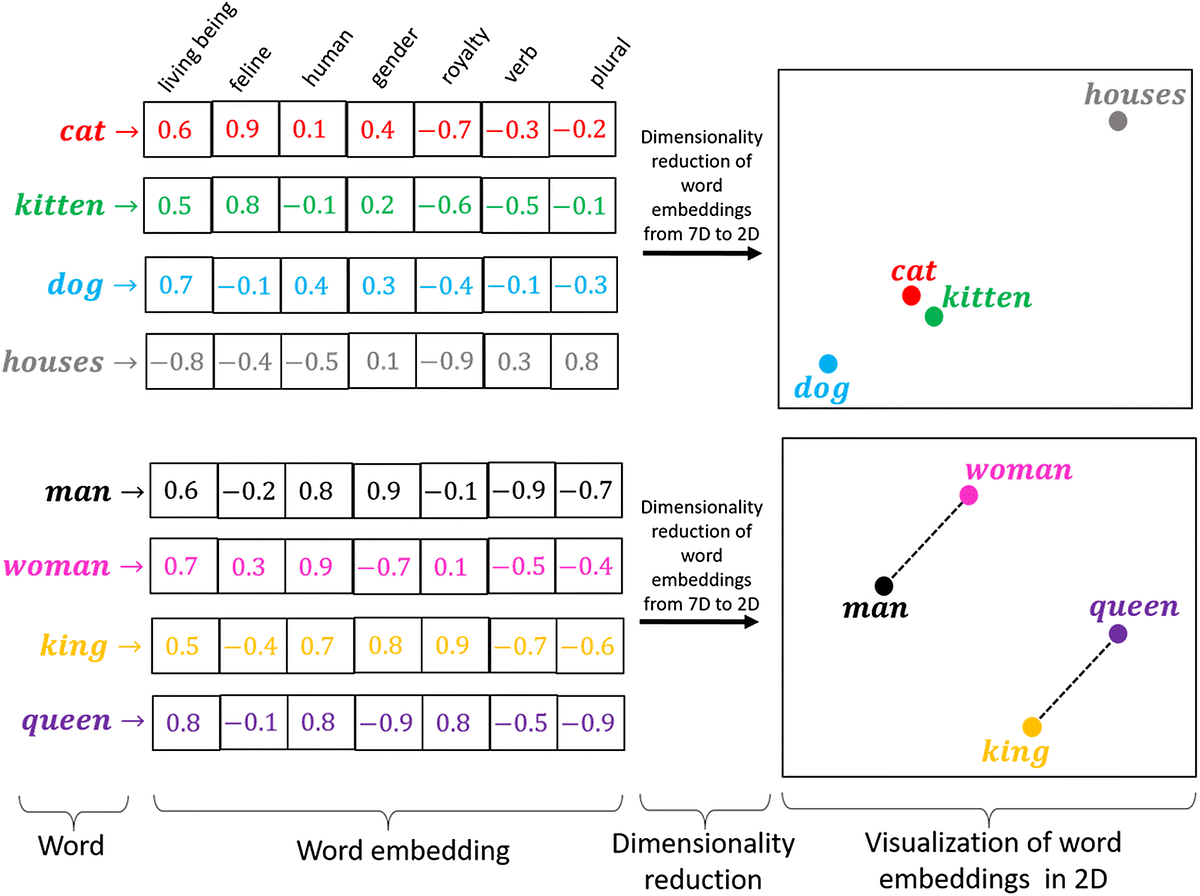

단어를 처리하기 위해서는 이를 숫자로 바꾸어 주어야한다. 또한 이를 바탕으로 학습하기 위해서는 유사한 단어는 유사한 숫자로 변화시켜 묶어주는 작업이 필요하다. 이를 벡터 임베딩이라고 한다. 이를 통해 LLM은 데이터를 학습한다. -

LLM의 미래

LLM은 Chat GPT와 같이 많은 이점이 있을 것이다. 하지만 문제점은 없을까?

먼저 기술적 문제가 존재한다. 많은 양의 메모리로 인한 전기세, 리소스 관리 문제는 미래에 해결해나가야 할 문제이다.

다음으로는 윤리적 문제가 존재한다. 데이터 학습 과정에서 증오 언설에 노출 될 경우 편향된 데이터를 학습할 수 있기에 올바른 데이터만을 제공해야한다.