Chat Vector: A Simple Approach to Equip LLMs with Instruction Following and Model Alignment in New Languages

Merging

https://arxiv.org/pdf/2310.04799

간단 요약

이 논문에서는 Chat Vector라는 개념을 소개하여, 기존의 대형 언어 모델(LLM)에 간단한 모델 연산을 통해 다국어 대화 능력과 인간 가치 정렬 기능을 추가하는 방법을 제안합니다.

핵심 아이디어

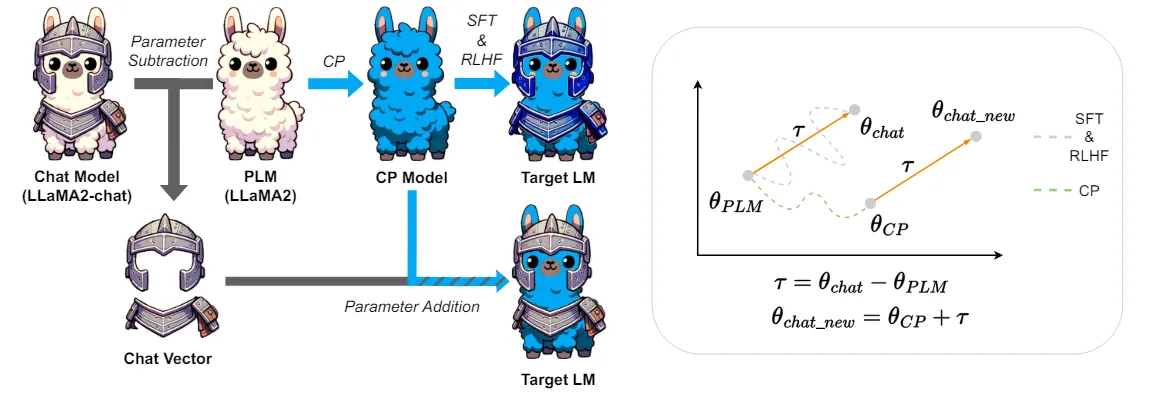

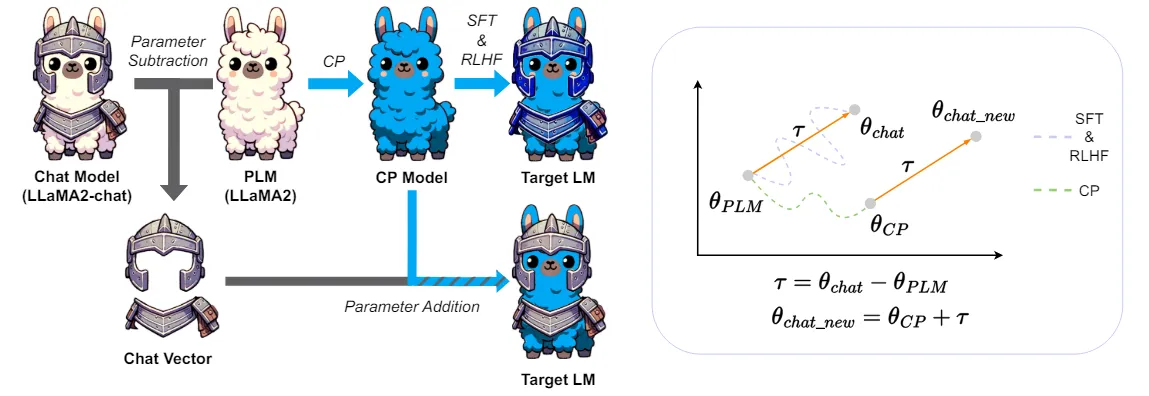

- Chat Vector 생성:

- 기본 언어 모델(예: LLaMA2)과 이를 기반으로 한 대화 모델(LLaMA2-chat)의 가중치를 빼서 새로운 벡터(즉, Chat Vector)를 생성합니다.

- 이 Chat Vector를 기존의 사전 학습된 모델에 추가하면, 추가적인 훈련 없이도 새 언어에서 대화 기능을 사용할 수 있습니다.

- Chat Vector 활용:

- Chat Vector를 사용하여 특정 언어에서 훈련된 모델에 추가하면, 해당 언어에서 지시를 따르고 유해한 콘텐츠를 생성하지 않는 등의 특징을 갖는 대화형 모델이 됩니다.

- 이러한 벡터 연산 방식은 별도의 강화 학습 없이도 RLHF(인간 피드백을 통한 강화 학습)의 효과를 대체할 수 있다는 장점이 있습니다.

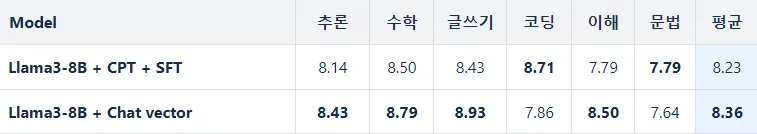

실험 결과

논문은 다음 세 가지 측면에서 Chat Vector의 성능을 실험했습니다.

- 지시 수행 능력:

- Chat Vector를 추가한 모델은 다양한 언어에서 지시를 더 잘 따르며, fine-tuning(세부 조정) 단계를 추가하지 않아도 지시 수행 능력이 향상되는 것으로 나타났습니다.

- 유해성 저감:

- Chat Vector가 추가된 모델은 유해한 콘텐츠 생성 가능성이 줄어들어, 모델의 안전성이 강화되었습니다.

- Perspective API를 통해 모델의 유해성을 측정한 결과, 기본적으로 Chat Vector를 추가한 모델이 더 안전한 응답을 생성하는 것으로 나타났습니다.

- 다중 턴 대화 능력:

- Chat Vector를 추가한 모델은 다중 턴 대화를 기억하고 적절히 응답하는 능력도 향상되었습니다. 실험에서는 “번개 ⚡”라는 기호를 기억하라고 요청한 후 이를 기억하는지 테스트했으며, Chat Vector를 추가한 모델이 이를 기억하고 지속적인 대화를 가능하게 했습니다.

주요 기여

- 다양한 언어 및 모델에 대한 적용 가능성: Chat Vector는 전통적인 한국어 및 중국어 LLaMA와 같은 여러 언어와 모델에서 적용 가능성을 보였습니다.

- 연산 효율성: Chat Vector는 RLHF처럼 복잡한 훈련을 거치지 않고도 대화 능력을 쉽게 추가할 수 있어, 모델 학습 비용을 크게 절감할 수 있습니다.

이 논문은 Chat Vector를 사용하여 다국어 대화 모델을 보다 효율적으로 만드는 방법을 제시하며, 미래에 더욱 광범위한 언어 및 모델에 적용될 수 있는 가능성을 열어둡니다.

이 논문에서 제안하는 Chat Vector 아이디어와 방법론을 자세히 살펴보면 다음과 같습니다.

1. 아이디어 개요

Chat Vector의 핵심 아이디어는 벡터 연산을 통해 기본 언어 모델(LLM)에 대화 능력을 간단하게 추가하는 것입니다. 여기서 중요한 점은 일반적인 대화 능력을 갖춘 LLM(예: LLaMA2-chat)과 그렇지 않은 일반 LLM(예: LLaMA2) 사이의 가중치 차이를 벡터 형태로 추출하여 활용하는 것입니다.

기존의 대화 모델은 보통 RLHF(인간 피드백을 통한 강화 학습)이나 복잡한 파인튜닝 과정을 거쳐서 개발됩니다. 이러한 방식은 시간이 오래 걸리고 비용이 높기 때문에, Chat Vector는 이러한 과정 없이 벡터 연산으로 대화 능력을 추가하여 효율성과 비용 절감을 목표로 합니다.

2. Chat Vector 생성 방법

Step-by-Step 방식

- 기본 모델과 대화 모델 가중치 비교:

- 예를 들어, 기본 언어 모델인 LLaMA2와 그에 맞춰 훈련된 대화형 모델인 LLaMA2-chat의 가중치를 가져옵니다.

- 가중치 차이 추출:

- 두 모델의 가중치 값을 빼서 새로운 벡터, 즉 Chat Vector를 생성합니다.

- 수식으로는 다음과 같이 표현할 수 있습니다.

[

]

- Chat Vector 적용:

- 생성된 Chat Vector를 다른 기본 LLM(예: 다른 언어의 LLaMA2 모델)에 추가하여 대화형 모델로 변환합니다.

- 이는 기본 모델의 가중치에 Chat Vector를 더하는 방식으로, 단순한 벡터 연산만으로 새로운 대화형 모델을 만들어냅니다.

이 과정은 추가 훈련이나 파인튜닝 없이 즉각적으로 대화 능력을 부여하기 때문에 매우 효율적입니다.

3. Chat Vector의 작동 방식

Chat Vector를 활용하면 기본 모델에 여러 가지 유용한 특성을 추가할 수 있습니다. 그 중 대표적인 예시는 다음과 같습니다.

- 지시 수행 능력 강화: Chat Vector를 더한 모델은 인간이 요청한 지시를 더 잘 이해하고 수행할 수 있습니다. 예를 들어 “이 문장의 감정이 긍정적인가 부정적인가?”와 같은 질문에 대해 더 정확한 응답을 제공할 수 있습니다.

- 유해한 콘텐츠 생성 억제: Chat Vector가 추가된 모델은 유해한 언어 생성 확률을 줄이는 경향이 있습니다. 이는 대화 모델에서 일반적으로 요구되는 윤리적 기준을 충족시키는 데 유리합니다.

- 다중 턴 대화 기능: Chat Vector를 추가하면 다중 턴 대화 상황에서도 앞서 나온 맥락을 기억하고 반응하는 능력이 향상됩니다.

4. 실험 및 평가 방법

Chat Vector의 성능을 다양한 방식으로 평가하였습니다.

- 지시 수행 능력: 특정 언어에서 지시 수행 능력을 평가하기 위해 텍스트 분류와 감정 분석 작업을 수행했습니다. Chat Vector를 추가한 모델은 일반적인 LLM보다 지시 수행 능력이 향상되었습니다.

- 유해성 저감: Perspective API 등을 통해 모델이 생성하는 콘텐츠의 유해성을 측정하여 Chat Vector가 유해 콘텐츠를 생성할 가능성을 줄였음을 확인했습니다.

- 다중 턴 대화 기억 능력: 모델이 이전 대화 내용을 기억할 수 있는지 평가하기 위해 다중 턴 대화 실험을 진행했습니다. 특정 단어나 표현을 기억하고 이를 반복적으로 언급할 수 있는지 확인하여, Chat Vector가 추가된 모델이 이 기능을 더 잘 수행함을 발견했습니다.

5. Chat Vector의 장점과 한계

장점

- 비용 절감: Chat Vector는 파인튜닝 없이 기존 LLM을 바로 대화 모델로 사용할 수 있어 모델 학습 비용이 크게 줄어듭니다.

- 유연성: 기존의 다양한 LLM과 언어에서 Chat Vector를 적용하여, 특정 언어 또는 도메인에 맞춘 대화 모델을 쉽게 만들 수 있습니다.

- 확장 가능성: Chat Vector 방식은 기본 LLM의 구조 변경 없이 여러 기능을 부여할 수 있어, 여러 언어와 다양한 애플리케이션에 응용 가능합니다.

한계

- 정교한 제어의 부족: Chat Vector는 간단한 벡터 연산으로 모델을 변환하기 때문에, 일부 복잡한 상호작용이나 사용자 맞춤형 대화 기능에서는 한계가 있을 수 있습니다.

- 기능 확장 제한: 텍스트 생성 외의 이미지 생성 등 멀티모달 기능을 추가하는 데에는 어려움이 있을 수 있습니다.

결론

Chat Vector는 대화 기능을 손쉽게 추가할 수 있는 혁신적인 접근 방식으로, 기존의 복잡한 훈련과정을 벡터 연산으로 대체함으로써, 비용과 시간을 절약할 수 있는 실용적인 방법입니다. 이 방법론은 대형 언어 모델을 더욱 유연하고 확장 가능하게 만들어, 다양한 실용 사례에 적용될 가능성을 열어줍니다.