백엔드 개발자라면 SQL쿼리를 잘 다루는건 기본이라고 생각한다.

프로그래머스에서 SQL문제를 풀때 내가 푸는게 아니라 점점 답안을 찾게되는 상황이 반복되니

기초가 부족한데 무작정 문제를 푸는 것이 큰 도움이 되는 것 같지 않아서

주춤하고 있던 참에 SQLD 자격증이 있다는 걸 알게되었다.

SQL 자격검정 실전문제 책 한권만 풀면 딸 수 있다는 말을 들어서 책을 구매했는데

공부하는 책이 아니라 문제를 푸는 문제집 책이였고, 첫번째 문제부터 어려웠다.

그래서 공부 방법을 더 찾아보니 인터넷에서 개념과 어휘를 정리한 자료가 많으니

일주일정도 공부를 한 다음에 문제를 풀어야한다는 사실을 깨닫았다.

내가 참고한 블로그와 사이트는 SQLD 요약정리 PDF 와 추가정리 PDF, 한국데이터산업진흥원사이트(현재는 서비스가 종료되었다)이다.

프린터기가 없어서 공책에 손으로 따라 쓰다보니 공부가 저절로 되었고,

여러 사람의 정리본들을 찾아보면서 빠진 부분을 추가하며 나만의 개념서를 만들다보니

나중에는 30장이나 되는 많은 분량이 만들어져서 매일 읽기에도 벅찰정도 였지만

시험직전까지도 읽어볼 수 있어서 큰 도움이 되었다.

지금까지는 소규모 프로젝트였기에 erd를 설계할때 기능을 구현하는 것에만 관심을 기울였다면 성능을 높이는 다양한 방법도 알게되어서 다음번엔 배운 것을 토대로 더 많은 고민을 해볼 것 같다.

헷갈리는 부분들을 달달 암기하기 보다는 반복해서 읽어보면서 이해하고 익숙해지는 것이 좋을 것 같아서 정리해보았다.

1과목 1장 데이터 모델링의 이해

데이터 모델의 이해

데이터 모델링이란

- 정보시스템을 구축하기 위한 데이터 관점의 업무 분석 기법

- 현실세계의 데이터(what)에 대해 약속된 표기법에 의해 표현하는 과정

- 데이터베이스를 구축하기 위한 분석/설계의 과정

데이터 모델링의 목적

- 업무정보를 구성하는 기초가 되는 정보들에 대해 일정한 표기법에 의해 표현함으로써 정보시스템 구축의 대상이 되는 업무 내용을 정확하게 분석하는것

- 분석된 모델을 가지고 실제 데이터베이스를 생성하여 개발 및 데이터 관리에 사용하기 위해서

데이터 모델링의 특징

- 추상화 : 현실세계를 일정한 형식에 맞추어 표현하는 추상화의 의미를 가질 수 있음

- 단순화 : 복잡한 현실을 제한된 언어나 표기법을 통해 이해하기 쉽게 하는 단순화의 의미를 가지고 있음

- 명확화 : 애매모호함을 배제하고 누구나 이해가 가능하도록 정확하게 현상을 기술하는 정확화의 의미를 가짐

데이터 모델링을 할 때 유의점

- 중복성 : 데이터 모델은 같은 데이터를 사용하는 사람, 시간, 장소를 파악하는데 도움을 줌으로써 데이터베이스가 여러 장소에 같은 정보를 저장하는 잘못을 하지 않도록 한다.

- 비유연성 : 사소한 업무변화에도 데이터 모델이 수시로 변경되면 유지보수의 어려움을 가중시킬 수 있으므로 데이터와 사용프로세스를 분리함으로써 중대한 변화를 일으킬 수 있는 가능성을 줄인다.

- 비일관성 : 데이터의 중복이 없어도 비일관성은 발생할 수 있다. 예를 들면 신용 상태에 대한 갱신 없이 고객의 납부 이력 정보를 갱신하는 경우이다. 개발자가 서로 연관된 다른 데이터와 모순된다는 고려없이 일련의 데이터를 수정할 수 있기 때문에 이와 같은 문제가 발생할 수 있다. 따라서 데이터 모델링을 할 때 데이터들 간의 상호 연관관계에 대해 명확하게 정의한다면 예방할 수 있다.

데이터 모델링의 3단계 진행

- 개념적 데이터 모델링 : 추상화 수준이 높고 업무중심적이고 포괄적인 수준의 모델링 진행, 전사적 데이터 모델링, EA수립시 많이 이용. 주요한 활동은 핵심 엔티티와 그들 간의 관계를 관계를 발견하고 다이어그램을 생성

- 논리적 데이터 모델링 : 시스템으로 구축하고자 하는 업무에 대해 Key, 속성, 관계 등을 정확하게 표현, 재사용성이 높음. 주요한 활동은 정규화로 논리데이터 모델의 일관성을 확보하고 중복을 제거하여 속성들이 가장 적절한 엔터티에 배치되도록 함으로 신뢰성있는 데이터 구조를 얻는 것이 목적.

- 물리적 데이터 모델링 : 실제로 데이터 베이스에 이식할 수 있도록 성능, 저장 등 물리적인 성격을 고려하여 설계

ANSI/SPARC의 3단계 구성의 데이터 독립성 요소

- 외부스키마 : 개인 사용자가 보는 개인적 DB 스키마로 사용자 관점에 따른 스키마 구성

- 개념스키마 : 모든 사용자 관점을 통합한 전체 DB으로 통합 관점에 따른 스키마 구성

- 내부스키마 : 개발자 관점에서 물리적 장치에서 데이터가 실제적으로 저장되는 방법을 표현한 스키마

엔터티

ERD 작업순서

1. 엔터티를 그린다

2. 엔터티를 적절하게 배치한다(중요한건 좌측상단)

3. 엔터티간 관계 설정 (선으로 연결)

4. 관계명 기술 (주문-제품 간에는 '주문하는 제품')

5. 관계의 참여도를 기술 (1:1, 1:n, n:m 표시)

6. 관계의 필수 여부를 기술 (값이 0개일 수 있으면 원을 표시)

엔터티의 특징

- 반드시 해당 업무에서 필요하고 관리하고자 하는 정보이어야 한다.

- 유일한 식별자에 의해 식별이 가능해야 한다.

- 영속적으로 존재하는 인스턴스의 집합이어야 한다(2개이상이어야한다)

- 엔터티는 업무 프로세스에 의해 이용되어야 한다.

- 엔터티는 반드시 속성이 있어야 한다.(2개 이상의 속성을 갖는다)

- 엔터티는 다른 엔터티와 최소 한 개 이상의 관계가 있어야 한다.

엔터티의 분류

유무형에 따른 분류 : 유형, 개념, 사건 엔터티

- 유형 물리적 형태 : 물리적인 형태가 있고 안정적이며 지속적으로 활용되는 엔터티 (사원, 물품)

- 개념 개념적 정보 : 물리적인 형태는 없고 관리해야 할 개념적 정보로 구분이 되는 엔터티 (조직, 보험상품)

발생시점에 따른 분류 : 기본/키, 중심, 행위 엔터티

- 기본/키 엔터티 : 업무에 원래 존재하는 정보로 독립적 생성가능, 타 엔터티의 부모 역할을 하며, 자신의 고유한 주식별자 가짐 (사원, 상품)

- 중심/메인 엔터티 : 기본엔터티로부터 발생되고 그 업무에 있어서 중심적인 역할을 한다. 데이터의 양이 많이 발생되고 다른 엔터티와의 관계를 통해 많은 행위엔터티를 생성한다. (계약, 주문)

- 행위 엔터티 : 두 개 이상의 부모엔터티로부터 발생되고 자주 내용이 바뀌거나 데이터량이 증가된다. (주문목록, 사원변경이력)

속성

속성의 분류

- 기본 속성 : 업무로부터 추출된 일반적인 속성으로 엔터티를 대표하고 구별하는 데 사용되는 속성들이 여기에 속한다

예를 들어, "고객" 엔터티의 경우 이름, 주소, 전화번호 등이 기본 속성에 해당한다. - 설계 속성 : 데이터 모델링을 위해 설계 시에 만들거나 변형된 속성으로

주로 업무 규칙 또는 필요에 따라 새로운 속성을 생성하거나 변형하여 정의된다.

예를 들어, 예금분류처럼 우리가 업무상 데이터 외에 데이터 모델링에 필요한 속성의 추가가 요구될 때 하는 속성이다. - 파생 속성 :

다른 속성의 계산에 의해 생성되는 속성으로 주로 다른 속성의 연산 결과나 조합에 의해 만들어진다.

데이터 정합성을 유지하기 위해 주의가 필요하며, 성능을 향상시키기 위해 미리 계산된 값을 저장할 수도 있다.

예를 들어, 주문 엔터티의 '총 주문 금액'은 '가격X수량'과 같은 계산으로 파생될 수 있다.

속성과 관계

- 한 개의 속성은 반드시 한 개의 속성값만을 가집니다.

- 한 개의 엔터티는 최소 2개 이상의 속성을 가집니다.

- 한 개의 엔터티는 최소 1개 이상의 다른 엔터티와의 관계를 가집니다.

- 한 개의 엔터티는 최소 2개 이상의 인스턴스 집합이어야 한다.

도메인이란

각 속성은 가질 수 있는 값의 범위가 있는데 이를 그 속성의 도메인이라하며, 엔터티 내에서 속성에 대한 데이터 타입과 크기, 제약사항을 지정하는 것 이다.

속성의 명칭

- 해당업무에서 사용하는 이름을 부여한다.

- 서술식 속성명은 사용하지 않는다.(명사사용)

- 약어 사용은 가급적 제한한다.

- 전체 데이터 모델에서 유일성을 확보하는 것이 좋다.

관계

존재에 의한 관계(부서-사원) 행위에 의한 관계(고객-주문) 모두 단일화된 표기.

UML : Unified Modeling Language 에서는 연관관계(실선) / 의존관계(점선)을 다르게 표기.

관계를 고려해야 할 사항

1) 두 개의 엔터티 사이에 관심있는 연관규칙이 있는가?

2) 두 개의 엔터티 사이에 정보의 조합이 발생되나?

3) 업무기술서, 장표에 관계연결을 가능하게 하는 동사가 있는가? -> 명사아님주의

4) 업무기술서, 장표에 관계연결에 대한 규칙이 서술되어있는가?

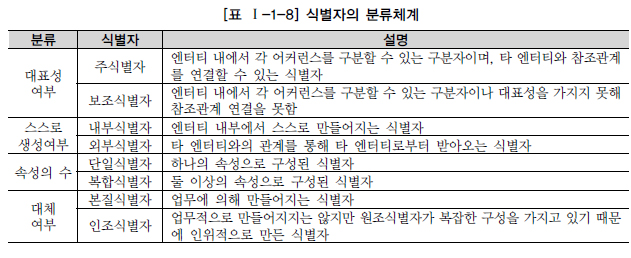

식별자

식별자 분류

주식별자 특징

유일성 : 주식별자에 의해 엔터티내에 모든 인스턴스들을 유일하게 구분할 수 있다.

최소성 : 주식별자를 구성하는 속성의 수는 유일성을 만족하는 최소의 수가 되어야 함.

불변성 : 주식별자가 한 번 특정 엔터티에 지정되면 그 식별자의 값은 변하지 않아야 함.

존재성 : 주식별자가 지정되면 반드시 데이터 값이 존재해야한다. Null은 허용되지 않는다.

주식별자를 도출하는 기준

- 해당 업무에서 자주 이용되는 속성을 주식별자로 지정한다.

- 명칭, 내역 등과 같이 이름으로 기술되는 것들은 가능하면 주식별자로 지정하지 않는다.

- 복합으로 주식별자로 구성할 경우 너무 많은 속성이 포함되지 않도록 한다.

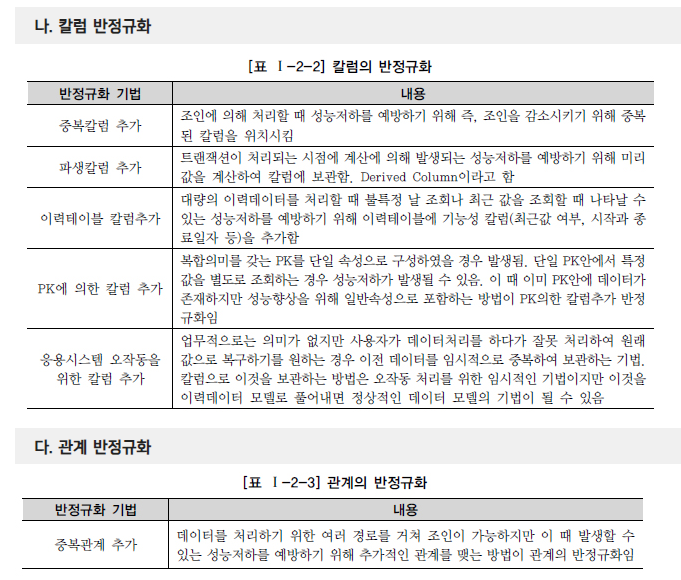

1과목 2장 데이터 모델과 성능

성능 데이터 모델링이란

분석 및 설계 단계에서부터 DB 성능향상을 목적으로 데이터모델링을 수행하는 것이다. 정규화, 반정규화, 테이블 분할/병합/추가, 칼럼 추가 , PK/FK 조정, 슈퍼타입/서브타입 조정들의 기능을 한다.

분석/설계 단계에서 데이터 모델에 성능을 고려한 데이터 모델링을 수행할 경우 성능저하에 따른 재업무 비용을 최소화 할 수 있으며 데이터의 증가가 빠를수록 성능저하에 따른 성능개선비용은 기하급수적으로 증가하게 된다.

성능 데이터 모델링 순서

정규화 -> 용량산정 -> 트랜잭션 -> 반정규화 -> 기타 조정

① 데이터 모델링을 할 때 정규화를 정확하게 수행한다.

② 데이터베이스 용량산정을 수행한다.

③ 데이터베이스에 발생되는 트랜잭션의 유형을 파악한다.

④ 용량과 트랜잭션의 유형에 따라 반정규화를 수행한다.

⑤ 이력모델의 조정, PK/FK조정, 슈퍼타입/서브타입 조정 등을 수행한다.

⑥ 성능관점에서 데이터 모델을 검증한다.

정규화

1차 정규화 : 1차 정규화는 모든 속성은 반드시 하나의 값만 가져야한다는 특징을 갖고 있습니다. 쉽게 말해서 '중복되는 속성을 제거하는 작업이다.

| 소속사 | 이름 | SNS |

|---|---|---|

| 엔터테이먼즈 | 아이유 | 인스타, 페이스북, 유튜브 |

| 소속사 | 이름 | SNS | SNS | SNS |

|---|---|---|---|---|

| 엔터테이먼즈 | 아이유 | 인스타 | 페이스북 | 유튜브 |

SNS 에 다중 값을 가지거나 반복되는 SNS그룹이 있는 경우 제 1 정규형을 위배했다고 볼 수 있다. 중복/반복되는 속성을 분류해주는게 1차 정규화라고 할 수 있다.

SNS 각각에 대하여 개별로 index를 생성할 경우 입력, 수정, 삭제 때 성능이 저하되므로 제1차 정규화를 수행한 후 인덱스를 적용하는 것이 좋다.

2차 정규화 : 2차 정규화는 모든 속성은 기본키에 종속되어야 하며, 일부만 종속되는 것도 안된다. 라는 특징을 가지고 있으며 '함수 종속성(FD)'키워드를 가지고 있다.

문제에서는 주로 PK가 2개이며 입력이상이나 수정이상을 일으키는 경우라서 테이블을 2개로 나누어 해결해야 하는 상황이 주어진다.

3차 정규화 : 기본키가 아닌 다른 속성들끼리 종속되어선 안된다. 라는 특징이다. (이행 종속 불가)

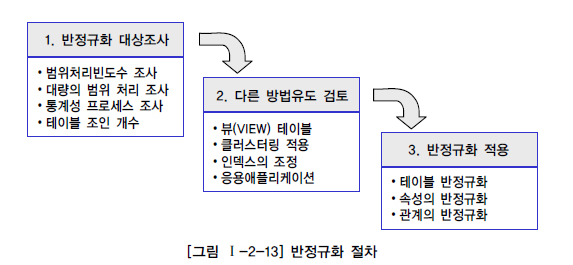

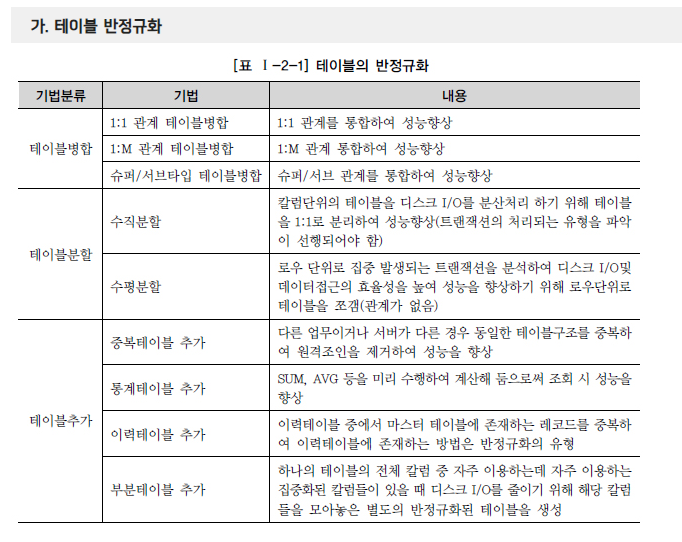

반정규화

반정규화를 적용할 때는 기본적으로 데이터 무결성이 깨질 가능성이 많이 있기 때문에 반드시 데이터 무결성을 보장할 수 있는 방법을 고려한 이후에 반정규화를 적용하도록 해야 한다.

데이터를 입력, 수정, 삭제할 때는 성능이 떨어지는 점을 기억해야 하고 데이터의 무결성 유지에 주의를 해야 한다.

- 반정규화 대상 조사

- 자주 사용되는 테이블에 접근(Access)하는 프로세스의 수가 많고 항상 일정한 범위만을 조회하는 경우에 반정규화를 검토한다.

- 테이블에 대량의 데이터가 있고 대량의 데이터 범위를 자주 처리하는 경우에 처리범위를 일정하게 줄이지 않으면 성능을 보장할 수 없을 경우에 반정규화를 검토한다.

- 통계성 프로세스에 의해 통계 정보를 필요로 할 때 별도의 통계테이블(반정규화 테이블)을 생성한다.

- 테이블에 지나치게 많은 조인(JOIN)이 걸려 데이터를 조회하는 작업이 기술적으로 어려울 경우 반정규화를 검토한다.

- 다른 방법유도 검토

- 지나치게 많은 조인(JOIN)이 걸려 데이터를 조회하는 작업이 기술적으로 어려울 경우 뷰(VIEW)를 사용하면 이를 해결할 수도 있다. 뷰가 조회의 성능을 향상시키는 역할을 수행하지는 않는다. 다만 개발자별로 SQL문장을 만드는 방법에 따라 성능저하가 나타날 수 있으므로 성능을 고려한 뷰를 생성하여 개발자가 뷰를 통해 접근하게 함으로써 성능저하의 위험을 예방하는 것도 좋은 방법이 된다.

- 대량의 데이터처리나 부분처리에 의해 성능이 저하되는 경우에 클러스터링을 적용하거나 인덱스를 조정함으로써 성능을 향상시킬 수 있다. 클러스터링을 적용하는 방법은 대량의 데이터를 특정 클러스터링 팩트에 의해 저장방식을 다르게 하는 방법이다. 이 방법의 경우 데이터를 입력/수정/삭제하는 경우 성능이 많이 저하되므로 조회중심의 테이블이 아니라면 생성하면 안되는 오브젝트이다. 다만, 조회가 대부분이고 인덱스를 통해 성능향상이 불가능하다면 클러스터링을 고려할 만하다. 또한 인덱스를 통해 성능을 충분히 확보할 수 있다면 인덱스를 조정하여 반정규화를 회피하도록 한다.

- 대량의 데이터는 Primary Key의 성격에 따라 부분적인 테이블로 분리할 수 있다. 즉 파티셔닝 기법(Partitioning)이 적용되어 성능저하를 방지할 수 있다. 인위적인 테이블을 통합/분리하지 않고 물리적인 저장기법에 따라 성능을 향상시킬 수 있는 파티셔닝을 고려해 볼 수 있다. 이 경우는 데이터가 특정 기준(파티셔닝 키)에 의해 다르게 저장되고 파티셔닝 키에 따른 조회가 될 때 성능이 좋아지는 특성이 있다. 따라서 특정 기준에 의해 물리적인 저장공간이 구분될 수 있고 트랜잭션이 들어올 때 일정한 기준에 의해 들어온다면 파티셔닝 테이블을 적용하여 조회의 성능을 향상시키는 것도 좋은 방법이 될 수 있다.

- 응용 애플리케이션에서 로직을 구사하는 방법을 변경함으로써 성능을 향상시킬 수 있다. 응용 메모리 영역에 데이터를 처리하기 위한 값을 캐쉬한다든지 중간 클래스 영역에 데이터를 캐쉬하여 공유하게 하여 성능을 향상 시키는 것도 성능을 향상시키는 방법이 될 수 있다.

- 반정규화 적용

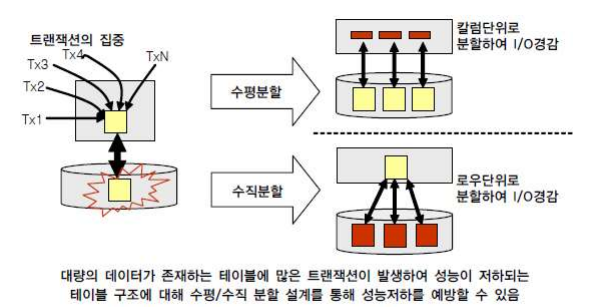

대량 데이터에 따른 성능

테이블에 대한 수평분할/수직분할에 대한 결정은 다음의 4 가지 원칙을 적용하면 된다.

1) 데이터 모델링을 완성한다.

2) 데이터베이스 용량산정을 한다.

3) 대량 데이터가 처리되는 테이블에 대해서 트랜잭션 처리 패턴을 분석한다.

4) 칼럼 단위로 집중화된 처리가 발생하는지, 로우단위로 집중화된 처리가 발생되는지 분석하여 집

중화된 단위로 테이블을 분리하는 것을 검토한다.

로우체이닝(Row Chaining) 현상 :

로우 길이가 너무 길어서 데이터 블록 하나에 데이터가 모두 저장되지 않고

두 개 이상의 블록에 걸쳐 하나의 로우가 저장되어 있는 형태

로우마이그레이션(Row Migration) :

데이터 블록에서 수정이 발생하면 수정된 데이터를 해당 데이터 블록에서

저장하지 못하고 다른 블록의 빈 공간을 찾아 저장하는 방식이다.

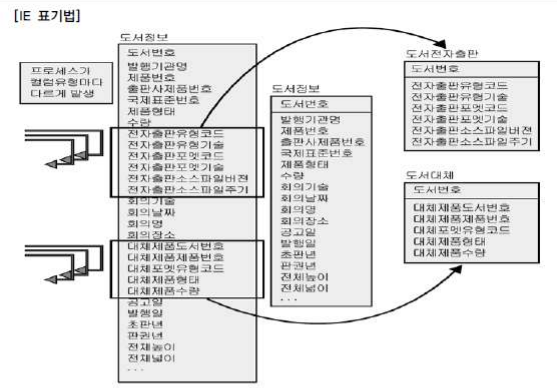

도서정보 테이블에는 전자출판유형에 대한 트랜잭션이 독립적으로 발생이 되는 경우가 많고 대체제품에 대한 유형의 트랜잭션이 독립적으로 발생되는 경우가 많이 있어 1:1 관계로 분리하였다. 분리된 테이블은 디스크에 적어진 칼럼이 저장이 되므로 로우마이그레이션과 로우체이닝이 많이 줄어들 수 있다. 따라서 아래와 같이 발행기관명, 수량, 중간에 위치한 공고일, 발행일을 가져오는 동일한 SQL 구문에 대해서도 디스크 I/O 가 줄어들어 성능이 개선되게 된다.

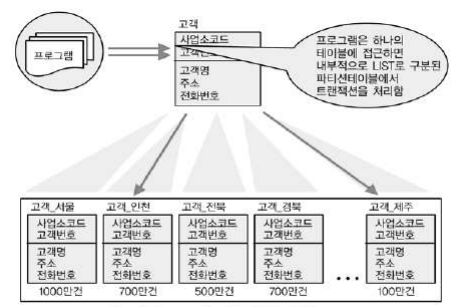

파티셔닝

테이블에 많은 양의 데이터가 예상될 경우 파티셔닝을 적용하거나 PK 에 의해 테이블을 분할하는

방법을 적용할 수 있다.

1.RANGE PARTITION

요금테이블에 PK 가 요금일자+요금번호로 구성되어 있고 데이터건수가 1 억 2 천만 건인 대용

량 테이블의 경우이다. 하나의 테이블로는 너무 많은 데이터가 존재하므로 인해 성능이 느린 경우

에 해당된다. 이 때 요금의 특성상 항상 월단위로 데이터 처리를 하는 경우가 많으므로 PK 인 요

금일자의 년+월을 이용하여 12 개의 파티션 테이블을 만들었다.

2.LIST PARTITION

LIST PARTITION 은 대용량 데이터를 특정값에 따라 분리 저장할 수는 있으나 RANGE

PARTITION 과 같이 데이터 보관주기에 따라 쉽게 삭제하는 기능은 제공될 수 없다.

3.HASH PARTITION

지정된 HASH 조건에 따라 해슁 알고리즘이 적용되어 테이블이 분리되며

설계자는 테이블에 데이터가 정확하게 어떻게 들어갔는지 알 수 없다. 역시 성능향상을 위해 사용하

며 데이터 보관주기에 따라 쉽게 삭제하는 기능은 제공될 수 없다.

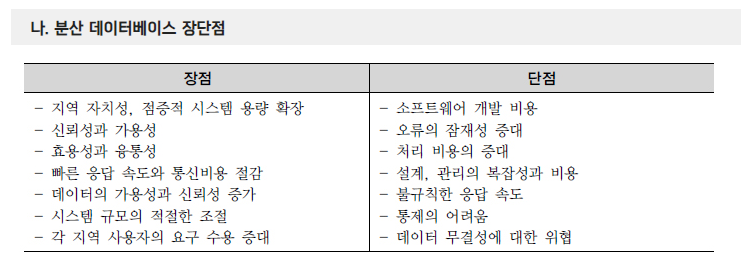

분산 데이터베이스

여러 곳으로 분산되어있는 데이터베이스를 하나의 가상 시스템으로 사용할 수 있도록 한 데이터베이스

논리적으로 동일한 시스템에 속하지만, 컴퓨터 네트워크를 통해 물리적으로 분산되어 있는 데이터들의 모임.

분산데이터베이스가 되기 위해서는 6가지 투명성(Transparency)을 만족해야 한다.

- 1) 분할 투명성 (단편화) : 하나의 논리적 Relation이 여러 단편으로 분할되어 각 단편의 사본이 여러 site에 저장

- 2) 위치 투명성 : 사용하려는 데이터의 저장 장소 명시 불필요. 위치정보가 System Catalog에 유지되어야 함

- 3) 지역사상 투명성 : 지역DBMS와 물리적 DB사이의 Mapping 보장. 각 지역시스템 이름과 무관한 이름 사용 가능

- 4) 중복 투명성 : DB 객체가 여러 site에 중복 되어 있는지 알 필요가 없는 성질

- 5) 장애 투명성 : 구성요소(DBMS, Computer)의 장애에 무관한 Transaction의 원자성 유지

- 6) 병행 투명성 : 다수 Transaction 동시 수행시 결과의 일관성 유지, Time Stamp, 분산 2단계 Locking을 이용 구현