regularization

l1, l2를 이용

Dropout

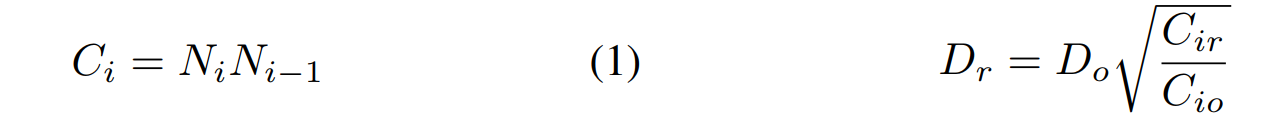

ci가 layer의 connections의 수

cio는 original network

cir는 retraining network

Do는 original network의 dropout ratio

Dr = dropout rate during retraining

아키텍처별 pruning

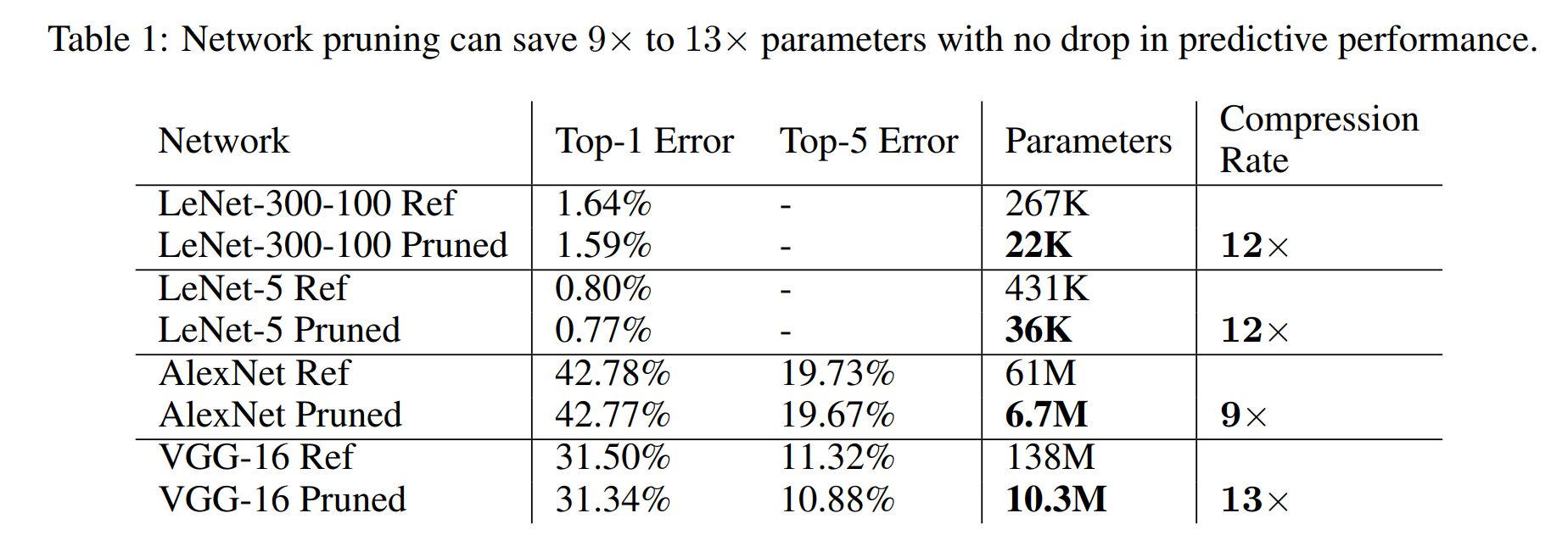

Learning both Weights and Connections for Efficient

Neural Networks이란 논문에서 발췌한 pruning 성능표다.

pruning neurons

connections이 없는 neuron들과 output이 없는 neuron들이 나오는데 이것을 pruning 하는 것

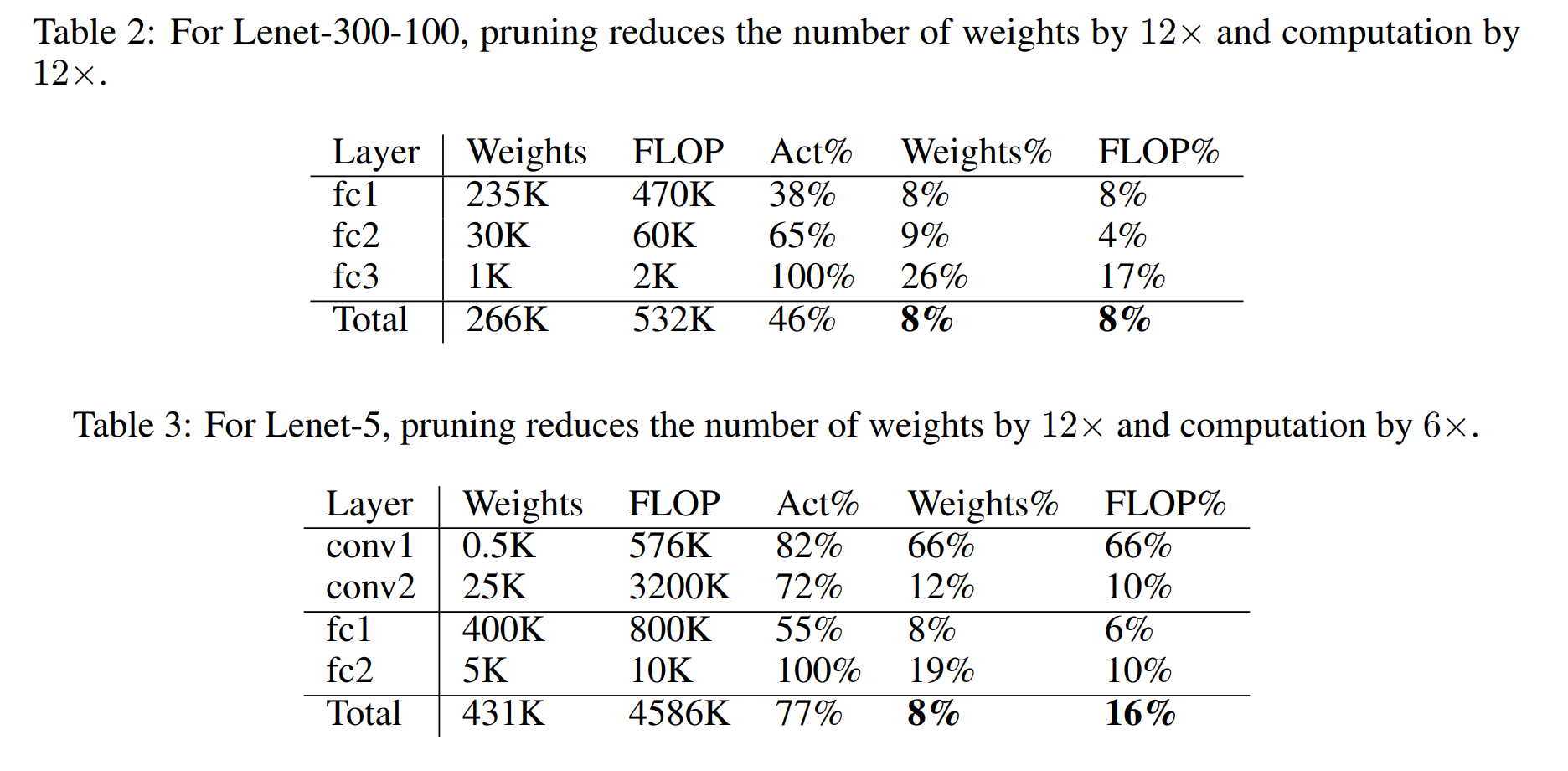

모델별로 연산량, weigtht의 수를 12배 줄였다고 한다.

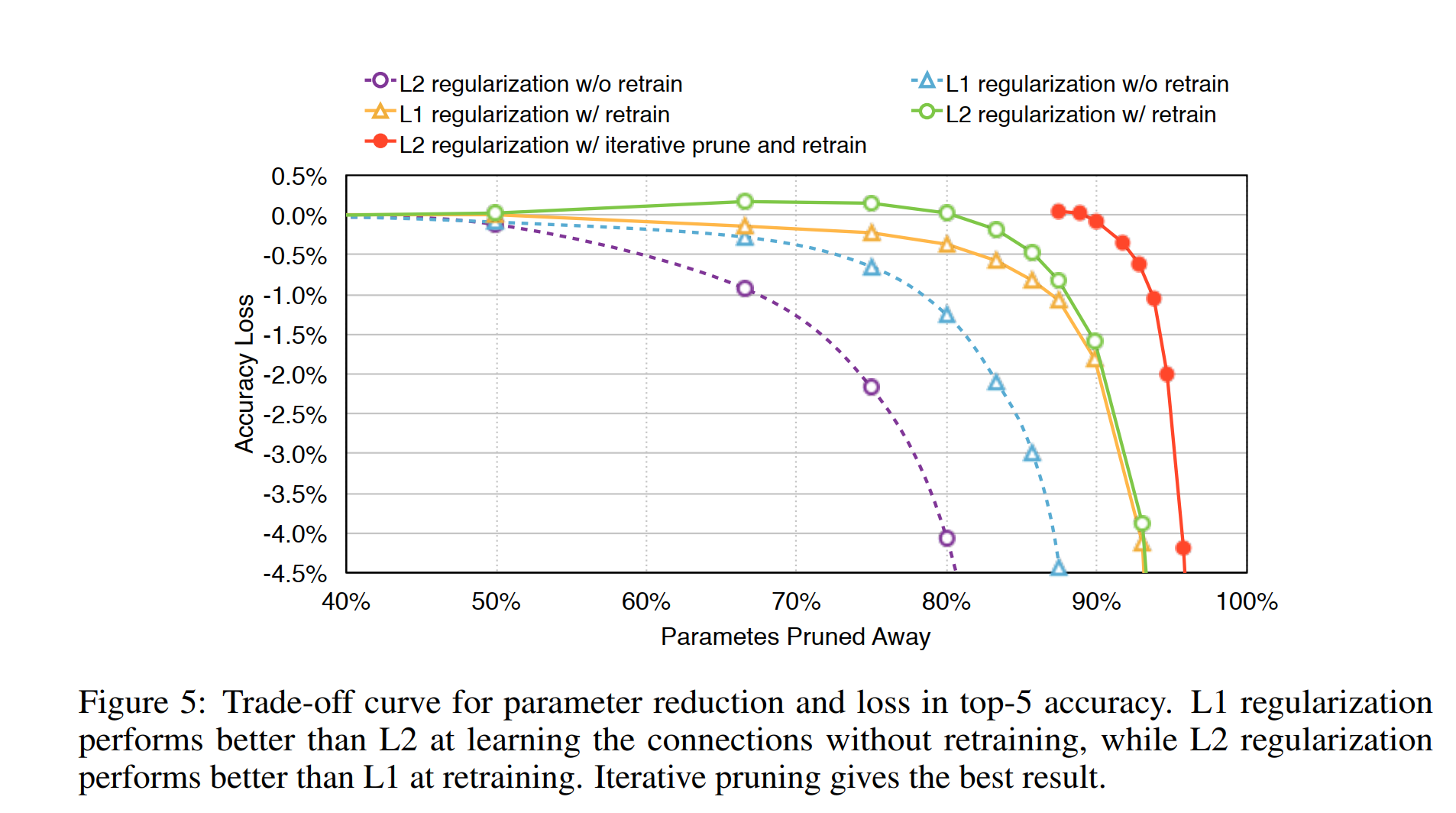

retrainng

pruning하고 retraining 꼭 해줘야 함

pruned and retrained network 이런식으로 반복

weight과 neurons를 얼마만큼의 비율로 줄이는 걸 정하는 게 중요함

특정 배율에서 아주 큰 기울기의 성능저하가 발생

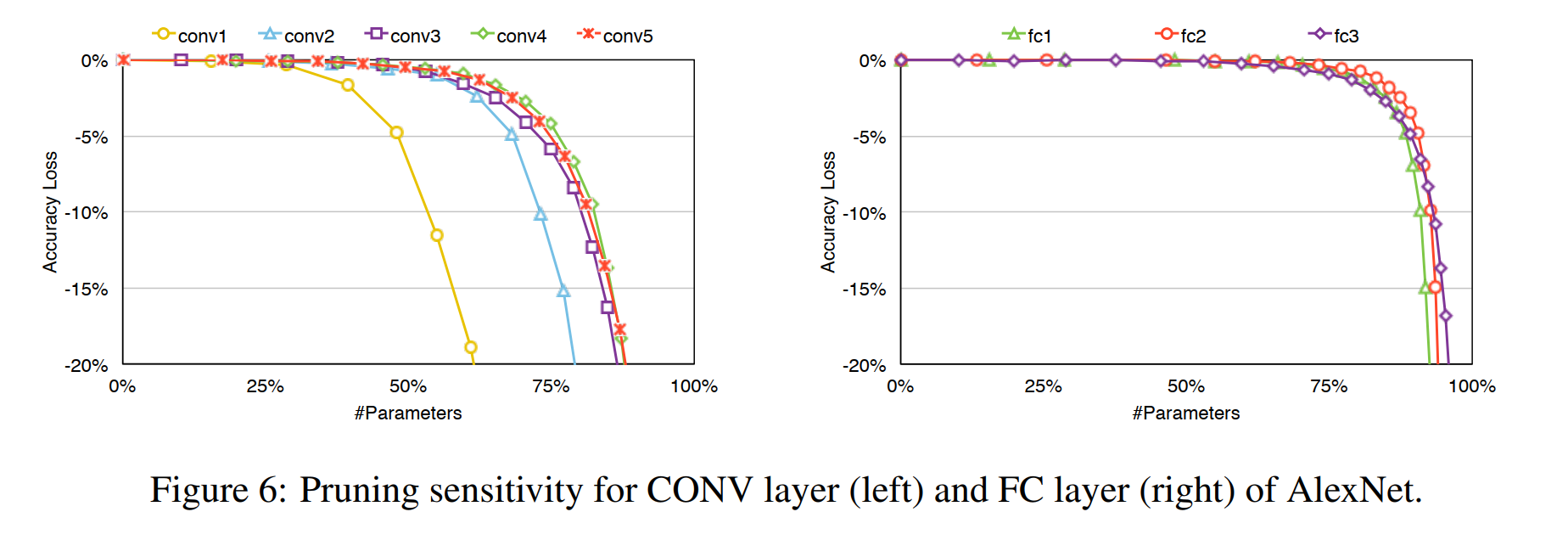

layer별 성능

CONV layers와 FC layers 모두 prune 할 수 있다.

CONV layers가 FC보다 좀 더 pruning에 예민함

CONV layers에서 이미지를 직접 받는 1st 계층이 가장 pruning에 예민함

threshold를 층마다 다르게 정하는데 이 논문에선 예민할 수록 작은 값으로 정함