본 내용은 빅데이터 파이프라인 마스터; 성공을 위한 도구와 기술

강의를 들으며 실습하는 과정을 기록했습니다.

1. (연습) 파이썬 생성 후 실행

이전 포스트의 마지막에서 이어짐

vim 1_urllib.pyimport urllib.request

url = "http://api.aoikujira.com/ip/ini"

res = urllib.request.urlopen(url)

data = res.read()

text = data.decode("utf-8")

print(text)vim에서 위 내용을 저장하려면 esc 후

:wqpython3 1_urllib.py2. (실습) 기상청 사이트

기상청 https://www.weather.go.kr/w/index.do

2.1 RSS 가져오기

기상청 사이트 하단 RSS 누름

여러 지역에 대한 RSS가 나옴(이걸 가져오려고 함)

vim 1_urllib.py#!/usr/bin/env python3

import sys

import urllib.request as req

import urllib.parse as parse

if len(sys.argv) <= 1:

print("usage: download-forecast-argv <region number>")

sys.exit()

regionNumber = sys.argv[1]

api_addr = "http://www.kma.go.kr/weather/forecast/mid-term-rss3.jsp"

values = {

'stnId' : regionNumber

}

params = parse.urlencode(values)

url = api_addr + "?" + params

print("url =", url)

data = req.urlopen(url).read()

text = data.decode("utf-8")

print(text)실행

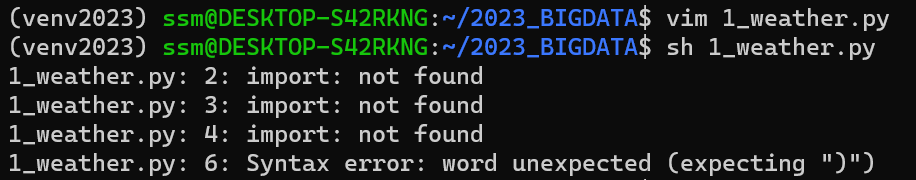

sh 1_weather.py

python3 1_weather.py

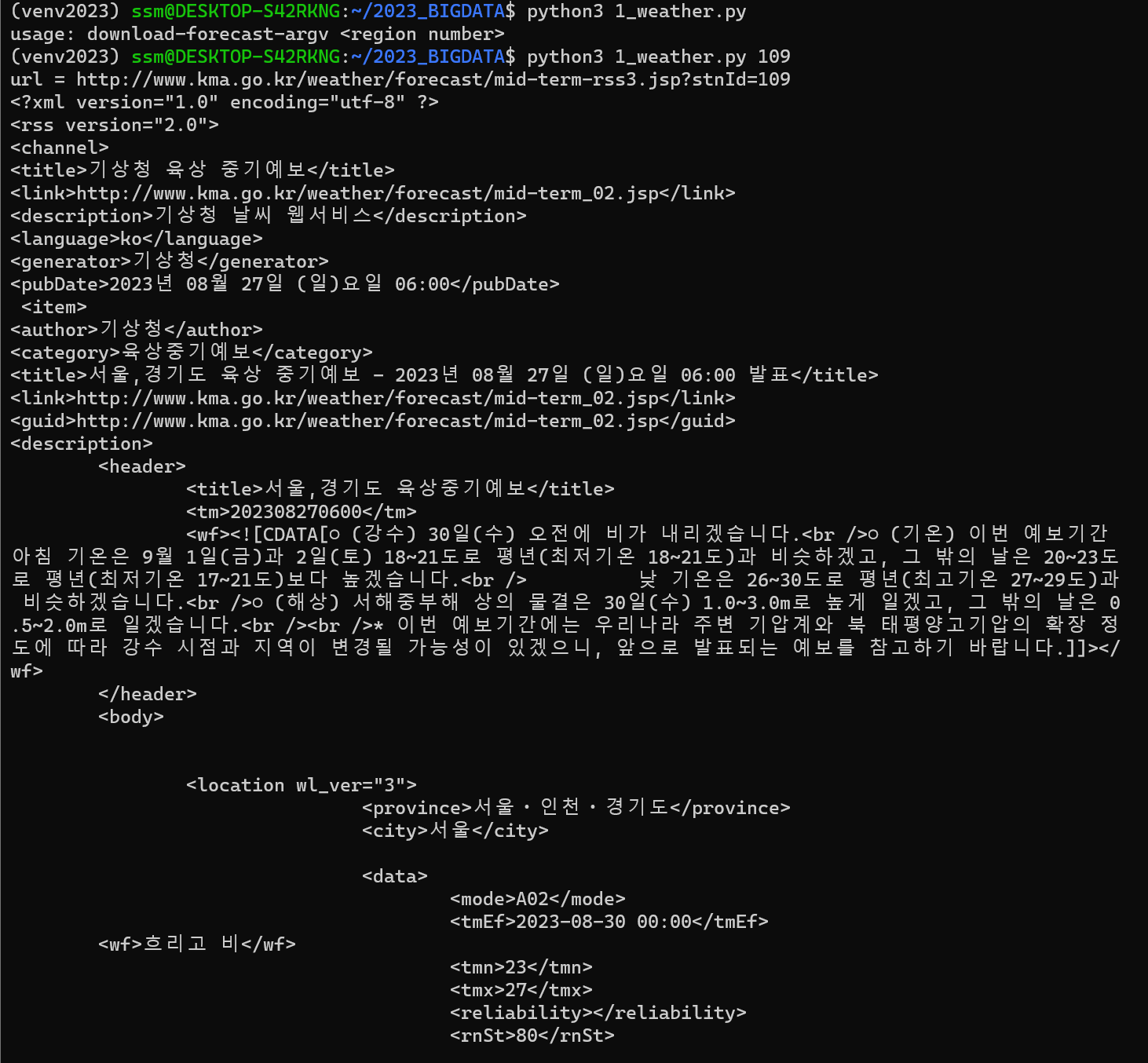

python3 1_weather.py 109

짠 잘 가져온다

이 데이터를 파싱해서 사용하면 되겠다