🏆 학습 목표

- 딥러닝에 대한 소개: CNN(Convolutional neural networks), RNN(Recurrent Neural Networks)과 같은 딥러닝 모델을 공부하기 전에 중요한 요소인 Data, Model, Loss, Optimization algorithms에 대해 배웁니다.

- 딥러닝의 역사: 2012년부터 2021년까지의 패러다임에 대해 배웁니다.

인공지능(Artificial Intelligence) = 인간의 지능을 모방하는 것

머신러닝(Machine Learning) = 데이터를 통해 무언가를 학습하는 기계학습

딥러닝(Deep Learning) = Neural Network라는 구조를 사용하는 모델

Key Componenets of Deep Learning

- Data : 우리가 풀고자하는 문제에 dependent

- Model : 같은 데이터가 주어져도 모델에 따라 성능이 다를 수 있다.

- Loss function : 모델을 어떻게 학습할지(=Neural Network의 weight와 bias를 어떻게 업데이트 할지에 대한 기준)

- 회귀(Regression) : MSE (Mean squared Error)

- 분류(Classification) : CE(Cross Entropy)

- 확률(Probabilistic) : MLE (=MSE)

- Algorithm : 네트워크를 어떻게 줄일지

- Dropout

- Early stopping

- k-fold validation

- Weight decay

- Batch normalization

- MixUp

- Ensemble

- Bayesian Optimization

=> 다양한 techinique를 통해 학습 데이터만이 아닌 한 번도 보지 못한 테스트 데이터/실환경에서 잘 동작하는 것이 목적

Historical Review

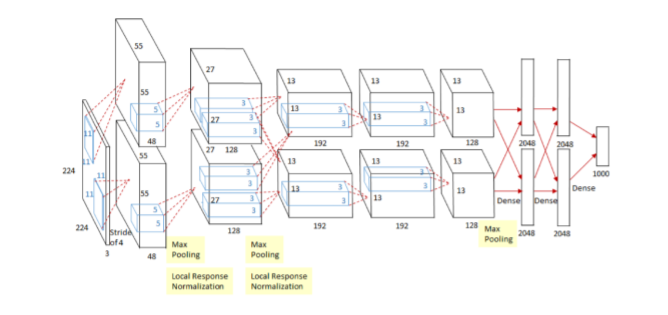

2012-AlexNet

딥러닝이 실제적으로 성능을 발휘하기 시작하여 기계학습의 판도가 바뀌기 시작

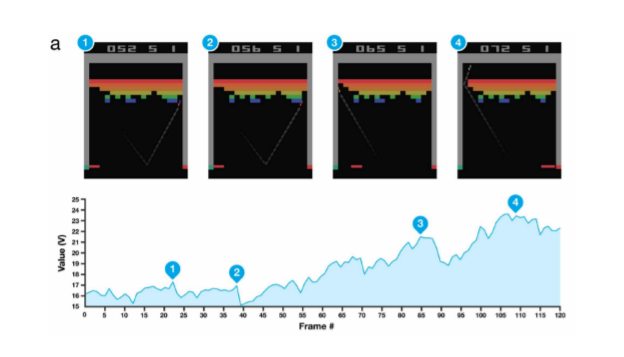

2013-DQN

- 알파고를 만든 알고리즘

- 큐러닝이라 불리는 강화학습의 방법론을 이용해 딥러닝에 접목한 방법

- 오늘날의 DeepMind를 있게 한 것

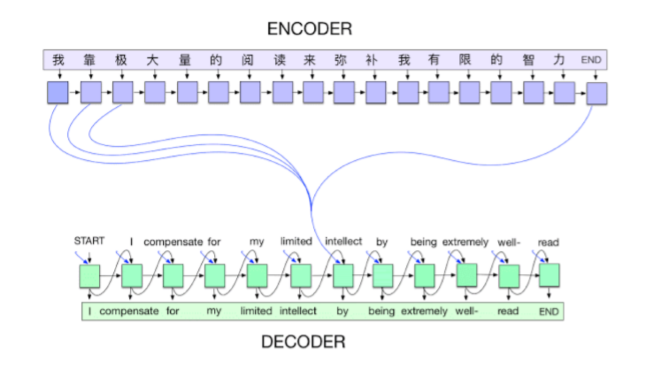

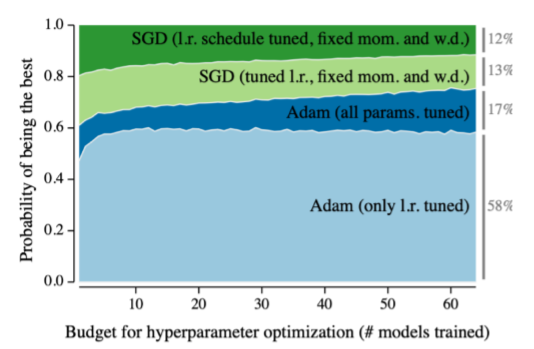

2014-Encoder/Decoder, Adam

- 단어의 연속(sequence)이 주어졌을 때 우리가 원하는 다른 언어의 단어의 연속(sequence)으로 뱉어주도록 함 (seq2seq)

- 웬만하면 실험결과가 잘 나옴

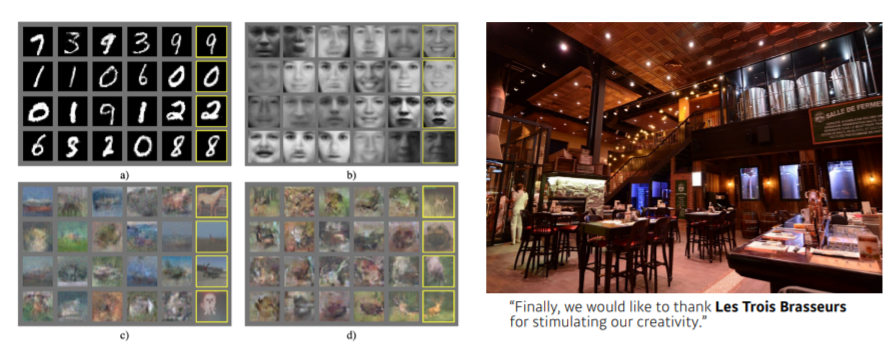

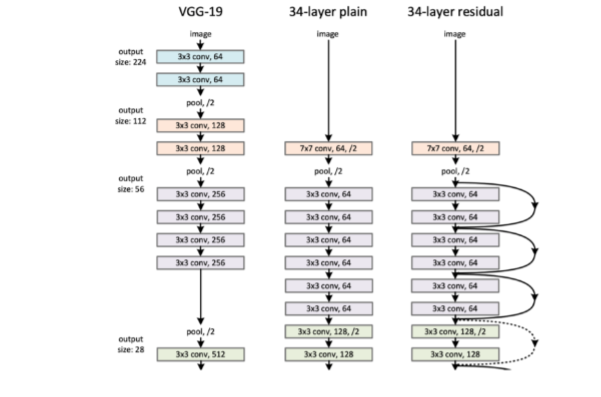

2015-GAN, ResNet

- 네트워크가 generator와 discriminator 두 개를 만들어 학습시키는 것

- 딥러닝의 이유/필요성을 설명해주는 모델

- 네트워크를 깊게 쌓을 수 있도록 만들어준 모델

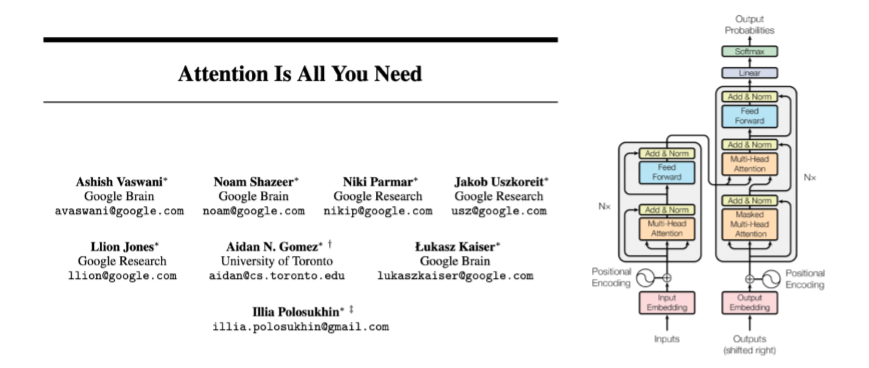

2017-Transformer

- "Attention Is All You Need"

- Multi-Head Attention의 구조를 이해하는 것이 중요

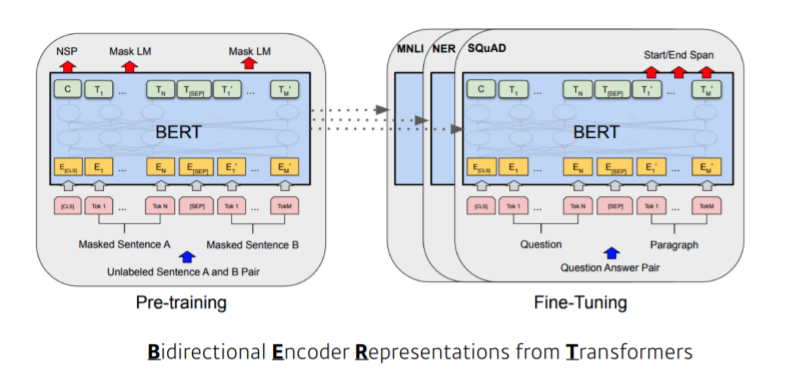

2018-Bert

- Transformer 구조 + Bidirectional Encoder 구조 활용

- 딥러닝의 흐름을 바꾼 개념 : fine-tuned NLP models

- language model : 이전 단어들이 주어졌을 때 다음에 어떤 단어들이 나올지 맞추는 것. 이를 반복하게 되면 그럴싸한 문장/글은 물론 프로그램을 만들 수 있다.

- 다양한 단어들/큰 말뭉치(wikipedia)를 활용해 pre-training(사전 학습)한 후 내가 풀고자 하는 소수의 데이터에 fine tuning하여 좋은 성능을 내는 모델

2019-Big Language Models(GPT-X)

- NLP 모델

- fine-tuned model의 끝판왕

- 약간의 fine tuning을 통해 다양한 문장/프로그램/표와 같은 sequencial 모델을 만들 수 있음

- 굉장히 많은 parameter

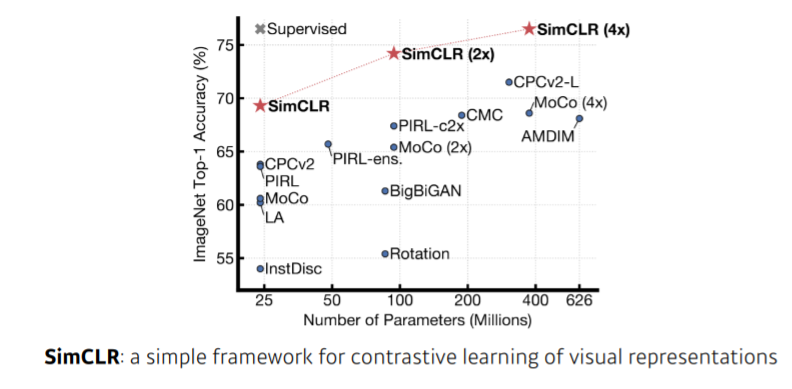

2020-Self-Supervised Learning

- SimCLR : Self Supervised Learning의 포문을 열은 논문

- 한정된 학습 데이터(label 있음)외에 unsupervised 데이터(label 없음)를 활용하는 것

- Supervised Learning : 학습데이터를 도메인 지식을 통해 추가로 만들어내 학습 데이터를 더 많이 만들어 좋은 성능을 내는 것

Reference