학습 : 주변 환경과 상호작용을 통해 배우는 것

강화학습 : 인공지능 연구자나 엔지니어의 시각에서 컴퓨터를 활용하는(Computational) 상호작용으로, 이상적인 학습 환경에서 다양한 방법이 가지는 효과를 수학적 분석과 컴퓨터 실험을 통해서 분석한다.

1.1 강화학습

'학습자(Agent)'가 주어진 상황'에서 '어떠한 행동(Action)'을 취할지 학습하는 것

또한, 어떤 행동이 수치적으로 표현 가능한 '최대한의 보상(Reward)'을 가질 때, 여러 행동의 연속에서 각각 최대의 보상을 받을 수 있는 '지연된 보상'을 '시행착오'를 통해서 최대화 하는 것을 강화학습으로 정의 할 수 있다.

이 과정에서 마르코프 결정 과정(MDP)을 사용하며, 지침(label)이 포함되어 시스템의 행동방식을 예측하는 지도학습(Supervised learning)이나 데이터간의 숨겨진 구조를 찾아 분류하는 비지도학습(Unsupervised learning)과 구분된다.

이미 데이터들이 주어져있는 위의 두 분야와는 다르게 효과적인 행동을 발견하기 위해서는 (가능한 모든 경우의 수의) 다양한 행동을 통해 경험을 축적해야 하는데, 이를 탐험(Exploration)이라고 하며, 경험한 행동을 활용(Exploitation)의 trade-off에서 균형을 잡는 것이 중요하다.

강화학습은 주변 환경과 상호작용을 고려하므로, 여러 하위 문제를 병합해서 연구하기 적절하며, 주변 환경에 대한 정보가 부족한 점 또한 인지할 수 있으므로 환경에 대한 모델을 도충하고 개선시킬 수 있다.

강화학습은 공학과 과학등에 실질적으로 생산적인 상호작용이 가능하며, 기존의 통계학과 수학을 수렴할뿐만 아니라 심리학과 신경과학과 서로 큰 영향을 주고받고 있다. 이런 과정을 통해 단순하고 포괄적인 의사결정의 일반 원리를 찾아가고자 하고 있다.

1.2 예제

- 체스의 어느 위치로 말을 옮기는 것은 상대의 대응과 나의 미래의 계획,

직관적인 판단을 통해서 이루어진다. - 석유 정제의 효율적 운영을 위해 초기 파라미터를 조정하고, 한계비용을 고려하여 산출물, 비용, 품질 균형을 최적화 한다.

- 로봇 청소기는 청소를 위해 새방을 탐색할지 혹은 충전 스테이션으로 돌아갈지를 남아있는 배터리 양과 스테이션의 위치에 따라 결정한다.

- 새끼 가젤은 태어난지 몇 분 지나지 않아 일어설 수 있고, 30분만에 시속 30km/h의 속도로 달릴 수 있다.

위의 모든 예제들은 학습자와 주변 환경 사이의 상호작용(Interaction)으로 이루어지며, 불확정(Uncertainty) 요소 사이에서 목표(Goal)를 이루기 위해서 환경을 모니터링하면서 적절한 대응을 하여야 한다.

결과적으로 체스 선수는 직관을 키워 더 좋은 수를 둘 수 있고, 가젤은 더 효율적으로 달릴 수 있는 법을 배우게 되는데, 이는 이전의 경험을 활용하거나 가지고 있는 지식을 활용하지만 주변 환경과 상호작용은 필수적이다.

1.3 강화학습의 구성 요소

학습자(Agent), 환경(Env)

정책(Policy)

정책은 특정 시점에 학습자가 취하는 행동을 정의한다. 이는 간단한 함수나 테이블일 수도 있고, 혹은 탐색 과정에 필요한 방대한 계산을 포함 할 수있다. 또한 정책은 확률론적으로 각 행동에 선택 확률을 부여하고, 그 확률에 따라 행동을 선택 할 수 있다.

보상 신호(Reward Signal)

보상신호는 성취해야 할 목표를 정의한다. 매 시간마다 환경은 학습자에게

보상(Reward)이라 불리는 숫자를 전달하고, 학습자는 장기간에 걸쳐 이 보상의 총합을 높게받으려 하고, 이로부터 높은 보상을 주는 행동은 자주하도록 낮은 보상을 주는 행동은 하지 않도록 정책이 조정될 수 있다.

가치함수(Value Fuction)는 즉각적으로 알 수 있던 보상과는 달리 장기적인 관점에서 무엇이 좋은지를 알려준다. 특정 상태의 가치(Value)는 그 상태에 시작점에서부터 학습자가 기대할 수 있는 보상의 총량으로, 가치는 보상에 대한 예측이므로 불확실하고,결정하기 어렵지만 장기적으로 큰 보상을 얻기 위해서는 가치가 중요하고, 가치 추정이 강화학습에서 핵심적 역할을 하게 된다는 것이 60년간의 강화학습에서 알게 된 것 중 가장 중요하다.

모델(Model)

환경 모델은 환경의 변화를 모사(mimic)한다. 환경의 변화를 알 수 있다면 행동에 따른 다음 상태와 보상을 예측하여 계획(Planning)을 짤 수 있다. 이런 모델 기반의 강화학습 문제를 해결하는 것을 모델 기반(Model-based) 방법이라 하고, 반면 계획없이 시행착오만을 통해 학습하는 것을 Model-free 방법이라고 한다.

1.4 한계와 범위

강화학습은 상태(state)라는 개념에 의존한다. 상태는 정책 및 가치 함수의 입력이 되기도 하고, 모델의 입력과 출력이 되기도 한다. 이는 학습자의 환경에 대한 모든 정보를 전처리(Preprocessing)하여 제공 되는 것으로 상태 정보를 바탕으로 가치 함수를 추정해 학습자가 취할 행동을 결정한다.

반대로 유전자 알고리즘이나 유전자 프로그래밍, 모의 담금질 같은 최적화 방법은 진화적(Evolutionary)방법은, 환경과 큰 시간 간격으로 상호작용하는 정적 정책(Static policy)을 가지며, 환경의 완전한 상태를 감지 할 수 없거나 정책을 잘 찾을 수 있는 경우 사용할 수 있다.

1.5 확장된 예제 틱택토

틱택토는 세 개의 행과 열로 이루어진 격자판으로 하는 게임으로

한국에서는 삼목이라고도 불린다.

이 게임에 숙달된 사람은 무조건 적어도 비기는 게임을 할 수 있기 때문에,

숙달되지 않은 사람과 연습을 한다고 가정하면, 전통적인 기계학습으로는 항상 지지않는 방식을 학습시키긴 어렵다. 왜냐하면 상대방에 대한 사전 정보가 없으면, 상대방의 행동 확률을 알 수 없기 때문이다.

진화적 방법을 사용한다면, 모든 경우의 수의 정책을 가지는 에이전트들을 만들고 승패를 통해 연속적으로 정책들을 판단해서 좋은 정책들의 집합을 유지할 수 있을 것이다.

반면, 가치함수를 사용한다면 게임에서 나타날 수 있는 모든 상태에 숫자표를 만들어 승리할 확률에 따라 가치를 부여한다. 이 경우에 초기 확률을 50%로 설정하고 여러 번 게임을 진행하면서, 승리확률 추정을 최고로 하는 위치에 X를 탐욕적으로 선택하거나 때로는 탐험적(exploratory)으로 X를 무작위로 선택한다. 이로부터 점점 더 특정 상태의 가치가 승리 확률에 대한 더 정확한 추정이 되도록 한다.

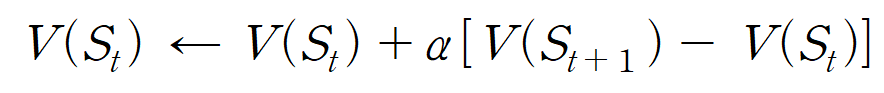

이는 선택 이후 현재 가치가 나중 상태의 가치에 가까워지도록 갱신하는 과정을 통해서 가능해지며

α라는 시간 간격 파라미터(Step-size parameter)를 통해 두 연속적인 추정값 차이에 기반하여 계산되기 때문에 시간차(Temporal-Difference learning) 학습 방법이라고 한다. 이 과정이 반복되다보면 결과적으로 각각의 상태로부터 승리할 확률은 참으로 수렴하며, 이로부터 최적의 정책이 수렴되게 된다.

진화적 방법이 정책을 고정한채로 최종 결과만을 사용하여 정책을 수정하는 거와 반대로(MC와 유사한 느낌), 강화학습은 매 순간 환경과 상호작용하며 학습하는 특징을 알 수 있다

강화학습은 틱택토보다 상태가 훨씬 더 무한한 경우에도 인공 신경망의 일반화 능력을 통해, 지도학습을 결합할 수도 있고, 모델이 없는 경우도 탐색을 통해 모델을 학습하거나, 여러 수준에서 정교한 문제 해결방법을 사용하는 계층적 학습 시스템을 가질 수도 있따.

1.6 요약

강화학습은 목표 지향적인 학습과 결정을 이해하고 자동화하긴 계산적 접근법이다. 지도(supervision)나 완벽한 모델 없이 환경과 상호작용하는 것이 다른 접근법과 구별되는 것으로, 이를 위해서 마르코프 결정 과정의 틀을 사용한다.

이 과정에서 가장 중요한 것은 가치와 가치 함수로, 정책을 평가하는 큰 기준이 됨과 동시에 진화적 방법과 구별되는 점이다.