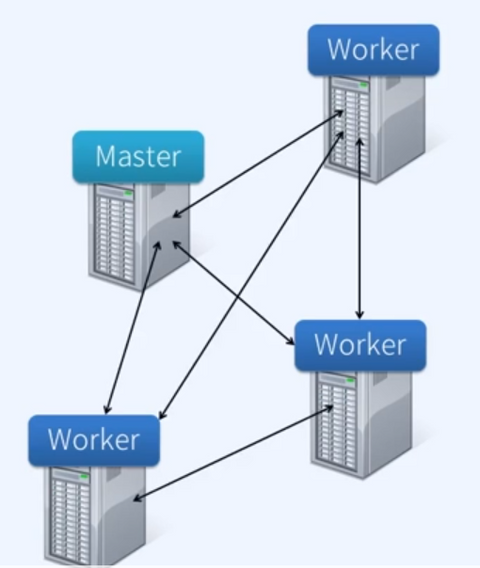

ssh 설치 및 키 생성

서버간 안전하게 통신할 수 있도록 하기 위함

# spark 계정으로 스위칭

sudo su - spark

# 다른 서버에 ssh 연결해 보기

ssh spark-master-01

ssh spark-worker-01

ssh spark-worker-02

ssh spark-worker-03 # aws에서는 3대 연결할 예정임

# Permission denied 됨 -> 연결 불가

ssh key생성, authorized_keys 구성

- Server no password, SSH 연결하기

- RSA key 기반 인증)

- ssh key 생성

- authorized_keys 구성

- 3개 Server 동일 작업 수행

- SSH Connection Test(w/o PWD)

# .ssh 디렉토리생성

mkdir ~/.ssh

cd ~/.ssh

# 3개 서버 모두 동일하게 생성 하기

ssh-keygen -t rsa -P '' -f ./id_rsa

# key pair 생성 확인

ls -al 또는 llauthorized_keys 파일 구성

- key 기반 server 인증을 위한 인가(authorized)된 keys 파일 구성

- 3대 서버의 public key 내용으로 authorized_keys 파일 생성(private key 아님)

# 본 서버의 키를 ~/.ssh/authroized_keys 에 복사

~/.ssh$ cat id_rsa.pub > authorized_keys

# 파일 확인

~/.ssh$ cat authorized_keys

# 다른 서버의 퍼블릭키 동일 방법으로 모두 붙여넣기

echo 'ssh-rsa XXXXXXXXXXXX...XX= spark@spark-worker-01' >> ~/.ssh/authorized_keys

# 파일 확인

~/.ssh$ cat authorized_keys

# 다른 host로 파일 보내기

scp authorized_keys spark@spark-worker-02:~/.ssh/

- 4대 모두 소유자만 읽을 수 있도록 퍼미션 변경

# 4대의 퍼블릭키 모두 복사후 소유자만 rw 가능하도록 변경

chmod 600 ~/.ssh/authorized_keys- 서로 연결되는지 테스트 하기

ssh spark-worker-01

- 연결이 되지 않으면, 방화벽 상태 확인 및 port 열기

# 방화벽 상태 확인

sudo ufw status

# 방화벽 활성화

sudo ufw enable

# ssh port 인 22번 port 열여주기

sudo ufw allow 22/tcp

---------------------------

# ssh port 인 22번 port 열여주기

sudo ufw deny 22/tcp

# 방화벽 비활성화

sudo ufw disable