Abstract

한정된 자원으로 최대의 효율을 내기 위한 방법으로 model scaling(depth, width, resolution)을 시스템적으로 분석하여 더 나은 성능을 얻고자 한다.

따라서 새로운 scaling 방법으로 compount coefficient를 제안한다. 그리고 이를 바탕으로 찾은 효율적인, 기본이 되는 모델 EfficientNet을 소개한다.

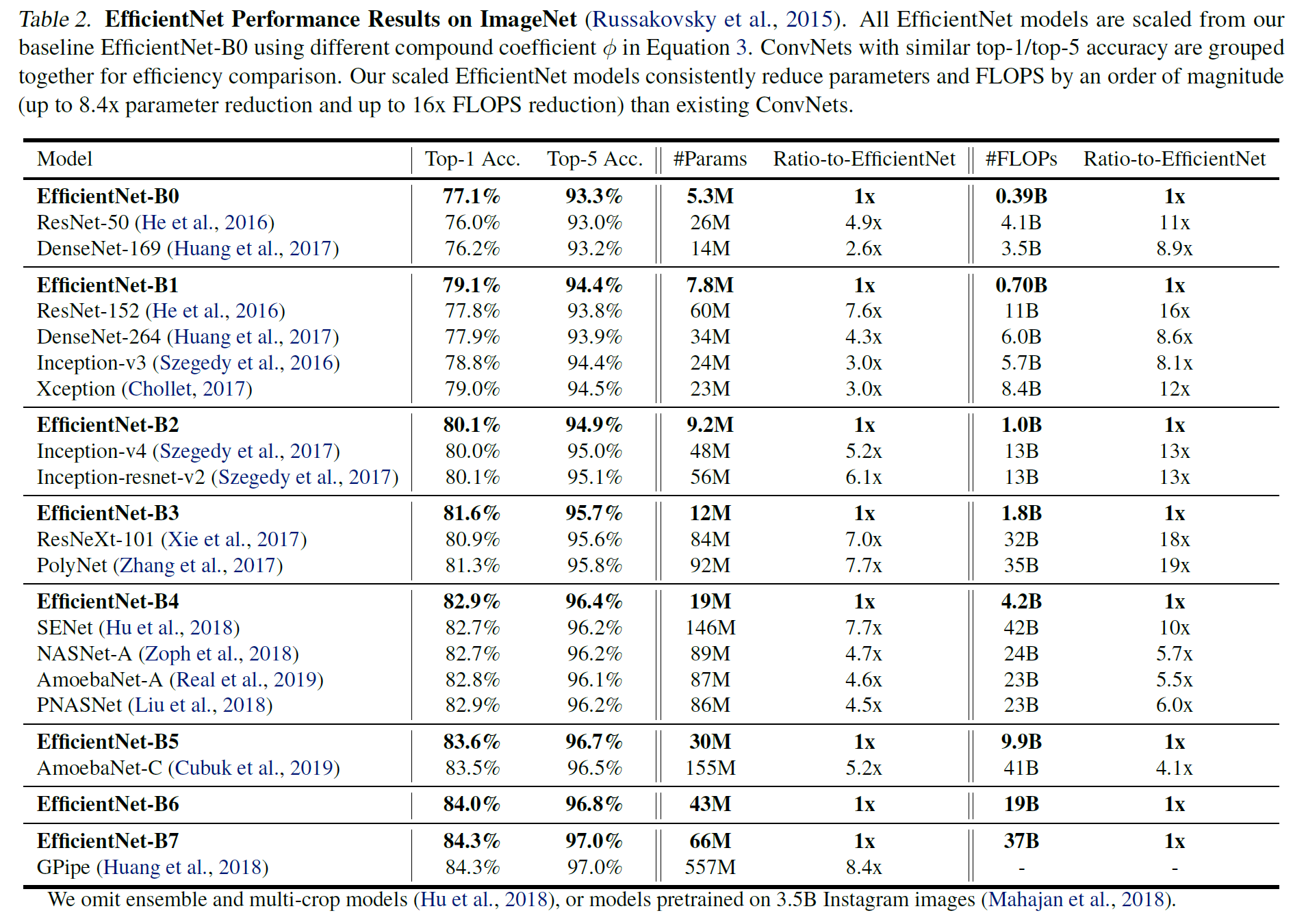

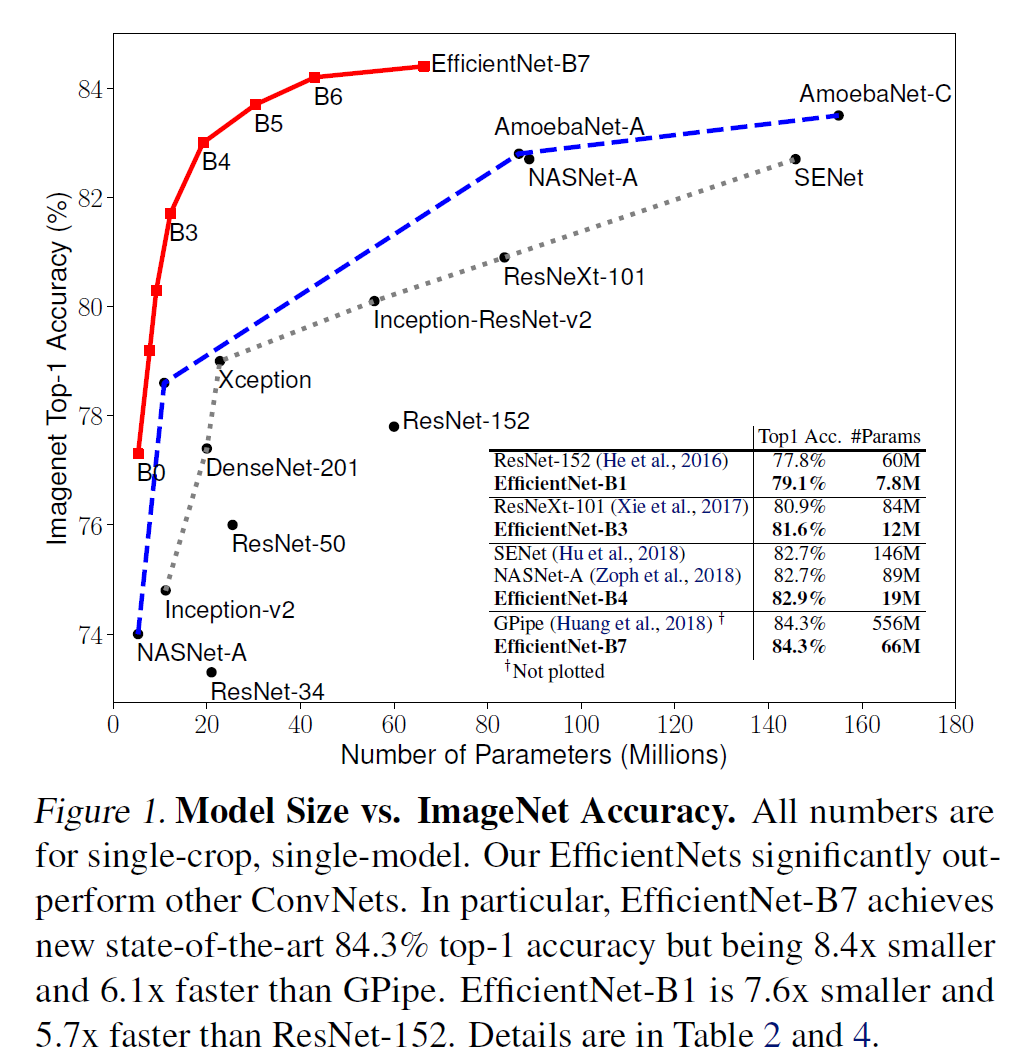

또한 EfficientNet은 ImageNet에서 기존 ConvNet보다 8.4배 작으면서 6.1배 빠르고 더 높은 정확도를 갖는다.

Related Work

ConvNet Accuracy

AlexNet 이후 ImageNet competition에서 더 깊어지고 더 커지면서 정확도 또한 상승한 모델이 여럿 발표되었다. 최근 발표되는 모델들은 ImageNet뿐만 아니라 다른 데이터셋에서도 잘 작동한다.

하지만 정확도가 늘어난 만큼 사용하는 자원 또한 크게 늘어났다.

ConvNet Efficiency

깊은 ConvNet은 종종 ver-parameterized된다. 따라서 효율을 높이기 위해 모델 압축하는 여러 기법이 제안되었다.

그 기법에는 SqueezeNets, MobileNets, ShuffleNets 등이 있다.

Model Scaling

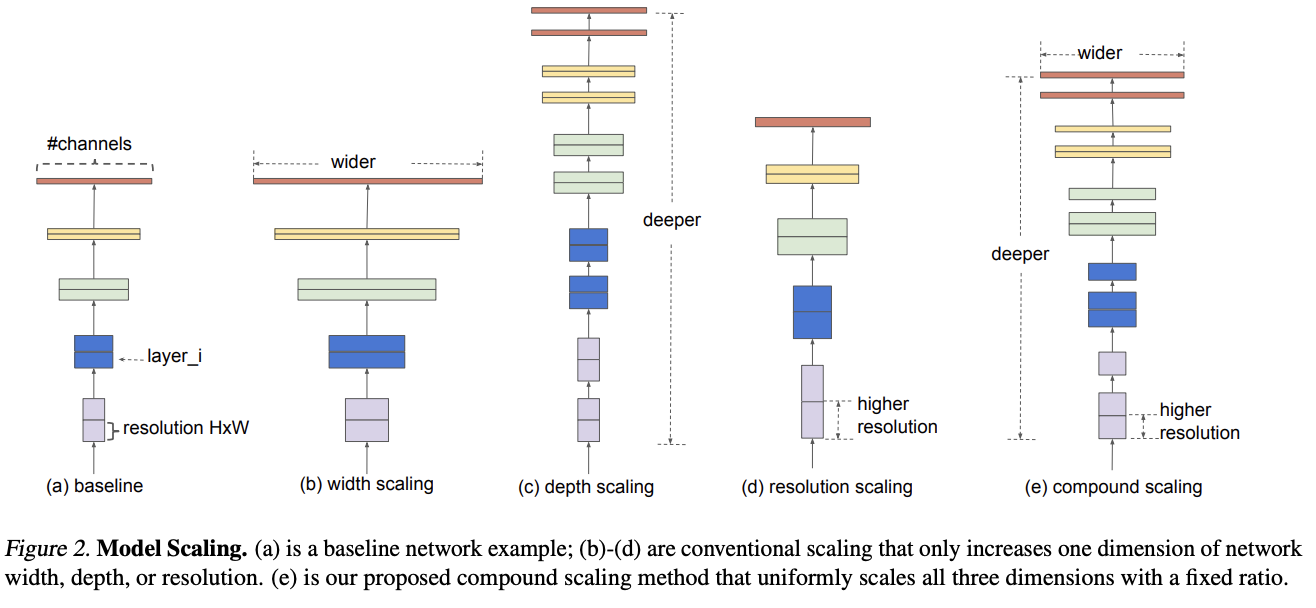

ResNet(ResNet-18, ResNet-50, ResNet-200)은 깊이를 달리 하였다.

MobileNets는 network width를 달리 하였다.

또한 이미지 해상도가 높아지면 (찾아낼 정보가 많아서) 정확도가 높아진다. (물론 계산량도 많이 늘어난다.)

이처럼 많은 연구가 진행되었으나 어떻게 효율적인 조합을 찾는지는 아직까지 정립되지 않았다.

Compound Model Scaling

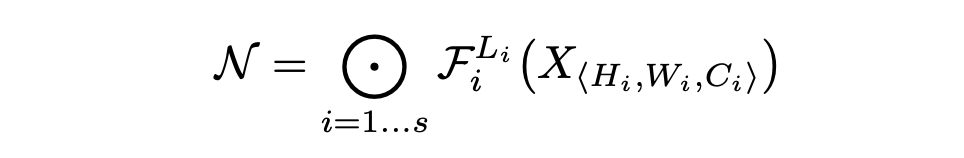

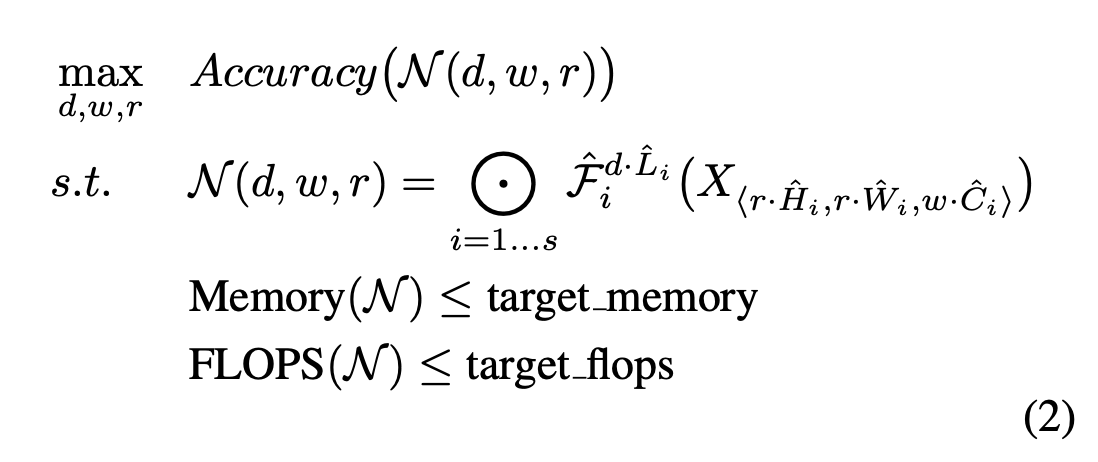

Problem Formulation

이 식은 ConvNet을 수식화해 정리해 놓은 부분이다. H,W,C는 입력 텐서의 크기이고 F는 conv layer이다.

모델이 사용하는 자원이 제한된 상태에서 모델의 정확도를 최대화하는 문제를 풀고자 하는 것이므로 다음과 같이 정리할 수 있다.

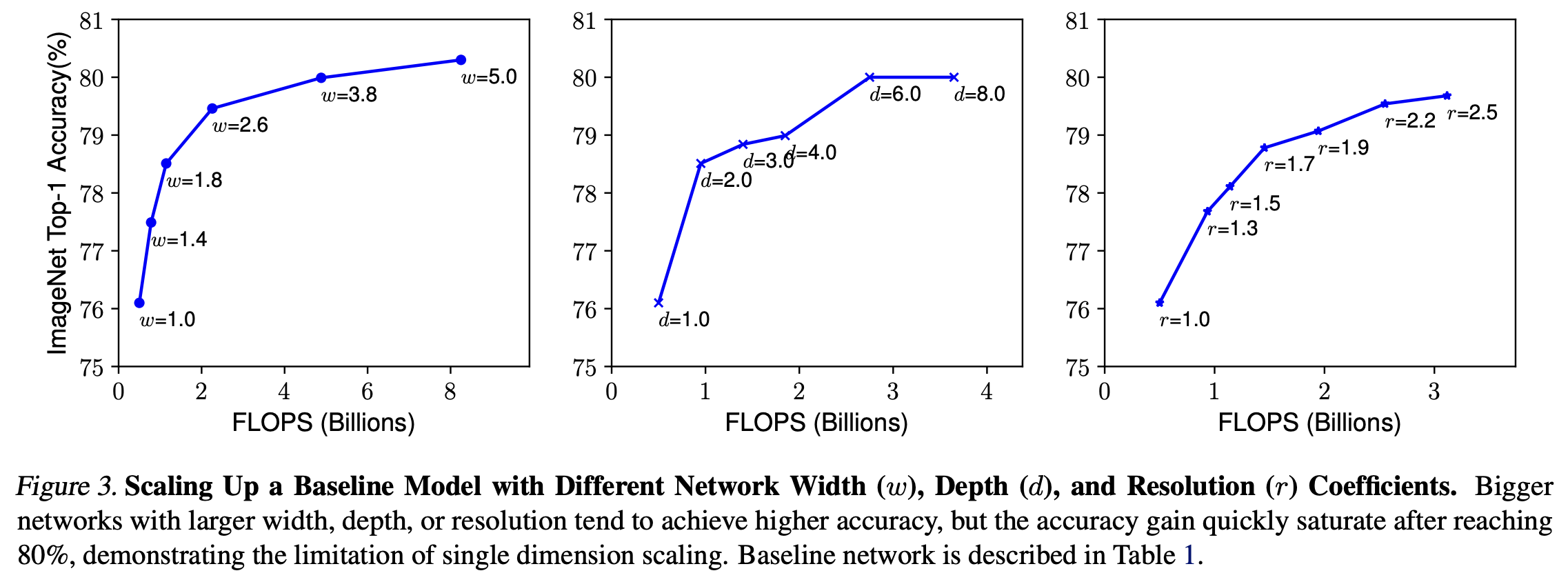

Scaling Dimensions

- Depth: 모델이 깊어질수록 모델의 capacity가 커지고 더 복잡한 feature를 잡아낼 수 있지만 vanishing gradient 문제로 학습시키기가 어려워진다.

- Width: 각 layer의 width를 키우면 해상도가 정확도가 높아지지만 계산량이 제곱에 비례하여 증가한다.

- Resolution: 입력 이미지의 해상도를 키우면 더 세부적인 feature를 학습할 수 있어 정확도가 높아지지만 마찬가지로 계산량이 제곱에 비례해 증가한다.

결론적으로 모델이 커질수록 드는 연산량에 비해 얻는 정확도 상승량이 매우 적다.

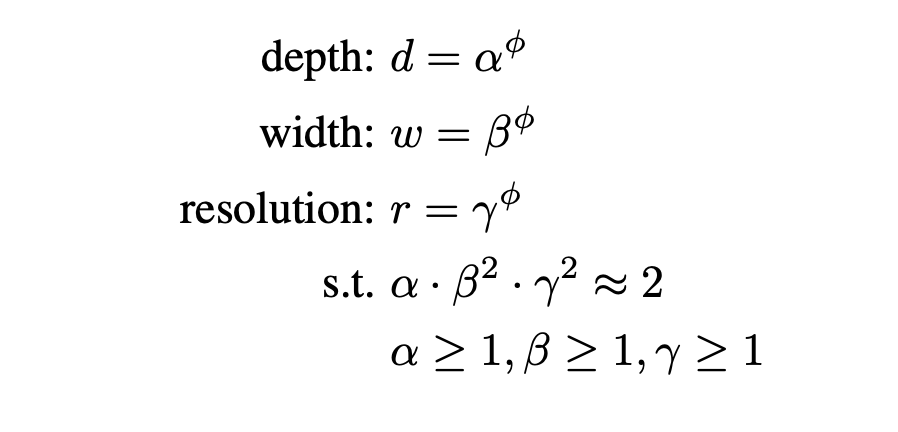

Compound Scaling

직관적으로, 더 높은 해상도의 이미지에 대해서는, 네트워크를 깊게 만들어서 더 넓은 영역에 걸쳐 있는 feature를 더 잘 잡아낼 수 있도록 하는 것이 유리하다.

또, 더 큰 이미지일수록 세부적인 내용도 많이 담고 있어서, 이를 잘 잡아내기 위해서는 layer의 width를 증가시킬 필요가 있다.

즉, 이 depth, width, resolution이라는 세 가지 변수는 밀접하게 연관되어 있으며, 이를 같이 움직이는 것이 도움이 될 것이다.

따라서 위 사진과 같은 비율로 변수를 움직인다.

Architecture

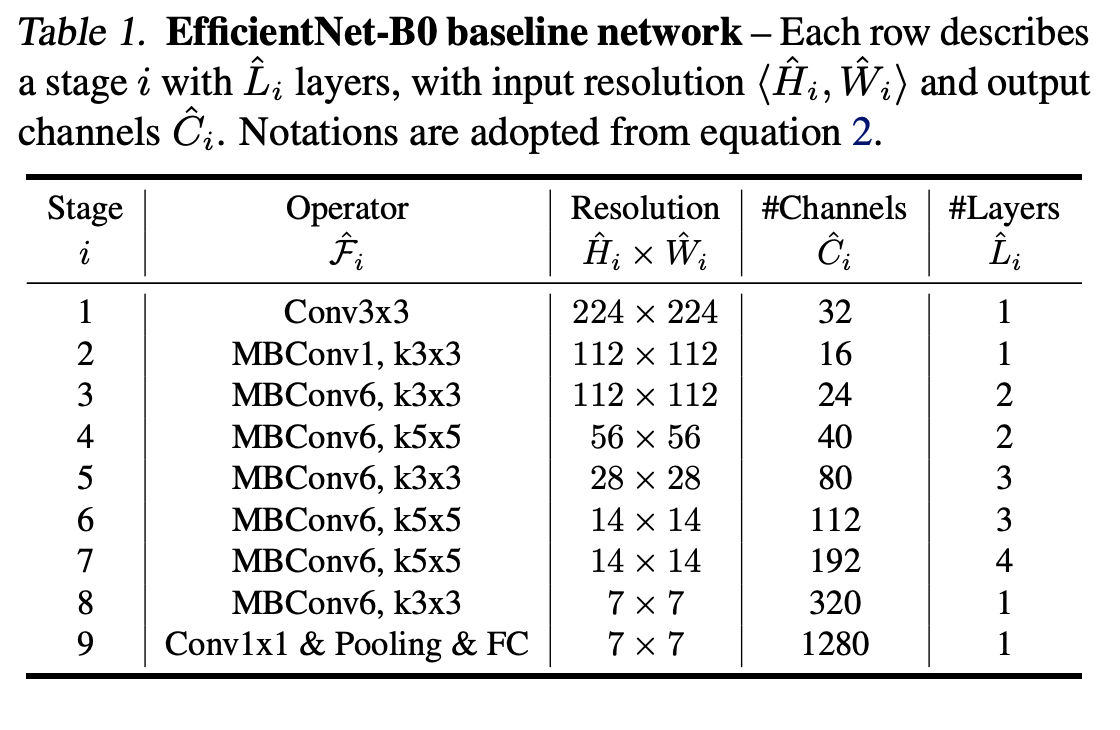

MnasNet에 기반한 baseline network를 사용한다.

Experiments