- 이번 주차 개요 — GA4 기반 마케팅 성과 분석 실습

이번 BDA 빅데이터 분석 학회 6주차 수업에서는 데이터 분석 실전반 - 지표 설계 및 고객분석을 주제로,

실제 마케팅 데이터가 유입되는 과정을 GA4(Google Analytics 4) 환경에서 직접 다뤘다.

특히 GTM(Google Tag Manager)를 활용해 이벤트를 설정하고, 실시간 데이터 수집이 정상적으로 이뤄지는지 검증하는 과정을 실습했다 .

이를 통해 단순한 이론이 아닌, 실제 서비스 환경에서의 데이터 트래킹 구조를 명확히 이해할 수 있었다.

⸻

- GTM과 GA4 연동 — 실무형 이벤트 트래킹 구조

수업의 핵심은 이벤트 기반 데이터 수집 구조를 직접 세팅해보는 것이었다.

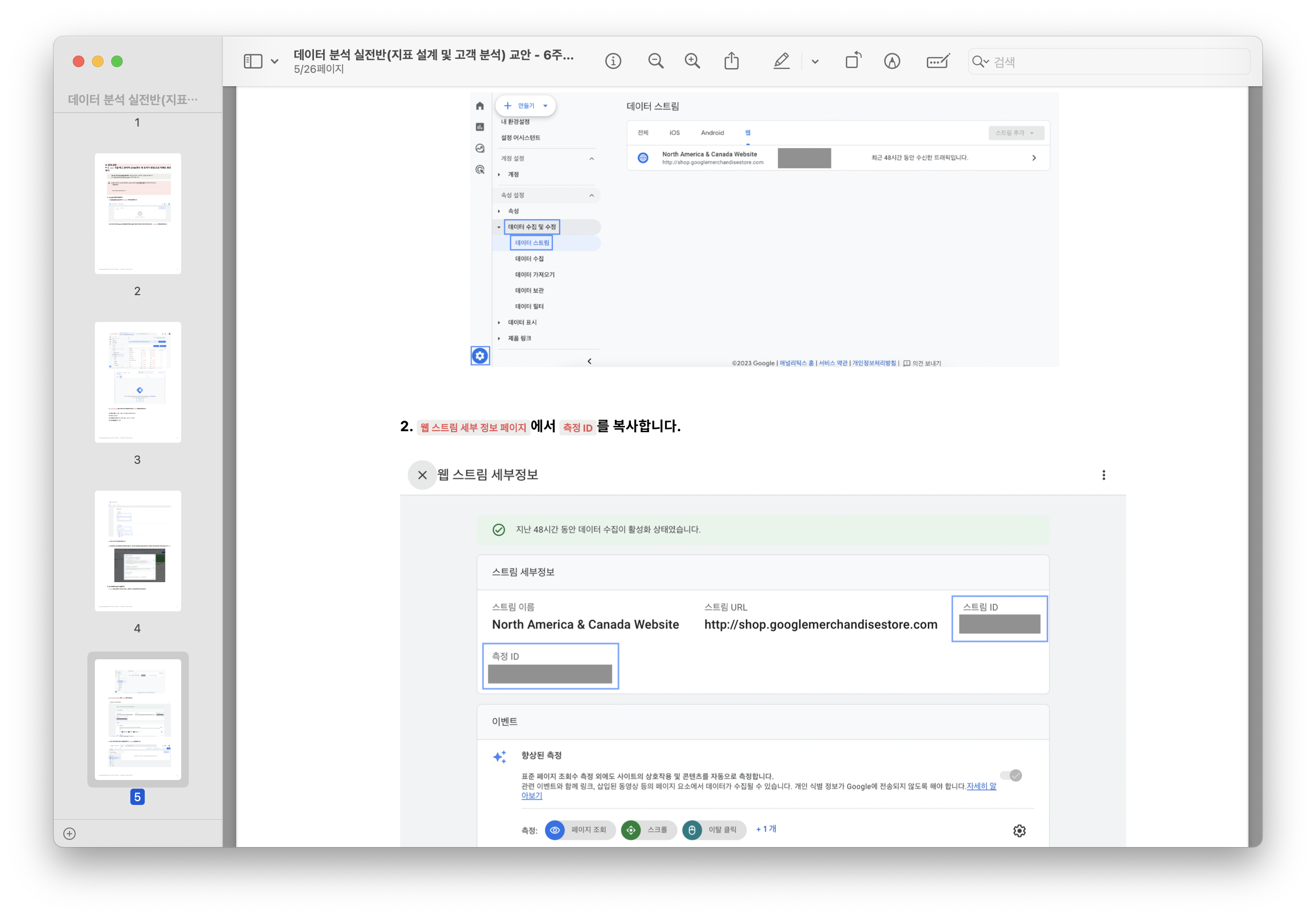

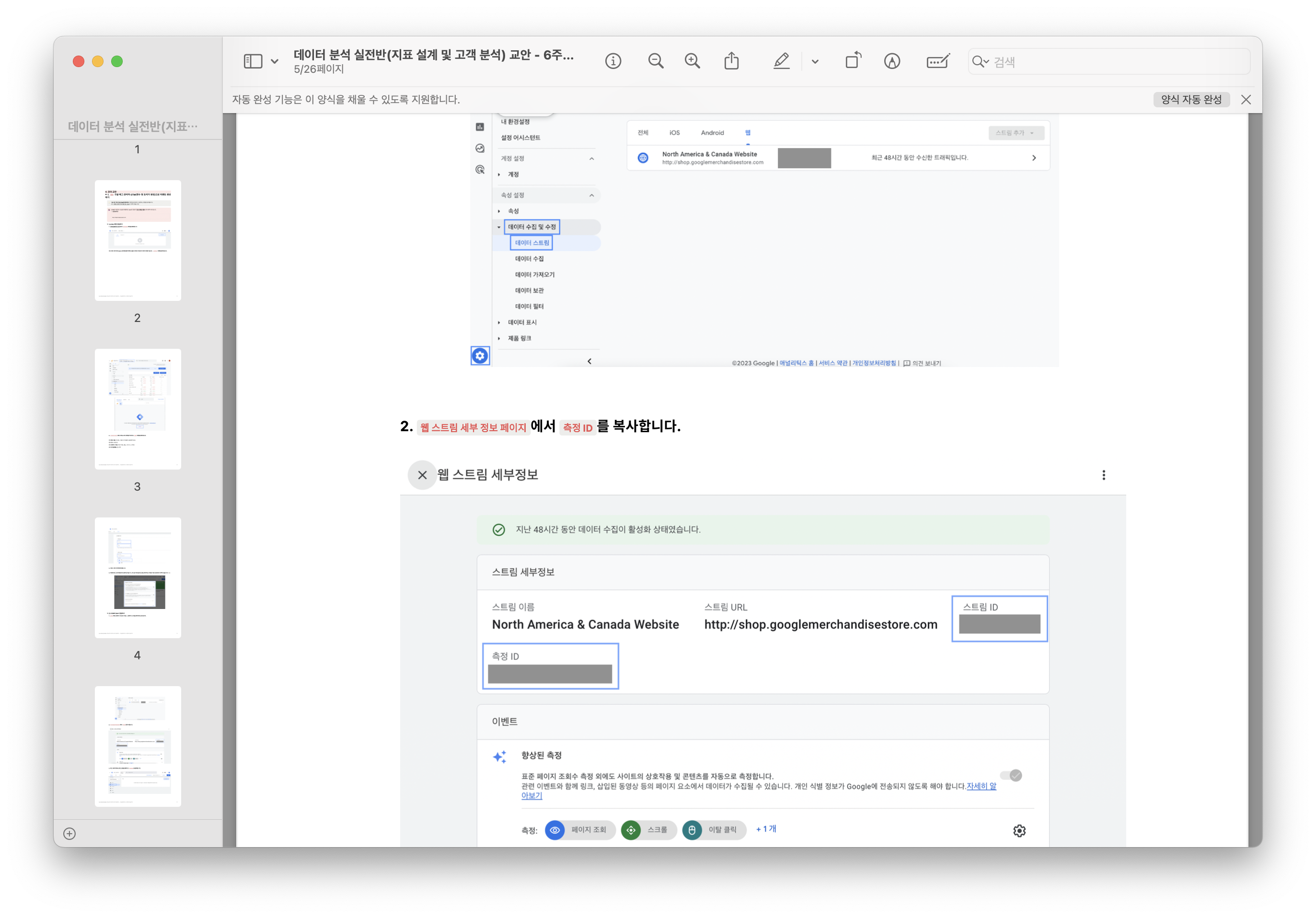

먼저 GTM에서 계정과 컨테이너를 생성한 뒤, GA4의 데이터 스트림에서 측정 ID를 복사해 태그에 연결했다.

이후 All Pages 트리거를 설정하여 모든 페이지의 사용자 행동 데이터를 수집할 수 있도록 구성했다 .

태그를 제출한 후 “Tag Assistant”에서 연결 성공(Connected) 상태를 확인했을 때, 실제 분석 환경이 구축된 것을 눈으로 볼 수 있었다.

이 과정을 통해 “데이터가 어떻게 수집되는가”를 이해하는 것이 데이터 분석의 출발점임을 다시금 느꼈다.

⸻

- 스크롤 이벤트 생성 및 마케팅 채널 분석

다음 실습에서는 스크롤 깊이(Scroll Depth) 이벤트를 생성해, 사용자의 페이지 체류 행동을 측정했다.

세로 스크롤 비율을 75%와 90%로 설정하여, 페이지 끝까지 읽는 사용자 비율을 파악할 수 있었다.

이후 GA4 실시간 보고서에서 이벤트 발생 여부를 직접 확인했으며,

이를 바탕으로 Organic Search, Paid Search, Referral, Email 등 다양한 마케팅 채널의 성과를 분석했다 .

특히 Paid vs Organic의 차이, CPC(클릭당 비용) 구조, Cross-network 통합 분석 개념을 함께 다루며, 실무에서 어떤 지표가 중요한지도 배웠다.

⸻

- UTM 파라미터 실습 — 캠페인 성과 추적의 시작점

6주차 후반부에서는 UTM 파라미터 구조를 학습했다.

utm_source, utm_medium, utm_campaign 세 가지 필수 요소를 중심으로

“누가(Where), 어떤 방식으로(How), 왜(Why)” 유입되었는지를 추적하는 방법을 실습했다 .

구글의 Campaign URL Builder를 사용해

https://shop.googlemerchandisestore.com/?utm_source=instagram&utm_medium=social&utm_campaign=winter_collection

형태의 URL을 직접 생성했고, 이를 통해 캠페인별 트래픽을 정확히 측정할 수 있음을 배웠다.

실제 기업 데이터 분석 시에도 이러한 파라미터 설계가 성과 분석의 기반 지표가 됨을 실감했다.

⸻

- 클린 코드와 효율적 전처리의 연계

이전 주차(데이터 핸들링 5~6주차)에서 배운 벡터화(Vectorize), 멀티프로세싱, 클린 코드 원칙도

이번 분석 실습과 자연스럽게 연결되었다  .

특히 UTM 데이터처럼 반복적이고 대량의 URL을 처리할 때, 벡터화 연산을 적용하면 처리 속도가 압도적으로 향상된다.

또한 학회 내에서 공유하는 스크립트 역시 PEP8 규칙을 지켜 일관된 스타일로 작성하며,

모듈화된 코드 구조로 협업 시 유지보수성을 높이고 있다.

이처럼 “좋은 분석은 좋은 코드에서 시작된다”는 사실을 다시 한 번 체감한 시간이었다.

⸻

- 학회 활동 소감 및 다짐

이번 6주차를 마치며, BDA 빅데이터 분석 학회에서의 경험이 단순한 과제가 아닌

실제 데이터 분석가의 사고방식을 익히는 과정이라는 걸 느꼈다.

휴회기를 지나 다시 수업을 시작하면서, 한 주 한 주 성장하고 있음을 실감한다.

앞으로는 TripMate 프로젝트나 대외 공모전에서도 이번 GA4·UTM 지식을 적극 적용해

실제 서비스 트래킹 환경을 직접 설계·분석해볼 계획이다.

학회의 목표인 “데이터를 통해 행동을 이해하고, 전략을 설계하는 분석가”로 성장하기 위해

남은 활동에서도 꾸준히 실습과 복습을 이어갈 것이다.

#BDA #BDA학회 #데이터분석 #학회 #데이터분석학회 #취업 #취업준비 #대외활동