졸작으로 게임을 만들어서 출시하려 했는데

어찌저찌 하다 AI분야를 하게 되었다…

대회도 나가고 논문도 쓴다는데

새내기들 수업 조교도 하게 되었고

청소년 교육사업도 해야하는데

개인프로젝트로 언리얼 게임 만들기를 할 수 있을까…

1년만에 폭삭 늙어버리진 않을까...

전 말이죠… 게임 개발자가 되고 싶었어요…

1-1

인공지능

- 사람처럼 학습하고 추론할 수 있는 지능을 가진 컴퓨터 시스템을 만드는 기술

머신러닝

- 자동으로 데이터에서 규칙을 학습하는 알고리즘을 연구하는 분야

사이킷런

- 파이썬 기반에서 머신러닝 분석을 위해 사용할 수 있는 라이브러리

- 컴퓨터 과학 분야 대표 머신러닝 라이브러리

딥러닝

머신러닝 알고리즘 중 인공 신경망 기반한 방법들의 통칭

1-2

코렐 기초니 넘어가도록…

1-3

분류

- 머신러닝에서 여러개의 종류(class)중 하나를 구별해 내는 문제

- 이진분류: 2개의 클래스 중 하나를 고르는 문제

특성

- 데이터의 특징

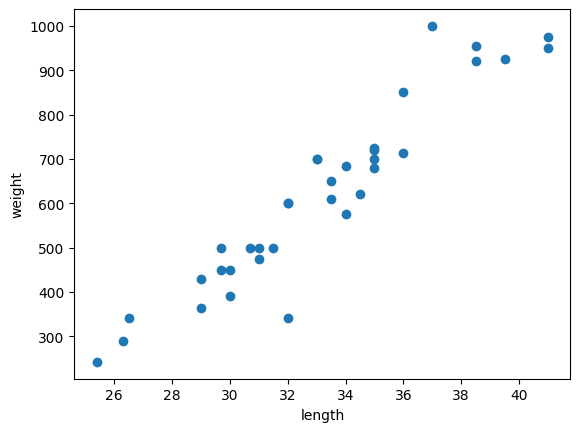

산점도

-

x, y축으로 이루어진 좌표계에서 두 변수의 관계를 표현하는 방법

-

선형: 산점도 그래프가 일직선에 가까운 형태로 나타나는 경우

-

맷플롯립: 과학 계산용 그래프 패키지

도미 데이터로 산점도 그래프를 출력해 보자!

스타듀밸리 하고싶다…

bream_length = [25.4, 26.3, 26.5, 29.0, 29.0, 29.7, 29.7, 30.0, 30.0, 30.7, 31.0, 31.0,

31.5, 32.0, 32.0, 32.0, 33.0, 33.0, 33.5, 33.5, 34.0, 34.0, 34.5, 35.0,

35.0, 35.0, 35.0, 36.0, 36.0, 37.0, 38.5, 38.5, 39.5, 41.0, 41.0]

bream_weight = [242.0, 290.0, 340.0, 363.0, 430.0, 450.0, 500.0, 390.0, 450.0, 500.0, 475.0, 500.0,

500.0, 340.0, 600.0, 600.0, 700.0, 700.0, 610.0, 650.0, 575.0, 685.0, 620.0, 680.0,

700.0, 725.0, 720.0, 714.0, 850.0, 1000.0, 920.0, 955.0, 925.0, 975.0, 950.0]import matplotlib.pyplot as plt

plt.scatter(bream_length, bream_weight)

plt.xlabel('length') # x축

plt.ylabel('weight') # y축

plt.show()

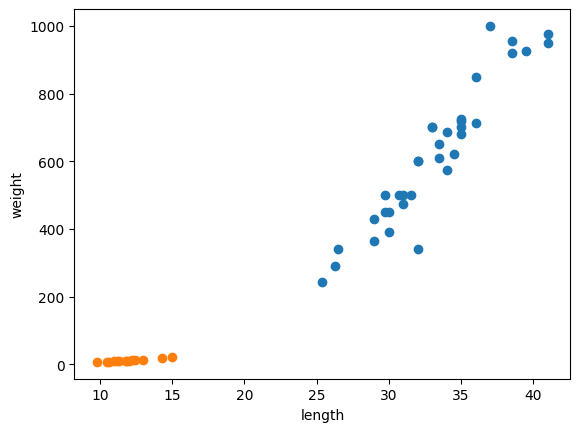

그래프에 빙어 데이터를 추가하자!

시샤모, 맛있었는데…. 보고싶다… 다들

smelt_length = [9.8, 10.5, 10.6, 11.0, 11.2, 11.3, 11.8, 11.8, 12.0, 12.2, 12.4, 13.0, 14.3, 15.0]

smelt_weight = [6.7, 7.5, 7.0, 9.7, 9.8, 8.7, 10.0, 9.9, 9.8, 12.2, 13.4, 12.2, 19.7, 19.9]plt.scatter(bream_length, bream_weight)

plt.scatter(smelt_length, smelt_weight) # 빙어 데이터 추가

plt.xlabel('length')

plt.ylabel('weight')

plt.show()

첫 번째 머신러닝 프로그램

K-최근점 이웃 알고리즘으로 도미와 빙어 데이터를 구분해 보자

- 우선 도미와 빙어 데이터를 하나의 데이터로 합치자

length = bream_length + smelt_length

weight = bream_weight + smelt_weight- 사이킷런 패키지를 쓸 건데 그러려면 각 특성의 리스트를 세로방향 2차원 리스트로 만들어야 함

- 파이썬의 zip 함수와 리스트 내포 구문을 사용하면 된다.

Zip()

나열된 리스트 각각에서 하나씩 원소를 꺼내 반환

fish_data = [[l,w] for l, w in zip(length, weight)]

print(fish_data)결과

[[25.4, 242.0], [26.3, 290.0], [26.5, 340.0], [29.0, 363.0], [29.0, 430.0], [29.7, 450.0], [29.7, 500.0], [30.0, 390.0], [30.0, 450.0], [30.7, 500.0], [31.0, 475.0], [31.0, 500.0], [31.5, 500.0], [32.0, 340.0], [32.0, 600.0], [32.0, 600.0], [33.0, 700.0], [33.0, 700.0], [33.5, 610.0], [33.5, 650.0], [34.0, 575.0], [34.0, 685.0], [34.5, 620.0], [35.0, 680.0], [35.0, 700.0], [35.0, 725.0], [35.0, 720.0], [36.0, 714.0], [36.0, 850.0], [37.0, 1000.0], [38.5, 920.0], [38.5, 955.0], [39.5, 925.0], [41.0, 975.0], [41.0, 950.0], [9.8, 6.7], [10.5, 7.5], [10.6, 7.0], [11.0, 9.7], [11.2, 9.8], [11.3, 8.7], [11.8, 10.0], [11.8, 9.9], [12.0, 9.8], [12.2, 12.2], [12.4, 13.4], [13.0, 12.2], [14.3, 19.7], [15.0, 19.9]]정답 데이터 준비

- 컴퓨터는 문자를 직접 이해 불가

- 따라서 도미와 방어를 1과 0으로 표현

fish_target = [1] * 35 + [0] * 14

print(fish_target)결과

[1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0]- 사이킷 런의 K-최근접 이웃 알고리즘 일 구현한 KNeighborsClassifier 클래스를 임포트 하고

- 임포트 한 KNeighborsClassifier 클래스의 객체를 만든다.

from sklearn.neighbors import KNeighborsClassifier kn = KNeighborsClassifier()

- 객체에 fish_data와 fish_target을 전달해 도미를 찾기 위한 기준을 학습 시킬것임

- 훈련: 모델에 데이터를 전달하여 규칙을 학습하는 과정

kn.fit(fish_data, fish_target)

kn.score(fish_data, fish_target)- fit(): 주어진 데이터로 알고리즘을 훈련하는 매서드

- score(): 모델 평가 매서드.

- 1.0은 모든 데이터를 정확히 맞힘, 0.5는 절반

- 이 값을 정확도라고 함

- 이 코드에서 score 결과는

1.0

predict

- predict() 매서드: 새로운 데이터의 정답을 예측

kn.predict([[30, 600]])결과는 array([1])

- K-최근접 이웃 알고리즘은 예측 시 가장 가까운 직선거리의 데이터만 살피면 됨

- 단점: 데이터가 아주 많은 경우 사용하기 어렵…

- 실제로 훈련 되는것이 없는 셈

가까운 몇개의 데이터를 참조하게 해보자

- KNeighborsClassifier의 기본값은 5임

- 가까운 49개 데이터를 참조해 예측하게 해보자

kn49 = KNeighborsClassifier(n_neighbors=49)

kn49.fit(fish_data, fish_target)

kn49.score(fish_data, fish_target)0.7142857142857143- 별로 안정확 하다…

- 몇개를 참조시킬지 정하는것도 중요할듯