개요

: 새로 합류한 티빙의 데이터엔지니어링팀에서는 배치 처리를 위해 Apache Airflow 를 사용 중이다. Ad-hoc 업무가 들어올 때 순간 필요한 내용을 학습해서 Dag를 개발 하고 있는데, 기본기, 활용능력, 개발 속도 등에서 부족하다 생각이 들어 최근 넥슨 데이터엔지니어 두 분과 운좋게 스터디를 시작하게 되었다. 스터디에서 활용할 발표 자료를 정리할 겸 velog 에 포스팅 해보자.

책 정보

-

학습할 책: Apache Airflow 기반의 데이터 파이프라인(Data Pipelines with Apache Airflow)

-

지은이: 바스 하렌슬락, 율리안 더라위터르

-

옮긴이: 김정민, 문선홍

책을 학습하는 방법

: 책에서는 각 Chapter 별로 이해를 돕기 위한 예제가 있다. 또한, 실제로 실행하고 테스트 할 수 있도록 Github 저장소에 실습용 소스가 공개 되어 있으니 활용해보자. (Github: https://github.com/K9Ns/data-pipelines-with-apache-airflow)

GitHub 저장소 clone

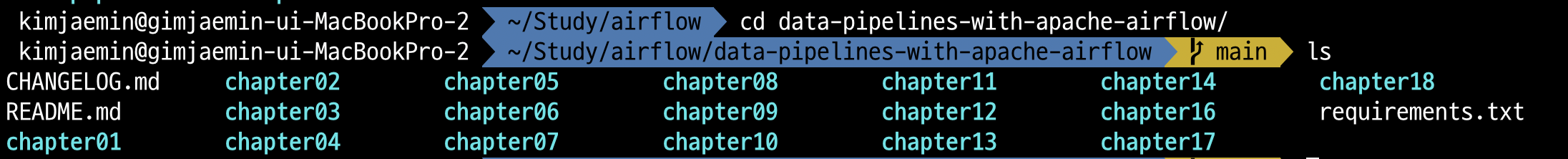

: 나는 data-pipelines-with-apache-airflow 저장소를 아래와 같은 경로에 내려받고 진행할 예정이다.

$ cd /Users/kimjaemin/Study/airflow

$ git clone https://github.com/K9Ns/data-pipelines-with-apache-airflow.git

$ ls

data-pipelines-with-apache-airflow실습환경 세팅

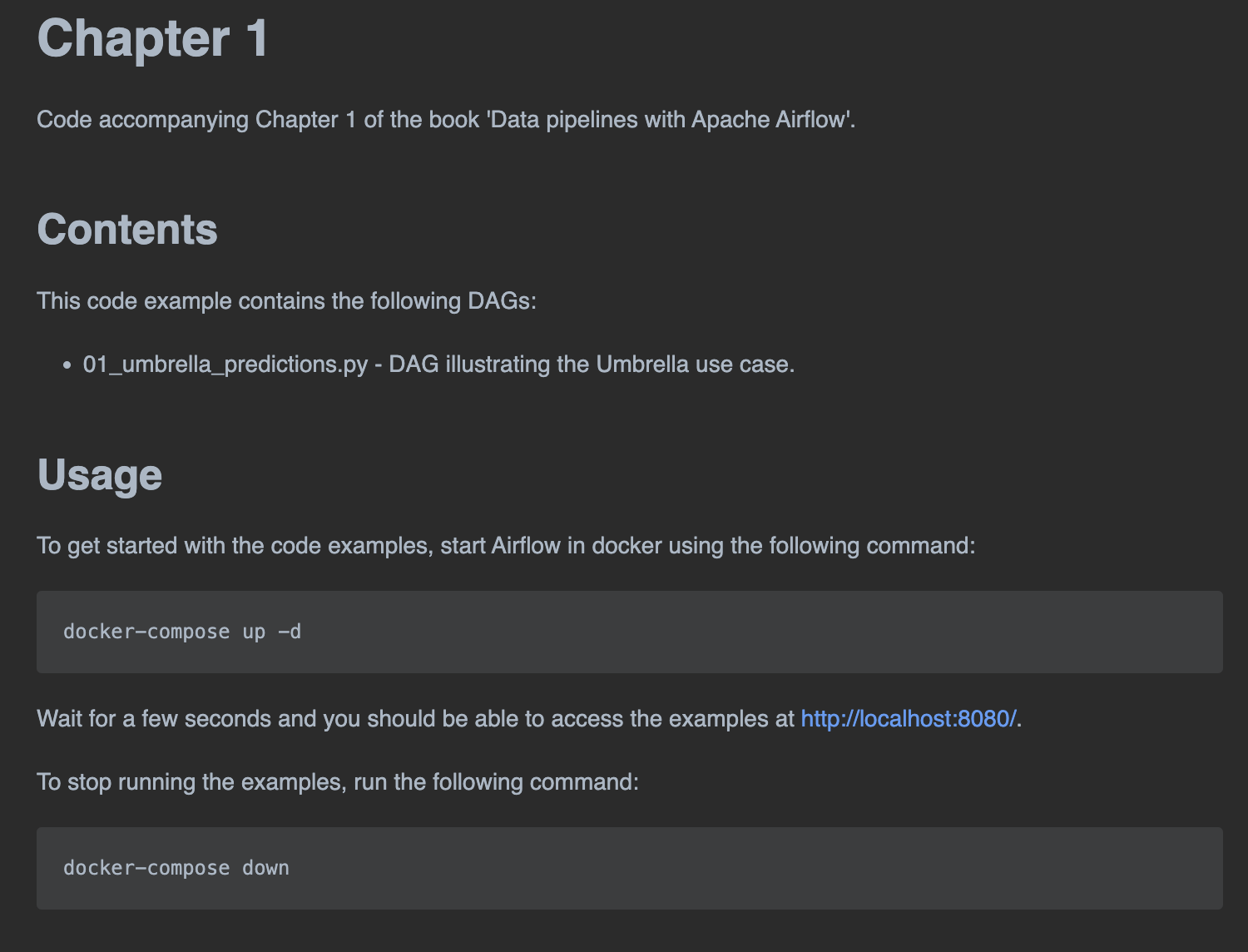

: data-pipelines-with-apache-airflow 디렉토리 하위에는 아래 이미지 처럼 chapter 별로 실습에 참고할 수 있는 소스들이 있다. chapter 를 진행할 때마다 각 chapter 디렉토리에 있는 README.md 파일을 참고하여 docker 환경으로 airflow 를 실행해주면 된다.

Docker compose 실행

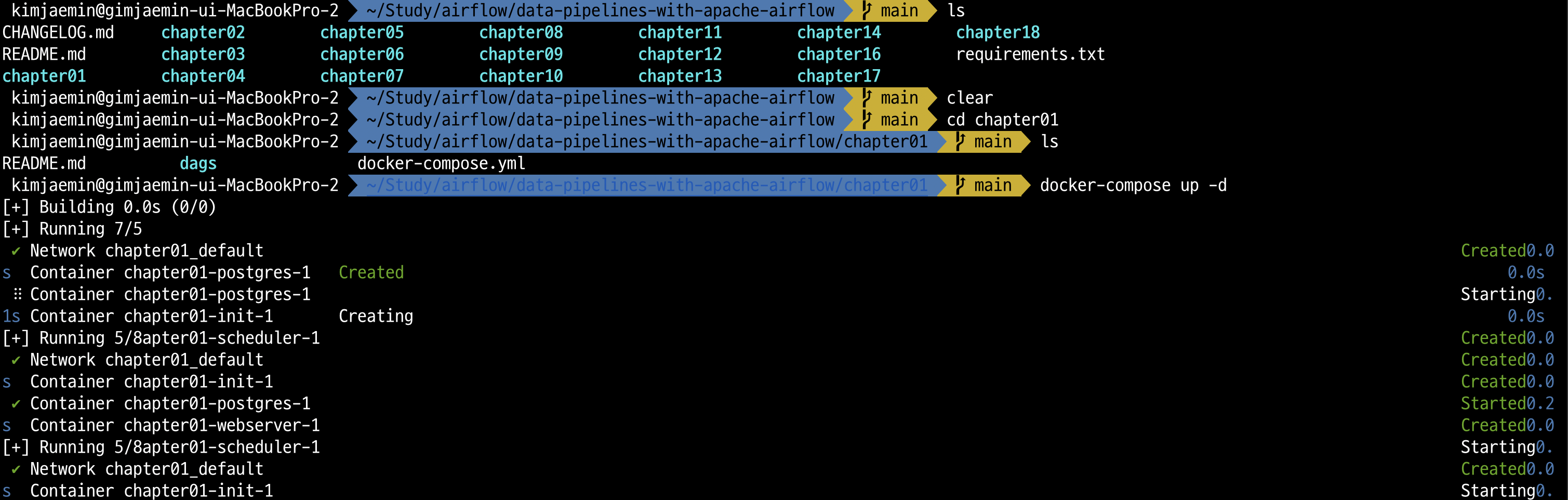

예를 들어, chapter01 에 있는 airflow 를 실습하기 위해서는 chapter01/ 디렉터리로 이동 후 아래와 같이 docker compose 명령어를 실행하여 airflow 환경을 세팅해주면 된다.

$ cd chapter01/

$ docker-compose up -d

Docker compose 종료

: 다음 chapter 학습을 시작할 때는 전에 사용했던 chapter의 docker compose 환경을 없애주고 새로 활성화해주면 된다.

$ docker-compose downREADME.md